この記事のポイント

OpenAIがGPT-2以来となるオープンウェイトモデル「GPT-OSS」をリリース。

GPT-OSS-120B(高性能)とGPT-OSS-20B(軽量)の2サイズ展開。

Apache 2.0ライセンスにより、商用利用や自由なカスタマイズが可能。

エージェントタスク向けに設計され、思考連鎖(CoT)やツール利用能力に優れる。

独自の安全評価を経ており、悪意のあるファインチューニングへの耐性を実証。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AIの世界に再び大きな変革の波が訪れました。OpenAIが、GPT-2以来となるオープンウェイトの言語モデルシリーズ**「GPT-OSS」**を正式に発表しました。

「GPT-OSS-120B」と「GPT-OSS-20B」の2つのサイズで提供されるこれらのモデルは、商用利用も可能なApache

2.0ライセンスの下、高い推論性能とエージェント能力、そして深いカスタマイズ性を兼ね備えています。

本記事では、この注目のオープンモデル「GPT-OSS」について、その核心的な特徴から、驚きの性能、安全性への取り組み、そして具体的な使い方まで、あらゆる情報を網羅して徹底的に解説します。

OpenAIの最新モデル「ChatGPT-5(GPT-5)」の詳細は以下の記事で解説しています。ぜひ合わせてご覧ください。

▶︎ChatGPT5はいつ発表か?性能や料金体系など、最新情報を予測解説!

【OpenAI】GPT-OSS-120B・20Bとは?

GPT-OSS-120B・20Bは、OpenAI社が2025年1月にリリースした、オープンソース大規模言語モデルです。これは2019年のGPT-2以来、7年ぶりとなるOpenAIのオープンウェイトモデルリリースであり、AI業界にとって歴史的な転換点となっています。

GPT-OSSモデルは、標準的な学術ベンチマークにおいて、既存のオープンモデルを上回り、OpenAIの高性能なクローズドモデルに匹敵する、あるいは分野によっては凌駕する結果を示しています。

*参考:Github

GPT-OSS-120BとGPT-OSS-20Bの違い

GPT-OSSシリーズは、単に大小2つのモデルがあるわけではありません。これは、プロフェッショナルのための**「高性能な専用機」と、誰もが手軽に使える「高機能な汎用機」**という、明確な目的を持って設計されたツールセットです。

GPT-OSS-120B

GPT-OSS-120Bは、一切の妥協なく最高の推論性能を追求するために生まれたフラッグシップモデルです。これは、研究開発の最前線や、企業の基幹システムに組み込まれることを想定した、まさに「プロ向けのワークステーション」と言えます。

| 特徴 | 詳細と実世界での意味 |

|---|---|

| 総パラメータ数 | 117B(1170億)- GPT-4に迫る知識量 |

| アクティブパラメータ | 5.1B/トークン - 効率的な処理で高速応答 |

| 専門家構成 | 128人の専門家から4人を動的選択 |

| コンテキスト長 | 128,000トークン(小説約300-400ページ分) |

| 必要インフラ | 単一H100 GPU(80GB)で動作可能 |

| トレーニングコスト | 約420万~2310万ドル(210万H100時間) |

この巨大なパラメータ数は、複雑で多段階にわたる推論や、専門分野における深い知識を要求されるタスクで真価を発揮します。

驚くべきは、これほどの性能を持ちながら、単一のNVIDIA H100(80GB)GPUで動作するよう最適化されている点です。これは、かつて大規模なサーバークラスタを必要としたレベルのAIを、より身近なインフラで運用できることを意味します。

GPT-OSS-20B

一方、GPT-OSS-20Bは、アクセシビリティと機動性を重視して設計された、まさに「高機能な万能ツール」です。その最大の魅力は、わずか16GBのメモリで動作する手軽さにあります。

これにより、コンシューマー向けのゲーミングPC(RTXなど)はもちろん、ノートPC(Apple Silicon搭載Macなど)の上でも、ローカル環境でサクサクとAIを動かすことができます。

| 特徴 | 詳細と個人開発者への価値 |

|---|---|

| 総パラメータ数 | 21B(210億)- GPT-3.5を超える能力 |

| アクティブパラメータ | 3.6B/トークン - 省メモリで高速処理 |

| 専門家構成 | 32人の専門家から4人を選択 |

| 動作環境 | 16GB RAM搭載のノートPCで実行可能 |

| 推論速度 | AMD Radeon 9070 XTで驚異的な応答速度 |

| トレーニングコスト | 120Bの約10分の1(42万~230万ドル) |

軽量だからといって性能が低いわけではありません。多くのベンチマークで一世代前のクローズドモデルに匹敵する性能を示し、日常的な開発支援やプロトタイピングには十分すぎるほどの能力を備えています。

インターネット接続を必要とせず、手元のマシンで高速に動作するため、アイデアをすぐに形にしたいすべての開発者にとって、これ以上ない「相棒」となるでしょう。

あなたに最適なモデルは?

- 最高の性能を求め、本番環境での複雑なタスクに挑むなら → GPT-OSS-120B

- 手元のPCで気軽に、そして高速にAIを活用し、アイデアを形にしたいなら → GPT-OSS-20B

多くの場合、まずは手軽な「GPT-OSS-20B」でその能力を体感し、プロジェクトの要求に応じて「GPT-OSS-120B」の移行を検討するのが、最も効率的なアプローチと言えるでしょう。

GPT-OSSの主な特徴

GPT-OSSが多くの開発者や企業から注目を集める理由は、その革新的な特徴にあります。ここでは、その魅力をより深く掘り下げて解説します。

1. イノベーションを加速させる「Apache 2.0ライセンス」

GPT-OSSの最も重要な特徴の一つは、Apache 2.0ライセンスでの提供です。このライセンス選択が開発者にもたらすインパクトは計り知れません。

- 自由な商用利用が可能

開発したモデルやアプリケーションを、ライセンス料を一切気にすることなく収益化できます。スタートアップから大企業まで、あらゆる規模の組織が自由にビジネス展開できる環境が整いました。

- カスタマイズと再配布の完全な自由

モデルを自社のニーズに合わせて徹底的に改変し、その成果物を自由に配布可能です。業界特化型のAIソリューションや、独自の製品開発において、法的な制約を受けることなく柔軟な開発が行えます。

- 法的リスクの最小化

コピーレフトの制限(GPL系ライセンスのようなソースコード公開義務)や、特許訴訟のリスクから解放されます。OpenAIの最小限の使用ポリシー(違法行為への使用禁止)を除けば、開発者は自由に技術を活用できます。

2. 次世代AIエージェントとしての革新的設計

GPT-OSSは、単純なテキスト生成を超えた自律的なAIエージェントとして機能するよう、根本から設計されています。その中核となるのが、思考の連鎖(Chain-of-Thought)と深く統合された高度なツール活用能力です。

統合されたツール利用機能

- Web検索機能(Web Browsing):リアルタイムの情報収集と検証を実現

- Pythonコード実行環境:複雑な計算、データ分析、ファイル操作を自動実行

- 関数呼び出し(Function Calling):外部APIやデータベースとのシームレスな連携

- 構造化出力(Structured Outputs):JSON形式など、システム連携に最適化された出力形式の生成

これらの機能は単独で動作するのではなく、モデルが与えられたタスクを深く理解し、最適なツールの組み合わせと実行順序を自律的に決定します。

例えば、「最新の市場データを分析して投資戦略を提案して」というリクエストに対して、Web検索で情報収集→Pythonでデータ分析→構造化された形式でレポート出力、といった一連のワークフローを自動的に構築して実行します。

3. 柔軟な制御機能と実用性の追求

GPT-OSSは、開発者がモデルの挙動を細かく制御できる革新的な仕組みを提供しています。

推論の「努力量」を動的に調整可能

システムメッセージの簡単な変更により、推論の深度を**低(low)・中(medium)・高(high)**の3段階で調整できます。これにより、タスクの複雑さと応答速度のバランスを最適化できます。

| 設定 | 説明 |

|---|---|

| 低設定 | シンプルな質問への高速応答(チャットボットなど) |

| 中設定 | バランスの取れた日常的なタスク |

| 高設定 | 複雑な問題解決や深い分析が必要な場合 |

この機能により、同一モデルで幅広いユースケースに対応でき、レイテンシーとパフォーマンスのトレードオフを柔軟に管理できます。

完全なファインチューニング対応

全パラメータへの完全なファインチューニングをサポートしており、医療診断、法的文書分析、金融リスク評価といった専門領域への深い特化が可能です。OpenAIの最先端トレーニングスタックを活用できるため、高品質なカスタムモデルの開発が実現できます。

4. 開発者フレンドリーな透明性とデバッグ環境

モデルが結論に至るまでの思考過程(Chain-of-Thought)に完全にアクセスできます。これは単なるログではなく、モデルが問題をどのように分解し、どのような推論ステップを踏んだかを詳細に追跡できる強力なデバッグツールです。

開発者はこの情報を活用して、以下のようなことが可能です。

- モデルの判断根拠を理解し、信頼性を評価

- 予期しない動作の原因を特定し、迅速に修正

- モデルの推論プロセスを最適化し、パフォーマンスを向上

5. 革新的な効率性とアクセシビリティ

GPT-OSSは最新のアーキテクチャ技術により、そのパラメータ数からは想像できない驚異的な効率性を実現しています。

mixture-of-experts(MoE)アーキテクチャの革新

- gpt-oss-120b:117Bの総パラメータを持ちながら、トークンあたり5.1Bのパラメータのみを活性化

- gpt-oss-20b:21Bの総パラメータで、トークンあたり3.6Bのパラメータを活性化

この選択的活性化により、大規模モデルでありながら実用的な速度での推論を実現。グループ化されたマルチクエリアテンション(グループサイズ8)により、メモリ効率もさらに向上しています。

ネイティブMXFP4量子化の採用

OpenAIとNVIDIAの協力により実現した独自の4ビット精度フォーマットです。品質を維持しながらメモリ使用量を劇的に削減し、より多くのハードウェアでの実行を可能にしました。

驚異的なハードウェア要件の削減

- gpt-oss-120b:単一のNVIDIA H100(80GB)またはRTXワークステーションで動作

- gpt-oss-20b:わずか16GBのVRAMまたは統合メモリで動作(Apple Silicon Macにも最適)

NVIDIA GeForce RTX 5090では最大256トークン/秒の推論速度を実現。これは、従来は大規模な計算クラスタが必要だったレベルのモデルを、個人開発者やスタートアップでも利用できる環境が整ったことを意味します。

安全性への包括的アプローチ

OpenAIは、オープンウェイトモデルのリリースにあたり、業界最高水準の安全性評価を実施しています。GPT-OSSは同社の「準備フレームワーク(Preparedness Framework)」に基づく厳格な評価プロセスを経ています。

「最悪の場合のファインチューニング」テスト

OpenAIは、悪意のある攻撃者がモデルを危険な用途に特化させようとした場合を想定した、前例のない評価手法を開発しました。

具体的にはこれらの危険領域において、攻撃的にファインチューニングされたgpt-oss-120bでも「高リスク」の閾値に達しないことが確認されています。

- 化学・生物兵器の開発に関する知識

- サイバー攻撃の実行能力

- AIの自己改良による暴走リスク

外部の専門家による独立したレビューも実施され、オープンウェイトモデルの新たな安全基準を確立しています。

最小限の使用ポリシー

Apache 2.0ライセンスの自由度を最大限に保ちながら、OpenAIは最小限の使用ポリシーを設けています。

- 適用法令の遵守義務

- 違法行為への使用禁止

- 悪意のある用途への転用防止

これにより、開発者の創造性を阻害することなく、社会的責任を果たす枠組みを提供しています。

GPT-OSSの使い方

GPT-OSSは、ローカルPCから大規模なクラウド環境まで、様々な場所で実行できるように設計されています。ここでは、あなたの目的に合わせて、GPT-OSSを使い始めるための具体的な方法をステップごとに解説します。

対応プラットフォーム

OpenAIは主要なデプロイメントプラットフォームと提携しており、様々な環境で利用・デプロイが可能です。

クラウドプラットフォーム

GPT-OSSは企業向けの大規模なクラウドデプロイメントから個人開発者の小規模なプロジェクトまで、様々な規模とニーズに対応できるよう、主要なクラウドプロバイダーと連携しています。

| プラットフォーム | 特徴・サービス |

|---|---|

| Azure AI Foundry | Microsoft提供のクラウドサービスで、開発者や企業がOpenAIモデルを独自の条件で実行、適応、デプロイできる |

| AWS | Amazon BedrockとAmazon SageMaker AIを通じて、OpenAIオープンウェイトモデルが初めて利用可能 |

| Databricks | AWS、Azure、GCPのFoundation Model APIで利用可能、Provisioned ThroughputとAI Functionsサポート |

| Hugging Face | AIモデル共有・実行プラットフォーム、Inference Providersサービス経由でgpt-oss.comの公式デモと同じインフラを使用 |

| Fireworks | 高速推論特化のクラウドサービス、gpt-oss-20bが利用可能 |

| Together AI | オープンソースモデル専門プラットフォーム |

| Baseten | MLモデルのデプロイメント・管理サービス |

| Vercel | フロントエンド開発者向けクラウド |

| Cloudflare | エッジコンピューティング・CDN |

| OpenRouter | 複数AIモデルの統一API |

ローカル実行ツール

手軽に自分のPC上でGPT-OSSを動かしたい開発者や研究者向けに、様々なローカル実行環境が用意されています。

| ツール名 | 特徴 |

|---|---|

| vLLM | 高速推論エンジン(OpenAI互換API提供) |

| Ollama | コンシューマーハードウェアで実行するための簡単なコマンド提供 |

| llama.cpp | C++ベースの軽量実行環境 |

| LM Studio | GUI付きローカル実行アプリ |

開発フレームワーク

アプリケーション開発者がGPT-OSSを既存のプロジェクトに統合するための、主要な開発フレームワークとライブラリです。

| フレームワーク名 | 特徴 |

|---|---|

| Transformers | Harmonyレスポンス形式を自動適用するチャットテンプレート機能付き |

| PyTorch | 機械学習フレームワーク |

| Triton | GPU最適化推論エンジン |

| Metal | Apple Silicon向け最適化実装 |

Microsoft Windows特別対応

リリースの一環として、MicrosoftはGPU最適化バージョンのgpt-oss-20BモデルをWindowsデバイスに導入される予定です。

ONNX Runtimeを搭載したこれらのモデルは、ローカル推論をサポートし、Foundry LocalとAI Toolkit for VS Codeを通じて利用できます。

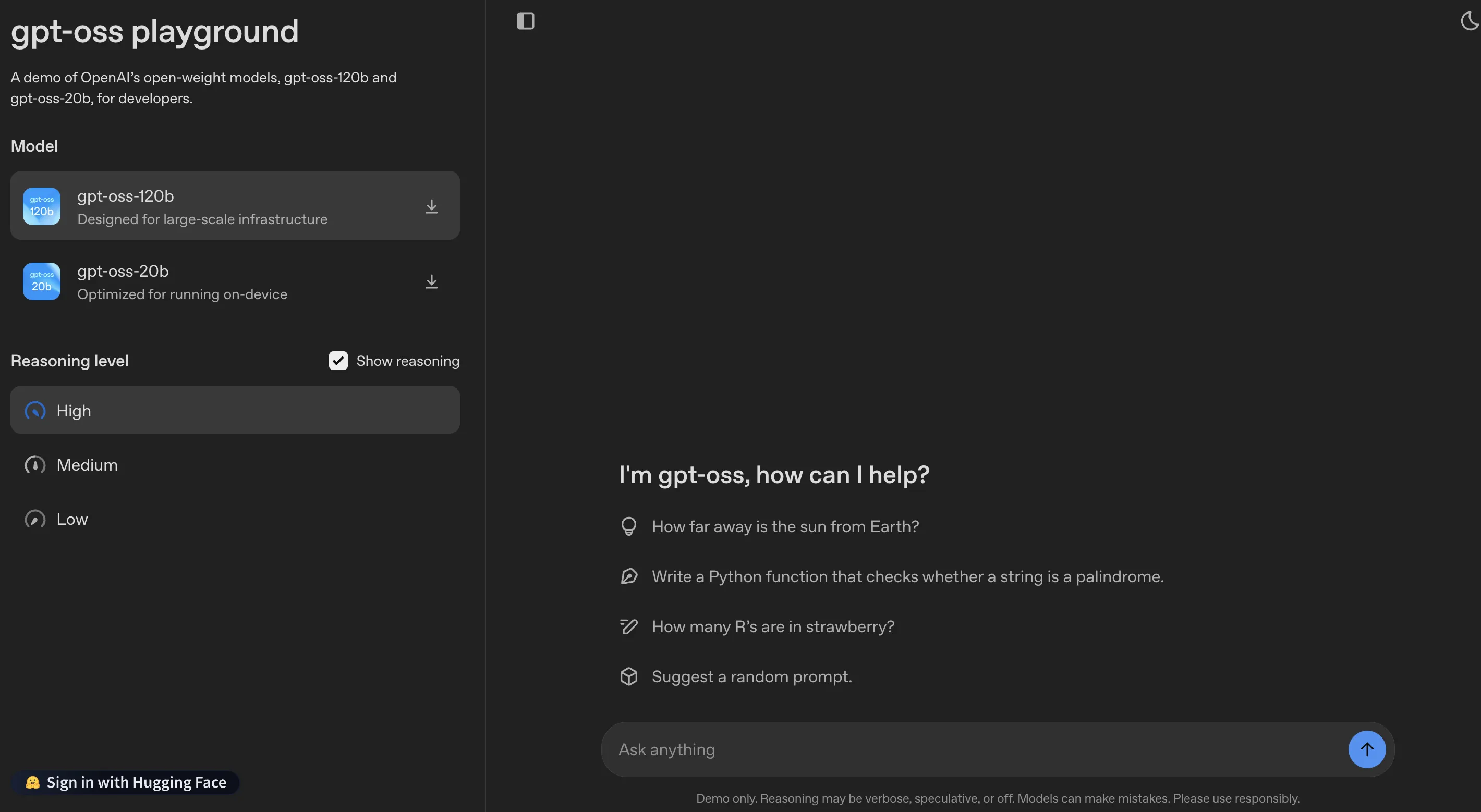

【おすすめ】公式プレイグラウンド

一番手軽にGPT-OSSの性能を体験するには、OpenAIが提供する公式のプレイグラウンドが最適です。ソフトウェアのインストールは一切不要。ブラウザ上で、すぐにモデルとの対話を開始できます。

GPT-OSSプレイグラウンドを試す(公式サイトへ)

GPT-OSS プレイグラウンド

自分のPCで手軽に動かす(Ollama・LM Studio)

自分のPC上で、チャットアプリケーションのように手軽にGPT-OSSを動かしてみたい方には、以下のツールがおすすめです。

Ollamaを使う

Ollamaは、ターミナル(黒い画面)から簡単なコマンドを一つ実行するだけで、ローカルに大規模言語モデルをセットアップし、実行できるツールです。

- Ollama公式サイトから、お使いのOS(macOS, Windows, Linux)に合ったアプリケーションをインストールします。

- ターミナルを開き、以下のコマンドを実行します。これだけでモデルのダウンロードとセットアップが完了します。

# 軽量な20Bモデルを試す場合 ollama run gpt-oss:20b - コマンド実行後、すぐにチャットを開始できます。

参考:How to run gpt-oss locally with Ollama

LM Studioを使う

GUI(グラフィカルな画面)で直感的に操作したい方には、LM Studioが適しています。

- LM Studio公式サイトからアプリをダウンロードします。

- アプリ内の検索画面で「gpt-oss」と検索し、「openai/gpt-oss-20b」などのモデルをダウンロードします。

- チャット画面でダウンロードしたモデルを選択すれば、すぐに会話を始められます。

LM Studioの使い方については、以下の記事をご覧ください。

▶︎LM Studioとは?機能・ローカルLLMの使い方・最新アップデートを紹介

アプリケーションに組み込む

GPT-OSSを自身のアプリケーションやサービスに組み込みたい開発者向けの方法です。

Hugging Face Transformers を使う

Python開発者にとって最も標準的な方法です。「transformers」ライブラリを使えば、数行のコードでモデルを呼び出せます。

from transformers import pipeline

import torch

# モデルIDを指定

model_id = "openai/gpt-oss-120b"

# パイプラインを準備(GPUが自動的に利用されます)

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype="auto",

device_map="auto",

)

# Harmonyフォーマットに準拠したメッセージを作成

messages = [

{"role": "user", "content": "Explain quantum mechanics clearly and concisely."},

]

# 推論を実行

outputs = pipe(

messages,

max_new_tokens=256,

)

print(outputs["generated_text"][-1])

vLLMでAPIサーバーを立てる

vLLMは、LLMの推論を高速化し、OpenAI互換のAPIサーバーを簡単に構築できるライブラリです。これを活用すれば、ローカルで実行しているGPT-OSSを、まるでOpenAIの公式APIのように扱うことができます。

プロダクション環境での利用や、既存のOpenAI APIを利用したアプリケーションでモデルを差し替える場合に非常に強力です。

参考:How to run gpt-oss with vLLM

公式GitHubリポジトリを活用する

OpenAIは、GPT-OSSの公式リポジトリで、推論の参照実装やツール(ブラウザ、Python実行環境)のサンプルコードを公開しています。モデルの内部構造を深く理解したい場合や、独自のツール連携を実装したい場合に非常に役立ちます。

▶︎OpenAI/gpt-oss on GitHub

GPT-OSSシリーズのよくある質問(FAQ)

GPT-OSSシリーズに関してよく寄せられる質問とその回答をまとめました。

Q1: Apache 2.0ライセンスとは具体的にどのような権利が得られますか?

Apache 2.0ライセンスにより、以下の権利が保証されます:

- 商用利用: 制限なく営利目的での利用が可能

- 改造・再配布: モデルの修正と再配布が自由

- 特許権: 関連特許の利用権も付与

- プライベート利用: 社内システムでの制限なし利用

コピーレフト制限がないため、改造版を公開する義務もありません。

Q2: どちらのモデルを選べばよいですか?

用途と計算リソースに応じて選択してください:

GPT-OSS-120Bが適している場合

- 最高の推論性能が必要

- H100等の高性能GPUが利用可能

- 本格的な商用システム構築

- 複雑な数学・科学計算

GPT-OSS-20Bが適している場合

- 限られたメモリ環境(16GB程度)

- エッジデバイスでの利用

- プロトタイピング・実験用途

- コスト効率を重視

Q3: ハーモニー応答フォーマットとは何ですか?

ハーモニー応答フォーマットは、GPT-OSSモデル専用の対話形式です。以下の特徴があります:

- 構造化された対話管理

- ツール呼び出しの標準化

- 思考連鎖の明示的表現

- エージェント機能の効率的実行

このフォーマットを使用しないと、モデルが正常に動作しない可能性があります。

Q4: 安全性の観点でプロプライエタリモデルとの違いはありますか?

GPT-OSSシリーズは、プロプライエタリモデルと同等の安全性トレーニングを受けています:

- 有害データの事前除去

- 審議的調整による安全性強化

- 悪意ある微調整への耐性確認

- 外部専門家による検証済み

むしろ、思考連鎖が見える分、動作の透明性が高いとも言えます。

Q5: 商用利用時のサポートはありますか?

現在、OpenAIは以下のサポート体制を提供しています:

- 技術文書: 包括的なドキュメントとガイド

- コミュニティ: Hugging Face等でのコミュニティサポート

- パートナー企業: Azure、AWS等のクラウドベンダーサポート

将来的には、API形式での提供も検討されています。

AI導入でお悩みの方へ

まとめ

GPT-OSS-120B・20Bのリリースは、AI業界における歴史的な転換点となりました。OpenAIという最先端技術企業が、自社の競争優位技術をオープンソースとして公開するという決断は、AI技術の民主化に向けた大きな一歩です。

技術的インパクト

- Apache 2.0による完全なオープンライセンス

- プロプライエタリモデルと競合する高い推論性能

- エッジからクラウドまで対応する柔軟な展開オプション

- 透明性の高い思考連鎖と安全性の両立

経済的インパクト

- 従量課金から固定費への転換可能

- 中小企業・個人開発者へのAI技術普及

- カスタマイズによる差別化サービスの創出

- データプライバシーを保った内製AI開発

社会的インパクト

- 研究機関での制約なしAI研究の促進

- 新興国でのAI技術へのアクセス向上

- オープンソースコミュニティでの協調開発

- AIガバナンスの透明性向上

GPT-OSSシリーズは、単なる新しいAIモデルではありません。それは「AIは少数の巨大企業が独占するものではなく、人類全体の共有財産である」というビジョンの具現