この記事のポイント

LM Studioは、ローカル環境で大規模言語モデル(LLM)を実行・管理できるクロスプラットフォーム対応のアプリケーション

LM Studioを使えば、モデルのダウンロード・実行・対話・API提供までをすべてローカルで完結

LM Studioは、OpenAI互換のAPIサーバー機能を持ち、ローカルで実行しているモデルをChatGPT APIと同様の方法で他のアプリケーションから呼び出すことが可能です。

LM Studioは、PDFやTXTファイルを読み込ませ、内容に基づいた質疑応答を行う機能も備えています。

ローカルLLMを使うことで、プライバシーの確保やオフライン利用、カスタマイズ性の向上が期待できます。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

クラウドに依存せず、ローカル環境で大規模言語モデル(LLM)を安全に実行したい──そんなニーズに応えるのが「LM Studio」です。

GUIベースで簡単にモデルを導入・起動でき、OpenAI互換のAPIや文書読み取り機能、RAG構築にも対応。エッジAIやオフライン環境でのAI活用を検討する企業・研究者にとって、強力な選択肢となりつつあります。

本記事では、LM Studioの概要から機能、導入手順、最新アップデートまでをわかりやすく解説します。

AI総合研究所では、ローカルLLMの導入支援を行っています。

お気軽にご相談ください。

目次

LM Studio 0.4.0の発表ポイント:ヘッドレス運用・並列推論・stateful API

LM Studioとは?

LM Studioは、ローカル環境で大規模言語モデル(LLM)を実行・管理できる、クロスプラットフォーム対応アプリケーションです。

Windows / macOS / Linuxに対応しており、オープンソースモデルをローカルで安全かつ簡単に扱いたいユーザーに利用が広がっています。

従来、LLMの活用はクラウドAPI前提になりがちでした。

一方でLM Studioは、モデルのダウンロード・実行・対話・API提供までをローカルで完結させられる点が核になります。

LMStudioトップページ

ローカル完結により、主に次のメリットが得られます。ここは「便利そう」で終わらせず、運用観点で効くポイントだけ押さえるのがコツです。

- プライバシーの確保:外部クラウドへデータを送らずに済むため、個人情報や機密情報の取り扱いと相性が良いです。

- オフライン利用:インターネット接続なしでもモデルを活用できます。

- カスタマイズ性:使用モデルや設定、UI、APIなどを用途に合わせて調整できます。

もうひとつ押さえておきたいのが、OpenAI互換のAPIサーバー機能です。

これにより、ローカルで動かしているモデルを、ChatGPT APIと同じ形式で外部アプリから呼び出せます。

【関連記事】

ローカルLLMとは?メリットやおすすめモデル、導入方法を解説

LM Studio 0.4.0の発表ポイント:ヘッドレス運用・並列推論・stateful API

2026年1月28日に公開されたLM Studio 0.4.0では、ローカルLLMを「GUIで触る」段階に加えて、「サーバー配備」「高負荷検証」「API統合」まで見据えた機能が強化されています。ここでは発表内容を、用途別に整理します。

LM Studioのヘッドレス運用:llmster(daemon)とCLI(lms)

GUIに依存しないデーモンとしてllmsterが提供され、サーバーやCIでもLM Studioのコア機能を動かせる構成が追加されています。運用フローは次の順で把握すると迷いません。

- デーモン起動(lms daemon up)。

- モデル取得(lms get <model>)。

- ローカルサーバー起動(lms server start)。

- ターミナル対話(lms chat)。

ローカル検証はGUI、継続稼働や自動化はヘッドレス、という役割分担を取りやすくなります。

LM Studioの高スループット推論:並列リクエストとcontinuous batching

同一モデルに対する複数リクエストを同時に処理する仕組みが導入され、待ち行列で1件ずつ処理する運用よりもスループットを狙いやすくなっています。モデルロード時に追加された主要な設定は次の2点です。

- 同時処理数の上限(Max Concurrent Predictions)。

- KVキャッシュの柔軟運用(Unified KV Cache、デフォルト有効)。

この変更は、同時接続やバッチ処理を前提にした負荷検証をやりやすくする意図だと整理できます。

LM Studioのstateful API:v1/chatによる会話継続と小さなリクエスト

v1/chatはstateful設計のREST APIとして追加され、会話状態を維持しながらリクエストを小さく保てる設計になっています。押さえるべき要素は次の通りです。

- 会話状態の引き継ぎ(response_idとprevious_response_id)。

- 実行統計の返却(tokens in/out、速度、初回トークンまでの時間など)。

これにより、履歴を毎回すべて送る前提よりも、多段のワークフローを組みやすくなります。

LM Studioのツール連携とアクセス制御:ローカルMCPとpermission keys

v1/chatは、必要に応じてローカルに設定したMCPを利用できる設計になっています。一方で、ツール連携をAPIとして公開する場合の事故を避けるため、クライアント制御の仕組みも同時に追加されています。

- ローカルMCPの有効化(必要時ロード)。

- クライアント制御キー(permission keys)。

- 設定画面での発行・管理(Settings > Server)。

この構成により、「ツールは使えるが誰でも使えるわけではない」という運用に寄せています。

LM StudioのUIと開発体験:Split View、Developer Mode、チャットエクスポート

日常利用と検証効率を上げる変更もまとめて入っています。

代表的な追加点は次の通りです。

- チャットのエクスポート(PDF / Markdown / Text)。

- Split View(複数チャットの並列表示)。

- Developer Mode(高度設定の集約表示)。

- アプリ内ドキュメント(REST API / CLI / 設定の参照)。

- CLI体験の刷新(lms chat中心)。

これらは「触りやすさ」と「検証の回しやすさ」を同時に上げるための改善として位置づけられます。

LM Studioの主な特徴・できること

LM Studioは「モデル管理」「対話」「API提供」「文書QA」までを、GUI中心で一気通貫に扱える**のが特徴です。

モデル検索とダウンロード

LM Studioでは、Hugging Face Hubなどのモデルリポジトリから、任意の大規模言語モデルをGUIで検索・ダウンロードできます。

モデル名や用途(チャット、埋め込み生成など)でフィルタリングでき、初手のつまずきを減らす設計です。

例:

meta-llama/Llama-3-8B-Instruct、google/gemma-3-12b、DeepSeek-R1-Distill-Qwen-7B、gpt-oss-8Bなどを数クリックで導入可能。

ここで重要なのは、「モデルは後からいくらでも変えられる」点です。最初は“確実に動く構成”を作るのが先です。

チャットインターフェース

チャットUIが内蔵されており、モデルを選ぶとすぐ対話を開始できます。

応答表示のスタイルやシステムプロンプトの編集もできるため、**プロンプト調整や挙動確認(デバッグ)**にも向きます。

対話の品質を上げたい場合でも、いきなり設定を増やすより、まずはモデルサイズや量子化を変えて体感差を取る方が安定します。

OpenAI API互換のローカルサーバー

LM StudioはOpenAI互換エンドポイントを提供し、既存の実装資産を流用しやすい**のが強みです。

そのため、ローカルのまま次のような使い方に繋げやすくなります。

- 社内システムやアプリへの組み込み。

- LangChainやLlamaIndexとの統合。

- 外部へのデータ送信を避けた高セキュリティ設計。

「ローカルで動く」だけで終わらず、既存のエコシステムにそのまま接続できる点が実務上のメリットになります。

ドキュメントとの対話(RAG対応)

PDFやTXTを読み込ませ、内容に基づいて質疑応答する機能も備えています。

内部的には、埋め込み生成と検索を組み合わせたRAGアーキテクチャが使われており、社内文書へのAI活用に適しています。

RAGは“作った瞬間に終わり”ではなく、更新・版管理・アクセス制御まで含めて運用対象になります。運用の勘所は後半でまとめます。

マルチモーダルモデルの対応

Gemma 3シリーズ(テキスト+画像)に加え、Gemma 3nでは音声・画像・動画すべてに対応し、スマートフォンやタブレットなどの日常デバイスでも動作する最適化が施されています。

画像は896×896に正規化され、質疑応答・要約・推論タスクに活用できます。今後のアップデートでは、より多くのマルチモーダルモデルへの対応拡大も期待されます。

マルチモーダルは「動かす」だけなら簡単ですが、実務に乗せる場合は入出力(ファイル/URL/メタデータ)の扱いを先に決めておくと手戻りが減ります。

Model Context Protocol(MCP)対応

LM Studio 0.3.17以降、Model Context Protocol(MCP)ホストとして機能し、外部ツールやサービスとLLMを接続できます。

「ローカルLLMを単体で使う」から「ツールと繋いで拡張する」までを見据えた機能です。

- ローカル・リモート両方のMCPサーバーに対応します。

- ツール呼び出し時の確認ダイアログで安全性を確保します。

- mcp.json設定ファイルまたはワンクリック追加で簡単セットアップできます。

運用で重要なのは、どのツールに何を渡すかを把握し、確認フローを含めて設計することです。

次章では、まずLM Studioを“最短で動かす”手順に入ります。

LM Studioの使い方(導入〜基本操作)

LM Studioは「インストール→モデル追加→チャット開始」までが短いのが強みです。

ここでは、迷いが出やすい箇所だけ言葉を足しつつ、基本手順を押さえます。

インストール手順

以下のOS別にインストーラが提供されており、公式サイトまたはGitHubリリースページから入手可能です。

まずは自分のOSに合う形式を選び、通常のアプリと同じ手順でインストールします。

| OS | 入手形式 | 備考 |

|---|---|---|

| Windows | .exe形式 |

インストーラで自動セットアップ |

| macOS | .dmg形式 |

Gatekeeperでの許可が必要な場合あり |

| Linux | .AppImage等 |

ディストリビューションによっては追加設定が必要 |

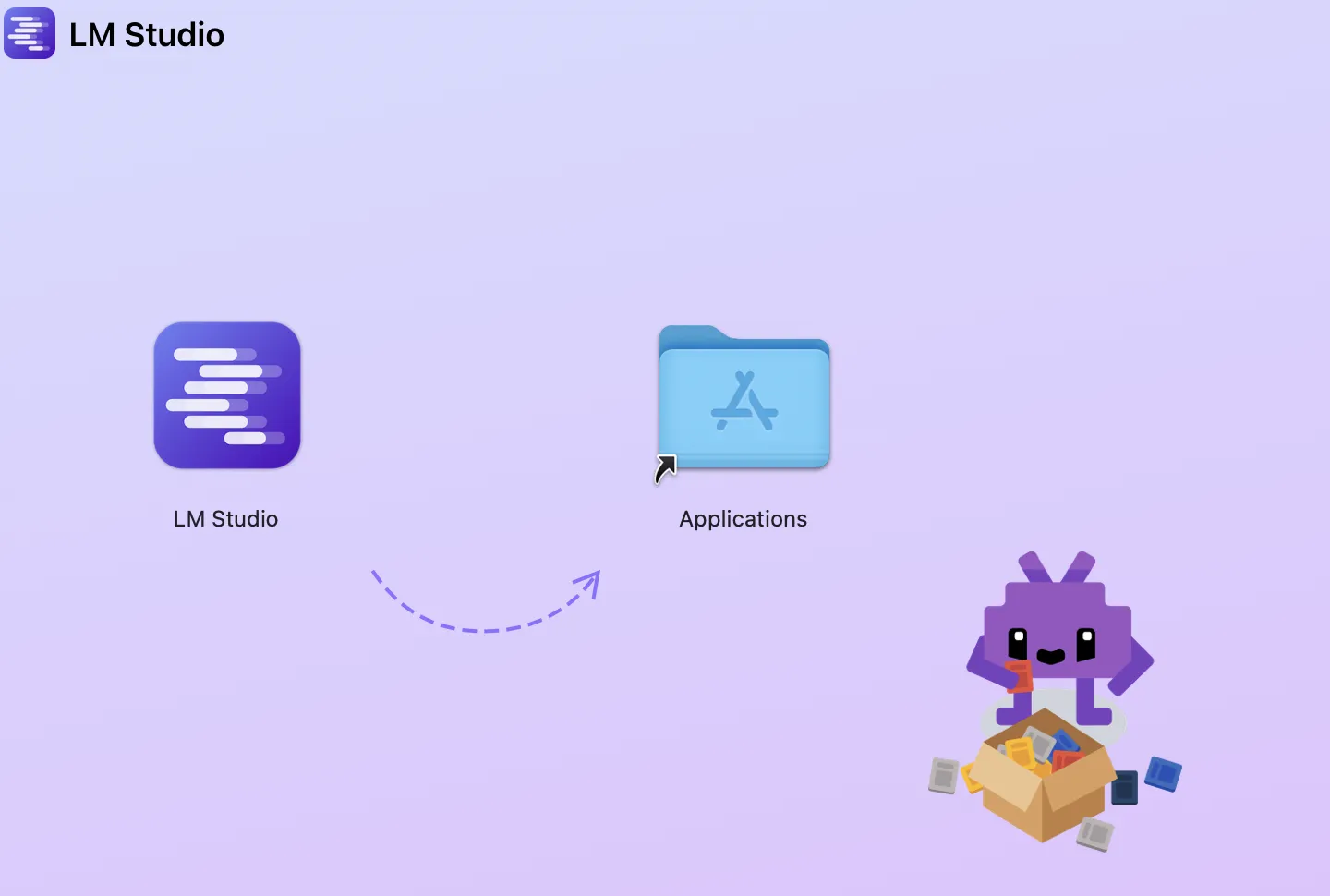

インストーラーのイメージ

モデルの追加と実行

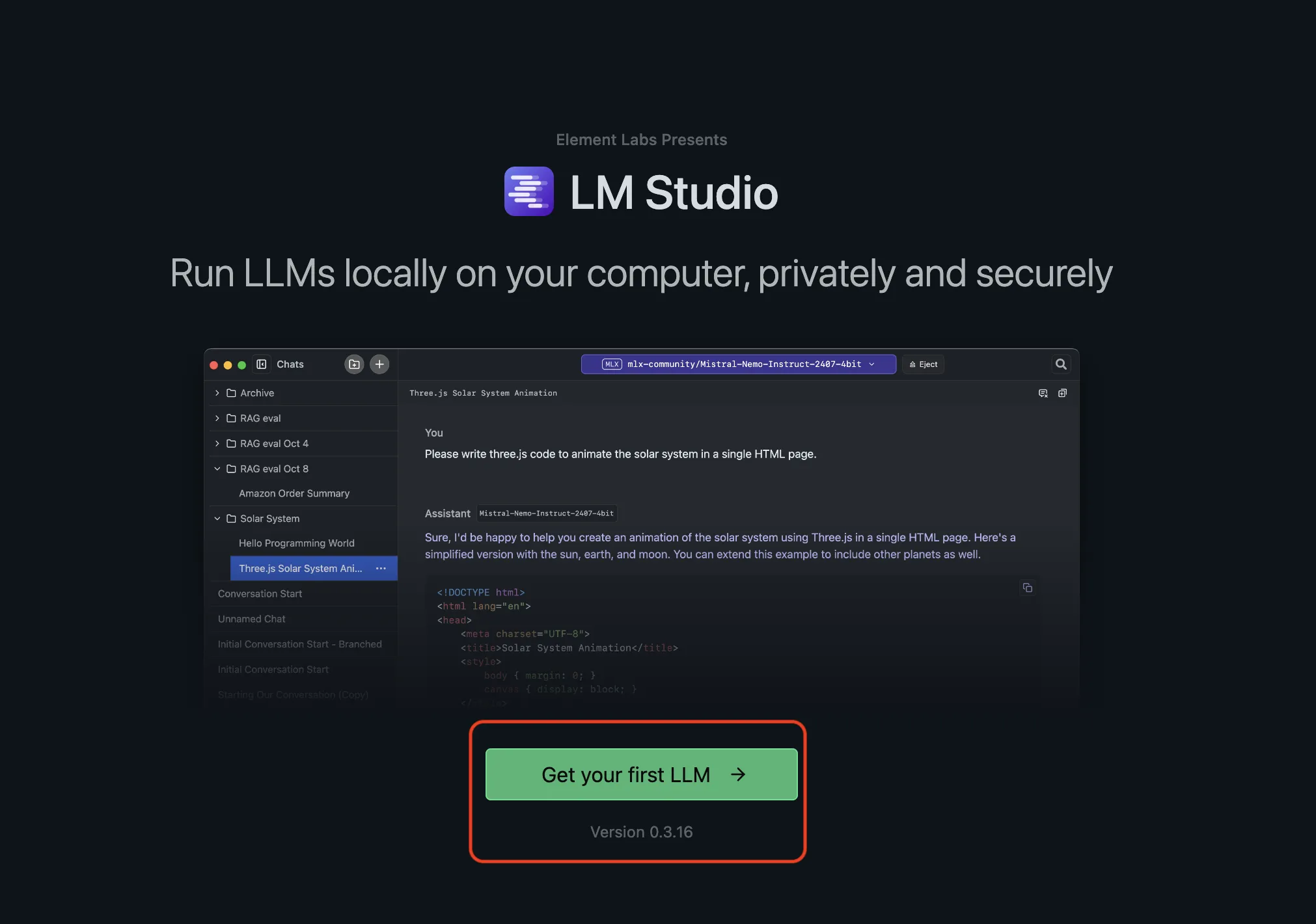

アプリ起動画面

ここでは、モデルを追加してチャットを開始するまでの流れを3ステップで整理します。

操作自体はGUIで完結するため、最初は“軽いモデルで一度成功させる”ことを優先するとスムーズです。

-

アプリ起動後、画面左の「Models」からHugging Faceに接続します。

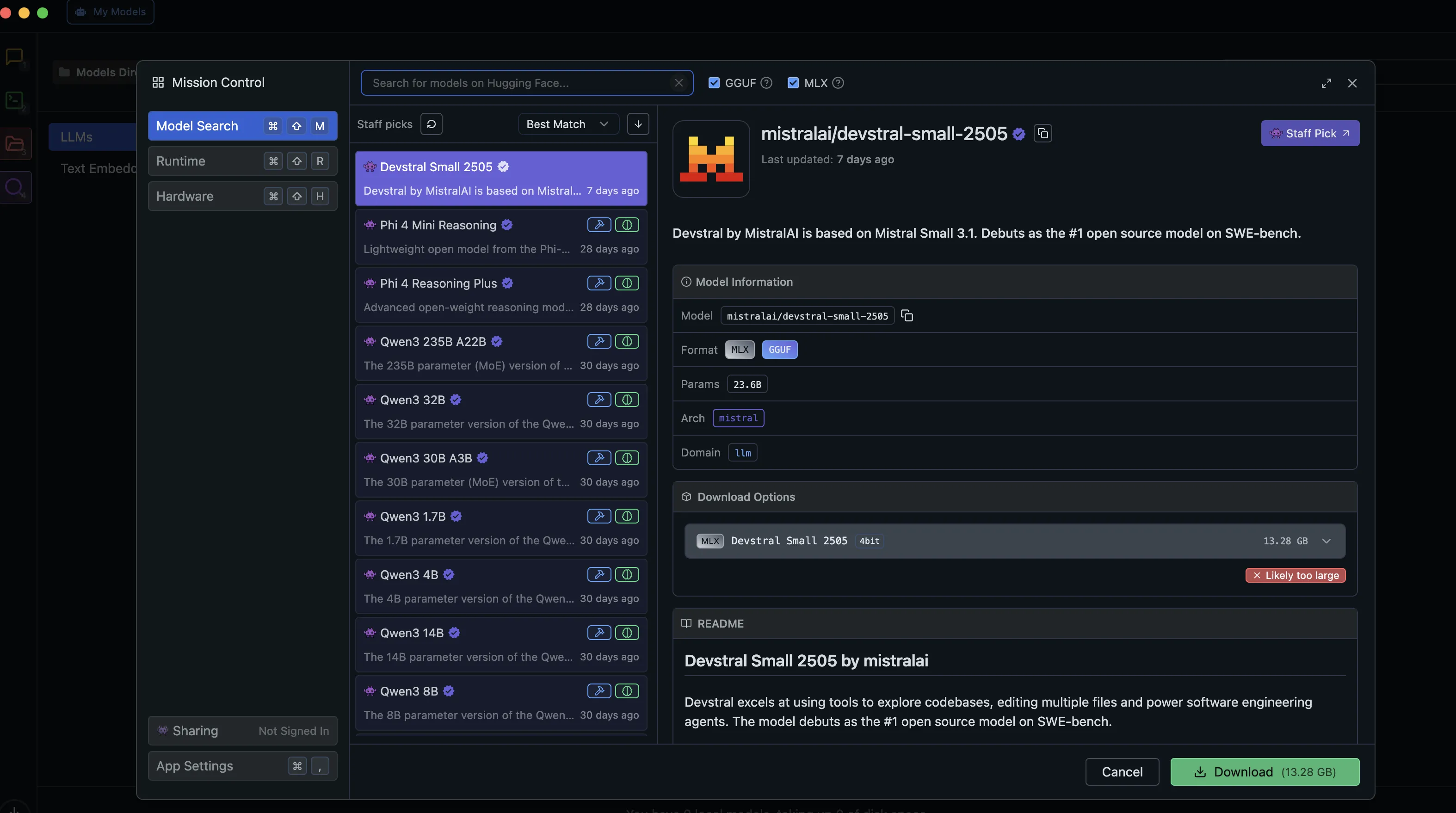

Hugging Faceに接続画面

-

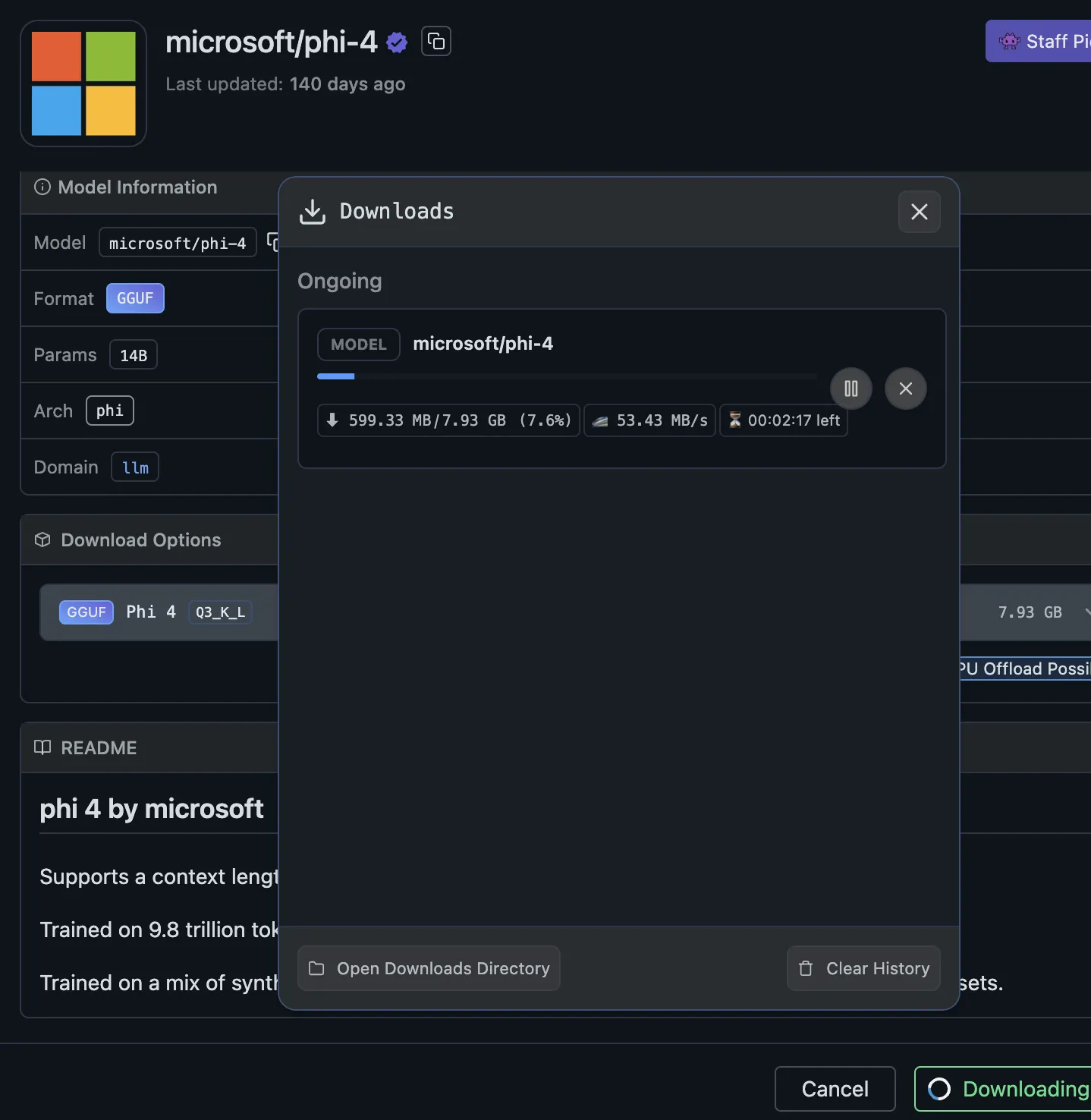

使用したいモデル名を検索し、ダウンロードします。

-

チャットモード・埋め込みモードなどの用途を選択して起動します。

ダウンロード画面

以上で、モデルをローカルに取り込み、起動まで進められます。

ここから先は「どのモデルを選ぶか」「どのくらいのコンテキストで回すか」で体感が変わるため、まずは軽量モデルで挙動を掴むのがおすすめです。

今回は、Microsoft phi4をダウンロードしました。

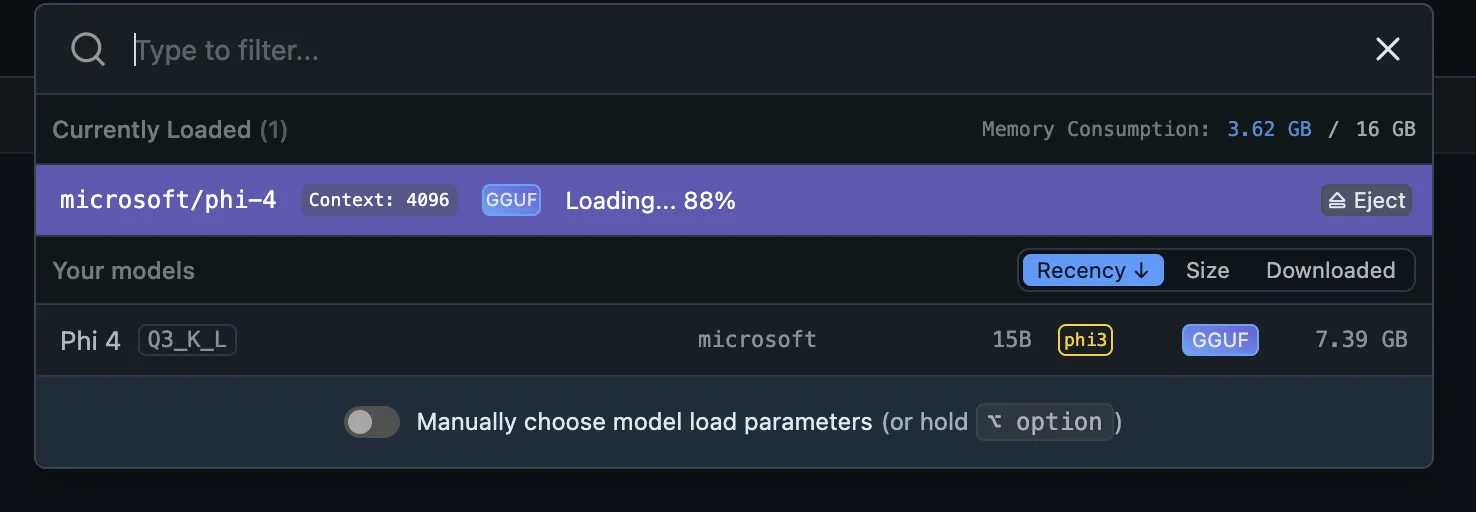

loadモデルでチャット画面の方に移行しましょう。

load画面

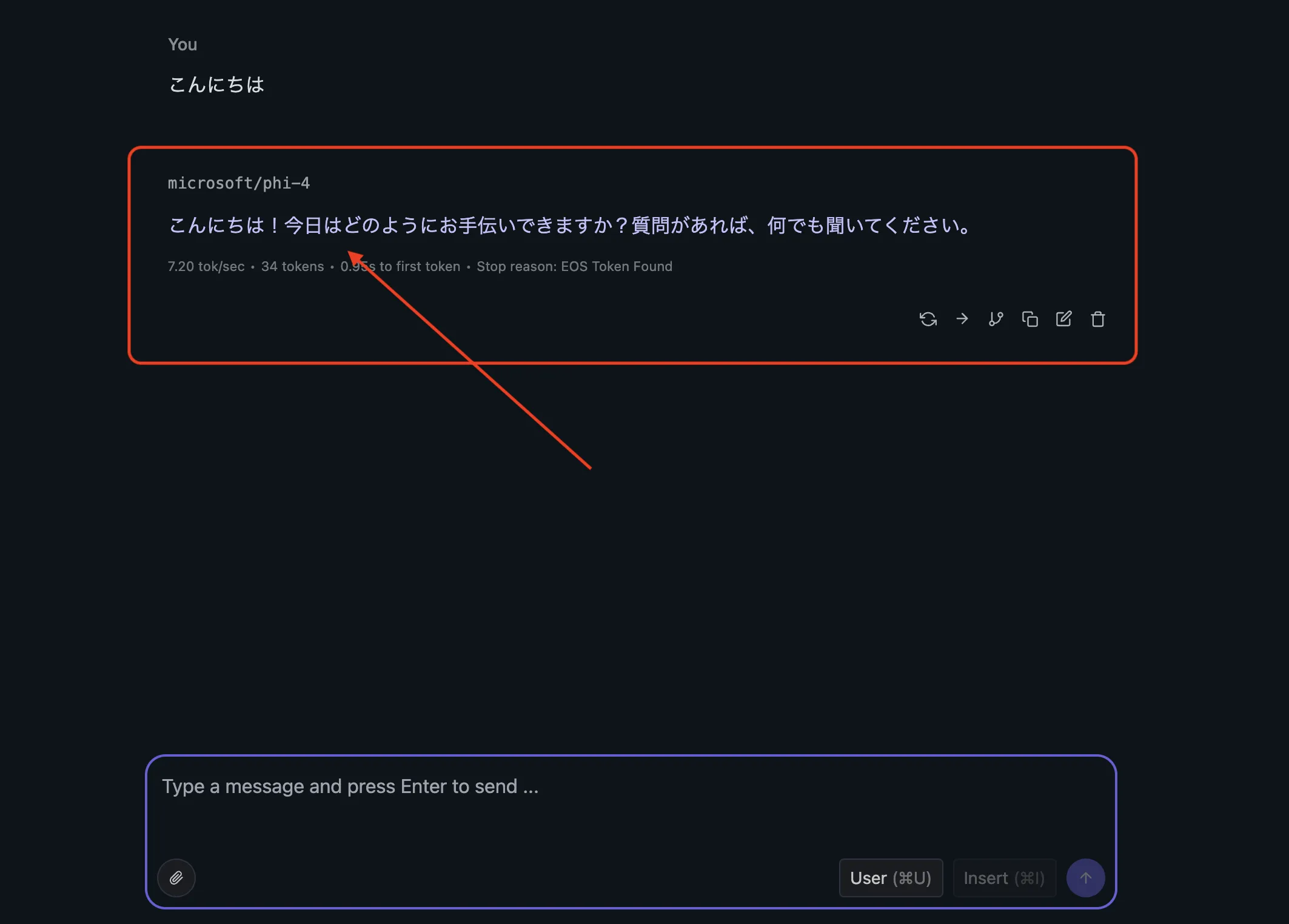

ロードが完了すると、すぐにローカルLLMでの対話が可能になります。

実際の対話画面

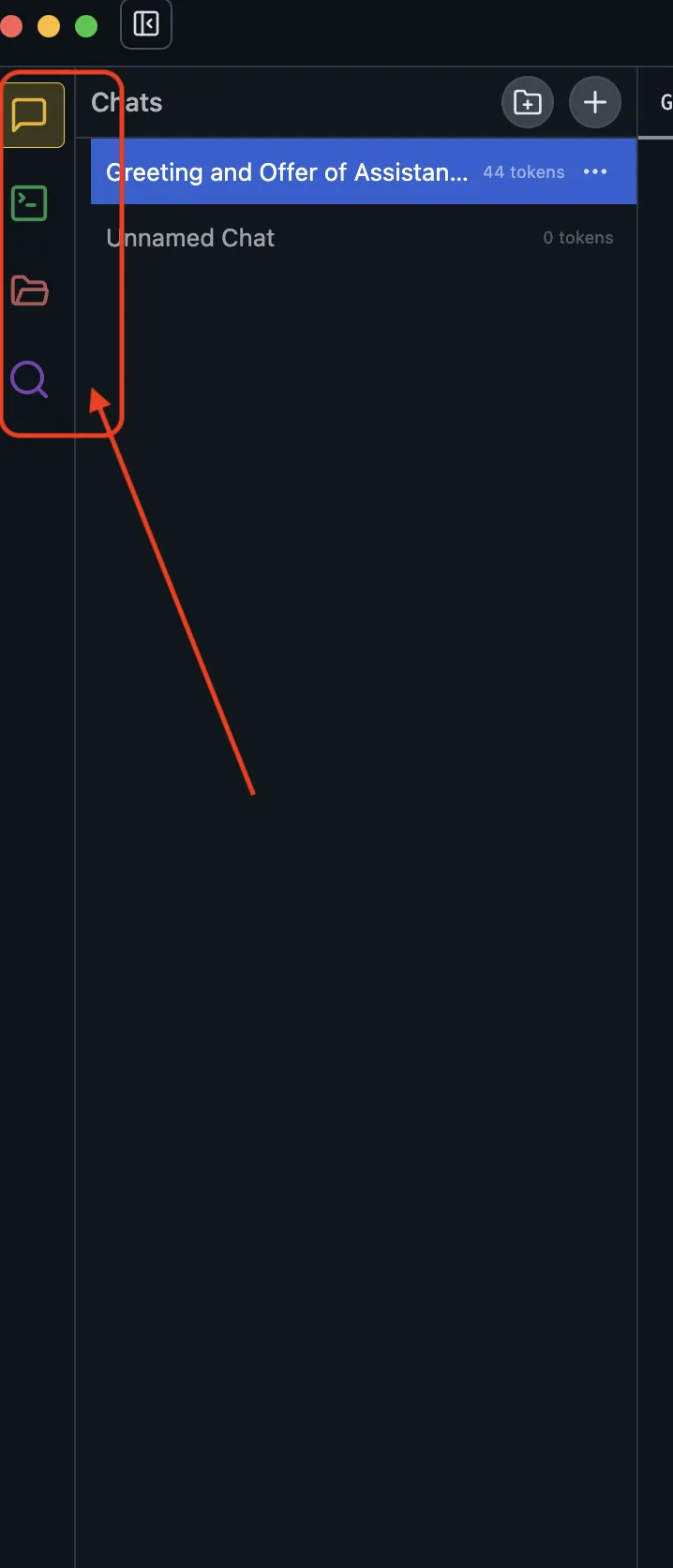

左側メニューの使い方:Chat / Developer / My Models / Discover

LM Studioの操作は、左側メニューの4セクションを押さえると把握しやすいです。

ここでは「普段使い」と「開発統合」で迷わないように、役割ベースで見ていきます。

サイドバーイメージ

Chat:チャット対話モード

Chatは、選択したLLMと対話するメイン画面です。基本操作は次の流れになります。

- 上部で使用するモデルを選択します(例:「llama3-8b-instruct」)。

- 中央の入力欄に質問や命令文を入力し、Enterで実行します。

- 応答は右側にリアルタイム表示されます。

- 上部の歯車アイコンから「温度」「最大トークン数」「システムプロンプト」などの設定を調整可能です。

ChatGPTのように試せるため、応答品質の確認やプロンプト調整に向きます。

Developer:開発・統合用パネル

Developerは、外部アプリに繋ぐための確認・設定を集約した画面です。開発者が見るポイントは次の通りです。

- 「API Endpoint」で

http://localhost:1234/v1を確認し、他アプリで利用します。 - 「Embed」タブでは、ベクトル埋め込みを生成するエンジンとしても活用可能です。

- 「Webhook」などの外部連携機能が今後拡充予定です。

API/SDK/CLIの使い分けは次章の「開発・統合」でまとめます。

My Models:ローカル管理されたモデル一覧

My Modelsは、ダウンロード済みモデルを運用目線で管理するための画面です。よく使う操作は次の通りです。

- モデルごとに「Chat」「Embed」など起動モードを選択します。

- 「⋮(三点リーダ)」から削除や設定変更、再量子化(例:4bit→5bit)などが可能です。

- モデル情報(ファイルサイズ、必要VRAM、元リポジトリURLなど)も確認可能です。

実行対象が一覧化されるため、運用中の全体像を把握しやすい画面です。

Discover:モデルの検索とダウンロード

Discoverは、モデル探索と取得のための入り口です。モデル選定の最初の一歩として使います。

- 検索欄に「llama」「mistral」などのキーワードを入力します。

- 対応モデルが一覧表示され、各モデルに「Download」ボタンが付属します。

- モデル詳細を開くと、量子化形式(GGUF)、対応アーキテクチャ(Chat/Embed)も表示されます。

モデル名が曖昧でも「用途」「人気」「更新日」などで絞り込めます。

この4セクションを使い分けると、LM Studioは単なるチャットアプリではなく、LLMの検証・統合・運用まで見据えたツールとして扱いやすくなります。

次章では、外部アプリから呼ぶ前提の「開発・統合」をまとめます。

開発・統合(API / SDK / CLI)

LM StudioはOpenAI互換APIを起点に、既存のアプリやワークフローへ繋ぎやすい**設計です。

「ローカルで動かす」から一歩進めて、検証や内製組み込みまで持っていく場合は、この章の観点が効いてきます。

APIとしての利用方法

LM Studioは、OpenAI互換のAPIエンドポイント(「http://localhost:1234/v1」など)を提供します。

外部アプリからは、次のように呼び出せます。

curl http://localhost:1234/v1/chat/completions \

-H "Authorization: Bearer YOUR-KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "llama3",

"messages": [{"role": "user", "content": "こんにちは"}]

}'

Python SDK(lmstudio-python)

PythonからLM Studioにアクセスし、API呼び出しやモデル制御が可能です。

Jupyter NotebookやStreamlit、Flaskなどとの連携に適しています。

from lmstudio import ChatSession

chat = ChatSession(api_base="http://localhost:1234")

response = chat.ask("こんにちは。今日の天気は?")

print(response)

OpenAIと同様のインターフェース設計のため、既存コードの移植もしやすいです。

TypeScript SDK(lmstudio-js)

TypeScript/JavaScriptでも利用可能なSDKが提供されており、フロントエンドアプリ(Next.js、Electronなど)との統合にも対応しています。

VS Code拡張やローカルWebアプリへの実装に活用されています。

CLIツール(lms)

コマンドライン操作に対応するCLIも提供されており、運用の自動化や検証の繰り返しで効いてきます。

代表的な用途は次の通りです。

- モデルのダウンロード・一覧・起動に使えます。

- チャット実行やファイル読み込みに使えます。

- スクリプトによるバッチ推論の自動化に使えます。

例:

lms chat --model llama3 --prompt "今日は何の日?"

GUIで固めた運用を、CLIで再現できるようにしておくとチーム内共有もしやすくなります。

Open Responses対応(OpenAIパートナーシップ)

2026年1月15日、LM StudioはOpenAIとパートナーシップを結び、Open Responses仕様に対応しました。

これにより、以下の高度な機能が利用可能になります。

- logprobs(確率表示):モデルがトークンを選択した確信度を数値で確認可能。ゼロに近いほど確信度が高く、モデルの応答信頼性を評価できます。

- トークンキャッシュ統計:以前のリクエストから再利用されたトークン数を表示し、コスト最適化や効率分析が可能です。

- リモート画像URL対応:VLM(Vision Language Model)に外部画像URLを直接提供可能です。

Open Responsesは、LLM呼び出しをプロバイダー非依存にするオープンソース仕様で、統一的なエージェント開発を支援します。詳細はopenresponses.orgで確認できます。

次章では、実際に運用へ進める前提で「モデル選定」と「必要な環境」をまとめます。

モデル選定と推奨環境

最初は「小さめ・量子化・用途一致」で失敗を潰すのが近道です。**

モデル選びは沼になりやすいので、まずは「動く構成」を作ってから拡張する方が安定します。

モデル選びの最短ルール

最短で迷いにくいルールは、次の4つです。ここは“守るほど失敗しにくい”指針として置きます。

- まずは7B〜8B級から:最初の成功体験(読み込み・会話・API呼び出し)を作りやすいです。

- 量子化モデル(GGUFなど)を優先:VRAM/RAM負荷を下げ、端末側で回せる範囲を広げます。

- 用途でモデルを分ける:チャット用 / 埋め込み(Embed)用は、同じ「モデル名」でも適性が異なることがあります。

- 詰まったら“モデルを小さくする”が最優先:速度や安定性の改善は、設定よりもモデルサイズ変更が効く場面が多いです。

最初は「小さく始めて、必要になったら上げる」方針にしておくと、環境要件や運用の見積もりが崩れにくいです。

最低動作環境

小〜中規模モデル(例:Mistral-7B、LLaMA 3 8Bなど)をCPUまたはGPUで実行する場合の目安です。

| 項目 | 推奨スペックの目安 |

|---|---|

| CPU | 4コア以上(Intel Core i5 第10世代以降など) |

| メモリ(RAM) | 16GB以上(8GBでも軽量モデルなら動作可能) |

| ストレージ | SSD推奨、空き容量20GB以上 |

| GPU(任意) | NVIDIA CUDA対応GPU(VRAM 8GB以上推奨) |

CPUオンリーでも動作はしますが、応答速度や大規模モデル運用では限界が出やすい点は押さえておきましょう。

快適に使うための目安(GPUあり)

LLM実行で効いてくるのは、GPUのVRAM容量とCUDA互換性です。代表例を挙げると次の通りです。

- NVIDIA RTX 3060 / 4060:VRAM 12GB → LLaMA 3 8B 程度まで快適です。

- RTX 4080以上:VRAM 16GB以上 → LLaMA 3 13B、Gemma 7Bなども余裕があります。

- RTX 5080/5090(Blackwell):VRAM 16GB〜24GB → 大規模モデルや高速推論に最適です。

- CUDA 12.8自動アップグレード:RTX 50シリーズではドライバ互換時に自動適用されます。

- パフォーマンス向上:CUDA graph有効化でスループット最大35%向上します。

- CUDAバージョン:12.8以降対応(v0.3.15で正式サポート)です。

このあたりは「どのモデルを、どの速度で回したいか」で必要条件が変わるため、用途から逆算して考えるのが確実です。

GPUなしで利用したい場合

GPUがない場合でも、次の工夫で使い勝手は上げられます。

- 量子化済みモデル(GGUF形式)を利用し、VRAMやRAM使用量を削減します。

- チャット履歴を短く保ち、推論処理量を減らします。

- マルチスレッドCPU環境を活用し、CPUでも一定の応答速度を確保します。

次章では、RAG・セキュリティ・トラブル対応をまとめて「運用の勘所」として整理します。

LM Studio利用時のポイント

結ローカル運用でも「何がどこに残るか」「どこへ出ていくか」を先に言語化した方が事故が減ります。

LM Studioは入口が軽い分、運用へ進めるときに“設計が必要な部分”が後から出てきます。この章では、そこだけをまとめます。

ドキュメント対話(RAG)の実運用フロー

RAGは「入れる→整える→探す→答える」の4工程を分けると破綻しにくいです。

LM Studioのドキュメント対話を使う場合も、全体像を一度押さえると設計が楽になります。

- 投入(Ingest):PDF/TXTなどの文書を読み込みます。

- 分割(Chunking):長文を適切な単位に切り、検索しやすくします。

- 埋め込み(Embedding):文書断片をベクトル化し、検索の土台を作ります。

- 検索→回答(Retrieve & Generate):質問に近い断片を探し、LLMが回答を組み立てます。

社内文書で運用する場合は、ここに「更新頻度」「版管理」「アクセス制御」といった要素が乗ります。

まずは小さめの文書セットで試し、精度と負荷感を確認してから拡張するのが安全です。

企業利用で確認したいセキュリティとデータの流れ

企業利用では、次の観点をチェックリスト化しておくと運用に耐えやすくなります。ここは“運用の前提”として固める領域です。

- 入力データの扱い:会話、貼り付けたテキスト、読み込んだ文書がどの範囲に残る前提かを整理します。

- 保存と削除:モデルファイル、キャッシュ、履歴、ログの保存場所と削除方法を確認します。

- 権限と端末統制:誰がどの端末で使うか(持ち出し、BYOD、共有PCなど)を決めます。

- 外部連携(MCP等):通信先・送信内容・確認フローをどうするかを設計します。

- 監査と再現性:業務利用で「なぜその回答になったか」を説明できる運用になっているかを見ます。

ローカルLLMは「クラウドに出さない」だけで完結しません。

運用要件(監査、端末管理、ポリシー)とセットで整えると、強みが活きます。

よくある詰まりどころ(トラブルシュート)

導入初期で詰まりやすいポイントをまとめます。

結論から言うと、「モデルを軽くする」「コンテキストを短くする」「設定を単純化する」が効く場面が多いです。

- 読み込みが遅い/落ちる:モデルサイズを下げる、量子化モデルを選ぶ、空きメモリ/VRAMを確保します。

- VRAM不足で起動できない:より軽い量子化や小さいモデルへ切り替え、他アプリのGPU利用を止めます。

- 応答が途切れる/不安定:チャット履歴(コンテキスト)を短くし、短い入出力で挙動を確認します。

- APIで繋がらない:エンドポイント(例:

http://localhost:1234/v1)とポート、呼び出し側のBase URL設定を確認します。 - RAGの精度が出ない:文書の分割単位や投入する文書量を見直し、小さく試してから拡張します。

トラブル時は「設定を増やす」より先に、モデルサイズ・量子化・コンテキスト長を一段落とす方が、再現性のある改善に繋がりやすいです。

次章では、他ツールとの違いと商用利用をまとめて整理します。

LM Studioの商用利用について

2025年7月8日、LM Studioは利用規約を更新し、これまで必要だった商用ライセンスを撤廃しました。これにより、個人利用だけでなく、企業や組織における職場での利用も完全に無料となりました。

この変更により、企業は追加のライセンス契約やコストを気にせず、チームでの実験や業務利用のためにLM Studioを導入できます。開発元は「ローカルAIを誰もがアクセスしやすく、便利にする」というミッションに沿った変更であると説明しています。

参考:LM Studio is free for use at work

AI導入でお悩みの方へ

まとめ

LM Studioは、ローカル環境で大規模言語モデル(LLM)を柔軟かつ安全に活用できる統合型アプリケーションです。

GUIベースで導入が早く、OpenAI API互換のローカルサーバーや、RAG・マルチモーダル対応など、実運用に繋がる機能が揃っています。

2026年1月に公開された最新版(v0.3.39)では、以下のようなアップデートが追加され、機能面がさらに広がりました。

- OpenAIとのパートナーシップによるOpen Responses仕様対応(logprobs、トークンキャッシュ統計)

- Model Context Protocol(MCP)によるエージェント機能拡張

- RTX 50シリーズ(Blackwell)GPU対応とCUDA 12.8自動アップグレード

- DeepSeek R1、Gemma 3n、Qwen3、gpt-ossなど最新モデル対応

ローカルLLM活用は、プライバシー確保、オフライン対応、カスタマイズ性の面で注目が続いています。

その中でLM Studioは、導入のハードルが低く、統合・拡張まで見据えやすい選択肢です。

「ローカルでもここまでできる」を確認したい場合は、まずは小さめのモデルから試してみてください。

AI総合研究所では、ローカルLLMの導入支援や活用方法のアドバイスも行っています。お気軽にご相談ください。