この記事のポイント

CodexはCLI・IDE拡張・Codex Cloud・macOSデスクトップアプリを中核とする「AIコーディングエージェント」で、ChatGPT有料プランから利用できる

2026年2月登場の **GPT-5.3-Codex** は自身の開発にも貢献した初の「自己開発型AI」で、GPT-5.2-Codexより約25%高速

GPT-5.3-Codex はサイバーセキュリティ領域で初の「High Capability」認定を受け、専用のセーフガードとTrusted Access for Cyberが整備された

macOSデスクトップアプリにより、複数エージェントの並行実行・Git Worktree・Skills & Automations に対応

ChatGPT Plus / Pro などのプランに一定の利用枠として含まれ、不足時は「クレジット」追加で柔軟にスケール可能

Claude Code・Devinなど他社AIコーディングツールとの比較では、Codexは既存ワークフロー(GitHub / Slack / IDE)への統合が強み

CiscoやInstacartなどの企業が、コードレビュー時間の削減や技術的負債解消にCodexを活用

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

Codexは、OpenAIが提供するクラウドベースのAIコーディングエージェントで、バグ修正から大規模リファクタリング、コードレビューまで、ソフトウェア開発の一連のタスクを自律的にこなします。 2026年2月には最新モデル GPT-5.3-Codex が登場し、自身の開発プロセスにも貢献した初の「自己開発型AI」として注目を集めています。また、macOS向けデスクトップアプリのリリースにより、複数エージェントの並行実行やSkills & Automationsにも対応しました。 本記事では、Codexの基本機能から、最新モデル構成、CLI・IDE・クラウド・モバイル・デスクトップアプリでの使い方、Claude Code・Devinなど他社ツールとの比較、料金体系、企業での活用事例、セキュリティまでを、2026年2月時点の公式情報にもとづいて整理します。 AI総合研究所では、企業のChatGPT / Codex導入支援を行っています。お気軽にご相談ください。

なお、GPT-5.3-Codexの詳細については、以下の記事で詳しく解説しています。 GPT-5.3-Codexとは?性能や使い方、GPT-5.2-Codexとの違いを解説

目次

GitHub Copilot / ChatGPTとCodexの違い

【GPT-5.1-Codex-Max】長時間タスク向けフラグシップモデル

【GPT-5.3-Codex】自己開発型AIとしての最新フラグシップモデル

【GPT-5.3-Codex-Spark】リアルタイムコーディング向け軽量モデル

Codexと周辺機能の連携(Slack・SDK・Web検索・iOSなど)

管理ツール(Analytics / Usage Dashboard)

GPT-5.3-Codexの「High Capability」認定と追加セーフガード

ステップ1:個人レベルでCLI / IDE拡張を試す(小さなPoC)

ステップ2:小さなリポジトリでAGENTS.mdを整備する(ルールの言語化)

ステップ3:Slack連携やCodex Cloudで長時間タスクを試す(チーム活用)

Codexとは?

Codexは、OpenAIが開発したソフトウェア開発支援向けのクラウドベースAIエージェントです。

コード補完だけでなく、タスクの分解や実装計画の立案、テスト・レビューまでを一連のフローとして扱えるように設計されています。

Codexは、主に次の4つの形態で提供されます。

-

Codex CLI ターミナル上で対話的に操作するコマンドラインツール

-

Codex IDE拡張機能 VS Code や Cursor などのIDEに統合された拡張機能

-

Codex Cloud 大規模なタスクをバックグラウンドで実行するクラウド環境

-

Codex macOSアプリ 複数エージェントを並行管理できるデスクトップアプリケーション(2026年2月リリース)

これらを組み合わせることで、バグ修正、機能追加、テスト作成、コードレビュー、大規模リファクタリングなど、現場で発生する多様なタスクを「AIチームメイト」に任せることができます。

Codexの全体イメージ(参考:OpenAI公式ブログ「アップグレード版 Codex が登場」)

GitHub Copilot / ChatGPTとCodexの違い

Codexを理解するうえで、「すでにある開発支援ツールとの違い」は最初に押さえておきたいポイントです。

GitHub Copilotとの違い

GitHub Copilotは、主に次のような位置づけです。

- エディタ内のコード補完やインライン提案が中心

- Copilot Chatを通じて、ファイル単位・プロジェクト単位の質問も可能

- あくまで「開発者の手元作業を楽にする」アシスタント

一方でCodexは、次の点が大きく異なります。

- CLI / IDE / Cloud / GitHub / Slack / iOS / macOSアプリ までを含むエージェント基盤

- テスト実行やコマンド実行、PR作成、長時間リファクタリングなど、

「手を動かす作業そのもの」を自律的に実行 - Codex Cloud上でコンテナを立ち上げ、コード編集〜テスト〜PR作成まで完走

ざっくり言うと、

- 「今開いているファイルの作業を早くしたい」 → Copilot

- 「リポジトリ全体を触る大きめのタスクを丸ごと任せたい」 → Codex

という住み分けになります。

ChatGPTとの違い

ChatGPT(ブラウザ版 / モバイルアプリ)は、汎用的なAIアシスタントです。

- 仕様相談、設計レビュー、技術調査など「文章ベースのやり取り」が得意

- コードも書けるが、標準のブラウザ版・モバイル版では主にファイルアップロードや貼り付けベースでコードを扱い、リポジトリへの直接アクセスを前提とはしていない

Codexは、ChatGPTの汎用性をベースにしつつも、

- 実際のリポジトリやターミナルに直接アクセス

- テスト実行やビルド、依存関係インストールなどの環境操作を自動化

- PRレビューやリファクタリングをタスクとして継続実行

といった「開発フローへの埋め込み」に特化しています。

そのため、現場での使い分けとしては

- 仕様検討・設計レビュー・技術調査 → ChatGPT(ブラウザ / モバイル)

- 実際のコードベースを触るタスク → Codex(CLI / IDE / Cloud / GitHub)

と考えると整理しやすくなります。

他社AIコーディングツールとの比較

Codex以外にも、AIコーディングエージェントは複数の選択肢が登場しています。ここでは、代表的なツールとCodexのポジショニングを比較します。

| 比較項目 | Codex(OpenAI) | Claude Code(Anthropic) | Devin(Cognition) |

|---|---|---|---|

| 月額料金 | ChatGPT Plus $20〜 | Claude Pro $20〜 | Core $20〜(ACU従量課金) |

| 利用形態 | CLI / IDE / Cloud / macOSアプリ / Slack / iOS | CLI(ターミナル) | クラウドIDE+ブラウザ |

| ベースモデル | GPT-5.3-Codex | Claude Sonnet 4.6 / Opus 4.6 | 独自モデル |

| 並行タスク | macOSアプリでGit Worktree並行実行 | 単一セッション | 複数セッション対応 |

| 得意な領域 | 既存リポジトリのリファクタリング・レビュー・PR作成 | コードベース全体の理解・ファイル編集・Git操作 | 長時間の自律タスク・PoC構築 |

ここで注目すべきは、各ツールの「得意領域」の違いです。Codexは既存の開発ワークフロー(GitHub / Slack / IDE)への統合に強みがあり、Claude Codeはターミナル中心の軽量な操作体験を提供し、Devinはプランニングからデプロイまでの完全自律を目指す設計です。

チーム規模や開発スタイルに合わせて、単独利用・併用の両方を検討するのが現実的です。

Codexのモデル構成と性能

ここからは、「中で動いているモデル」にフォーカスして、Codex関連モデルのラインナップと性能を整理します。

Codex関連のモデルは、2026年2月時点で主に次のような系列で提供されています。以下のリストでは、各モデルの特性と位置づけを整理しました。内容を読んだ上で、次のセクションで主要モデルの詳細を掘り下げていきます。

-

GPT-5-Codex

GPT-5ベースの標準的なコーディングモデル。Codex CLI・IDE・Cloud・コードレビューのデフォルトエンジンとして広く使われてきたモデル

-

GPT-5.1-Codex-Max

GPT-5.1系の推論モデルをベースにしたフラグシップモデル。コンテキスト圧縮と長時間タスク対応に最適化され、24時間規模のリファクタリングにも対応

-

GPT-5.2-Codex

GPT-5.2世代のコーディングモデル。GPT-5.1-Codex-Maxの後継として、日常的なコーディングタスクの精度と速度を両立した中核モデル

-

GPT-5.3-Codex

2026年2月5日に発表された最新のフラグシップモデル。GPT-5.2-Codexのコーディング性能とGPT-5.2の推論・専門知識を統合し、約25%高速化を実現。OpenAIの開発プロセスで自身のデバッグに貢献した初の「自己開発型AI」としても注目されている

-

GPT-5.3-Codex-Spark

2026年2月12日にリサーチプレビューとして公開された、リアルタイムコーディング向けの軽量モデル。Cerebrasのウェハースケールエンジン上で毎秒1,000トークン以上の出力速度を実現

ここで注目すべきは、最新のGPT-5.3-Codexが「自身の開発に貢献した初のモデル」であるという点です。OpenAIのCodexチームは、GPT-5.3-Codexの初期バージョンを使って自身のトレーニングのデバッグ、デプロイメント管理、テスト結果の診断を行いました。つまり、AIが自身の改善サイクルに組み込まれる新しい開発パラダイムが始まっているということです。

【GPT-5-Codex】標準モデル

GPT-5-Codexは、汎用モデル GPT-5 をベースに、「エージェント的なコーディングタスク」に特化して最適化されたモデルです。

フルプロジェクトの構築、機能追加、バグ修正、大規模リファクタリング、コードレビューといった「現場の開発タスク」を想定して訓練されています。

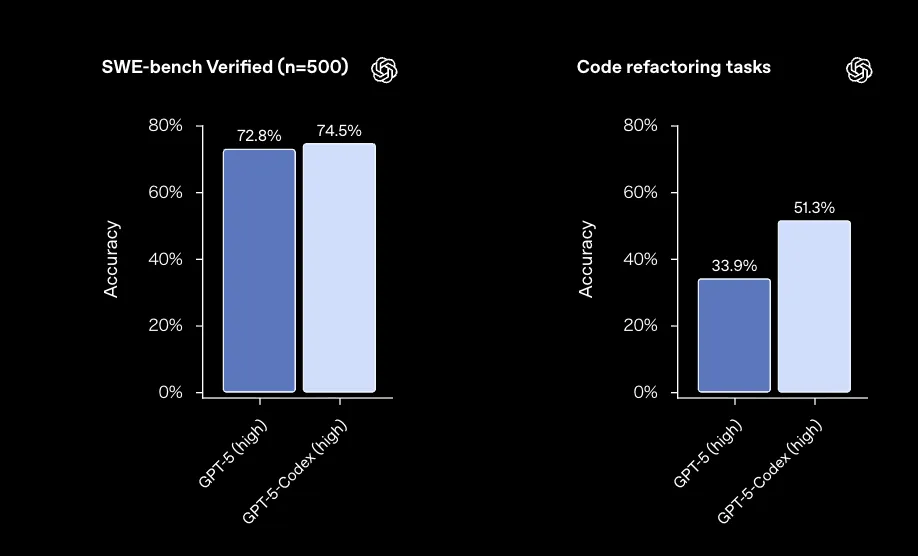

大規模リファクタリングでGPT-5を上回る

OpenAIは、SWE-bench Verified や大規模リファクタリングタスクで GPT-5-Codex を評価しています。

-

SWE-bench Verified OSSのIssueベースの修正タスクを自動評価するベンチマーク

-

リファクタリング評価 数百ファイル・数千行規模の変更が含まれるプルリクエストを再現したタスク群(例:Giteaの PR で232ファイル・3,500行以上の変更)

これらの評価では、GPT-5-Codexは以下のような特徴を示しています。

- 一般的なソフトウェア開発タスク(SWE-bench Verified)では、GPT-5と同等以上の正解率

- 大規模リファクタリングタスクでは、GPT-5より高い成功率を達成

- コードベース全体の依存関係を追いかけながら、整合性を保った変更を行いやすい

SWE-bench Verifiedと大規模リファクタリングタスクのイメージ(参考:OpenAI公式ブログ)

タスクの難易度に応じた「可変の思考量」

GPT-5-Codexの特徴のひとつが、タスクの難易度に応じて思考トークン(hidden reasoning)を自動で増減させる挙動です。

- もっとも単純な10%のターンでは、GPT-5と比べて約94%少ないトークンで応答

- もっとも複雑な10%のターンでは、GPT-5の約2倍のトークンを使ってじっくり考える

その結果、次のような使い分けが自然に行われます。

- 簡単な作業 レスポンスが速く、コストも抑えめ

- 難しい作業 時間をかけてコードを編集・テストしながら解決策を探る

OpenAI社内での評価では、GPT-5-Codexが7時間以上連続でタスクに取り組み、テスト失敗を自力で修正しながら完了まで到達したケースも報告されています。

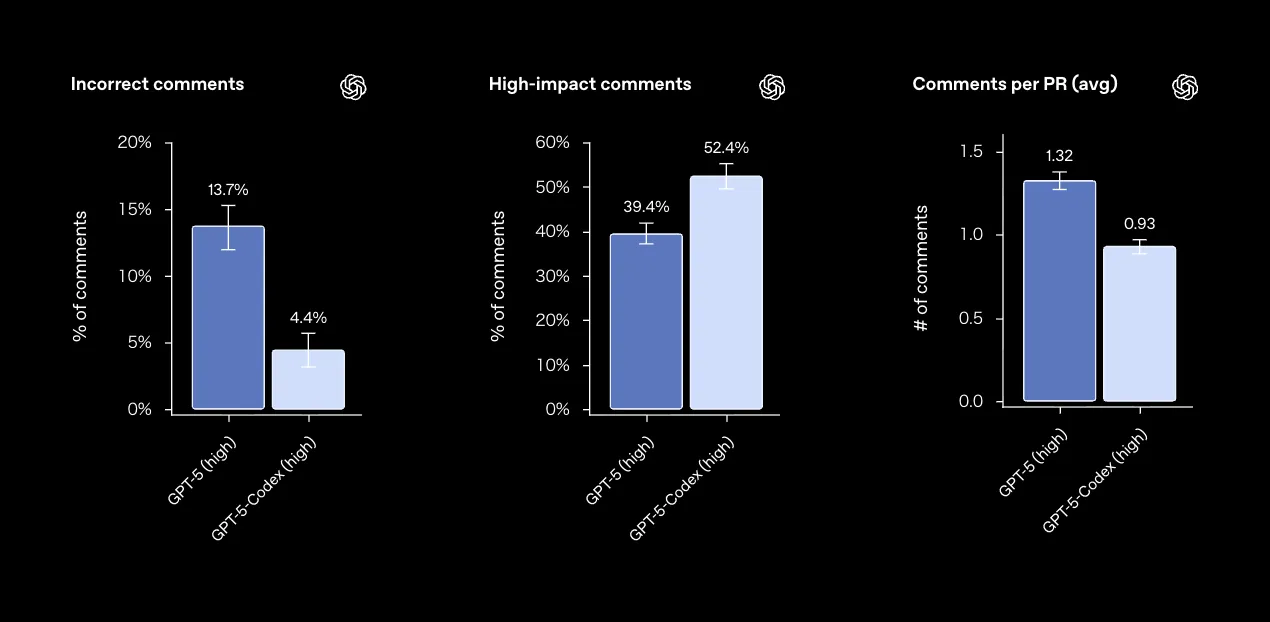

コードレビュー品質:ノイズを減らし重要な指摘に集中

GPT-5-Codexは、コードレビュー能力についても専用の評価が行われています。OpenAIはOSSリポジトリのコミットを対象に、エンジニアによるレビューコメントとGPT-5 / GPT-5-Codexのコメントを比較し、次の観点で評価しています。

- コメントが事実として正しいか

- 指摘が重要な問題に関するものか

結果として、GPT-5-Codexのレビューコメントは、GPT-5と比べて:

- 誤った指摘の割合が大きく減少

- 重要な指摘の割合が増加

- コメント総数はやや減り、開発者の注意を「本当に直すべき箇所」に集中させやすい

コードレビュー品質の比較イメージ(参考:OpenAI公式ブログ)

単なる「レビューコメント数の増加」ではなく、重要で正確なコメントだけを残す方向の最適化が行われている点が実務上のポイントです。

【GPT-5.1-Codex-Max】長時間タスク向けフラグシップモデル

ここからは、2025年11月に発表された GPT-5.1-Codex-Max にフォーカスします。長時間タスクや大規模リポジトリでの利用を前提とした「次世代コーディングエンジン」です。

GPT-5.1-Codex-Maxは、GPT-5.1系の推論モデルをベースにしたフロンティア・コーディングモデルで、CodexのCLI・IDE拡張・Cloud・コードレビューのすべてで利用できます。

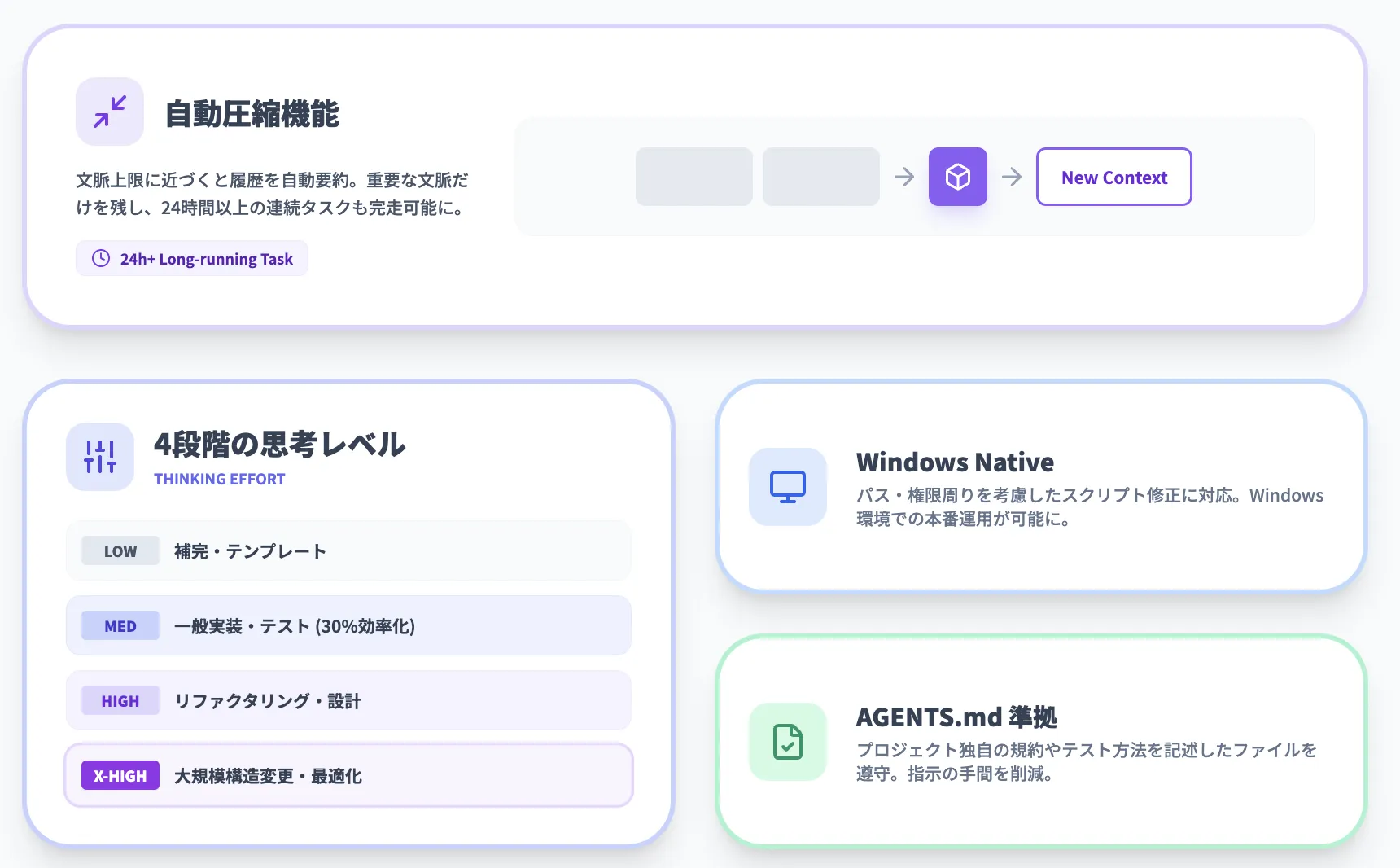

自動コンテキスト圧縮機能(Compaction)

最大の特徴は、コンテキスト圧縮(Compaction)にネイティブ対応していることです。

通常、LLMはコンテキストウィンドウ(入力できるトークン数)に上限があり、大規模リファクタリングや長時間の対話では「履歴が長すぎてこれ以上続けられない」という問題が発生します。

GPT-5.1-Codex-Maxでは、次のような仕組みでこれを回避します。

- セッションがコンテキスト上限に近づくと、モデル自身が履歴を要約し「重要な文脈だけ」を残す

- 新しいコンテキストウィンドウを確保し、タスクを継続

- この圧縮を繰り返しながら、プロジェクト全体レベルのタスクを完走

OpenAI内部評価では、24時間以上にわたりCodex CLIのOSSリポジトリをリファクタリングし続けた事例も報告されています。

4段階の思考レベルと効率化

GPT-5.1-Codex-Maxは、タスクに応じて「どの程度じっくり考えるか(thinking effort)」を選択できるようになっています。

代表的なモードは次の通りです。

| 思考レベル | 特徴 | 想定ユースケース |

|---|---|---|

| low | もっとも軽量・高速 | シンプルな補完、テンプレート生成 |

| medium | 標準的な思考量 | 一般的な実装・バグ修正・テスト作成 |

| high | じっくり考える | 複雑なリファクタリング、設計レビュー |

| xhigh | 最高の思考量 | 大規模プロジェクトの構造変更、難度の高い最適化 |

OpenAIの評価では、SWE-bench Verified において、同じmedium設定で比較した場合、GPT-5.1-Codex-MaxはGPT-5.1-Codexよりも少ない思考トークン(約30%削減)で同等以上の性能を達成しています。

Windows環境への対応

GPT-5.1-Codex-Maxは、Codexシリーズとして初めてWindows環境でのエージェント動作を前提に訓練されたモデルです。

これにより、従来はmacOS / Linuxに比べて制約が多かったWindows開発環境でも、次のようなタスクをCodexに任せやすくなりました。

- Windows固有のパス / 権限まわりを考慮したスクリプト修正

- Windows向けビルド・デプロイフローの整備

- Windows環境でのテスト実行・ログ解析

Windows中心の企業開発でも、Codexを「本番投入」しやすくなっています。

コードレビューの精度:不正確なコメントを抑制

GPT-5-Codex世代で向上したコードレビュー品質は、GPT-5.1-Codex-Maxでさらに強化されています。OpenAIの評価では、長時間にわたるタスクや大規模リポジトリを前提としたテストで、重要度の高い指摘に集中したコメントが出力されることが確認されています。

ポイントを整理すると次の通りです。

- テスト実行・ログを踏まえたコメントが増え、「動くかどうか」の観点での指摘がしやすい

- 些末なスタイル指摘を減らし、仕様逸脱やバグの温床になり得る箇所にフォーカス

- 長時間タスク中も、コンテキスト圧縮のおかげでレビュー基準がぶれにくい

コードレビューを完全自動化するというより、「もう1人のシニアレビュアー」としてチームに加えるイメージに近い位置づけです。

タスクに応じて思考を最適化、長時間タスクにも対応

GPT-5系と比較したときの特徴を整理すると、次のような「メリハリの効いた使い方」が可能になります。

-

小さな修正や質問

→ GPT-5-Codex / GPT-5.1-Codexをmedium以下で使い、レスポンス重視

-

複雑なリファクタリングや長時間のリサーチ

→ GPT-5.1-Codex-Maxをhigh / xhighで使い、品質重視

特にGPT-5.1-Codex-Maxは、24時間規模の長時間タスクでもコンテキスト圧縮を繰り返しながら作業を継続できるため、「プロジェクト単位の整理」をAIに任せたいケースで選択肢になります。

【GPT-5.3-Codex】自己開発型AIとしての最新フラグシップモデル

2026年2月5日に発表されたGPT-5.3-Codexは、GPT-5.2-Codexのコーディング性能とGPT-5.2の推論・専門知識能力を1つのモデルに統合した最新のフラグシップモデルです。Codexアプリ、CLI、IDE拡張、Webのすべてで利用できます。

GPT-5.3-Codexが注目される理由は、性能面の進化だけではありません。以下に主な特徴を整理します。

-

自己開発型AI OpenAIのCodexチームは、GPT-5.3-Codexの初期バージョンを使って、自身のトレーニングのデバッグ、デプロイメント管理、テスト結果と評価の診断を行った。つまり、このモデルは自身の開発プロセスに貢献した初のモデル

-

約25%の高速化 GPT-5.2-Codexと比較して約25%高速に動作し、リサーチやツール呼び出し、複雑な実行を伴う長時間ワークフローでの生産性が向上

-

High Capability認定 OpenAIのPreparedness Frameworkにおいて、サイバーセキュリティ領域で初めて「High Capability」に到達したモデル。これに伴い、専用のセーフガードが適用されている(詳細はセキュリティセクションで後述)

ここで注目すべきは、「自己開発型AI」という特性が持つ意味です。従来はAIモデルの改善にはすべて人間のエンジニアが介入していましたが、GPT-5.3-Codexでは、モデル自身がデバッグや評価の分析に貢献することで、開発サイクルの短縮と品質向上を両立しています。これは、AIが「道具」から「開発チームの一員」へと役割を拡張していくことを示唆する重要な転換点といえます。

【GPT-5.3-Codex-Spark】リアルタイムコーディング向け軽量モデル

2026年2月12日にリサーチプレビューとして公開されたGPT-5.3-Codex-Sparkは、GPT-5.3-Codexの小型版であり、リアルタイムコーディング向けに設計された初のCodexモデルです。

従来のCodexモデルでは、200トークンの応答を生成するのに約3秒かかっていましたが、Codex-Sparkは同じ応答を200ミリ秒未満で返します。以下に主な特性を整理します。

-

毎秒1,000トークン以上の出力速度 Cerebras社のWafer Scale Engine 3上で動作し、超低レイテンシの推論を実現

-

実用的なコーディング能力の維持 軽量化しつつも、ターゲットを絞った編集、ロジックの再構成、インターフェースの改善といった実務タスクに十分対応

-

リアルタイム共同作業の実現 即座にフィードバックが返るため、人間が考えながらコードを書くリズムを崩さない対話的な開発体験が可能

2026年2月時点では、ChatGPT Proユーザー向けにCodexアプリ、CLI、VS Code拡張でリサーチプレビューとして提供されています。

AGENTS.mdへの準拠性が向上

Codexは、リポジトリ内に配置した AGENTS.md ファイルを読み込むことで、そのプロジェクト独自のルールに合わせた振る舞いができます。

- テスト実行コマンド

- コーディング規約や命名ルール

- 重要なディレクトリ構成や設定ファイル

GPT-5-Codex世代から、AGENTS.mdをきちんと読み、その指示を守る能力が強化されており、GPT-5.3-Codexでもこの流れが引き継がれています。

プロンプトで毎回細かいルールを説明するのではなく、「プロジェクトの作法」をAGENTS.mdに集約し、Codexにはそれを読ませる、という使い方が推奨されています。

【関連記事】

AI開発の新常識「agents.md」とは?AIの性能を引き出す書き方を徹底解説

GPT-5.3-Codex-Sparkとは?主な特徴や使い方、料金体系を解説!

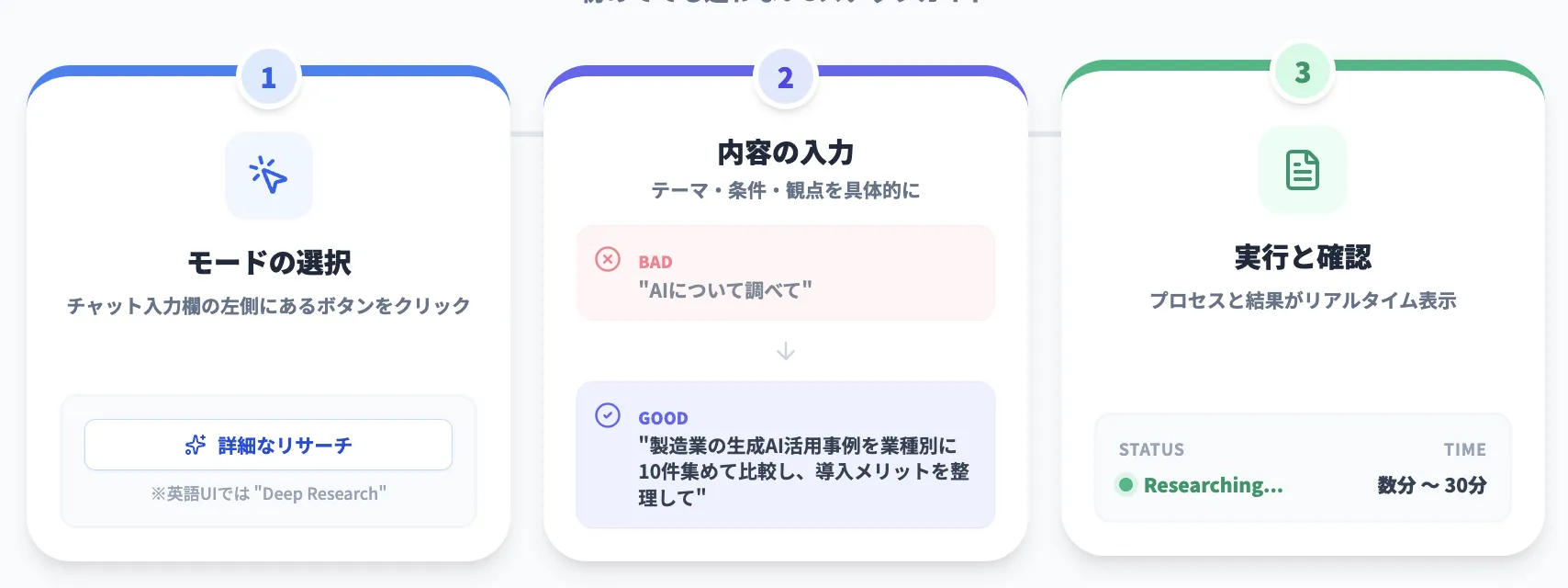

Codexの使い方(CLI / IDE / Cloud)

ここからは、「どこからCodexにアクセスして、どう使い始めるか」という観点で、代表的な3つの入り口(CLI / IDE拡張 / Cloud)ごとの使い方を整理します。

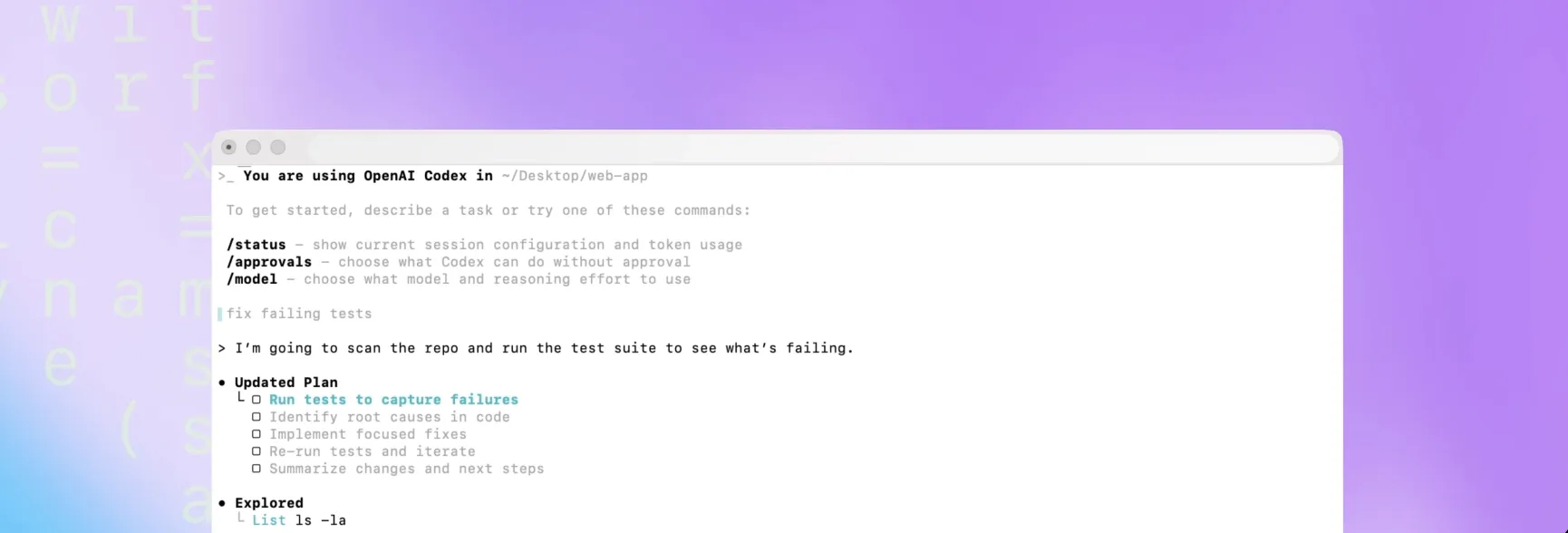

1. Codex CLI

Codex CLIのイメージ(参考:Codex CLI GitHubリポジトリ)

Codex CLIは、ターミナル上で動作するオープンソースのクライアントです。

主な特徴は次の通りです。

- 対話的なUI(TUI)で、タスクのToDoリストや進捗を可視化

- モデルや思考レベルを /model コマンドで変更可能

- 承認モード(read-only / auto / full access)を切り替え可能

- 画像添付(スクリーンショットやワイヤーフレーム)にも対応

- Web検索・MCPなどのツール呼び出しに対応

- 音声入力(スペースバー長押しで録音・文字起こし)に対応(CLI 0.105.0〜)

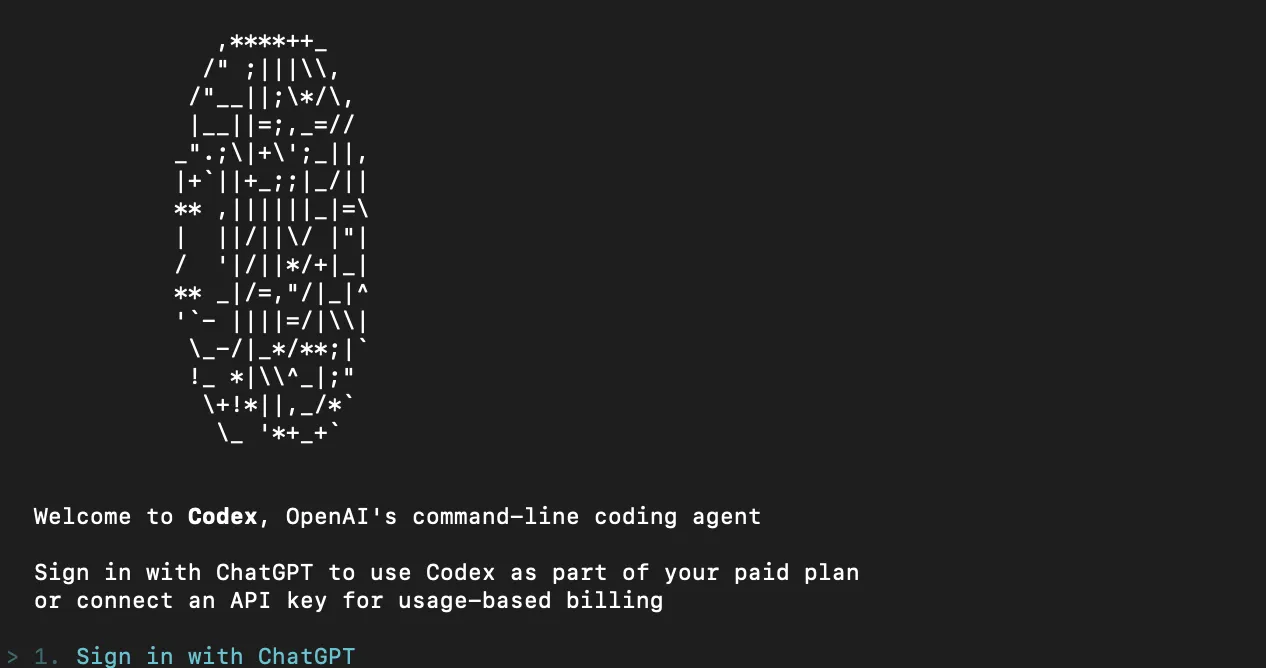

Codex CLIのセットアップと基本的な使い方

Codex CLIは、npmまたはHomebrewからインストールできます。

# npm経由

npm install -g @openai/codex

# Homebrew経由(対応環境のみ)

brew install codex

インストール後、ターミナルで「codex」を実行すると、初回はChatGPTアカウントでのサインインが求められます。

Codex CLIの初期画面

サインイン後の基本的な流れは次の通りです。

- 初回はリポジトリ構造のスキャン結果や推奨タスクが表示される

- 画面下部の入力欄に、自然言語でタスクを入力する

- 例:「このリポジトリで使われていないコンポーネントを洗い出して」

- Codexが計画(plan)を提示するので、内容を確認して承認する

- 実行中のコマンド・編集ファイル・テスト結果はTUI上で逐次確認できる

- 必要に応じて /model や承認モードを切り替えながら、タスクを連続して依頼する

日常的な開発では、「ターミナルを開いたらとりあえずcodexを立ち上げておく」くらいの運用が現実的です。

2. Codex IDE拡張機能

Codex IDE拡張機能は、VS CodeやCursorなどのIDEに統合された拡張機能です。

主な特徴は次の通りです。

- 開いているファイルや選択中のコードを自動でコンテキストとして利用

- 入力欄下のスイッチャーからモデル・思考レベル・承認モードを切り替え

- IDE上からCodex Cloudにタスクを「委任」し、重い処理をバックグラウンドに回せる

IDE拡張機能の基本的な使い方

- VS Code / Cursorなどの拡張機能マーケットプレイスから「Codex」をインストール

- ステータスバーやサイドバーのCodexアイコンからチャットパネルを開く

- 編集中のファイルを開いた状態で、チャットにタスクを入力する

- 例:「このファイルで使われていない関数を削除するPRを作って」

- Codexが差分案(diff)を提示するので、IDEの差分ビューで確認して反映

- より大きな変更が必要な場合は、「この変更をCodex Cloudに委任」といったアクションで、長時間タスクとして投げる

「細かい修正・ファイル単位の作業はIDE拡張」「大きなタスクはCloudへ委任」という使い分けがしやすくなっています。

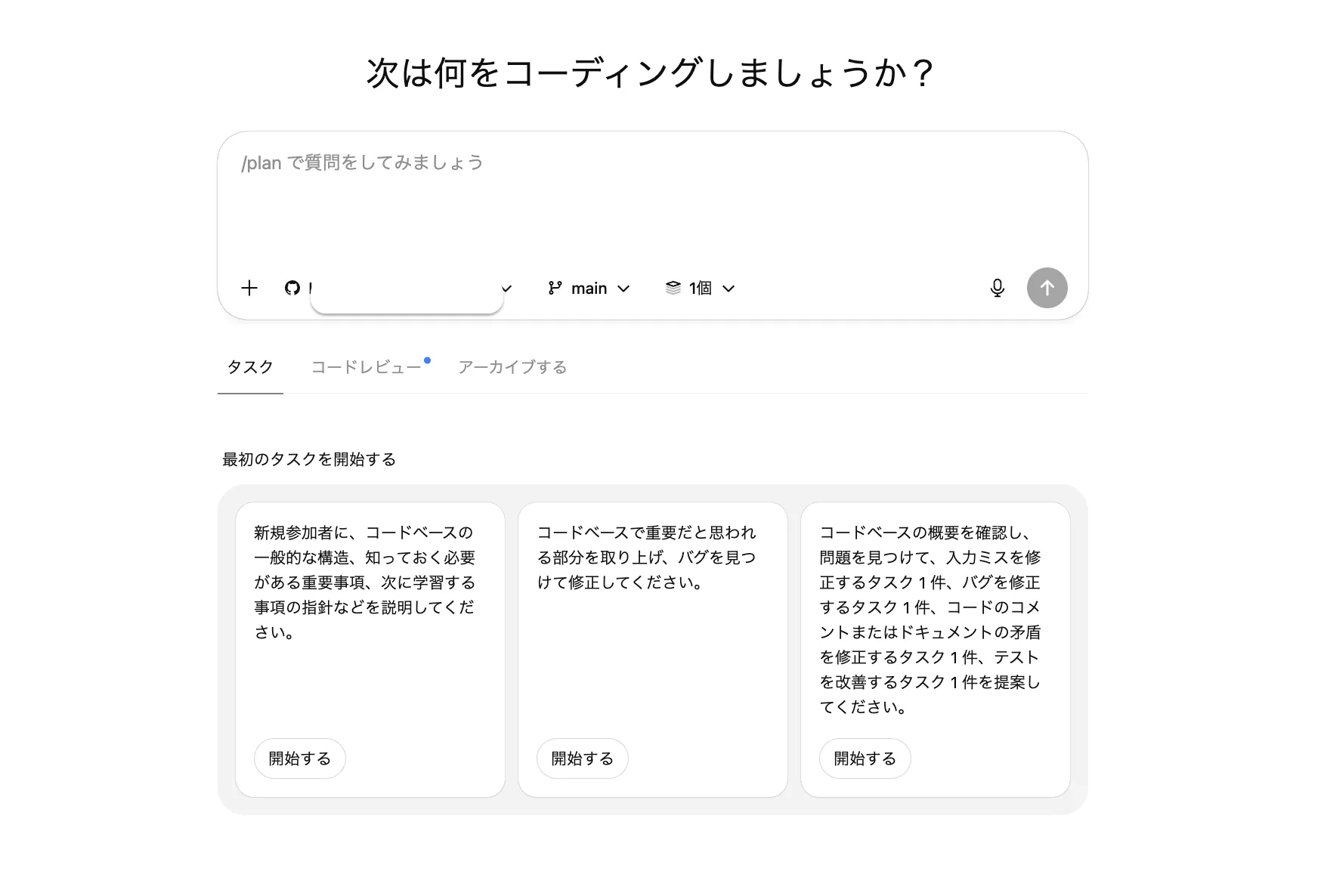

3. Codex Cloud

Codex Cloudは、長時間かかるタスクや大規模リファクタリングをバックグラウンドで処理するクラウド環境です。

代表的な用途は次の通りです。

- プロジェクト全体を対象にしたリファクタリング提案

- コードベース全体の構造理解(アーキテクチャ図の生成など)

- 脆弱性スキャンと修正案の提案

- 大規模なテストコードの追加・整理

タスクごとに隔離されたコンテナが起動し、その中でコード編集・テスト実行が行われます。

Codex Cloudの基本的な使い方

- 「https://chatgpt.com/codex」にアクセスしてGitHubアカウントを接続する

- Codex Cloudで扱いたいGitHubリポジトリを選び、必要に応じて Cloud 環境(対象ブランチ、ビルド・テストコマンドなど)を設定する

- Web上のCodex画面、IDE拡張(IDE → Cloud tasks)、ChatGPT iOSアプリのCodexタブ、またはGitHub上での「@codex」メンションから Cloud タスクを開始する

- Cloudタスクが起動すると、Codexが専用のサンドボックスコンテナを立ち上げ、指定したリポジトリと依存関係を読み込んで処理を実行する

- 実行中タスクのログや進捗は、CodexのWeb UIやIDE拡張、GitHubのスレッドなどから確認する

- タスク完了後、Codexが作成したPRやパッチを人間がレビューし、必要に応じて修正してからマージする

Codexの主要機能とできること

ここからは、エンジンやツールの話から一歩引いて、「Codexを使うと開発現場で何ができるのか」を機能ベースで整理します。

Codexは、日常的なソフトウェア開発タスクをAIエージェントにオフロードすることを目的として設計されています。とくに次のような領域が得意です。

バグ修正・コード生成・テスト作成の自動化

このセクションでは、「AIに任せやすい定番タスク」を整理します。これらはCLI・IDE・Cloudのどこからでも依頼できます。

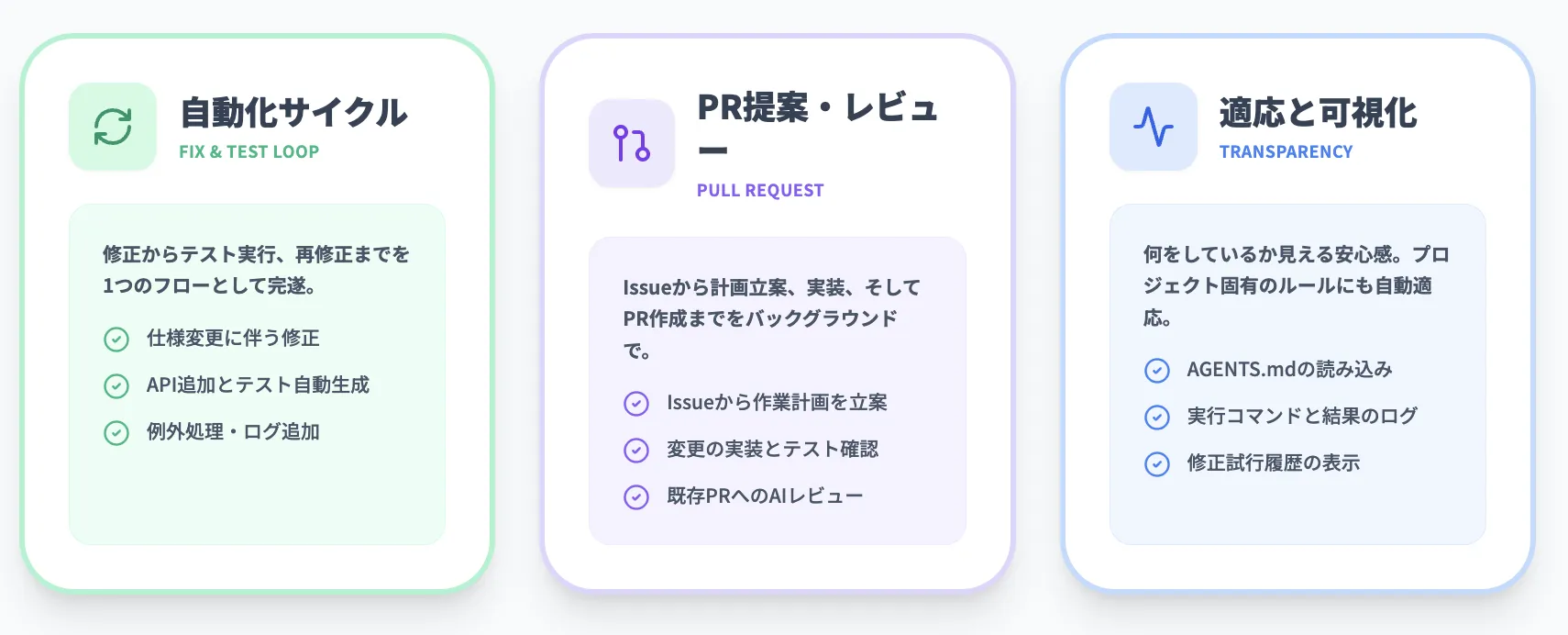

Codexは、自然言語での依頼文(プロンプト)にもとづいて、既存コードのバグ修正や新機能のコード生成を行います。テストコードの自動生成・実行も可能で、「修正 → テスト → 再修正」までを1つのフローとして任せることができます。

代表的なユースケースは次の通りです。

- 既存機能の仕様変更に伴う修正

- 新しいAPIエンドポイントの追加とテストコード作成

- 例外処理やログ出力の追加

- パフォーマンスボトルネックの候補箇所の洗い出し

Pull Request(PR)の提案とレビュー

次に、PRベースの開発フローにCodexを組み込む方法を見ていきます。

Codexは、GitHubリポジトリと連携することで、変更内容をPull Request単位でまとめて提案できます。

- Issueやタスクの説明から作業計画を立案

- 変更内容をローカル or Cloudで実装

- テストを実行し、結果を確認

- PRとしてまとめ、レビューコメントも付与

さらにGitHubのPRコメントで @codex review のようにメンションすることで、既存PRに対するAIコードレビューを依頼することも可能です。

プロジェクトへの自動適応と動作ログの可視化

最後に、「AIが何をしているのか分かる状態を保つ」ための仕組みを整理します。

Codexは、次のような情報を読み取ってプロジェクトに自動適応します。

- AGENTS.md や README、テスト用スクリプト

- 開いているファイルやカレントディレクトリ

- 過去のターミナルログやテスト結果

タスク実行中は、CLIやWeb UI上で以下のログが確認できます。

- 実行したコマンドとその結果

- 編集したファイルと差分(diff)

- 失敗したテストと修正の試行履歴

「何をしているか分からないブラックボックス」ではなく、人間がいつでも確認・介入できるペアプロパートナーとして振る舞う設計になっています。

Codexと周辺機能の連携(Slack・SDK・Web検索・iOSなど)

Codex本体に加えて、実務で効いてくるのが周辺機能・連携です。ここでは、GAタイミングで追加された機能と、その後段階的に追加された高度な機能を整理します。

macOSデスクトップアプリ(2026年2月2日)

2026年2月2日にリリースされたCodex macOSアプリは、**複数のAIコーディングエージェントを並行管理するための「コマンドセンター」**として設計されたデスクトップアプリケーションです。Apple Silicon搭載のMacで利用できます。

従来のCLIやIDE拡張では1つのタスクを順番にこなすのが基本でしたが、macOSアプリでは複数のエージェントスレッドを同時に立ち上げ、並行して作業を進められます。主な特徴を以下に整理します。

-

複数エージェントの並行実行 1つのリポジトリに対して複数のエージェントを同時に起動し、異なるタスクを並行して処理できる。各エージェントはGit Worktreeにより独立した作業コピーで動作するため、互いの変更が干渉しない

-

Git Worktree対応 新しいスレッドを作成する際に「Local」と「Worktree」を選択可能。Worktreeモードでは、通常のプロジェクトとは独立した作業環境が自動的に作られるため、本番コードに影響を与えずに複数の実験や修正を並行して試せる

-

Skills 指示、リソース、スクリプトをバンドルした再利用可能なタスクテンプレート。コード生成だけでなく、情報収集、問題解決、ドキュメント作成などにCodexの能力を拡張できる

-

Automations Skillsと組み合わせて、定期的なタスクをバックグラウンドで自動実行する機能。頻度やトリガーを設定しておくと、Codexが指定のスケジュールでタスクを実行し、結果をレビューキューに格納する

-

MCPショートカット 2026年2月のアップデートで、コンポーザー内にMCPツール呼び出しのショートカットが追加された。@メンションやSkillメンションをインラインレビューコメントでも利用できるようになっている

ここで注目すべきは、Automationsの存在です。たとえば「毎朝8時にリポジトリの依存ライブラリの更新をチェックし、必要なPRを作成する」といった定型作業を、人間の介入なしに自動化できるようになります。これにより、開発チームは定型作業から解放され、設計やアーキテクチャの検討など、より付加価値の高い作業に集中しやすくなります。

Slack連携

Slack連携では、チャンネルやスレッド上で @codex にメンションするだけでタスクを依頼できます。

- 会話履歴からコンテキストを自動抽出

- 適切なCodex Cloud環境を選択

- タスク完了後、結果やPRへのリンクをスレッドに返信

エンジニアだけでなく、プロダクトマネージャーやカスタマーサポートなど、非エンジニアも自然言語でタスクを投げられる点が特徴です。

Codex SDK

Codex SDKは、Codex CLIと同じエージェント実装をTypeScriptライブラリとして組み込めるSDKです。

主な用途は次の通りです。

- CI/CDパイプラインの一部としてCodexを呼び出す

- 社内ツールやダッシュボードから「ボタンひとつでコード修正」を実行

- 独自のUIを持つコードレビュー支援ツールの構築

管理ツール(Analytics / Usage Dashboard)

企業向けには、Codexの利用状況やコードレビュー品質を可視化するUsage Dashboard / Analyticsが提供されています。

- プランごとのレート制限の使用状況

- CLI / IDE / Web / Cloud別の利用状況

- クレジットの消費状況(Plus / Pro / Business / Enterprise)

管理者は、これらの情報をもとにチーム全体の活用状況を把握し、必要に応じてクレジットの追加やポリシー調整ができます。

Web検索機能(2025年8月27日)

Codex CLI / Cloudには、必要に応じてWeb検索ツールを呼び出す機能が組み込まれています。

設定ファイルでWeb検索を有効化すると、次のようなプロンプトに対して自動的にWeb検索が走ります。

- 「このライブラリの最新のセキュリティ情報を確認して」

- 「バージョンXからYへの移行ガイドを探して」

代表的な活用例は次の通りです。

- 最新APIドキュメントやBreaking Changesを確認しながらのコード生成

- 既知の脆弱性(CVE)の有無を確認しながら依存ライブラリを更新

- 新技術(例:新しいフロントエンドフレームワーク)の採用検討

メッセージキューイング機能

Codexには、長時間タスク実行中に新しいタスクをキューに積む機能が用意されています。

- 1つ目のタスク(大規模リファクタリング)を実行中に、

→ 別の小さな修正を「あとで実行するタスク」として登録 - CLIのTUI上で、キューの状況や実行中タスクの進捗を一覧表示

これにより、「今走っている処理が終わるまで待ってから次の依頼をする」といった無駄な待ち時間を減らせます。

ChatGPT iOSアプリでの利用(2025年5月〜)

Codexは、ChatGPT iOSアプリにも統合されており、モバイルデバイスからもCodexタスクを実行できます。

iPhone / iPadからできることの例は次の通りです。

- 移動中にPRの差分を確認し、軽微な修正を依頼

- スクリーンショットを添付し、「この画面のバグを修正するパッチを書いて」と依頼

- アプリ内の画面から長時間タスクの進捗を確認

デスクトップのCodexとセッションが同期されるため、「外出先で状況確認 → 帰社後にIDEやmacOSアプリで続きを確認・修正」といったフローが取りやすくなっています。

Codexの料金と利用上限について

Codexは、ChatGPTの有料プラン(Plus / Pro / Business / Edu / Enterprise)で標準機能として利用可能です。

これらのプランには「Codexを一定量まで使える利用枠」が含まれており、CLI / IDE / Web / Cloud / macOSアプリ のすべてで共有されます。

2026年2月時点の、各プランの月額料金と利用枠の目安は以下の通りです。

| プラン | 月額料金 | ローカルメッセージ / 5時間 | Cloudタスク / 5時間 | Code Review / 週 |

|---|---|---|---|---|

| ChatGPT Plus | $20/月 | 45〜225 | 10〜60 | 10〜25 |

| ChatGPT Pro | $200/月 | 300〜1,500 | 50〜400 | 100〜250 |

| Business | $30/ユーザー/月 | 45〜225(大容量VM) | 10〜60(大容量VM) | 10〜25 |

| Enterprise / Edu | 要問い合わせ | 固定上限なし(creditsでスケール) | 固定上限なし | 固定上限なし |

なお、2026年2月のmacOSアプリリリースに伴い、期間限定でChatGPT FreeおよびGoユーザーにもCodexが提供されています。

利用枠はモデルやタスクの複雑さに応じて消費量が変わります。以下は、1メッセージ/1タスクあたりのクレジット消費の目安です。

| モデル | ローカルタスク(平均) | Cloudタスク(平均) |

|---|---|---|

| GPT-5.3-Codex | 約5クレジット | 約25クレジット |

| GPT-5.1-Codex-Mini | 約1クレジット | ローカルのみ対応 |

GPT-5.1-Codex-Miniは、軽量タスク向けの低コストモデルです。シンプルな補完やテンプレート生成にはこちらを選択することで、クレジット消費を抑えられます。

利用制限に達した場合の対処法:クレジットの追加購入

Plus / Pro などの個人プランでは、利用制限に達した場合に追加のクレジットを購入してCodexやSoraの利用を継続できます。

- 利用上限に達すると、「Add credits」ボタンやバナーが表示

- 設定画面の利用量Dashboardからクレジット購入が可能

- まずはプランに含まれる標準枠が消費され、その後クレジットが消費される

ビジネス / Enterprise向けには、柔軟なクレジットプールやワークスペース単位の利用メトリクスが用意されており、Usage Dashboardから確認できます。

APIキーを使った従量課金での利用

Codexは、ChatGPTプランとは別に、APIキーを使った従量課金でも利用可能です。2026年2月時点の参考単価を以下に整理します。

以下の表は、API経由で利用する場合の主要モデルごとのトークン単価です。開発規模やタスク内容に応じた最適なモデル選定の参考にしてください。

| モデル | 入力トークン(100万あたり) | 出力トークン(100万あたり) | 備考 |

|---|---|---|---|

| GPT-5-Codex | GPT-5と同一単価 | GPT-5と同一単価 | Responses APIから利用可能 |

| GPT-5.2-Codex | $1.75 | $14.00 | 2026年2月時点の参考単価 |

| GPT-5.3-Codex | API提供準備中 | API提供準備中 | 今後数週間以内にAPI提供開始予定 |

ここで注目すべきは、GPT-5.2-Codexの入力トークン単価が$1.75と、大規模なコードベースを扱うエージェント用途に見合った価格設定になっている点です。100万トークンあたりの入力コストが抑えられているため、リポジトリ全体のスキャンや長時間タスクでのコスト効率が高くなっています。

「ChatGPTプランの枠を温存したい」「Codexだけ大量に使いたい」といった場合は、APIによる分離利用も検討できます。

Codexのセキュリティについて

最後に、「自律的なAIにコードベースを触らせても安全か?」という観点で、Codexのセキュリティ設計を整理します。

ネットワークから隔離されたサンドボックス環境

Codex Cloudは、デフォルトでネットワークアクセスが無効化されたサンドボックス環境で実行されます。

- ファイルアクセスはワークスペース内に限定

- ネットワークアクセスは明示的に有効化しない限り無効

- プロジェクトごとにコンテナが分離される

「誤って外部サービスに機密情報を送信してしまう」といったリスクを低減する設計になっています。

開発者が制御できる3段階の承認モード

Codex CLI / IDE拡張には、権限レベルを制御する承認モードが用意されています。

-

read-only コードの読み取りと提案のみ

-

auto ワークスペース内でのファイル編集・テスト実行は自動、外部コマンドは承認が必要

-

full access ネットワークアクセスを含むすべての操作を許可(高リスクなため要注意)

これにより、「まずはread-onlyで様子を見る → 慣れてきたらautoをデフォルトにする」といった段階的な運用が可能です。

GPT-5.3-Codexの「High Capability」認定と追加セーフガード

GPT-5.3-Codexは、OpenAIのPreparedness Frameworkにおいて、サイバーセキュリティ領域で初めて「High Capability」に到達したモデルです。これは、合理的に防御されたターゲットに対するサイバーオペレーションの自動化や、運用上重要な脆弱性の発見・悪用を自動化できる能力が認められたことを意味します。

この認定に伴い、OpenAIは多層的なセーフガードを導入しています。以下にその主要な要素を整理します。

-

安全性トレーニング 資格情報の窃取など明らかに悪意のあるリクエストを拒否するよう、モデル自体にトレーニングが施されている

-

自動分類器による監視 不審なサイバー活動の兆候を検出する自動分類器ベースのモニターが稼働しており、高リスクなトラフィックはサイバー能力がより低いGPT-5.2にルーティングされる

-

Trusted Access for Cyber セキュリティリサーチャーや、リクエストが誤分類されたと考える開発者は、OpenAIのTrusted Access for Cyberプログラムを通じてフルアクセスを申請できる。高度なサイバーセキュリティのユースケースは、審査済みの信頼アクセスワークフローを経由する仕組み

-

Lockdown Mode 高セキュリティ要件のユーザー向けに、Codex内でリスクの高い機能にラベルを表示し、操作の可否を制御するLockdown Modeが用意されている

ここで注目すべきは、「攻撃能力を持つモデルを、防御側が最大限活用できるようにする」というOpenAIのアプローチです。サイバーセキュリティ能力を一律に封じるのではなく、Trusted Access for Cyberのような審査付きアクセスを通じて、防御側のセキュリティリサーチャーには能力を開放しつつ、悪意ある利用は多層的に抑止するという設計になっています。

OpenAIが推奨する安全な運用方法

OpenAIは、Codexを「人間のレビューを置き換えるものではなく、追加のレビュアー」として位置づけることを推奨しています。

- Codexの提案はすべてPRやdiffとして人間がレビュー

- 本番反映前には、既存のレビュー・テストプロセスを必ず通す

- サイバーセキュリティ関連のタスクでは、とくに人間のチェックを厳格にする

GPT-5.3-Codexは「High Capability」認定を受けた初のモデルであり、その能力の高さゆえに、従来以上に人間による監督と段階的なデプロイが重視されています。

Codex導入パターンとおすすめの始め方

実際にチームでCodexを導入する際の「踏み方」を、小さなPoC → チーム展開 → 組織標準化 という流れで整理します。

いきなり全プロジェクトに入れるのではなく、リスクの低い範囲から段階的にスコープを広げていくイメージです。

ステップ1:個人レベルでCLI / IDE拡張を試す(小さなPoC)

最初の目的は、「Codexで何がどこまでできるか」をチームの誰かが体感することです。いきなり全員で使う必要はありません。

まずは少人数(あるいは1人)で次のツールを試し、「どの程度まで任せられそうか」「どんなタスクと相性が良いか」を感覚的につかみます。

- Codex CLI

- Codex IDE拡張(VS Code / Cursor)

この段階では、次のようなタスクから始めるのがおすすめです。

- 既存コードの軽微なリファクタリング(変数名の整理、コメント追加など)

- 小さめのバグ修正やユニットテストの追加

- ログ整備や型注釈の追加など、仕様リスクが小さい改善

あわせて、

- 「Codexに任せて楽になった作業」

- 「まだ任せづらい/注意が必要だと感じた作業」

を簡単にメモしておくと、後のステップで運用ルールを決める材料になります。

ステップ2:小さなリポジトリでAGENTS.mdを整備する(ルールの言語化)

次の目的は、「プロジェクト単位でCodexに守ってほしいルールを言語化し、AGENTS.mdに落とし込む」ことです。

小さめのリポジトリを1つ選び、次のような内容を中心に整備していきます。

-

AGENTS.md にテストコマンドやコーディング規約、ビルド手順を明文化

例:npm test / pytest / go test ./... など

禁止事項(直接さわってほしくないディレクトリなど)があれば明記

-

Codexの承認モードは read-only / auto を中心に使い、危険な操作が入りづらい設定で試す

このフェーズでのゴールは、

- AGENTS.mdをきちんと書くと、Codexの振る舞いがどれだけ安定するか

- 「どこまで書けば十分か」というテンプレートのたたき台

を掴むことです。ここで作ったAGENTS.mdテンプレを、後で他プロジェクトにも横展開できます。

ステップ3:Slack連携やCodex Cloudで長時間タスクを試す(チーム活用)

一定の成功体験が得られたら、「個人のPoC」から「チームのワークフロー」へスコープを広げていきます。

具体的には、次のような使い方を試していくイメージです。

-

Slack連携で、非エンジニアからのタスク依頼を試す

例:CSやPMが「このバグ報告に対応する修正PRを作って」と @codex に依頼

-

Codex Cloudで、数時間〜1日規模のリファクタリングや大規模テスト追加を試す

例:古い機能群のテスト追加、パッケージ構成の整理、Deprecated APIの一括置き換え

PoCの対象として選ぶリポジトリは、次のような条件を満たしていると扱いやすくなります。

- クリティカルではないが、技術的負債が溜まりがちな領域である

- テストがそこそこ整っており、Codexの変更をテストで検証しやすい

チームとしては、

- 「Codexに丸投げするタスク」

- 「Codexにたたき台を作らせ、人間が仕上げるタスク」

の境界を徐々に見極めていくフェーズになります。

ステップ4:チーム全体の運用ルール・ガバナンスを決める(本格展開)

最後に、「人によって運用がバラバラにならないようにする」ためのルールづくりに入ります。

ここで急に高度なことをやる必要はなく、ステップ1〜3で得られた知見を整理していくイメージです。

たとえば、次のような観点でルールを定めていきます。

-

どの承認モードをデフォルトにするか

例:基本は auto だが、本番系リポジトリは read-only から始める など

-

どの種類のタスクまでは自動マージを許可するか

例:コメント追加・ログ整備・テスト追加は条件付きで自動マージ可、それ以外は必ず人間レビュー

-

セキュリティ・コンプライアンス上の禁止事項

例:特定ディレクトリ配下の変更禁止、外部ネットワークアクセスの可否 など

-

「Codexがやった変更」を可視化・モニタリングする方法

例:Codex由来のPRにはラベルを付ける、ダッシュボードでPR数・マージ率を追う

必要に応じて、Business / EnterpriseプランでクレジットプールやRBAC(ロール別アクセス制御)を設定し、

- どのチームにどれくらいの利用枠を割り当てるか

- どのロール(開発 / QA / SRE / CSなど)がどの機能にアクセスできるか

といった組織レベルのコントロールも整えていきます。

規模別のざっくり指針

最後に、チーム規模別にざっくりまとめると次のようなイメージです。

-

個人〜数名チーム

→ ステップ1〜2を重点的に。CLI / IDE + AGENTS.md で「まずは自分たちの開発がどれだけ楽になるか」を確認。

-

10〜30人規模の開発チーム

→ ステップ3まで進めて、Slack連携やCloudタスクまで含めたチーム全体のワークフローを一度設計してみる。

-

100人規模以上の組織

→ ステップ4まで含めて、RBAC・クレジットプール・推奨AGENTS.mdテンプレ・教育コンテンツなどを整え、

「Codexを使うときのデファクト・スタンダード」をドキュメント化しておく。

この流れで進めると、「とりあえず入れてみたけどカオスになった」状態を避けつつ、段階的にCodexの恩恵を引き出しやすくなります。

Codexの活用事例

最後に、実際にCodexを活用している企業・組織の事例を紹介します。自社でのユースケースを考える際の参考になります。

事例紹介イメージ(参考:OpenAI公式ブログ)

OpenAI社内での活用

OpenAI自身も、社内のほぼすべてのエンジニアがCodexを利用しており、次のような用途に使われています。

- 繰り返しタスク(テスト作成・ログ整備・変数名変更)の自動化

- インシデント対応時のオンコール支援(ログ解析・暫定対処コードの提案)

- 朝一のタスク整理(コードベースの状態を踏まえたToDoリストの生成)

社内評価では、Codex導入後に週あたりのPRマージ数が増加していることが報告されており、エンジニアの時間を「より付加価値の高い設計や難しい実装」に振り向けやすくなっています。

Cisco:コードレビュー時間の短縮

ネットワーク機器大手のCiscoは、Codexをコードレビューの補助として活用し、複雑なPRに対するレビュー時間を最大約50%短縮したと報告しています。

- Codexが一次レビューを行い、潜在的な問題点を洗い出す

- 人間のレビュアーは、重要な指摘や設計上の論点に集中

これにより、「チェックリスト的な確認」にかかる時間を削減しつつ、品質基準は維持しやすくなっています。

Instacart:技術的負債の削減

オンラインスーパーのInstacartは、Codex SDKを自社のバックグラウンドエージェント基盤に統合し、次のような用途に活用しています。

- 使用されていないコードや実験用フラグの自動クリーンアップ

- 古いABテストの削除や設定の整理

- これらの変更をまとめたPRの自動生成

結果として、コードベース全体の複雑さやレイテンシの低減に貢献し、エンジニアが新機能開発に集中しやすい環境を整えています。

FAQ:Codexについてよくある質問

最後に、これからCodex導入を検討しているチームからよく聞かれる質問をまとめます。

Q1. GitHub CopilotとCodexはどう違いますか?

A. GitHub Copilotはエディタ内のコード補完やチャットに特化したツールで、Codexはターミナル・IDE・Cloud・GitHub・モバイル・macOSアプリをつなぐ「エージェント基盤」という位置づけです。

- 「手元の実装を少し楽にしたい」 Copilot単体でも十分

- 「テスト実行やPR作成、大規模リファクタリングまで任せたい」 Codexの守備範囲

と考えると整理しやすいです。

Q2. まずはどのモデルから試すべきですか?

A. 一般的には次の順番がおすすめです。

- 日常的なタスク → GPT-5.3-Codex (2026年2月時点の最新モデル)

- リアルタイム応答が必要なタスク → GPT-5.3-Codex-Spark (リサーチプレビュー、Proユーザー限定)

- 大規模リファクタリング・長時間タスク → GPT-5.3-Codex のhigh / xhigh設定

まずはデフォルト設定で使い始め、「もう少し踏み込んだ提案が欲しい」と感じるタスクだけ思考レベルを上げると、コストと品質のバランスを取りやすくなります。

Q3. Codexを導入するときの最初の一歩は?

A. 本文の「Codex導入パターンとおすすめの始め方」で詳しく解説していますが、要約すると次の4ステップです。

- 個人レベルで Codex CLI / IDE拡張 を試す

- 小さなリポジトリでAGENTS.mdを整備し、安全範囲で自動修正を試す

- Slack連携やCodex Cloudで長時間タスクを試す

- チーム全体の運用ルール(承認モード・レビュー方針など)を決める

Q4. Codexを使う際に注意すべきことは?

A. 主に次の3点を意識しておくと、トラブルを減らしやすくなります。

- 出力の正確性を過信しない Codexの提案はあくまで「たたき台」であり、人間によるレビューが必須です。とくにセキュリティ関連の変更や本番環境への反映時には、既存のレビュー・テストプロセスを必ず通してください

- クレジット消費に注意する Cloudタスクは1回あたり約25クレジットを消費するため、大量の並行タスクを無計画に走らせるとプラン上限に早く到達します。ダッシュボードで利用量を定期的に確認しましょう

- 機密情報の取り扱い 承認モードをread-onlyから始めるなど、段階的にアクセス権を広げていく運用が推奨されています。環境変数やシークレットの扱いには特に注意が必要です

AI導入でお悩みの方へ

まとめ:Codexは「コード補完ツール」から「AIチームメイト」へ

本記事では、OpenAIのAIコーディングエージェント「Codex」について、最新モデルと機能、料金体系、実務での活用事例までを整理しました。

- 2026年2月登場のGPT-5.3-Codexは、自身の開発プロセスにも貢献した初の「自己開発型AI」であり、GPT-5.2-Codexより約25%高速

- macOSデスクトップアプリにより、複数エージェントの並行実行・Git Worktree・Skills & Automationsに対応し、CLI / IDE拡張 / Cloud / Slack / GitHub / iOS / macOSアプリをまたいだ一貫したエージェント体験が提供されている

- ChatGPTの有料プランに一定の利用枠として含まれ、不足分は「クレジット」追加で柔軟に補える

- 企業事例では、コードレビュー時間の短縮や技術的負債の削減など、開発プロセス全体への波及効果が報告されている

Codexは、単なる「コード補完ツール」を超えて、開発チームの一員としてタスクを引き受けるAIチームメイトへと進化しつつあります。

自社での導入を検討する際は、本記事で紹介したモデルの選び方・ツールの使い分け・料金・セキュリティの観点を踏まえ、小さなプロジェクトからの試験導入 → チーム全体への展開というステップで進めるとスムーズです。