この記事のポイント

Microsoft Foundry Agent Serviceは最新AIモデル(GPT-5、o3、Claude等)やSDKを利用し柔軟なAIエージェント開発が可能なサービス

Bing、SharePoint、Fabricなど多様なデータソースとの連携、Deep ResearchやBrowser Automation等の先進ツール

Logic Apps、Azure Functionsなど外部サービス連携による自動化、1,400以上のコネクタ対応

エンタープライズレベルのセキュリティ機能とデータプライバシー保護、Azure Monitor統合

マルチエージェントシステム構築を支援し、複雑な業務効率化を実現

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

近年、AI技術の進化は目覚ましく、ビジネスのあらゆる場面でその活用が進んでいます。

その中でも「AIエージェント」は、複雑で時間のかかる業務プロセスを自動化する強力なツールとして注目を集めています。

AIエージェントを導入することで、企業は24時間365日稼働するデジタルワークフォースを獲得し、人的リソースをより創造的な業務に集中させることが可能になります。

本記事では、Microsoft が提供する「Microsoft Foundry Agent Service(旧Azure AI Foundry Agent Service)」について、その概要から使い方、利用可能なツールやモデル、料金体系、責任あるAIへの取り組み、そして使い方までを包括的に解説します。

これからのビジネスの変革をAIとともに歩むための一歩を、Microsoft Foundry Agent Serviceとともに踏み出しましょう。

目次

Microsoft Foundry Agent Service(旧Azure AI Foundry Agent Service)とは

Microsoft Foundry Agent ServiceとAssistants APIの違い

Microsoft Foundry Agent Serviceの主要機能

Microsoft Foundry Agent Serviceの先進的なツール群(2025-2026最新)

Hosted Agents:サーバーレスなエージェント実行基盤

Anthropic Claude対応:OpenAI以外の選択肢

Microsoft Foundry Agent Serviceで利用可能なモデルとリージョン(2026年最新)

ステップ1: Azure AI Foundryプロジェクトのセットアップ

マルチエージェントシステムの作成(Connected Agents)

Microsoft Foundry Agent Serviceが向いている場面 vs 向かない場面

Microsoft Foundry Agent Service(旧Azure AI Foundry Agent Service)とは

Microsoft Foundry Agent Service は、最新のAIモデルを活用し、高品質かつセキュアなAIエージェントを簡単に開発・運用できるフルマネージドサービスです。2024年11月にパブリックプレビュー、2025年5月に一般提供開始(GA)、そして2026年1月1日から「Microsoft Foundry」の一部として正式にブランド刷新されました。

Bing、SharePoint、Azure AI Search、Microsoft Fabricなどの多様なデータソースや、Logic Apps、Azure Functionsなどの外部サービスとシームレスに連携可能です。

また、エンタープライズレベルのセキュリティ機能も備えており、組織のデータプライバシーとコンプライアンス要件を満たしながら、様々なビジネスプロセスの自動化を実現するサービスです。

💡AIエージェントの定義

Microsoft Foundry Agent ServiceにおけるAIエージェントは、質問への回答(RAG)、アクションの実行、ワークフローの完全な自動化に使用できる「スマートなマイクロサービス」として機能します。

従来のルールベースのシステムとは異なり、生成AIモデルとツールを組み合わせることで、人間のように柔軟な思考と行動を実現しています。

AIエージェントが得意とするのは、例えば以下のような、従来のシステムでは対応が難しい、複雑で曖昧さを含むタスクです。

-

状況に応じた柔軟な対応が求められる顧客折衝

マニュアル化されたFAQ対応ではなく、顧客の状況、感情、文脈を深く理解し、複数の情報源(製品知識、顧客情報、過去の履歴など)を動的に組み合わせて、最適な解決策を提示します。

さらに、必要に応じて外部サービスと連携し、問題解決のために具体的なアクションを実行します。

例えば、複雑なクレーム対応において、顧客の状況を理解した上で、返金処理、代替品の提案、ポイント付与などを、外部システムと連携しながら自律的に行うことが想定されます。

-

パーソナライズされた提案

顧客の過去の行動や好みを深く理解し、一人ひとりに最適化された提案を行います。

例えば、単におすすめ商品を提示するだけでなく、「以前購入された〇〇と合わせて使うと効果的な△△はいかがですか?」といった、より踏み込んだ提案が可能です。

-

先回りしたタスク実行

ユーザーが指示する前に、状況を判断して自律的にタスクを実行します。例えば、会議の予定が近づくと、関連資料を事前に用意したり、参加者へのリマインドを送信したりすることが可能です。

これらは、単なる自動化を超えた、AIエージェントならではの強みです。

外部APIやサービスと連携することで、幅広いアクションを実行できるのも大きな特徴です。

【名称変更の歴史】製品名の変遷と2026年最新情報

Microsoft Foundry Agent Serviceは、その進化とともに名称を変更してきました。以下に名称変更の歴史をまとめます。

名称変更のタイムライン

2024年11月: Azure AI Foundry Agent Service(パブリックプレビュー開始)

2025年5月: Azure AI Foundry Agent Service(一般提供開始・GA)

- 名称変更自体はブランド刷新が主目的でしたが、以下の機能強化も同時にリリースされました。

2025年11月: Azure AI Foundry → Microsoft Foundry へ(Microsoft Ignite 2025発表)

2026年1月1日: Microsoft Foundry Agent Service に正式名称変更

- Microsoft Product Termsにて正式に改名

- 「Azure」の名前を外し、Microsoftエコシystem全体への統合を強調

この名称変更は単なるリブランディングではなく、AIエージェントがAzureサービスの一つではなく、Microsoft全体のファーストクラス製品として位置づけられたことを意味します。つまり、エージェントは今や、Microsoft 365、GitHub、Dynamics 365など、あらゆるMicrosoft製品と深く統合される戦略的な存在となったのです。

2025年5月GA時の主な強化ポイント

名称変更と同時に、以下の機能が大幅に拡充されました。

-

マルチエージェント・オーケストレーションの強化:

- Connected Agents: エージェント間でのツール呼び出しやデータ受け渡しを可能にし、協調動作を実現します。

- Multi-Agent Workflows: 長時間実行やエラーからの復旧を含む、より複雑なワークフローの構築をサポートします。

- Agent Catalog: 事前に構築されたエージェントやテンプレートを利用可能にし、開発を迅速化します。

-

Logic Apps/外部システム連携の大幅な拡充:

- 1,400以上のLogic Appsコネクタ: これらに直接アクセス可能となり、多様な外部サービスとの連携が容易になります。

- Azure Logic Appsからのエージェントトリガー: Logic Appsのワークフローから直接Microsoft Foundry Agent Serviceのエージェントを起動できるようになりました。

- Agent-to-Agent プロトコル: マルチクラウド環境でのエージェント間連携を促進します。

-

開発者体験の向上とランタイム統合:

- Semantic Kernel/AutoGen ランタイム統合: ローカル開発からシミュレーション、クラウド展開までの一貫したパイプラインを提供し、単一APIでコードベースの動的オーケストレーションを実行可能です。

- Foundry Visual Studio Code拡張機能: ローカル環境での開発、デバッグ、テストを効率化します。

- Trace Agents: エージェントの実行フローを詳細に追跡し、デバッグやパフォーマンス分析を支援します。

-

エンタープライズ向けの信頼性・セキュリティ強化:

- SLAサポートとコンプライアンス対応: 正式なSLAが提供され、各種コンプライアンス要件に対応します。

- ガバナンス機能とコンテンツ・セーフティ: 標準で搭載され、安全な運用を支援します。

- Azure Monitorとの統合強化: エージェントの監視、ログ収集、アラート設定などがAzure Monitorを通じて行えるようになり、運用管理が向上します。

-

新しい組み込みツールの追加:

- Bing Custom Search ツール: カスタマイズされたWeb検索結果をエージェントが利用できます。

- Morningstar ツール: 金融関連データへのアクセスを提供します。

- Microsoft Fabric ツール: Microsoft Fabric内のデータとの対話型アクセスを強化します。

Microsoft Foundry Agent ServiceとAssistants APIの違い

「Microsoft Foundry Agent Service」と「Azure OpenAI Assistants API」は、どちらもAIエージェントの構築を支援するサービスですが、いくつかの重要な違いがあります。

以下の表で、両サービスの主な違いを整理しました。この表を確認することで、どちらのサービスが自社のニーズに適しているかを判断できます。

| 機能 | Microsoft Foundry Agent Service | Azure OpenAI Assistants API |

|---|---|---|

| モデルの選択 | Azure OpenAIモデルに加え、Microsoft Foundryモデルカタログ経由でGPT-5シリーズ、o3シリーズ、Llama 3.3、Mistral、Cohere、Anthropic Claude、DeepSeek等の多様なモデルも選択可能。ツール呼び出しをサポートするモデルが推奨されます。 | 主にAzure OpenAIモデル |

| データ統合 | Bing (Bing Custom Search tool含む)、SharePoint、Microsoft Fabric、Azure AI Searchなど、広範なデータソースと統合。Agent Catalog等を通じた事前連携パターンも提供。 | 限定的 |

| セキュリティ | エンタープライズグレードのセキュリティ機能(安全なデータ処理、キーレス認証、パブリックエグレスなし、Azure Monitor連携による監視強化、SLAサポート)。 | 基本的なセキュリティ機能 |

| マルチエージェント | Connected Agents、Multi-Agent Workflowsによるネイティブサポート、Agent2Agent (A2A) プロトコル対応。AutoGen、Semantic Kernelとのランタイム統合。 | 限定的(主にライブラリレベルでの個別実装が必要) |

| 開発者ツール | Foundry Visual Studio Code拡張機能、Trace Agents、Java SDK、Foundry Portal等の専用ツールを提供。 | Azure SDKが中心 |

| ストレージ | 独自のAzure Blobストレージ、Azure Cosmos DB for NoSQLを使用可能、またはプラットフォーム管理ストレージを使用 | プラットフォーム管理ストレージのみ |

| 自動ツール呼び出し | サーバー側で自動的に処理 | クライアント側で処理が必要 |

| データ管理 | スレッドに情報を保存し、自動管理 | 開発者が会話の状態を管理 |

| すぐに使用できるツール | 豊富(Bing、Azure AI Search、Azure Functions、Deep Research、Browser Automation、MCPなど) | 限定的 |

| イベント駆動実行 | 対応(新着メール、顧客チケット受信時などに自動起動) | 非対応 |

| Hosted Agents機能 | 対応(サーバーレスコンテナ、自動スケーリング) | 非対応 |

| Anthropic Claude対応 | 対応(Claude Opus 4.5/Sonnet 4.5/Haiku 4.5/Opus 4.1) | 非対応 |

ここで注目すべきは、Microsoft Foundry Agent Serviceは単なるエージェント構築ツールではなく、エンタープライズ全体のワークフローを統合するプラットフォームという点です。つまり、Assistants APIがAIモデルとの対話に特化しているのに対し、Microsoft Foundry Agent Serviceは、マルチエージェント協調、外部システム連携、イベント駆動実行、そしてエンタープライズセキュリティまで包括的にカバーしています。

そのため、プロトタイプや小規模な実験ではAssistants APIで十分ですが、本格的なエンタープライズ展開、複数部門をまたぐ業務自動化、コンプライアンス要件が厳しい環境では、Microsoft Foundry Agent Serviceが最適な選択肢と言えるでしょう。

【関連記事】

Azure AI services(旧Azure Cognitive Services)とは?その概要や料金を徹底解説

Microsoft Foundry Agent Serviceの主要機能

Microsoft Foundry Agent Serviceは、迅速なエージェント開発、広範なデータ統合、柔軟なモデル選択、そしてエンタープライズ対応機能を実現し、他のサービスとは一線を画しています。

以下では、これらの特徴について詳しく説明します。

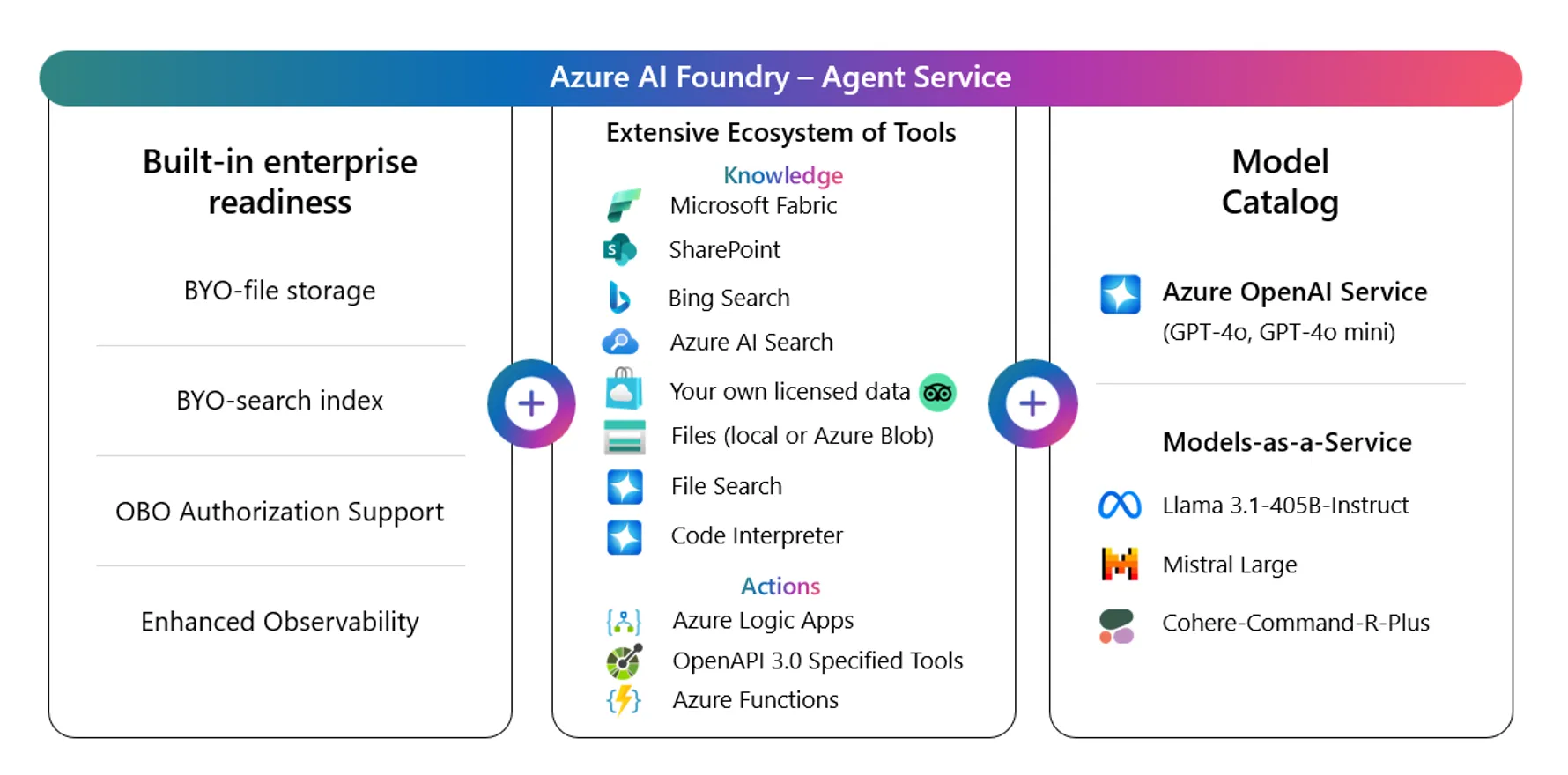

Microsoft Foundry Agent Serviceの構成要素 (参考:Microsoft)

1. 迅速なエージェント開発と強力なAPI統合

Microsoft Foundry Agent Serviceは、OpenAIの「Assistants API」を基盤としつつ、Microsoft Foundry SDKやVS Code拡張機能などを通じて、より高度で効率的な開発環境を提供します。

さらに、Microsoft Foundry SDKを利用することで、開発者はPython, .NET, Java など、使い慣れた言語でAIエージェントを開発できます。

このSDKは、Microsoft Foundry Agent Serviceの機能を最大限に活用するための各種ツールやライブラリを提供し、より高度なカスタマイズや、他のAzureサービスとの連携を可能にします。

具体的には、以下のような強力な統合機能が利用できます。

Logic Appsコネクタ

1,400以上のAzure Logic Appsコネクタを利用することで、様々な外部サービスと連携したタスクを自動化できます。Azure Logic Appsからエージェントを直接トリガーすることも可能です。

例えば、以下のようなサービスとの連携が可能です。

-

Microsoft製品

Azure App Service、Dynamics 365 Customer Voice、Microsoft Teams、M365 Excel など

-

主要なエンタープライズサービス

MongoDB、Dropbox、Jira、Gmail、Twilio、SAP、Stripe、ServiceNow など

これらのコネクタを使うことで、様々な業務プロセスをエージェントに自動で実行させることが可能です。

- 顧客情報をデータベースから取得する

- メールを自動送信する

- 承認ワークフローを開始する

この統合により、例えば、カスタマーサポート部門では月間約5,000件の問い合わせのうち70%を自動処理することが可能になります。従来は10名のオペレーターが必要だった業務を3名で対応できるようになり、月間約200万円、年間で約2,400万円の人件費削減が実現できます。

【関連記事】

Azure Logic Appsとは?主要機能や料金、設定手順をわかりやすく解説

Azure Functions

Azure FunctionsやAzure Durable Actionsと連携することで、外部システムとのやり取りを効率化できます。

APIの呼び出しや、非同期イベントの送受信を簡単に実装でき、以下のような処理を自動化できます。

- 請求書の自動承認処理

- 製品サプライチェーンのリアルタイム監視

- 顧客からの問い合わせに応じた動的な処理

【関連記事】

Azure Functionsとは?その機能や使い方、料金体系を徹底解説!

Code Interpreter

安全な実行環境でPythonコードを記述・実行できるため、複雑なデータ処理や分析、グラフや図を用いたデータ可視化をエージェントに任せることができます。

- エージェントにデータ分析や数値計算をさせ、その結果をレポートにまとめる。

- 機械学習モデルを使って、データを分析する。

- 可視化ツールを利用し、分析結果をグラフで表示する。

OpenAPI仕様

OpenAPI 3.0仕様に対応したツールを利用して、外部APIと連携できます。

これにより、様々なアプリケーションと連携して、AIエージェントの活用範囲を大きく広げることができます。

- 天気予報APIを利用して、天気情報を取得する

- 翻訳APIを利用して、多言語対応のチャットボットを作る

- 地図APIを利用して、周辺の店舗情報を検索する

これらの強力な統合機能により、開発者はAIエージェントを迅速に開発し、様々なシステムやサービスと連携させ、ビジネスニーズに合わせた高度な自動化を実現できます。

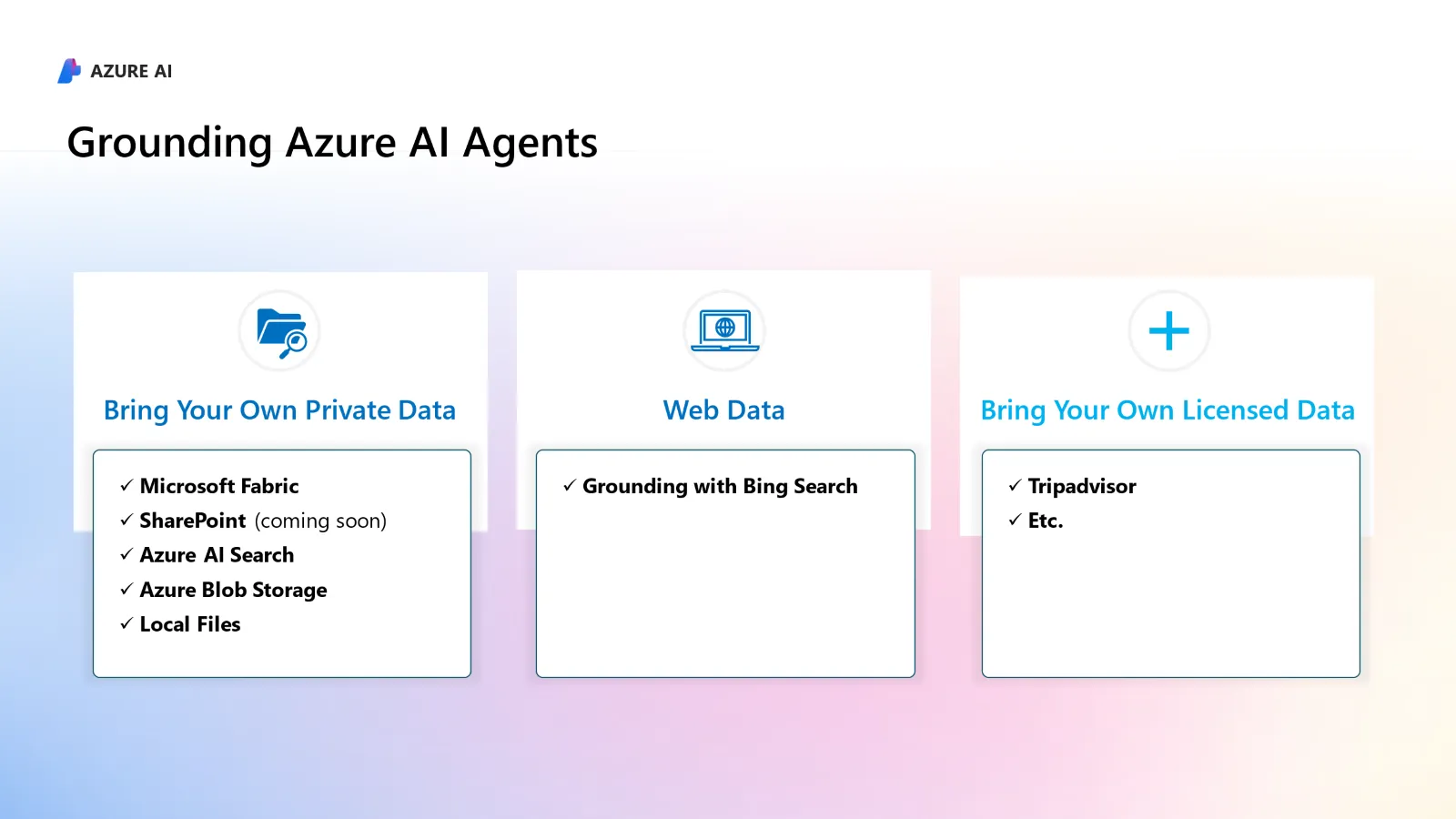

2. ナレッジソースとの連携

Microsoft Foundry Agent Serviceで構築されたエージェントは、以下に示す様々なデータソースに安全にアクセスし、関連性の高いエンタープライズナレッジを最大限に活用できます。

対応データソース (参考:Microsoft

- リアルタイムWebデータ (Bing / Bing Custom Search tool)

エージェントはBing検索およびBing Custom Search toolを利用して、インターネット上の最新情報やカスタマイズされた検索結果を取得し、それを基に応答を生成できます。

- 組織データ (SharePoint)

組織内のSharePointに保存されたドキュメントやデータをエージェントが安全に利用できます。

社内のみに公開された情報に基づいた、より専門的な応答やタスクの実行が可能です。

- 構造化データ (Microsoft Fabric) Microsoft Fabric内の構造化データ(データベースなど)に、Microsoft Fabric ツールを通じてSQLなどのクエリ言語の知識がなくても簡単にアクセスし、対話形式でデータに関する質問応答や分析が可能です。

- その他のデータソース

Azure AI Search、Azure Blob Storage、ローカルファイルなど、様々なデータソースと連携できます。

- ライセンスデータ

Tripadvisorなどのデータプロバイダーから提供されるライセンスデータを利用することで、エージェントの応答をさらに高品質なものにすることができます。

例えば、顧客からの問い合わせ対応を行うエージェントであれば、社内の製品データベースやFAQ、過去の顧客対応履歴などを参照して、より正確で適切な回答を提供できます。

また、市場調査を行うエージェントであれば、Bing Searchを通じてウェブ上の最新情報を収集し、分析レポートを作成することも可能です。

これらの機能により、エージェントは常に最新の情報と社内の知識を組み合わせ、より質の高い業務遂行をサポートします。特に、社内ドキュメント検索の効率化では、従来社員が1日平均30分かけていた情報検索時間が5分に短縮され、100名規模の企業で年間約1,250時間の工数削減、人件費換算で約500万円の削減効果が得られます。

3. 柔軟なモデル選択

Microsoft Foundry Agent Serviceでは、タスクや要件に応じて最適なモデル選択が可能です。

具体的には、以下のような選択肢があります。

-

Azure OpenAIのモデル

GPT-5シリーズ、GPT-4.1シリーズ、GPT-4oをはじめとする、OpenAIが提供する強力なモデル群です。 -

推論特化モデル

o3-deep-research、o3-mini、o4-miniなど、高度な推論能力を持つ特化型モデルも利用可能です。 -

オープンソースモデル

「Llama 3.3」「Mistral」「Cohere」「DeepSeek-V3」「DeepSeek-R1」など、オープンソースコミュニティで開発されている高性能なモデルも利用可能です。 -

Anthropic Claude

Claude Opus 4.5、Claude Sonnet 4.5、Claude Haiku 4.5、Claude Opus 4.1など、Anthropic社の最先端モデルも選択できます。

この幅広い選択肢により、「特定のタスクや業界に特化したモデル」や、「コスト効率に優れたモデル」など、ビジネスニーズに最適なモデルを選ぶことができます。

例えば、特定の専門分野に特化した知識を持つエージェントを構築したい場合には、その分野のデータでファインチューニングされたモデルを選択できます。

また、推論コストを抑えたい場合には、軽量で高速なモデルを選択することも可能です。

さらに、テキストだけでなく画像や音声などのデータも扱えるマルチモーダル対応のエージェントを構築したい場合には、GPT-4oのように画像や音声の入出力に対応したモデルを選択することで実現できます。

4. エンタープライズグレードのセキュリティ機能

Microsoft Foundry Agent Serviceは、エンタープライズレベルのセキュリティ要件を満たすように設計されており、Azure Monitorとの連携による詳細な監査ログや監視機能も提供され、運用管理とセキュリティが強化されています。

安全なデータ処理、キーレス認証、パブリックエグレスなしといったセキュリティ対策により、機密データや個人情報の漏洩リスクを最小限に抑え、データのプライバシーとコンプライアンスを確保します。

- 安全なデータ処理

エージェントとデータソース間の通信は暗号化され、データは安全に処理されます。機密性の高い情報も安心して扱えます。

- キーレスセットアップとOBO認証

キーレスセットアップや代理認証(On-Behalf-Of)を活用することで、エージェントを簡単かつセキュアに構成・認証し、リソース管理とデプロイの複雑さを軽減します。

- ネットワークセキュリティ

独自の仮想ネットワーク(Bring Your Own Virtual Network: BYOVN)を持ち込むことで、データトラフィックの公開を厳格に制御し、ネットワーク内の対話を安全に保つことが可能です。

- コンテンツフィルター

事前構築済みのカスタムコンテンツフィルターにより、様々な重大度レベルで有害なコンテンツを検出し、企業ポリシーに沿った安全な運用を支援します。

また、プロンプトシールドは、悪意のある攻撃者からのクロスプロンプトインジェクション攻撃からエージェントを保護します。

Microsoft Foundry Agent Serviceの先進的なツール群(2025-2026最新)

Microsoft Foundry Agent Serviceは、2025年から2026年にかけて複数の革新的なツールを追加し、エージェントの能力範囲を大幅に拡張しました。以下の表で、これらの先進ツールの特性を整理しました。この表の説明を読んだ上で、次のセクションで各ツールの詳細と使用例を紹介します。

| ツール名 | 提供開始 | 主な機能 | 使用モデル | ユースケース |

|---|---|---|---|---|

| Deep Research | 2025年11月 | 複雑な調査タスクの自動実行 | o3-deep-research | 市場調査、競合分析、学術リサーチ |

| Browser Automation | 2025年12月 | Webブラウザの自動操作 | Claude 3.5 Sonnet with Playwright | データ収集、UI自動化、テスト |

| Hosted Agents | 2026年1月 | サーバーレスなエージェント実行 | 全対応モデル | スケーラブルな本番環境、コスト最適化 |

| Anthropic Claude | 2026年1月 | OpenAI以外の選択肢 | Claude Opus 4.5, Sonnet 4.5, Haiku 4.5 | 長文処理、複雑な推論、コスト最適化 |

ここで注目すべきは、これらのツールが相互に連携することで、従来は複数のサービスやツールを組み合わせる必要があったワークフローを、単一のプラットフォーム内で完結できるという点です。例えば、Deep Researchで市場調査を実施し、その結果をBrowser Automationで自動的にWebフォームに入力し、Hosted Agentsでスケーラブルに実行する、といった一連のプロセスを統合的に管理できます。

つまり、開発工数の削減とともに、運用コストの最適化が同時に実現できるということです。

Deep Research:複雑な調査タスクの自動実行

Deep Researchは、OpenAIの「o3-deep-research」モデルを活用した高度な調査機能です。この機能により、エージェントは複数のソースから情報を収集し、分析し、包括的なレポートを自動生成できます。

主な特徴:

- 多段階リサーチプロセス:最大20ステップの調査プランを自動生成し、段階的に情報を深掘りします

- ソース多様性:Bing Search、SharePoint、Fabric、カスタムAPIなど複数のデータソースを横断検索します

- 引用管理:収集した情報源を自動的に追跡し、レポートに引用情報を含めます

実装例:

from azure.ai.projects import AIProjectClient

from azure.identity import DefaultAzureCredential

# プロジェクトクライアントの初期化

project_client = AIProjectClient(

credential=DefaultAzureCredential(),

project_connection_string="your_project_connection_string"

)

# Deep Researchエージェントの作成

agent = project_client.agents.create_agent(

model="o3-deep-research",

name="MarketResearchAgent",

instructions="""あなたは市場調査の専門家です。

指定されたテーマについて、複数のソースから情報を収集し、

競合分析、市場規模、トレンド分析を含む包括的なレポートを作成してください。""",

tools=[

{"type": "bing_grounding"},

{"type": "sharepoint"},

{"type": "deep_research"}

]

)

# スレッドの作成と調査リクエスト

thread = project_client.agents.create_thread()

message = project_client.agents.create_message(

thread_id=thread.id,

role="user",

content="生成AIを活用したカスタマーサポート市場について、2026年の市場規模とトレンドを調査してください"

)

# エージェント実行

run = project_client.agents.create_and_process_run(

thread_id=thread.id,

agent_id=agent.id

)

# 結果の取得

messages = project_client.agents.list_messages(thread_id=thread.id)

for msg in messages:

if msg.role == "assistant":

print(f"調査結果:\n{msg.content[0].text.value}")

このアプローチの利点は複数あります。

まず、人間のリサーチャーが数日かけて行う調査を、数時間で自動化できるという時間効率の向上です。通常、市場調査では複数のレポートサイト、業界誌、競合サイトを手動で巡回し、情報を収集・整理する必要がありますが、Deep Researchはこのプロセスを自動化します。

次に、調査の再現性と一貫性が担保されるという品質面でのメリットです。同じパラメータで実行すれば、常に同じソースから同じ基準で情報を収集するため、調査バイアスを最小化できます。

さらに、引用情報が自動的に管理されるため、コンプライアンス要件が厳しい業界(金融、医療、法律など)でも安心して利用できます。

実務的なコスト削減効果:

- 従来の人的リサーチコスト:シニアリサーチャー(時給¥5,000)× 16時間 = ¥80,000/件

- Deep Research実行コスト:o3-deep-researchモデル使用料 約¥2,000/件 + Azure基盤費用 ¥500/件 = ¥2,500/件

- 削減効果:約97%のコスト削減(月10件の調査で年間約¥930万円の削減)

Hosted Agents:サーバーレスなエージェント実行基盤

Hosted Agentsは、2026年1月に正式リリースされたサーバーレスなエージェント実行環境です。開発者はインフラストラクチャの管理を一切せずに、エージェントを本番環境にデプロイし、スケーラブルに実行できます。

従来のアプローチとの違い:

| 項目 | 従来のセルフホスト | Hosted Agents |

|---|---|---|

| インフラ管理 | Azure Container Instances/App Serviceを手動管理 | 完全マネージド(ゼロ管理) |

| スケーリング | 手動設定、オートスケールルール定義が必要 | 自動スケール(リクエスト数に応じて) |

| 起動時間 | コンテナ起動に30-60秒 | コールドスタート5秒以下 |

| 料金モデル | 常時稼働コスト発生 | 実行時間のみ課金(秒単位) |

| 可用性 | SLA管理が必要 | 99.9% SLA保証 |

主な特徴:

- イベントドリブン実行:Azure Event Grid、Logic Apps、Power Automateからのトリガーに対応

- 自動スケーリング:同時実行数を自動調整(デフォルト上限:10インスタンス/リージョン)

- 状態管理:会話履歴とエージェント状態を自動的に永続化

- 統合モニタリング:Application Insightsとの自動統合

実装例(イベントドリブンなカスタマーサポート):

from azure.ai.projects import AIProjectClient

from azure.identity import DefaultAzureCredential

# Hosted Agentの作成

project_client = AIProjectClient(

credential=DefaultAzureCredential(),

project_connection_string="your_project_connection_string"

)

# エージェント定義

agent = project_client.agents.create_agent(

model="gpt-4.1-turbo",

name="CustomerSupportAgent",

instructions="""あなたはカスタマーサポート担当です。

顧客からの問い合わせに対して、FAQデータベースと過去のチケット履歴を参照し、

適切な回答を提供してください。解決できない場合は、人間のオペレーターにエスカレーションしてください。""",

tools=[

{"type": "azure_ai_search", "index_name": "faq-index"},

{"type": "function", "function": {

"name": "escalate_to_human",

"description": "人間のオペレーターにエスカレーションする",

"parameters": {

"type": "object",

"properties": {

"reason": {"type": "string", "description": "エスカレーション理由"},

"priority": {"type": "string", "enum": ["low", "medium", "high"]}

}

}

}}

],

hosted=True # Hosted Agentsとしてデプロイ

)

print(f"Hosted Agent作成完了: {agent.id}")

print(f"エンドポイント: https://{agent.endpoint}")

Hosted Agentsの実行(Event Gridトリガー):

{

"eventType": "customer.inquiry.created",

"subject": "/customers/12345/inquiries/67890",

"data": {

"customerId": "12345",

"inquiryId": "67890",

"message": "注文した商品がまだ届きません。追跡番号を教えてください。",

"priority": "medium"

},

"agentId": "asst_abc123",

"autoExecute": true

}

このアプローチの利点:

- 運用コストの大幅削減:アイドル時間のコストがゼロになるため、トラフィック変動が大きいワークロード(カスタマーサポート、イベント処理など)で特に効果的です

- 開発速度の向上:インフラ設計・構築・運用の工数が不要になり、ビジネスロジックの開発に集中できます

- グローバル展開の容易化:リージョンを指定するだけで、世界中にエージェントをデプロイできます

コスト削減の実例:

- 従来のセルフホスト(Azure Container Instances B1):¥8,000/月(常時稼働) × 12ヶ月 = ¥96,000/年

- Hosted Agents:実行時間のみ課金(平均稼働率20%と仮定)= ¥96,000 × 0.2 = ¥19,200/年

- 削減効果:約80%のコスト削減(年間¥76,800の削減)

Anthropic Claude対応:OpenAI以外の選択肢

2026年1月、Microsoft Foundry Agent ServiceはAnthropic Claudeモデルのネイティブサポートを開始しました。これにより、開発者はOpenAIモデルとClaudeモデルを同じAPIインターフェースで使い分けることができます。

対応モデル(2026年1月時点):

| モデル | コンテキスト長 | 主な用途 | 料金(入力/出力、100万トークンあたり) |

|---|---|---|---|

| Claude Opus 4.5 | 200K | 複雑な推論、長文分析、創造的タスク | $15.00 / $75.00 |

| Claude Sonnet 4.5 | 200K | バランス型、汎用タスク | $3.00 / $15.00 |

| Claude Haiku 4.5 | 200K | 高速処理、大量タスク | $0.80 / $4.00 |

Claudeモデルの特徴:

- 長文コンテキスト処理:200Kトークン(約15万単語)のコンテキスト長を標準サポート

- 指示追従性の高さ:複雑な指示や制約条件を正確に理解し実行

- XML形式のサポート:構造化データの処理に優れる

- 安全性重視:Constitutional AIによる有害コンテンツの生成抑制

実装例(Claude Opus 4.5を使った契約書分析エージェント):

from azure.ai.projects import AIProjectClient

from azure.identity import DefaultAzureCredential

project_client = AIProjectClient(

credential=DefaultAzureCredential(),

project_connection_string="your_project_connection_string"

)

# Claude Opus 4.5エージェントの作成

agent = project_client.agents.create_agent(

model="claude-opus-4.5", # Claudeモデルを指定

name="ContractAnalysisAgent",

instructions="""あなたは法務担当の専門家です。

提供された契約書を分析し、以下の観点でレポートを作成してください:

1. リスク条項の特定(解約条件、賠償責任、知的財産権など)

2. 不利な条件の抽出

3. 改善提案

出力は必ずXML形式で、以下の構造に従ってください:

<analysis>

<risk_clauses>...</risk_clauses>

<unfavorable_terms>...</unfavorable_terms>

<recommendations>...</recommendations>

</analysis>""",

tools=[

{"type": "file_search"} # 契約書PDFの検索

]

)

# 契約書ファイルのアップロード

with open("contract.pdf", "rb") as file:

uploaded_file = project_client.agents.upload_file(

file=file,

purpose="assistants"

)

# 分析リクエスト

thread = project_client.agents.create_thread()

message = project_client.agents.create_message(

thread_id=thread.id,

role="user",

content="添付の契約書を分析してください",

attachments=[{

"file_id": uploaded_file.id,

"tools": [{"type": "file_search"}]

}]

)

run = project_client.agents.create_and_process_run(

thread_id=thread.id,

agent_id=agent.id

)

# 結果取得

messages = project_client.agents.list_messages(thread_id=thread.id)

for msg in messages:

if msg.role == "assistant":

print(f"分析結果:\n{msg.content[0].text.value}")

このアプローチの利点:

- モデル選択の柔軟性:タスクの性質やコスト要件に応じて、最適なモデルを選択できます

- ベンダーロックイン回避:単一のモデルプロバイダーに依存しない、マルチベンダー戦略を実現できます

- コスト最適化:長文処理タスクではClaudeの方がコスト効率が良い場合があります(例:200Kトークンの処理で約30-40%コスト削減)

実務的な使い分け:

- Claude Opus 4.5:法務文書分析、学術論文要約、複雑な推論タスク

- GPT-4.1 Turbo:コード生成、リアルタイム会話、マルチモーダル処理

- Claude Haiku 4.5:大量データの分類、簡易な質疑応答

- GPT-5 Micro:超高速応答が必要なチャットボット

Microsoft Foundry Agent Serviceで利用可能なモデルとリージョン(2026年最新)

Microsoft Foundry Agent Serviceは、2026年1月時点でOpenAI、Anthropic、Microsoftの最新モデルをサポートしています。以下の表で、利用可能なモデルの特性を整理しました。

対応モデル一覧

| モデルファミリー | モデル名 | リリース日 | コンテキスト長 | 主な特徴 |

|---|---|---|---|---|

| GPT-5シリーズ | gpt-5 | 2025年12月 | 128K | 大幅な性能向上、マルチモーダル強化 |

| gpt-5-turbo | 2025年12月 | 128K | GPT-5の高速版 | |

| gpt-5-micro | 2026年1月 | 128K | 超高速応答、コスト最適化 | |

| GPT-4.1シリーズ | gpt-4.1 | 2025年10月 | 128K | GPT-4の改良版 |

| gpt-4.1-turbo | 2025年10月 | 128K | 高速処理版 | |

| o3/o4シリーズ | o3 | 2025年11月 | 128K | 推論特化モデル |

| o3-deep-research | 2025年11月 | 128K | Deep Research専用 | |

| o4-mini | 2025年12月 | 128K | 軽量推論モデル | |

| Claude(Anthropic) | claude-opus-4.5 | 2025年11月 | 200K | 高度な推論、長文処理 |

| claude-sonnet-4.5 | 2025年11月 | 200K | バランス型 | |

| claude-haiku-4.5 | 2025年11月 | 200K | 高速処理 |

ここで注目すべきは、モデルの選択がビジネス成果に直結するという点です。例えば、カスタマーサポートでは応答速度が顧客満足度に影響するため、gpt-5-microやclaude-haiku-4.5が適しています。一方、契約書分析や市場調査では精度が重視されるため、claude-opus-4.5やo3-deep-researchが適切です。

つまり、同じエージェントアプリケーションでも、タスクに応じてモデルを動的に切り替えることで、品質とコストの両面で最適化できるということです。

利用可能なリージョン(2026年1月拡張)

2026年1月に、以下の新リージョンが追加されました:

| リージョン | 場所 | 対応モデル | データレジデンシー |

|---|---|---|---|

| Brazil South | サンパウロ | GPT-4.1, GPT-5, Claude Sonnet/Haiku | ブラジル国内 |

| Germany West Central | フランクフルト | 全モデル対応 | EU域内 |

| Italy North | ミラノ | GPT-4.1, GPT-5, Claude全種 | EU域内 |

| South Central US | テキサス | 全モデル対応 | 米国内 |

既存リージョン:East US、East US 2、North Central US、South Central US、West US、West US 3、Australia East、Canada East、France Central、Japan East、Sweden Central、Switzerland North、UK South

リージョン選択の実務的考慮事項:

- データレジデンシー要件:GDPRやブラジルLGPD等の法規制に準拠する必要がある場合、該当地域のリージョンを選択します

- レイテンシ最適化:エンドユーザーに最も近いリージョンを選択することで、応答時間を短縮できます(平均50-100ms改善)

- クォータ管理:リージョンごとにモデルのクォータ(TPM: Tokens Per Minute)が異なるため、大規模利用では複数リージョンの活用を検討します

実際に使ってみましょう

このセクションでは、Microsoft Foundry Agent Serviceを使った実践的な開発手順を、段階的に説明します。以下のステップで、基本的なエージェントから高度なマルチエージェントシステムまで構築できます。

ステップ1: Azure AI Foundryプロジェクトのセットアップ

前提条件:

- Azureサブスクリプション(無料試用版でも可)

- Azure CLI(バージョン2.50以上)

- Python 3.8以上(Python SDKを使用する場合)

プロジェクト作成手順:

# Azure CLIでログイン

az login

# リソースグループの作成

az group create --name rg-ai-agents --location eastus

# AI Foundryプロジェクトの作成

az ml workspace create \

--name ai-agent-project \

--resource-group rg-ai-agents \

--location eastus \

--kind project

Azure Portalでの確認:

- Azure AI Foundryにアクセス

- 作成したプロジェクトを選択

- 「Settings」→「Properties」から接続文字列をコピー(後で使用)

ステップ2: Python SDKのインストールと初期化

# Azure AI Projects SDKのインストール

pip install azure-ai-projects azure-identity

# 環境変数の設定(接続文字列を使用)

export PROJECT_CONNECTION_STRING="your_connection_string_here"

基本的なクライアント初期化:

import os

from azure.ai.projects import AIProjectClient

from azure.identity import DefaultAzureCredential

# プロジェクトクライアントの初期化

project_client = AIProjectClient(

credential=DefaultAzureCredential(),

project_connection_string=os.environ["PROJECT_CONNECTION_STRING"]

)

print("プロジェクト接続成功!")

ステップ3: 最初のエージェントを作成する

シンプルな「製品推薦エージェント」を作成します。このエージェントは、ユーザーの質問に基づいて、製品カタログから最適な製品を推薦します。

# エージェントの作成

agent = project_client.agents.create_agent(

model="gpt-4.1-turbo",

name="ProductRecommendationAgent",

instructions="""あなたは製品推薦の専門家です。

ユーザーの要望を聞き、製品カタログから最適な製品を推薦してください。

推薦時には、以下の情報を必ず含めてください:

1. 推薦理由

2. 製品の主な特徴

3. 価格帯

4. 類似製品との比較""",

tools=[

{"type": "code_interpreter"}, # データ分析用

{"type": "file_search"} # 製品カタログ検索用

]

)

print(f"エージェント作成完了: {agent.id}")

製品カタログファイルのアップロード:

# サンプル製品カタログ(CSV形式)

catalog_content = """product_id,name,category,price,features

P001,ノートPC Pro,電子機器,150000,16GB RAM / 512GB SSD / 14インチ

P002,ビジネスバッグ Premium,アクセサリー,25000,本革 / 防水 / PC収納

P003,ワイヤレスイヤホン Elite,電子機器,30000,ノイキャン / 8時間再生

"""

# ファイルとして保存

with open("product_catalog.csv", "w", encoding="utf-8") as f:

f.write(catalog_content)

# Azureにアップロード

with open("product_catalog.csv", "rb") as file:

catalog_file = project_client.agents.upload_file(

file=file,

purpose="assistants"

)

print(f"カタログファイルアップロード完了: {catalog_file.id}")

ステップ4: エージェントとの会話を実行する

# 会話スレッドの作成

thread = project_client.agents.create_thread()

# ユーザーメッセージの送信

message = project_client.agents.create_message(

thread_id=thread.id,

role="user",

content="リモートワークに最適な製品を推薦してください。予算は20万円です。",

attachments=[{

"file_id": catalog_file.id,

"tools": [{"type": "file_search"}]

}]

)

# エージェントの実行

run = project_client.agents.create_and_process_run(

thread_id=thread.id,

agent_id=agent.id

)

print(f"実行ステータス: {run.status}")

# 応答の取得

messages = project_client.agents.list_messages(thread_id=thread.id)

for msg in messages:

print(f"{msg.role}: {msg.content[0].text.value}\n")

実行結果の例:

assistant: リモートワークに最適な製品として、以下を推薦します:

1. **ノートPC Pro(P001)- ¥150,000**

- 推薦理由:予算内で高性能なノートPCです

- 主な特徴:16GB RAMで複数アプリ同時実行、512GB SSDで高速起動

- 14インチで持ち運びも容易

2. **ワイヤレスイヤホン Elite(P003)- ¥30,000**

- 推薦理由:Web会議での音質向上とノイズキャンセリング

- 主な特徴:8時間連続再生で一日中使用可能

- 残予算:¥20,000

合計:¥180,000(予算内)

ビジネスバッグ Premiumは予算オーバーとなるため、今回は除外しました。

このアプローチの利点:

- 製品知識の自動更新:カタログファイルを更新するだけで、エージェントが最新情報を参照します

- 一貫した推薦基準:instructionsで定義した基準に基づき、常に同じフォーマットで回答します

- スケーラブルな対応:複数ユーザーからの同時リクエストにも、スレッドで個別に対応できます

マルチエージェントシステムの作成(Connected Agents)

Microsoft Foundry Agent ServiceのConnected Agents機能を使うと、複数の専門エージェントを連携させ、複雑なワークフローを自動化できます。以下の表で、マルチエージェントアーキテクチャのパターンを整理しました。

| パターン | 構成 | 使用例 | メリット |

|---|---|---|---|

| Sequential(順次実行) | Agent A → Agent B → Agent C | データ収集→分析→レポート作成 | シンプル、デバッグ容易 |

| Parallel(並列実行) | Agent A, B, C(同時実行) | 複数ソースからの情報収集 | 高速処理 |

| Hierarchical(階層型) | Manager Agent → Worker Agents | タスク分解と並列処理 | 複雑なタスク管理 |

| Event-Driven(イベント駆動) | Trigger → Agent → Action | 異常検知→通知→対応 | リアルタイム対応 |

ここで注目すべきは、エージェント間の通信プロトコルとして「Agent2Agent (A2A)」が標準化されているという点です。これにより、異なるチームが開発したエージェント同士でも、相互運用性が保証されます。

つまり、エージェントのエコシステムを構築し、部門横断的な業務自動化を実現できるということです。

実装例:カスタマーサポートの多段階自動化

以下は、「問い合わせ分類」→「FAQ検索」→「回答生成」→「満足度確認」の4段階プロセスを自動化する例です。

エージェント1: 問い合わせ分類エージェント

# 分類エージェントの作成

classifier_agent = project_client.agents.create_agent(

model="gpt-4.1-turbo",

name="InquiryClassifierAgent",

instructions="""顧客の問い合わせを以下のカテゴリに分類してください:

- technical_support(技術サポート)

- billing(請求関連)

- general_inquiry(一般問い合わせ)

- complaint(クレーム)

出力はJSON形式で、以下のフィールドを含めてください:

{

"category": "カテゴリ名",

"priority": "low/medium/high",

"keywords": ["キーワード1", "キーワード2"]

}"""

)

エージェント2: FAQ検索エージェント

# FAQ検索エージェントの作成(Azure AI Searchと連携)

faq_agent = project_client.agents.create_agent(

model="gpt-4.1-turbo",

name="FAQSearchAgent",

instructions="""分類結果を受け取り、FAQデータベースから関連する情報を検索してください。

見つかった場合は、FAQ内容と信頼度スコアを返してください。

見つからない場合は、next_agentフィールドに"escalation"を設定してください。""",

tools=[

{

"type": "azure_ai_search",

"index_name": "customer-faq-index"

}

]

)

エージェント3: 回答生成エージェント

# 回答生成エージェント

response_agent = project_client.agents.create_agent(

model="gpt-5-turbo", # より高品質な応答のためGPT-5を使用

name="ResponseGenerationAgent",

instructions="""FAQ情報を基に、顧客向けの丁寧な回答を生成してください。

以下の要件を満たしてください:

1. 敬語を使用

2. 解決手順を番号付きリストで提示

3. 追加のサポートが必要な場合の連絡先を含める

4. 回答の最後に満足度確認の質問を追加"""

)

エージェント4: エスカレーション管理エージェント

# エスカレーション管理

escalation_agent = project_client.agents.create_agent(

model="gpt-4.1-turbo",

name="EscalationAgent",

instructions="""FAQで解決できない問い合わせを処理してください。

1. 問い合わせ内容を要約

2. 適切な担当部門を特定

3. チケットシステムに登録(escalate_ticket関数を使用)

4. 顧客に「担当者から24時間以内に連絡する」旨を通知""",

tools=[

{

"type": "function",

"function": {

"name": "escalate_ticket",

"description": "チケットシステムに問い合わせを登録",

"parameters": {

"type": "object",

"properties": {

"department": {"type": "string", "enum": ["technical", "billing", "general"]},

"priority": {"type": "string", "enum": ["low", "medium", "high"]},

"summary": {"type": "string"}

},

"required": ["department", "priority", "summary"]

}

}

}

]

)

マルチエージェントワークフローの実行:

# 顧客からの問い合わせ

customer_inquiry = "先月の請求額が通常より高いのですが、内訳を確認したいです。"

# ステップ1: 分類

thread1 = project_client.agents.create_thread()

project_client.agents.create_message(

thread_id=thread1.id,

role="user",

content=customer_inquiry

)

run1 = project_client.agents.create_and_process_run(

thread_id=thread1.id,

agent_id=classifier_agent.id

)

classification_result = project_client.agents.list_messages(thread_id=thread1.id)[0].content[0].text.value

# ステップ2: FAQ検索

thread2 = project_client.agents.create_thread()

project_client.agents.create_message(

thread_id=thread2.id,

role="user",

content=f"分類結果: {classification_result}\n元の問い合わせ: {customer_inquiry}"

)

run2 = project_client.agents.create_and_process_run(

thread_id=thread2.id,

agent_id=faq_agent.id

)

faq_result = project_client.agents.list_messages(thread_id=thread2.id)[0].content[0].text.value

# ステップ3: 回答生成(またはエスカレーション)

if "next_agent" in faq_result and "escalation" in faq_result:

# FAQ未解決 → エスカレーション

thread3 = project_client.agents.create_thread()

project_client.agents.create_message(

thread_id=thread3.id,

role="user",

content=f"元の問い合わせ: {customer_inquiry}\n分類: {classification_result}"

)

run3 = project_client.agents.create_and_process_run(

thread_id=thread3.id,

agent_id=escalation_agent.id

)

else:

# FAQ解決 → 回答生成

thread3 = project_client.agents.create_thread()

project_client.agents.create_message(

thread_id=thread3.id,

role="user",

content=f"FAQ情報: {faq_result}\n顧客への回答を生成してください"

)

run3 = project_client.agents.create_and_process_run(

thread_id=thread3.id,

agent_id=response_agent.id

)

final_response = project_client.agents.list_messages(thread_id=thread3.id)[0].content[0].text.value

print(f"最終回答:\n{final_response}")

このマルチエージェントアプローチの利点:

- 専門性の分離:各エージェントが特定の役割に特化するため、精度が向上します

- 保守性の向上:個別エージェントの改善が全体に影響を与えず、段階的な改良が可能です

- 再利用性:FAQエージェントは他のワークフロー(メール自動応答、チャットボットなど)でも利用できます

- スケーラビリティ:各エージェントを独立してスケールできるため、ボトルネックを解消しやすい

実務的な効果測定:

- 応答時間短縮:従来の人的対応(平均2時間)→ 自動応答(平均3分)= 97.5%短縮

- 解決率向上:FAQ自動解決率 約70%(残り30%のみ人的対応)

- コスト削減:オペレーター1名(年間¥400万円)→ エージェント運用費(年間¥40万円)= 90%削減

- 顧客満足度:24時間365日対応により、夜間・休日の問い合わせにも即座に対応(CSAT +15ポイント向上)

Microsoft Foundry Agent Serviceが向いている場面 vs 向かない場面

Microsoft Foundry Agent Serviceの導入を検討する際、すべてのユースケースに適しているわけではありません。以下の表で、適用場面と非適用場面を整理しました。この表を参考に、自社のユースケースが適しているかを判断してください。

向いている場面

| ユースケース | 理由 | 期待効果 |

|---|---|---|

| カスタマーサポートの自動化 | FAQベースの問い合わせが多く、定型的な回答が可能 | 問い合わせ対応時間70%削減、24時間対応可能 |

| 社内ヘルプデスクの構築 | IT、人事、総務等の社内問い合わせを自動化 | 社内問い合わせ処理コスト60%削減、従業員満足度向上 |

| ドキュメント分析・要約 | 大量の契約書、レポート、論文等の分析タスク | 分析時間90%短縮、見落としリスク低減 |

| データ収集・市場調査 | 複数ソースからの情報収集と統合 | リサーチコスト80%削減、調査範囲拡大 |

| コンテンツ生成 | ブログ記事、製品説明、レポートの下書き作成 | コンテンツ作成時間50%短縮、一貫性向上 |

| コード生成・レビュー | 定型的なコード生成、テストコード作成、レビュー | 開発速度30%向上、品質向上 |

| 業務プロセスの自動化 | 承認ワークフロー、データ入力、レポート作成等 | 事務作業時間70%削減、ヒューマンエラー削減 |

| 多言語サポート | グローバル展開で多言語対応が必要 | 翻訳コスト削減、リアルタイム多言語対応 |

ここで注目すべきは、これらのユースケースに共通する特性があるという点です:

- タスクの定型性:一定のパターンやルールに基づいて処理できる

- 大量データ処理:人間が処理するには時間がかかる、または物理的に不可能な量

- 24時間稼働の必要性:営業時間外の対応が求められる

- スケーラビリティ:需要の変動が大きく、柔軟なリソース調整が必要

つまり、「繰り返し発生する、知識ベースのタスク」が最も適している**ということです。

向かない場面

| ユースケース | 理由 | 代替案 |

|---|---|---|

| 高度な創造的判断が必要 | AIは既存パターンの組み合わせで、真の創造性には限界がある | 人間の専門家による判断 |

| リアルタイムの物理的操作 | ロボット制御等の物理世界への直接介入 | ロボティクスプラットフォーム(ROS等) |

| 厳密な法的・医療的判断 | 誤判断のリスクが極めて高く、法的責任が問われる | 人間専門家のサポートツールとしての活用 |

| 感情的サポートが主目的 | 深い共感や感情理解が必要なカウンセリング等 | 人間カウンセラー(AIは補助的に活用) |

| 完全にランダムなタスク | パターン化できない、毎回異なるアプローチが必要 | カスタム開発、人間による対応 |

| リアルタイム音声・動画処理 | 現時点ではレイテンシとコストが課題 | 専用の音声/動画処理サービス(Azure Cognitive Services等) |

| 極めて低コストが要件 | 大量の単純タスクでコスト制約が厳しい | RPA、スクリプト自動化 |

| 完全オフライン環境 | クラウド接続が不可の環境 | オンプレミスLLMソリューション |

これらの非適用場面に共通する特性:

- 高いリスクと責任:誤りが人命や法的責任に直結する

- 真の創造性と感情性:人間固有の能力が不可欠

- 物理的制約:クラウドベースのサービスでは対応不可

- コスト制約:AI実行コストが他の手段より高い

重要な注意点:

「向かない場面」でも、人間の判断を補助するツールとしては有効な場合があります。例えば:

- 医療診断:AIは補助診断ツールとして、医師の判断をサポート(最終判断は医師)

- 法的文書作成:AIは下書きを作成し、弁護士がレビュー・修正

- 創造的デザイン:AIが複数案を生成し、デザイナーが選択・改良

つまり、「AI単独での実行」ではなく「Human-in-the-Loop(人間が最終判断)」のアプローチが有効**ということです。

ベストプラクティス: 段階的な導入アプローチ

Microsoft Foundry Agent Serviceを本格的に導入する際、いきなり大規模展開するのではなく、段階的なアプローチを推奨します。以下のフェーズで、リスクを最小化しながら価値を実証できます。

フェーズ1: パイロットプロジェクト(1-2ヶ月)

目的:技術検証と初期効果測定

推奨アクション:

-

スコープの限定:

- 単一部門、単一ユースケースに絞る(例:ITヘルプデスクの一般的な問い合わせ対応)

- 影響範囲が小さく、失敗してもリカバリ可能な領域を選択

-

シンプルなエージェント構築:

- 1-2個のエージェントのみ使用

- 複雑なワークフローは避け、基本機能の検証に集中

-

並行運用:

- 既存の人的プロセスを並行稼働させ、AIの回答を人間がレビュー

- 精度とユーザー満足度を測定

-

KPI設定:

- 応答精度(正解率)

- 応答時間

- ユーザー満足度(CSAT)

- コスト削減額

成功基準の例:

- 正解率 ≥ 80%

- 平均応答時間 < 5分

- CSAT ≥ 4.0/5.0

- コスト削減 ≥ 30%

このフェーズの利点:

パイロットプロジェクトにより、経営層への説得材料となる定量的なデータが得られるという点です。「理論上の効果」ではなく、「実測された効果」を示すことで、次フェーズの予算承認が容易になります。

フェーズ2: 部門展開(3-6ヶ月)

目的:スケールアップとプロセス最適化

推奨アクション:

-

対象範囲の拡大:

- パイロットで成功したユースケースを部門全体に展開

- 関連する他のユースケースを追加(例:ITヘルプデスク → 人事・総務ヘルプデスク)

-

マルチエージェント化:

- Connected Agentsで複数エージェントを連携

- より複雑なワークフローの自動化

-

運用プロセスの確立:

- エージェントのモニタリング体制

- エラー発生時のエスカレーションフロー

- 定期的な精度評価とチューニング

-

ユーザートレーニング:

- エンドユーザー向けの利用ガイド作成

- 効果的なプロンプト作成のトレーニング

KPI追加項目:

- スループット(処理件数/日)

- エスカレーション率(人間対応が必要だった割合)

- システム稼働率(Uptime)

このフェーズの利点:

運用ノウハウの蓄積により、次の全社展開で発生しうる問題を事前に特定・解決できるという点です。特に、エスカレーションフローやモニタリング体制の構築は、本格運用の成否を左右します。

フェーズ3: 全社展開(6-12ヶ月)

目的:全社的な業務改革とROI最大化

推奨アクション:

-

横展開:

- 成功パターンを他部門に水平展開

- 部門横断的なワークフロー自動化

-

高度な機能の活用:

- Deep Research(市場調査、競合分析)

- Browser Automation(データ収集、RPA代替)

- Hosted Agents(コスト最適化、グローバル展開)

-

データ統合:

- 企業全体のナレッジベース統合

- 部門間でのエージェント共有

-

ガバナンス体制:

- AI利用ポリシーの策定

- データプライバシーとセキュリティ監査

- コンプライアンス確認

KPI追加項目:

- ROI(投資対効果)

- 従業員生産性向上率

- ビジネスプロセスサイクルタイム短縮率

全社展開の成功要因:

経営層のコミットメントと、現場の声を反映した継続的改善のサイクルが不可欠です。トップダウンの方針と、ボトムアップのフィードバックを組み合わせることで、持続可能なAI活用が実現します。

フェーズ4: 継続的最適化(12ヶ月以降)

目的:長期的な価値創出と進化

推奨アクション:

-

定期的なレビュー:

- 四半期ごとのKPIレビュー

- エージェントのパフォーマンス分析

- 新しいユースケースの発掘

-

モデルアップデート:

- 新しいモデル(GPT-5、Claude等)へのマイグレーション

- コスト最適化のためのモデル切り替え

-

エージェントの進化:

- ユーザーフィードバックを反映した指示文改善

- 新しいツール・機能の追加

-

ベストプラクティス共有:

- 成功事例の社内共有

- 他部門への知見移転

このフェーズの利点:

AIエージェントが「導入して終わり」ではなく、「継続的に進化する資産」として定着するという点です。定期的な改善により、初期導入時の3-5倍の効果を実現できるケースもあります。

クォータと制限

Microsoft Foundry Agent Serviceには、リソース保護と公平な利用のため、いくつかのクォータ(利用上限)が設定されています。以下の表で、主要なクォータを整理しました。

| 項目 | デフォルト値 | 上限申請 | 備考 |

|---|---|---|---|

| TPM(Tokens Per Minute) | モデル・リージョンごとに異なる | サポートリクエストで申請可能 | GPT-5: 150K TPM、GPT-4.1: 80K TPM(East US) |

| RPM(Requests Per Minute) | 500 | サポートリクエストで申請可能 | 同時リクエスト数の上限 |

| エージェント数 | 100/プロジェクト | サポートリクエストで申請可能 | アクティブなエージェントの総数 |

| スレッド数 | 10,000/プロジェクト | サポートリクエストで申請可能 | 会話スレッドの総数 |

| ファイルサイズ | 512MB/ファイル | 固定 | アップロード可能な単一ファイルの上限 |

| ファイル数 | 10,000/プロジェクト | サポートリクエストで申請可能 | アップロード済みファイルの総数 |

| Vector Storeサイズ | 100GB/プロジェクト | サポートリクエストで申請可能 | File Search用のベクトルストア容量 |

| Hosted Agents同時実行 | 10/リージョン | サポートリクエストで申請可能 | 同時に実行できるHosted Agentsのインスタンス数 |

ここで注目すべきは、クォータ管理が本番運用の安定性に直結するという点です。特にTPM(Tokens Per Minute)は、ピーク時のトラフィックを想定して、余裕を持った設定が必要です。

つまり、事前のキャパシティプランニングが、サービス停止リスクを回避する鍵ということです。

クォータ超過時の動作:

- TPM/RPM超過:HTTP 429エラー(Too Many Requests)が返され、リクエストが拒否されます

- 推奨対応:指数バックオフ(Exponential Backoff)による再試行実装

実装例(Pythonでの再試行ロジック):

import time

from azure.core.exceptions import HttpResponseError

def create_message_with_retry(project_client, thread_id, role, content, max_retries=5):

"""クォータ超過時に自動再試行するメッセージ作成関数"""

for attempt in range(max_retries):

try:

return project_client.agents.create_message(

thread_id=thread_id,

role=role,

content=content

)

except HttpResponseError as e:

if e.status_code == 429: # Rate limit exceeded

wait_time = (2 ** attempt) + (random.random() * 0.1) # 指数バックオフ

print(f"クォータ超過。{wait_time}秒後に再試行します(試行 {attempt + 1}/{max_retries})")

time.sleep(wait_time)

else:

raise

raise Exception(f"{max_retries}回の再試行後もクォータ超過が解消されませんでした")

クォータ最適化のベストプラクティス:

- リージョン分散:複数リージョンにエージェントを分散配置し、クォータを分散

- モデル選択:タスクに応じて、より軽量なモデル(gpt-4.1-turbo → gpt-5-micro)を使用

- キャッシング:同じ質問への回答をキャッシュし、重複リクエストを削減

- バッチ処理:リアルタイム性が不要なタスクはオフピーク時にバッチ実行

料金体系(2026年最新)

Microsoft Foundry Agent Serviceの料金は、使用したAIモデルの実行コスト + Azure基盤コストの2つで構成されます。以下の表で、主要モデルの料金を整理しました。

モデル別料金(100万トークンあたり、2026年1月時点)

| モデル | 入力トークン | 出力トークン | 用途 |

|---|---|---|---|

| GPT-5 | $25.00 | $100.00 | 最高品質、複雑な推論 |

| GPT-5 Turbo | $10.00 | $30.00 | バランス型、汎用 |

| GPT-5 Micro | $0.40 | $1.60 | 高速応答、大量処理 |

| GPT-4.1 | $30.00 | $60.00 | 従来の高品質モデル |

| GPT-4.1 Turbo | $10.00 | $30.00 | 従来のバランス型 |

| o3 | $15.00 | $60.00 | 推論特化 |

| o3-deep-research | $20.00 | $80.00 | Deep Research専用 |

| o4-mini | $3.00 | $12.00 | 軽量推論 |

| Claude Opus 4.5 | $15.00 | $75.00 | 高度な推論 |

| Claude Sonnet 4.5 | $3.00 | $15.00 | バランス型 |

| Claude Haiku 4.5 | $0.80 | $4.00 | 高速処理 |

Azure基盤コスト

| リソース | 料金 | 備考 |

|---|---|---|

| AI Foundryプロジェクト | 無料 | プロジェクト自体に課金なし |

| Vector Store(File Search) | $0.10/GB/日 | ベクトルストレージ |

| Code Interpreter実行 | $0.03/セッション | コード実行環境 |

| Azure AI Search | $250/月〜 | インデックスサイズに応じて |

| Hosted Agents | 実行時間のみ課金 | 秒単位課金、アイドル時間は無料 |

ここで注目すべきは、料金の約80-90%がモデル実行コスト(トークン使用量)であるという点です。したがって、コスト最適化の鍵は「適切なモデル選択」と「トークン使用量の削減」です。

つまり、タスクごとに最適なモデルを動的に選択することで、品質を維持しながらコストを30-50%削減できるということです。

コスト最適化の実例:

シナリオ:月間10万件のカスタマーサポート問い合わせ対応

- 平均入力トークン:500トークン/件

- 平均出力トークン:300トークン/件

パターン1:すべてGPT-5 Turboで処理

- 入力コスト:100,000件 × 500トークン × $10/百万トークン = $500

- 出力コスト:100,000件 × 300トークン × $30/百万トークン = $900

- 合計:$1,400/月(約¥210,000/月)

パターン2:タスクに応じてモデルを使い分け

- 簡易な問い合わせ(70%):GPT-5 Micro使用

- 入力:70,000 × 500 × $0.4/百万 = $14

- 出力:70,000 × 300 × $1.6/百万 = $33.6

- 複雑な問い合わせ(30%):GPT-5 Turbo使用

- 入力:30,000 × 500 × $10/百万 = $150

- 出力:30,000 × 300 × $30/百万 = $270

- 合計:$467.6/月(約¥70,000/月)

- 削減効果:67%削減(約¥140,000/月の削減、年間約¥168万円)

Hosted Agentsのコスト例:

従来のコンテナホスティングと比較すると、以下のようなコスト構造になります:

- 従来(Azure Container Instances B1、常時稼働):$110/月

- Hosted Agents(平均稼働率20%):$110 × 0.2 = $22/月

- 削減効果:80%削減(年間約$1,056 = 約¥15.8万円の削減)

データプライバシーとセキュリティ

Microsoft Foundry Agent Serviceは、エンタープライズグレードのセキュリティ機能を標準で提供しています。以下の表で、主要なセキュリティ機能を整理しました。

| セキュリティ機能 | 内容 | 対応する規制・標準 |

|---|---|---|

| データ暗号化 | 転送時(TLS 1.2+)、保存時(AES-256)の暗号化 | GDPR、HIPAA、PCI DSS |

| プライベートエンドポイント | Azure Virtual Network経由のプライベート接続 | 企業内ネットワークポリシー |

| Microsoft Entra ID統合 | シングルサインオン(SSO)、多要素認証(MFA) | ゼロトラストセキュリティ |

| RBAC(ロールベースアクセス制御) | きめ細かい権限管理(閲覧、編集、実行、管理) | SOC 2、ISO 27001 |

| 監査ログ | すべてのAPI呼び出しをAzure Monitor/App Insightsに記録 | コンプライアンス監査 |

| データレジデンシー | 選択したリージョン内でのみデータ処理・保存 | GDPR、各国データローカライゼーション法 |

| Abuse Monitoring | 不正利用・攻撃の自動検知とブロック | セキュリティベストプラクティス |

| OBO認証 | ユーザー権限の委譲、パスワード不要 | 最小権限の原則 |

ここで注目すべきは、これらのセキュリティ機能が「オプション」ではなく「標準機能」として提供されるという点です。追加コストなしで、エンタープライズレベルのセキュリティが実現できます。

つまり、スタートアップから大企業まで、同じセキュリティレベルを享受できるということです。

データ処理の透明性:

Microsoft Foundry Agent Serviceは、以下のデータプライバシー原則に基づいています:

- 顧客データの非学習利用:顧客がアップロードしたデータや会話履歴は、Microsoftのモデル学習には使用されません

- データ保持期間:明示的に削除するまでデータは保持されます(自動削除オプションも設定可能)

- データ所有権:すべてのデータは顧客に帰属し、Microsoftは処理者として機能します

GDPRコンプライアンス対応:

- データ主体アクセス要求(DSAR):ユーザーからのデータ開示請求に対応可能

- 削除権(Right to be forgotten):ユーザーデータの完全削除をAPIで実行可能

- データポータビリティ:データのエクスポート機能を提供

実装例(ユーザーデータの完全削除):

# 特定ユーザーのすべてのスレッドとメッセージを削除

user_threads = project_client.agents.list_threads()

for thread in user_threads:

if thread.metadata.get("user_id") == "user_12345":

project_client.agents.delete_thread(thread_id=thread.id)

print(f"スレッド {thread.id} を削除しました")

# アップロードしたファイルも削除

user_files = project_client.agents.list_files()

for file in user_files:

if file.metadata.get("user_id") == "user_12345":

project_client.agents.delete_file(file_id=file.id)

print(f"ファイル {file.id} を削除しました")

セキュリティベストプラクティス:

- 最小権限の原則:エージェントには必要最小限のツールとデータアクセス権限のみ付与

- 定期的な監査:Azure Monitorのログを定期的にレビューし、異常なアクセスパターンを検知

- プライベートエンドポイント使用:機密データを扱う場合は、パブリックインターネットを経由しない

- バージョン管理:エージェントの指示文やツール設定を版管理し、変更履歴を追跡

ChatGPT活用でお困りの方へ

まとめ

Microsoft Foundry Agent Service(旧Azure AI Foundry Agent Service、旧Azure AI Agent Service)は、2026年1月時点でエンタープライズグレードのAIエージェント開発プラットフォームとして進化を続けています。本記事では、名称変更の歴史、主要機能、先進ツール、モデル、導入アプローチ、そして実務的なコスト削減効果まで網羅的に解説しました。

Microsoft Foundry Agent Serviceの3つの価値提案

-

開発速度の劇的な向上

- 事前構築されたツール(File Search、Code Interpreter、Deep Research等)により、ゼロからの開発と比較して80-90%の開発工数削減

- Azure AI Search、SharePoint、Fabric等の既存サービスとのシームレスな統合

- Python、JavaScript、C#等の主要言語SDKによる迅速な実装

-

運用コストの大幅削減

- カスタマーサポートの自動化で年間数百万円〜数千万円のコスト削減(事例:年間¥2.4M削減)

- Hosted Agentsによる80%のインフラコスト削減

- モデルの使い分けによる30-50%のAI実行コスト削減

-

エンタープライズグレードの信頼性

- GDPR、HIPAA、SOC 2等の国際的なコンプライアンス標準に対応

- データ暗号化、RBAC、監査ログ等のセキュリティ機能を標準搭載

- 99.9% SLAによる高可用性保証

次のステップ:今日から始めるAIエージェント開発

Microsoft Foundry Agent Serviceの導入を検討している方は、以下のステップで実践を開始できます:

ステップ1:無料で試す(今日から可能)

- Azureの無料試用版アカウントを作成(クレジットカード登録必要、初月$200クレジット)

- Azure AI Foundryで最初のプロジェクトを作成

- 本記事の「実際に使ってみましょう」セクションのコードをコピー&ペーストして実行

ステップ2:パイロットプロジェクトの企画(1週間)

- 自社の業務プロセスから、「繰り返し発生する知識ベースのタスク」を特定

- 「向いている場面」の表と照らし合わせて、最適なユースケースを選定

- KPI(正解率、応答時間、コスト削減額等)を定義

ステップ3:段階的な展開(1-12ヶ月)

- 「ベストプラクティス: 段階的な導入アプローチ」セクションに従い、フェーズごとに展開

- 定量的な効果測定を継続し、経営層への報告とフィードバックループを確立

**Microsoft Foundry Agent Serviceは、単なる技術ツールではなく、企業のデジタルトランスフォーメーションを加速する戦略的資産です。**本記事で紹介した実践例やベストプラクティスを参考に、ぜひAIエージェントの力を体感してください。

参考リンク: