この記事のポイント

GPT-4oは2024年発表のマルチモーダルAIモデルで、テキスト・画像・音声を統合処理できる

2026年2月13日にChatGPTのUI上から引退。APIでは引き続き利用可能

日本語を含む多言語性能の大幅向上と、APIコスト50%削減を実現した

画像生成機能(ネイティブ画像生成)の搭載により、対話しながら高品質な画像を作成可能

後継のGPT-5.2がChatGPTの標準モデルとなり、GPT-4oの技術は発展的に引き継がれている

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

OpenAIが2024年に発表したマルチモーダルAIモデル**ChatGPT-4o(GPT-4o)**は、テキスト・画像・音声を統合的に処理できる画期的なモデルとして大きな注目を集めました。

2026年2月13日をもってChatGPTのUI上からは引退しましたが、APIでは引き続き利用可能であり、その技術はGPT-5.2に受け継がれています。

本記事では、GPT-4oの主要機能、料金体系、使い方、そして現在の後継モデルとの関係まで、包括的に解説します。

目次

ChatGPT-4o(GPT-4o)とは

ChatGPT-4oとは、OpenAIが2024年に発表した汎用マルチモーダルAIモデルです。 名称の「o」は”omni(オムニ)=すべて”を意味し、テキスト・画像・音声といった複数のモードを自在に扱える点が大きな特徴となっています。

このモデルは従来のGPT-4 Turboと同等以上の性能を持ちながら、音声応答速度は最短232ミリ秒(平均320ミリ秒)と人間に近い速さを実現しました。また、非英語圏での精度向上、日本語対応の強化、さらにAPIのコストが従来比で50%削減されるなど、開発者とユーザー双方にとって画期的なアップデートとなっています。

アップデートされたGPT-4oの画像

教育、カスタマーサポート、コンテンツ生成など幅広い分野での応用が進み、すでに多くのサービスがGPT-4oを組み込み進化を遂げています。これにより、組織や個人はより高度で自然なAI体験を得られるようになりました。

GPT-4o miniとは

GPT-4o miniは、OpenAIが発表した小型かつコスト効率に優れた生成AIモデルです。GPT-4を上回る性能を持ちながら、GPT-3.5 Turboよりも60%以上安価です。(API利用料金)

テキストとビジョン(マルチモーダル機能)をサポートし、将来的にはビデオやオーディオにも対応予定です。

数学、コーディング、マルチモーダル推論など様々なタスクで高いパフォーマンスを発揮し、安全対策も強化されています。

発表当初はAPI経由でのみ利用可能でしたが、現在はChatGPTの無料版・有料版(ChatGPT Plus)でも利用可能です。

モデル選択画面。(画像はChatGPT Plusの場合)

GPT-4oの引退と後継モデルの関係

2025年8月にGPT-5が発表された後、ChatGPTのデフォルトモデルはGPT-5へ移行し、GPT-4oはレガシーモデルとして一時期並行提供されていました。

しかし、2026年2月13日をもって、GPT-4oはChatGPTのUI上から完全に引退しました。OpenAIによれば、引退時点でChatGPTユーザーの99.9%が既にGPT-5.2へ移行済みだったとのことです。

GPT-4oの現在の利用方法

引退後もGPT-4oを利用できる手段は以下の通りです。

-

API経由

OpenAI APIではGPT-4oモデルが引き続き利用可能です。既存のアプリケーションやワークフローで使い続けることができます。

-

ChatGPT内の過去チャット

GPT-4oとのチャット履歴は残りますが、チャットを続ける場合はGPT-5.2に自動切り替えされます。

GPT-4o vs GPT-5.2 比較

以下の表で、GPT-4oと現在の標準モデルGPT-5.2の主な違いを整理しました。

| 項目 | GPT-4o | GPT-5.2 |

|---|---|---|

| システム構成 | 単一モデル | 統合システム(自動推論切替) |

| 応答速度 | 高速(平均320ms) | さらに高速・リアルタイム切替 |

| ハルシネーション | 改善済み | 45%大幅低減 |

| 専門分野性能 | 高い専門性 | 専門家レベルの知性 |

| 推論機能 | 基本的推論 | 組み込み思考機能・深い推論モード |

| 利用可能性 | API経由のみ | ChatGPTの標準モデル |

GPT-4oの高速な応答やマルチモーダル性能は、GPT-5.2に発展的に引き継がれています。API経由で引き続きGPT-4oを利用するケースもありますが、新規開発ではGPT-5.2への移行が推奨されます。

【関連記事】

GPT-5(ChatGPT-5)とは?主な特徴や使い方、料金など最新情報を解説!

ChatGPT-4o(GPT-4o)の料金

ChatGPT-4oは引退前、有料プランであるChatGPT Plusに加入する事で利用可能でした。

Plusプランに加入していないユーザーも回数制限付きで無料でGPT-4oを利用することが可能でした。現在、ChatGPT経由でGPT-4oを利用することはできませんが、API経由での利用は引き続き可能です。プランの違いについてはChatGPTの無料版と有料版の違いも参照してください。

【関連記事】

ChatGPT4とGPT-4oの料金、支払い方法を解説!無料で利用する方法も紹介!

ChatGPT-4oの画像生成機能の料金

ChatGPT-4oの画像生成機能は、無料プランおよび有料プラン(Plus・Team・Proプラン)のユーザーが利用可能でした。ChatGPTの画像生成の詳細はこちらの記事もご参照ください。

ただし、無料プランの場合はGPT4o自体の回数制限が有料プランに比べて低く設定されているため、ご注意ください。

【プラン別】利用可能なモデル

| モデル名 | 無料ユーザー | Plusユーザー |

|---|---|---|

| GPT-4o | ⚪︎ (制限あり) | ⚪︎ (3時間あたり80メッセージまで) |

| GPT-4 | × | ⚪︎ (3時間あたり40メッセージまで) |

| GPT-4.5 | × | ⚪︎(制限の回数明記なし) |

| GPT-4o mini | ⚪︎ (制限なし) | ⚪︎ (制限なし) |

| o1 | × | ⚪︎ (週50回まで) |

| o3-mini | ⚪︎ (回数制限の記載なし)¹ | ⚪︎ (1日150回まで) |

| o3-mini-high | × | ⚪︎ (1日50回まで) |

【プラン別】利用可能な拡張機能

| 機能名 | 無料ユーザー | Plusユーザー |

|---|---|---|

| ウェブ検索 | ⚪︎ | ⚪︎ |

| ファイルアップロード | △ (4o-miniでは利用不可) | ⚪︎ |

| データ分析 | △ (4o-miniでは利用不可) | ⚪ |

| キャンバス機能 | × | ⚪︎ |

| DALL-E (画像生成) | ⚪︎ | ⚪︎ (GPT-4o, GPT-4, GPT-4o mini, o3等で利用可) |

| 4o Image Generation (画像生成) | ⚪︎ | ⚪︎ |

| Sora (動画生成) | × | △ (月50回, 720p 5秒まで + 緩和措置あり) |

| 音声会話 (Voice) | ⚪︎ (標準および高度な機能、1日合計15分まで) | ⚪︎ (高度な機能、1日合計60分まで) |

| カスタム指示 | ⚪︎ (GPT-4o, GPT-4o mini, Voice等で利用可) | ⚪︎ (GPT-4o, GPT-4, GPT-4o mini, Voice等で利用可) |

| メモリ機能 | ⚪︎ (GPT-4o, GPT-4o mini, Voice等で利用可) | ⚪︎ (GPT-4o, GPT-4, GPT-4o mini, Voice等で利用可) |

| GPTsの作成 (カスタムGPT) | △(GPTsストアのみ利用可能) | ⚪︎ |

| GPT-4o with tasks | × | ⚪︎ (3時間あたり80回まで) |

| Deep Research | × | ⚪︎ (月10回まで) |

| Operator | × | × |

ChatGPT4o(GPT-4o)のAPI料金

OpenAI APIにおける、GPT-4oおよび関連モデルの料金一覧です。料金は100万トークンあたりの米ドル表記です。

Cached inputは利用可能な場合の割引料金を示します。

| モデル名 | 入力 (Input) / 1Mトークン | キャッシュ入力 (Cached input) / 1Mトークン | 出力 (Output) / 1Mトークン |

|---|---|---|---|

| gpt-4o | $2.50 | $1.25 | $10.00 |

| gpt-4o-audio-preview | $2.50 | - | $10.00 |

| gpt-4o-realtime-preview | $5.00 | $2.50 | $20.00 |

| gpt-4o-mini | $0.15 | $0.075 | $0.60 |

| gpt-4o-mini-audio-preview | $0.15 | - | $0.60 |

| gpt-4o-mini-realtime-preview | $0.60 | $0.30 | $2.40 |

| gpt-4o-mini-search-preview | $0.15 | - | $0.60 |

| gpt-4o-search-preview | $2.50 | - | $10.00 |

| GPT-4o API 料金とGPT-4-turboの料金比較 |

ChatGPT 4o(GPT-4o)の使い方

引退前は、ChatGPTのブラウザに訪れることで利用が可能でした。

有料版・無料版・スマホ版それぞれで切り替え方法が異なっていました。

GPT-4oの有料版(ChatGPT Plus)での使い方

左上のモデル選択の部分からGPT-4oをクリックしてください。

GPT4oの選択方法

従来のChatGPTの使い方通りに利用することが可能です。

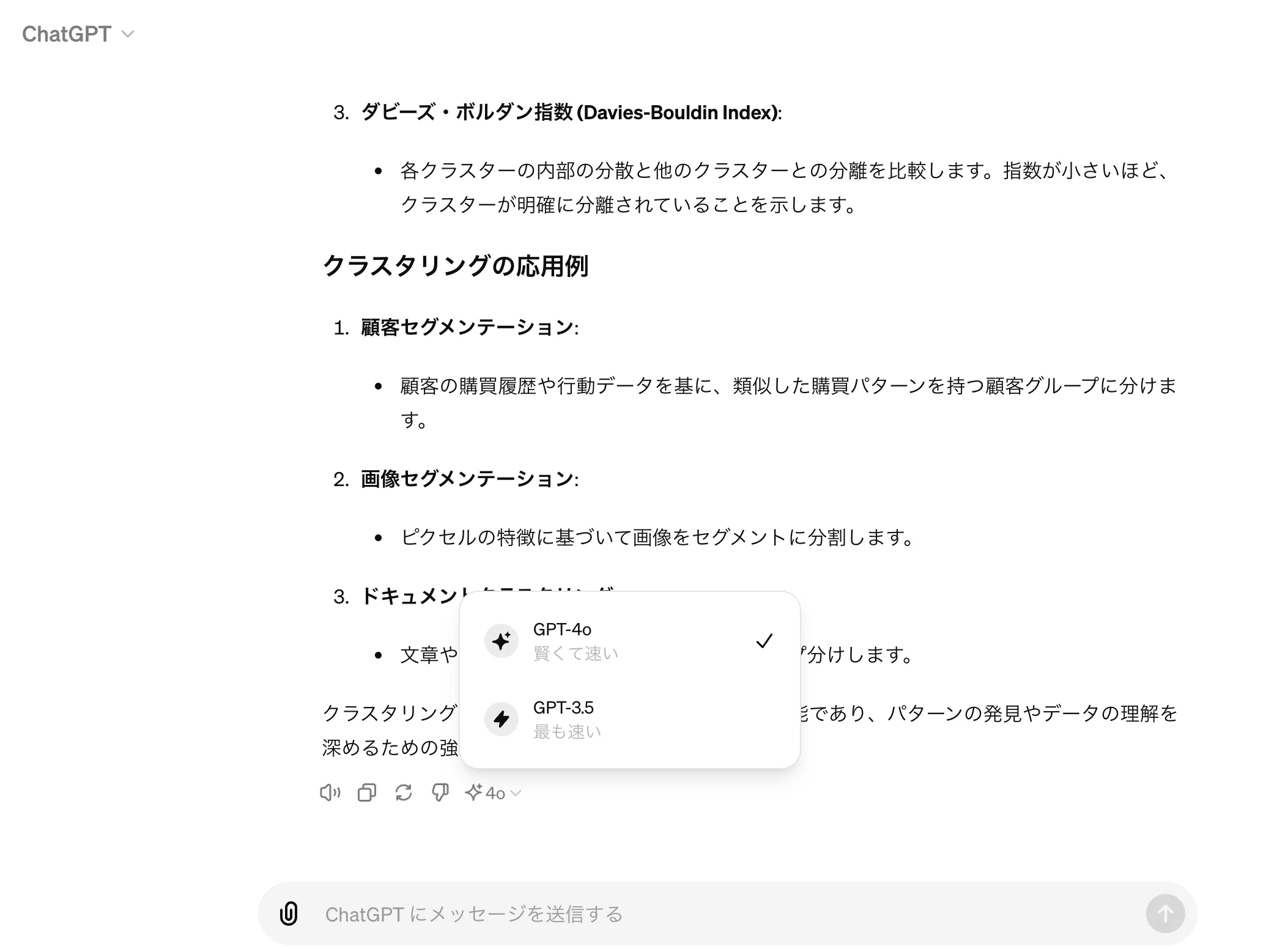

GPT-4oの無料版での使い方

ChatGPT Plusに未加入のユーザーでも、一定の利用回数まではGPT-4oを使用できました。

GPT4oとGPT-3.5の切り替えが可能(引退前の画面)

GPT-4oのアプリでの使い方

ChatGPTスマホアプリの場合も、有料版と無料版でそれぞれ切り替え方法が異なります。

有料版の場合

ChatGPTとのトーク画面上部の、「ChatGPT 〇〇(モデル名)」の箇所をタップすると、モデルの切り替えが可能です。

無料版の場合

- ChatGPTトーク画面で何かしらメッセージを送り、ChatGPTの回答を長押しします。

- すると、GPT-4oとGPT-3.5のいずれかを選択可能でした(引退前の画面)。

デスクトップアプリでの使い方

ChatGPTのデスクトップアプリは、ChatGPTの公式サイトからインストール可能です。macOS版・Windows版ともに提供されています。

AzureでのGPT-4o利用方法

Azure OpenAI Serviceでは、GPT-4oモデルをデプロイして利用できます。Azure OpenAI Studioまたは Azure AI Foundryからアクセス可能です。

Japan East(東日本)リージョンを含む複数のリージョンで利用可能となっており、企業向けのセキュリティ・コンプライアンス要件を満たした環境でGPT-4oを運用できます。詳しくはAzure OpenAI Serviceとは?をご覧ください。

【 GPT-4o の発表:Azure 上でプレビュー開始】#OpenAI の新しいフラッグシップモデルである GPT-4o が、 #Azure #AI 上から利用できることを嬉しく思います。このマルチモーダルモデルは、テキスト、視覚、音声の機能を統合し、次世代の #生成AI 体験をもたらします。https://t.co/9Zsd5IcjyD

— 日本マイクロソフト株式会社 (@mskkpr) May 14, 2024

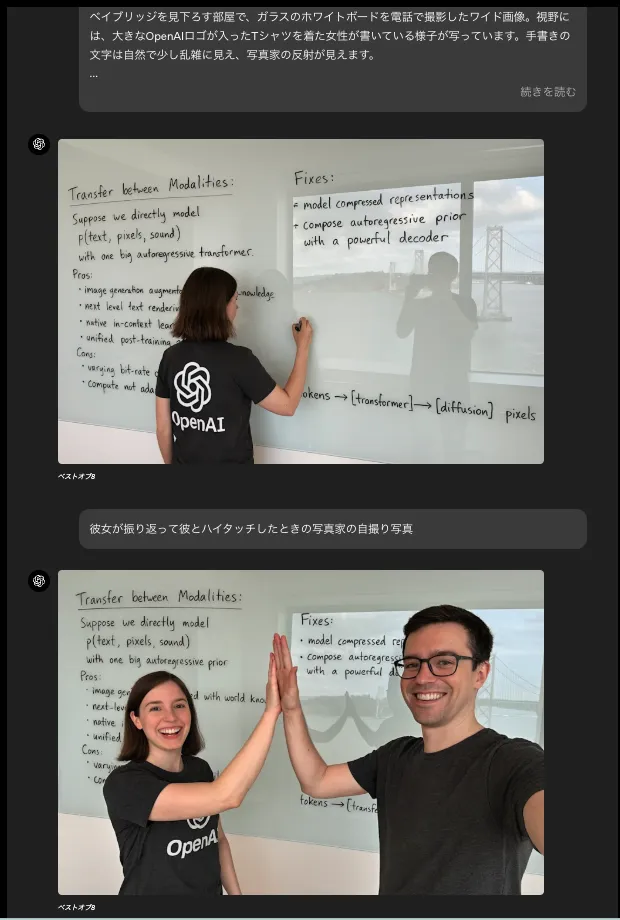

ChatGPT-4oで画像生成が可能に

2025年3月、OpenAIはChatGPT-4oに画像生成機能を統合したことを発表しました。これにより、テキスト生成と画像生成が同一モデル内で実現され、より自然な対話を通じて高品質な画像を作成できるようになりました。

画像の作成とカスタマイズは、GPT-4oを使った通常の会話と同じように行えます。「縦横比3:2で」「#FF0000の赤色を使って」「背景を透明にして」などの詳細を指定するだけで、詳細な画像が生成されます。

ただし、詳細な画像を作成するため、表示されるまでに最大1分程度かかる場合があります。

2025年3月の発表当初はPlus、Pro、Team、Freeユーザー向けに順次展開され、その後Enterprise、Edu、API経由でも利用可能となりました。現在はGPT-5.2に統合された形で、ChatGPTの標準的な画像生成機能として引き続き利用できます。

画像生成機能の主な特徴

ChatGPT-4oの画像生成機能は、幻想的なアート作品のような装飾的な画像だけでなく、ビジネスや日常で実際に使える実用的な画像(図表、説明図、テキスト入りの画像など)の作成に特に力を入れています。

【関連記事】

詳しくはこちらの記事をご覧ください。

ChatGPT4o(GPT-4o)の画像生成とは?使い方や料金、プロンプトを解説! | AI総合研究所

ChatGPT-4o(GPT-4o)の画像生成の使い方や料金、プロンプトを解説。商用利用時の注意点、使い方の実例、Stable Diffusion違いまで網羅します。

https://www.ai-souken.com/article/what-is-gpt4o-image-generation

- テキストレンダリング

画像内のテキストを正確に描画する能力に優れており、メニュー、看板、招待状など、文字を含む画像の生成が可能です。

- マルチターン生成

自然な会話を通じて画像を段階的に改良できます。例えば、「帽子を追加して」「背景を変えて」というように対話しながら画像を調整できます。

参考:OpenAI

- 指示への正確な対応

複雑な指示にも正確に従い、「右上に青い星、左下に赤い三角形」のように複数の要素を含む詳細なシーンを作成できます。

従来のAIが5-8個の物体を扱うのに苦労する中、GPT-4oは10-20の異なる物体も適切に配置できます。

参考:OpenAI

- 既存画像からの学習

ユーザーがアップロードした画像を分析し、その特徴を新しい画像生成に活かすことができます(例:アップロードした車の画像を参考に三角形の車輪を持つ新しい車のデザインを作成)。

以下は、チェーンソーの画像をまず作成し、生成されたチェーンソーの画像を新しい画像に組み込んだ例です。

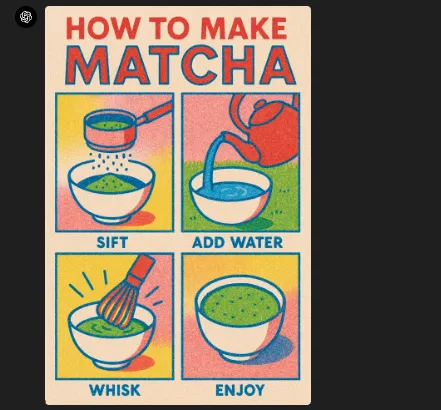

- 幅広い知識の活用

モデルの持つ知識を画像生成に反映できるため、レシピや図解など、正確な情報を含む画像を作成可能です。

- 様々な画像スタイル

リアルな写真からイラスト、水彩画風、漫画風まで、多様な表現スタイルに対応しています。

ChatGPT-4oの画像生成機能については、こちらの記事で詳しく解説しています。ぜひご覧ください。

【関連記事】

GPT-4oの画像生成とは?使い方・プロンプト例・商用利用・他AIとの違いも紹介

制限事項

現時点でのChatGPT-4o画像生成機能には、以下のような制限があります。

- 長い画像(ポスターなど)を生成する際に下部が切れることがある

- 詳細な指示がない場合に、AIが勝手に情報を作り出す(ハルシネーション)ことがある

- 一度に多数の概念(例:周期表のすべての元素)を含む画像の正確な生成が難しい

- 日本語や中国語などの非英語圏の文字の正確な描画に課題がある

- 「左上の文字だけ修正して」などの部分編集の精度に限界がある

- 小さなサイズの詳細情報を多く含む画像の描画が苦手

GPT-4oの画像生成機能の使い方

画像生成機能の使い方については、こちらの記事で詳しく解説しています。ぜひご覧ください。

【関連記事】

GPT-4oの画像生成とは?ChatGPTの使い方・プロンプト例・商用利用・他AIとの違いも紹介

ChatGPT4oアップデートの特長

OpenAIは、新たなモデルであるGPT-4oを発表しました。このモデルは テキスト、音声、画像の入力をリアルタイムで処理 し、出力も生成できる次世代のAIです。

全ての入力と出力を同じニューラルネットワークで処理するため、情報の損失が少なく、より自然なインタラクションが可能です。

音声会話・音声入力機能の改良

以前の音声モードは音声をテキストに変換し、再び音声に変換するプロセスを3つのモデルで行っていました。

GPT-4oではこれが単一のモデルで行われるため、情報の損失が減少し、音声のトーンや背景音も含めた高度な処理が可能となります。

Say hello to GPT-4o, our new flagship model which can reason across audio, vision, and text in real time: https://t.co/MYHZB79UqN

— OpenAI (@OpenAI) May 13, 2024

Text and image input rolling out today in API and ChatGPT with voice and video in the coming weeks. pic.twitter.com/uuthKZyzYx

このXのツイートは、OenAIが今回のアップデートを模擬した動画です。

リアルタイムでの返事や、感情表現などその性能がおわかりになるかと思います。

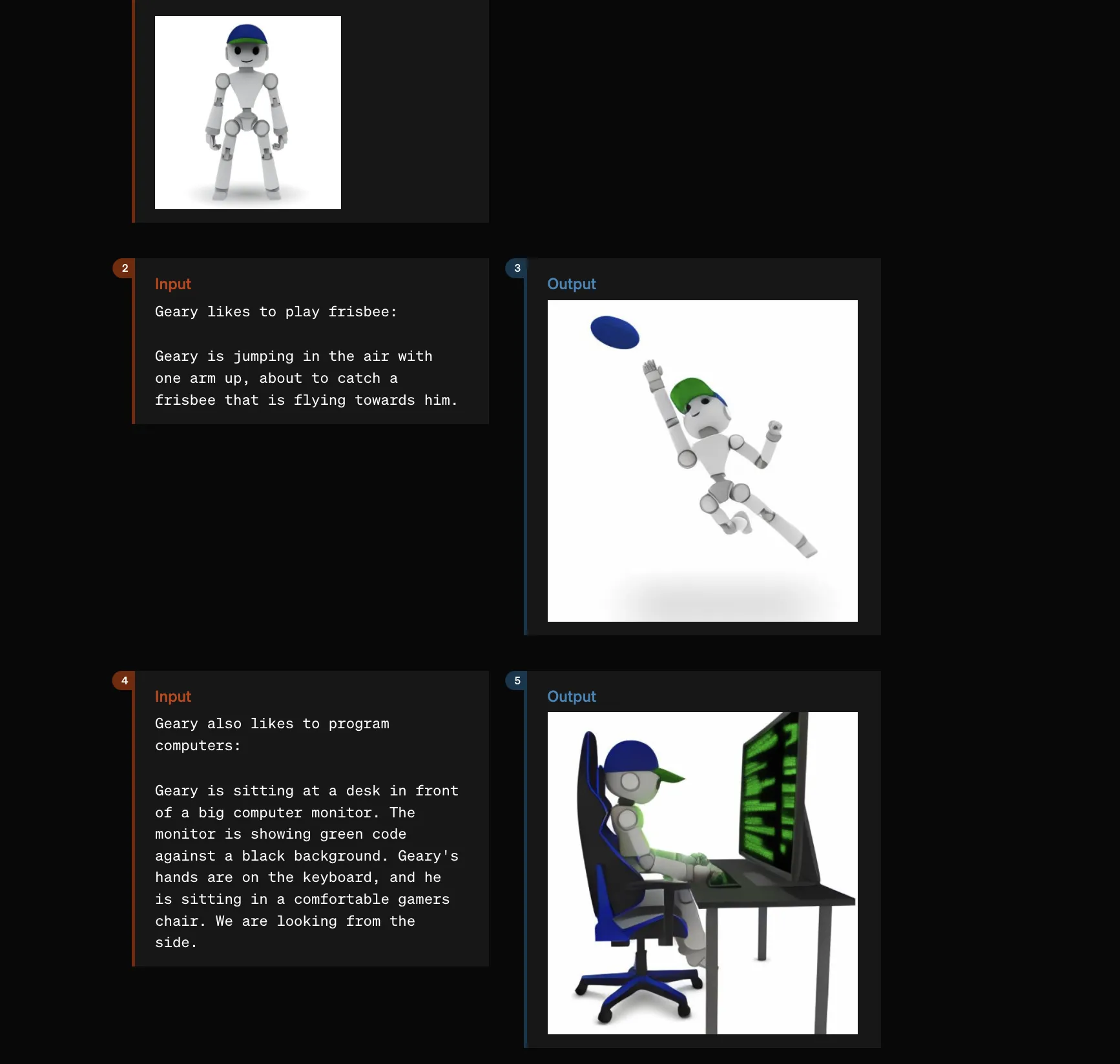

画像生成の機能向上

GPT-4oは画像生成機能が大幅に向上しており、視覚的なストーリー生成にも対応しています。

従来の画像生成では、生成した画像に一貫性を持たせることが難しく、画像が崩壊してしまうことも多々ありました。

今回のアップデートにより一貫性が大幅に改善されています。

例えば、「ロボットがタイプライターで日記を記す様子」など、多様なビジュアルコンテンツを生成できます。

これにより、豊かな表現力を持つAIが実現されました。

表示物の一貫性を保った画像の生成

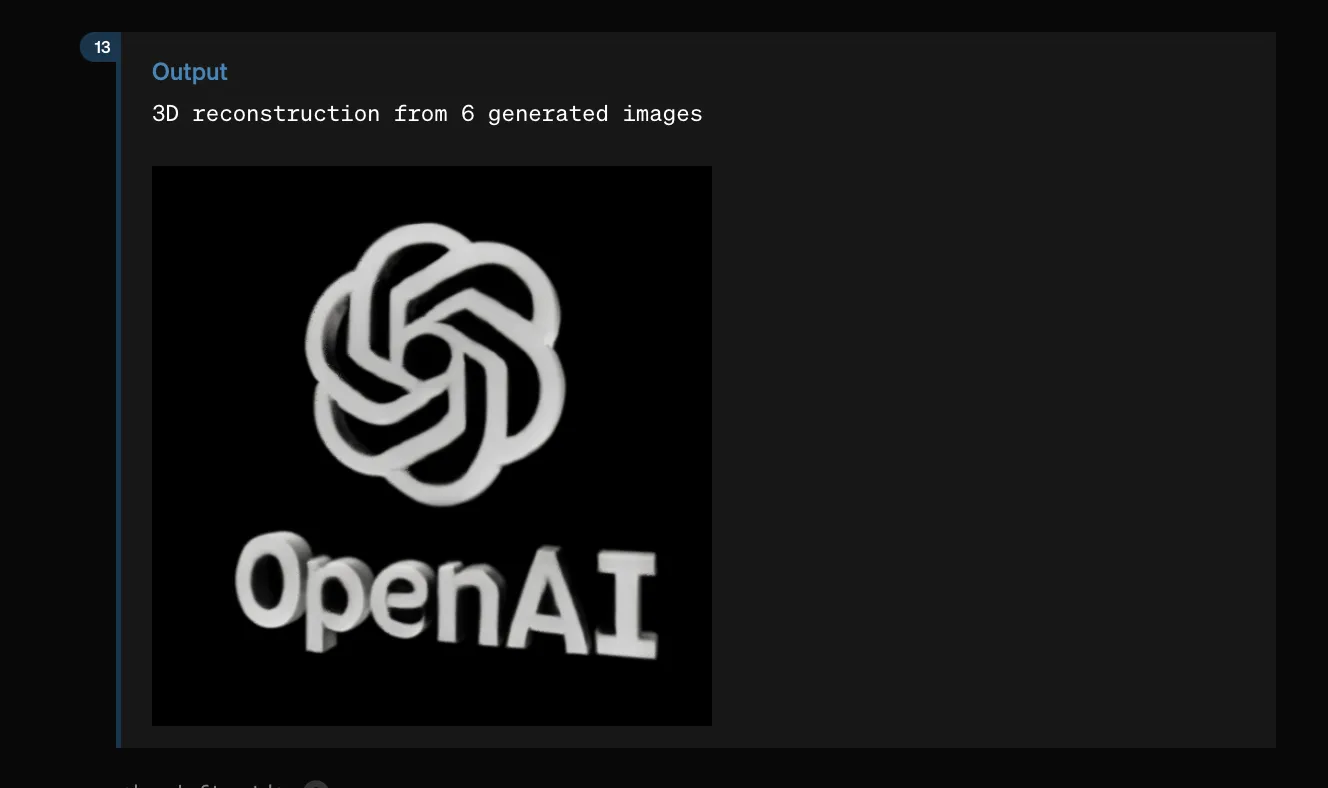

3Dの画像、およびそれが回転する動画の生成ができることも述べられています。

3Dの動画生成の画像

GPT-4oのモデル評価と性能

GPT-4oは、テキスト、音声、ビジョンの各分野で優れたパフォーマンスを発揮しており、その性能について数値的にも示しています。

特に音声認識や翻訳、視覚理解の分野で高い評価を受けています。

音声認識性能が大幅に向上し、低リソース言語でも高い精度を実現しました。マルチリンガルな評価でもGPT-4を上回る結果を示しています。

| 評価項目 | GPT-4oの性能 |

|---|---|

| テキスト処理 | GPT-4 Turboと同等、マルチリンガルで優れた性能 |

| 音声認識 | Whisper-v3を上回る性能、低リソース言語でも高精度 |

| 音声翻訳 | 最先端の性能、MLSベンチマークでWhisper-v3を上回る |

| 視覚理解 | 0-shot評価で高い性能、MathVistaやChartQAで優れた結果 |

回答速度においても非常に速い回答ができるようになっています。

こちらはX(旧Twitterで)投稿されたGPT-4oの回答速度を載せられた投稿ですが、回答スピードに驚きの声が多く寄せられています。

ChatGPT4o、爆速すぎて笑ってる。この速度でこの性能とか他の追随を許さない感じすごい pic.twitter.com/fxnpyzWeBD

— あるふ (@alfredplpl) May 13, 2024

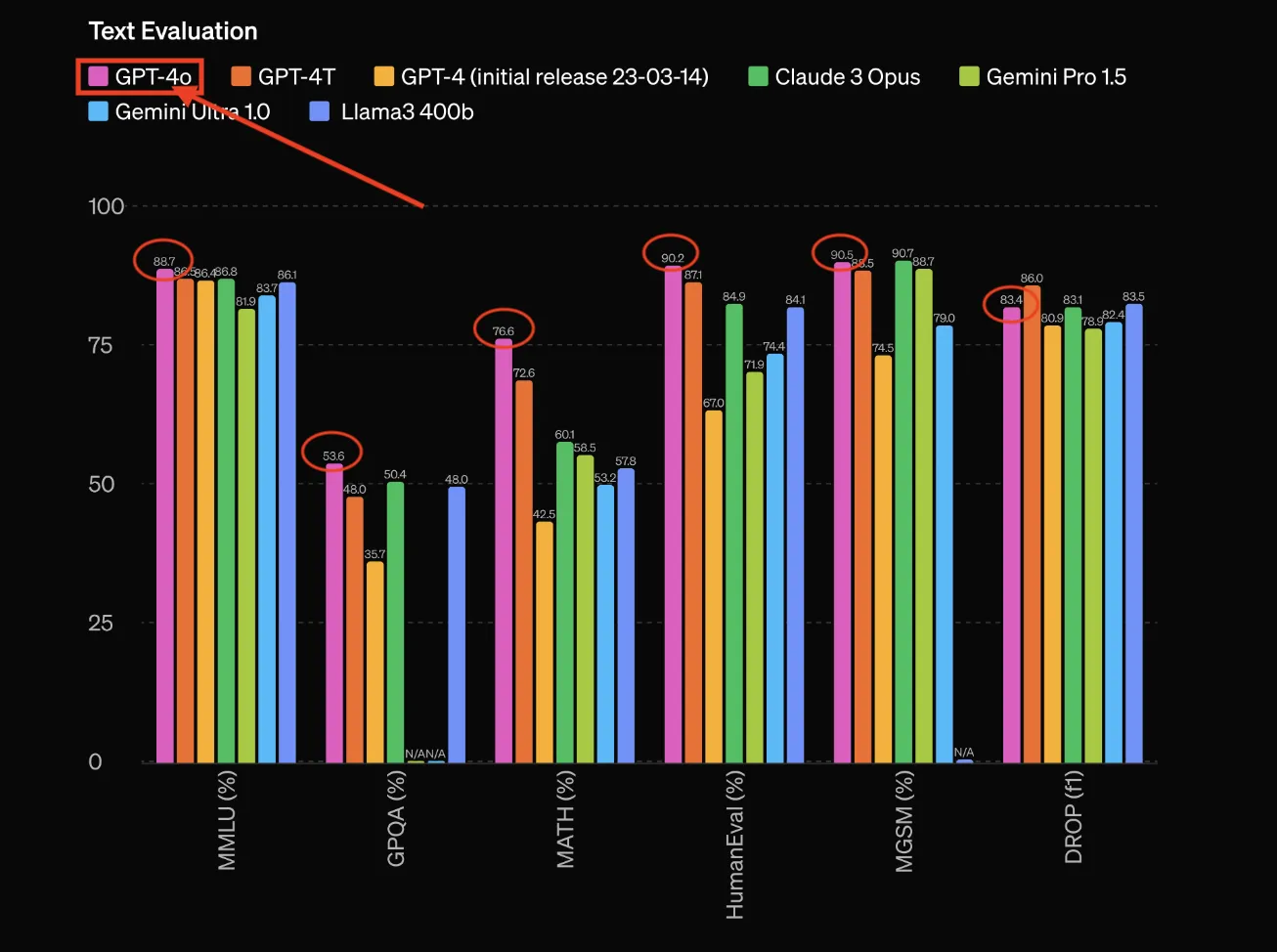

テキスト評価

テキスト性能でも大きくGPT-4oの性能の良さについて評価されています。

| 項目 | GPT-4o | GPT-4T | GPT-4(初期リリース 23-03-14) | Claude 3 Opus | Gemini Pro 1.5 | Gemini Ultra 1.0 | Llama3 400b |

|---|---|---|---|---|---|---|---|

| MMLU (%) | 88.7 | 86.8 | 85.6 | 85.8 | 86.1 | 81.9 | 86.1 |

| GPCQA (%) | 53.6 | 48.0 | 50.4 | N/A | 48.0 | 35.7 | N/A |

| MATH (%) | 76.6 | 72.6 | 60.1 | 58.5 | 57.8 | 42.5 | 53.2 |

| HumanEval (%) | 90.2 | 87.1 | 84.9 | 84.1 | 71.9 | 74.4 | 67.0 |

| MGSM (%) | 90.5 | 88.7 | 90.7 | 79.0 | 80.9 | 74.5 | 82.4 |

| DROP (f1) | 86.0 | 83.4 | 83.1 | 83.5 | 81.8 | 78.2 | 82.4 |

テキスト性能の評価グラフ

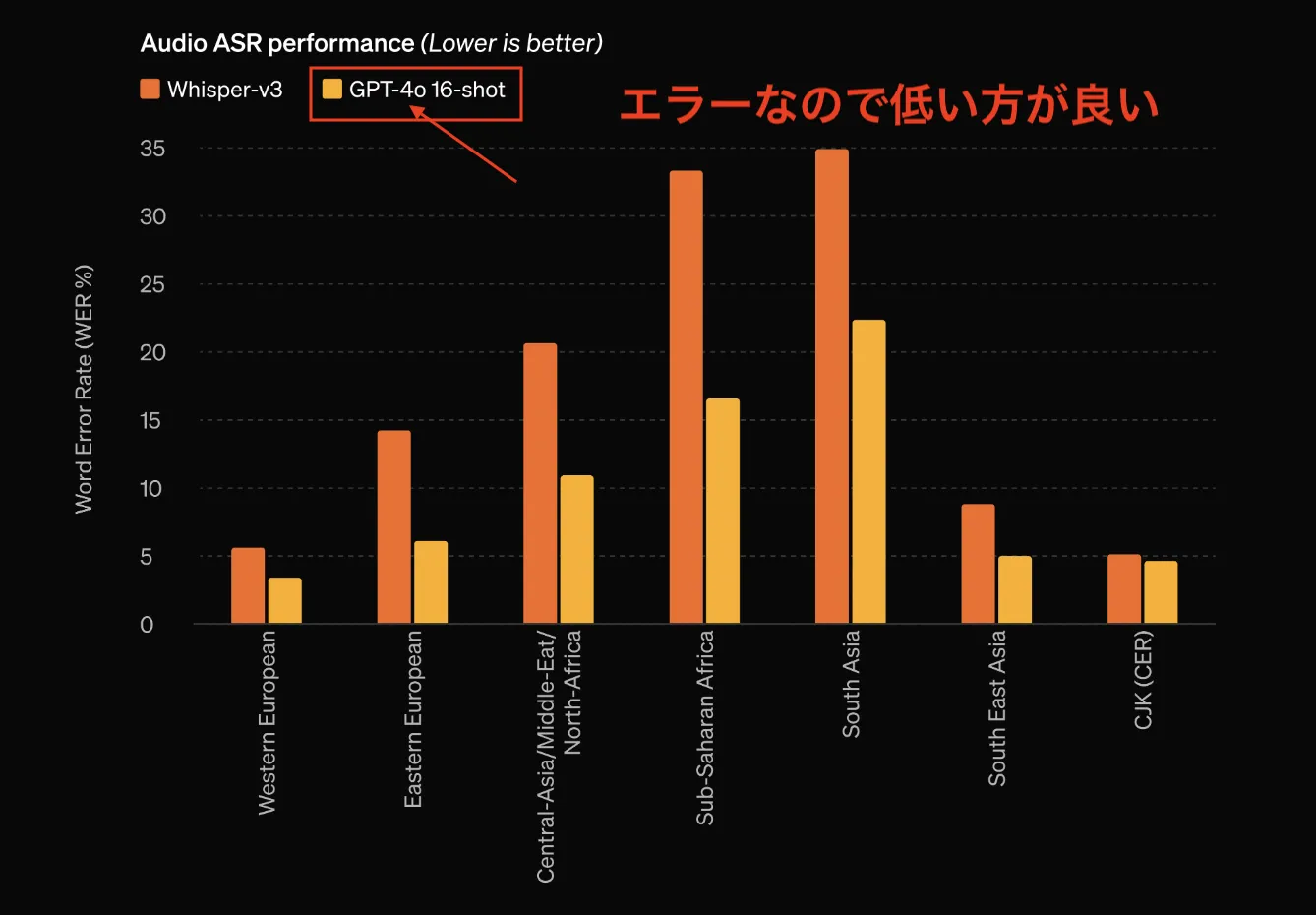

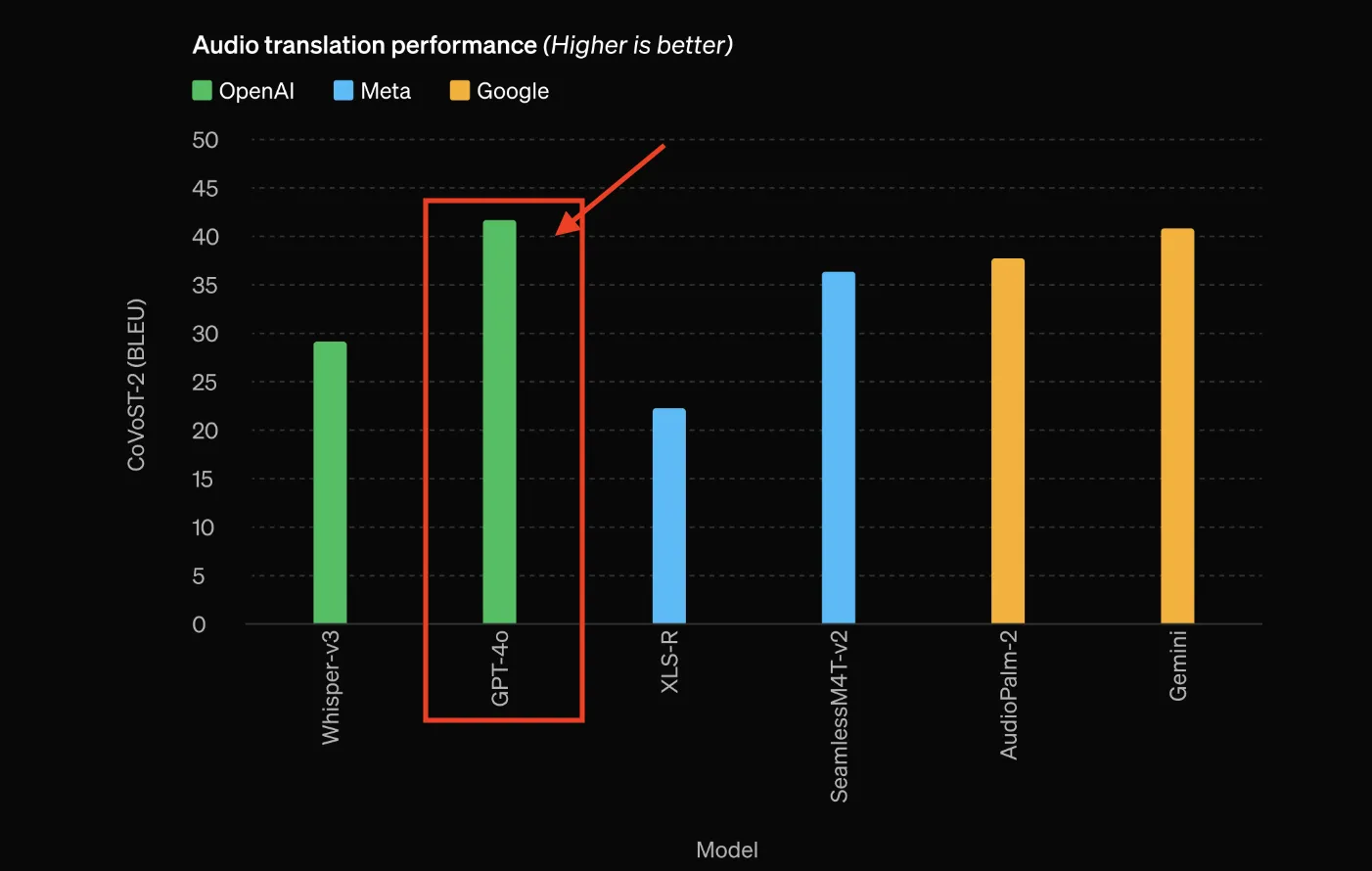

音声認識と翻訳

音声認識(ASR)の性能と翻訳精度を示しています。

音声認識の評価はWord Error Rate(WER%)を用いており、値が低いほど性能が優れています。比較されているモデルはWhisper-v3とGPT-4o(16-shot)です。

音声翻訳の方は高いほど精度が優れており、Geminiを超える翻訳精度であることが示されています。

| 地域 | Whisper-v3 WER(%) | GPT-4o 16-shot WER(%) |

|---|---|---|

| 西ヨーロッパ | 約5.5 | 約4.5 |

| 東ヨーロッパ | 約11 | 約6 |

| 中央アジア/中東/北アフリカ | 約20 | 約14 |

| サハラ以南のアフリカ | 約30 | 約22 |

| 南アジア | 約34 | 約27 |

| 東南アジア | 約9 | 約6.5 |

| CJK(中国語、日本語、韓国語) | 約7 | 約5.5 |

音声認識(ASR)の性能のグラフ

音声翻訳性能のグラフ

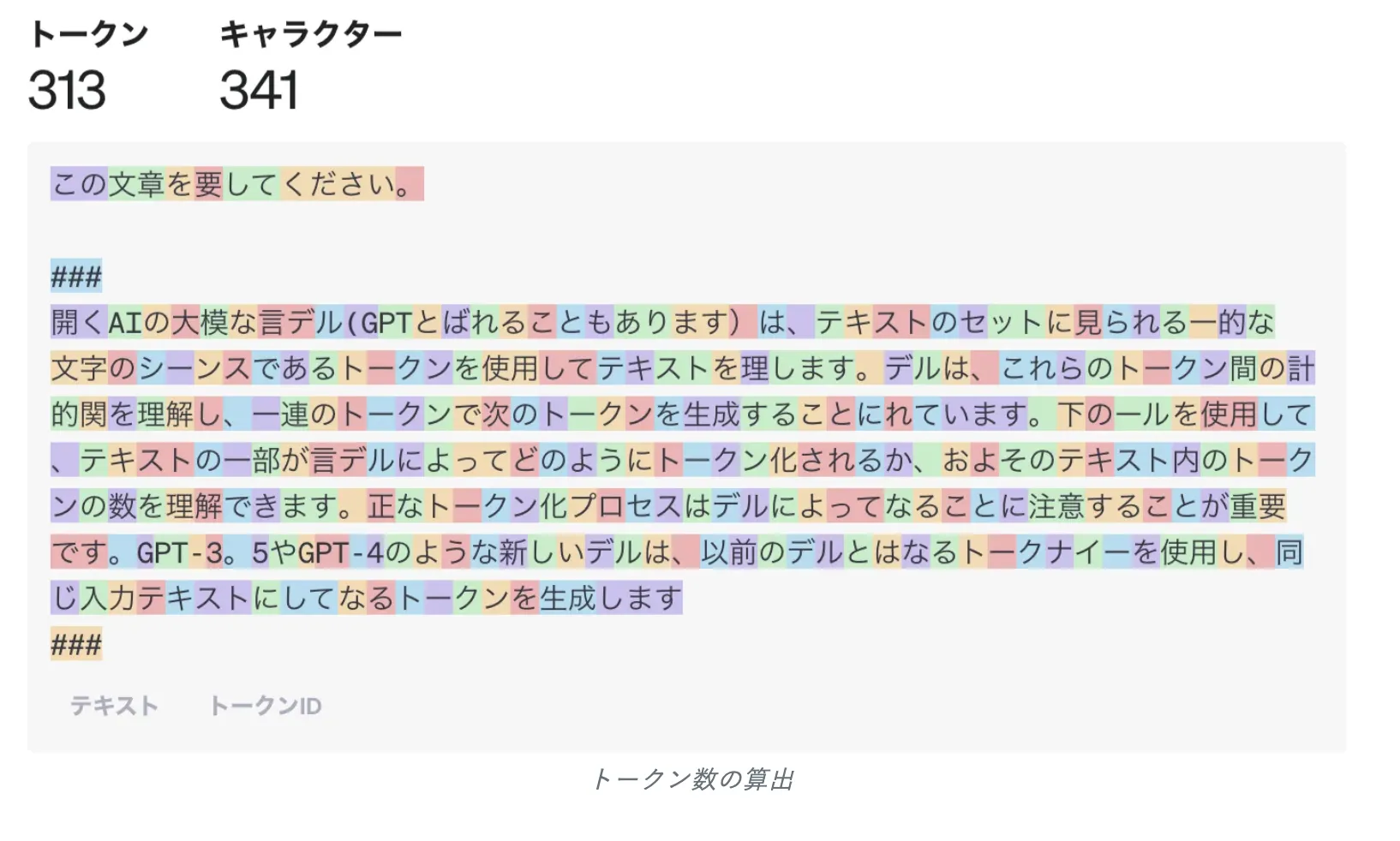

新しいトークナイザー

トークン計算イメージ画像

新しいトークナイザーは、複数の言語でトークン数を大幅に削減し、より効率的なテキスト処理を可能にします。

これにより、多言語対応が強化され、様々な言語での使用が容易になりました。

日本語もトークン数は削減されています。また、日本語以外の言語でも大きくトークン効率が良くなっていることがわかります。

| 言語 | トークン数削減比率 | 例文 |

|---|---|---|

| 日本語 | 1.4倍 | こんにちわ、私の名前はGPT−4oです。私は新しいタイプの言語モデルです、初めまして。 |

| グジャラート語 | 4.4倍 | હેલો, મારું નામ GPT-4o છે। |

| テルグ語 | 3.5倍 | నమస్కారము, నా పేరు GPT-4o. |

| タミル語 | 3.3倍 | வணக்கம், என் பெயர் GPT-4o. |

| マラーティー語 | 2.9倍 | नमस्कार, माझे नाव GPT-4o आहे। |

| ヒンディー語 | 2.9倍 | नमस्ते, मेरा नाम GPT-4o है। |

他多数の言語もトークン数が削減されています。

【関連記事】

トークン数についての説明は、こちらの記事をご覧ください。

【関連記事】

ChatGPT APIの料金は?モデル別の比較や費用を抑えるコツを解説

画像の視覚認識

様々なAIモデルの視覚認識における性能を評価した結果を示しています。

各評価セットのテスト結果はパーセンテージで示されており、高い数値ほど良い性能を意味します。

GPT-4oの精度の高さがよくわかります。

| Eval Sets | GPT-4o | GPT-4T 2024-04-09 | Gemini 1.0 Ultra | Gemini 1.5 Pro | Claude Opus |

|---|---|---|---|---|---|

| MMMU (%) (val) | 69.1 | 63.1 | 59.4 | 58.5 | 59.4 |

| MathVista (%) (testmini) | 63.8 | 58.1 | 53.0 | 52.1 | 50.5 |

| AI2D (%) (test) | 94.2 | 89.4 | 79.5 | 80.3 | 88.1 |

| ChartQA (%) (test) | 85.7 | 78.1 | 80.8 | 81.3 | 80.8 |

| DocVQA (%) (test) | 92.8 | 87.2 | 90.9 | 86.5 | 89.3 |

| ActivityNet (%) (test) | 61.9 | 59.5 | 52.2 | 56.7 | 56.7 |

| EgoSchema (%) (test) | 72.2 | 63.9 | 61.5 | 63.2 | 63.2 |

ChatGPT4o(GPT-4o)でできること

Google Drive・OneDriveとの連携

ChatGPTは、クラウドストレージサービスであるGoogle DriveとMicrosoft OneDriveと直接連携できるようになりました。

これらのサービスに保存されているスプレッドシート、ドキュメント、プレゼンテーションファイルを、ChatGPTに直接アップロードして分析することができます。

<<ChatGPTでデータ分析、データ入力の連携がスムーズに>>

— 坂本将磨@AI総合研究所 (@LinkX_group) May 17, 2024

ドライブとの接続がスムーズで、ユーザ体験としてはめちゃくちゃ良いのでは。

個人的な利用用途としては、これでデータ分析を完結させるというより初期分析として活用すると生産性が向上する。… pic.twitter.com/SjZROEvdua

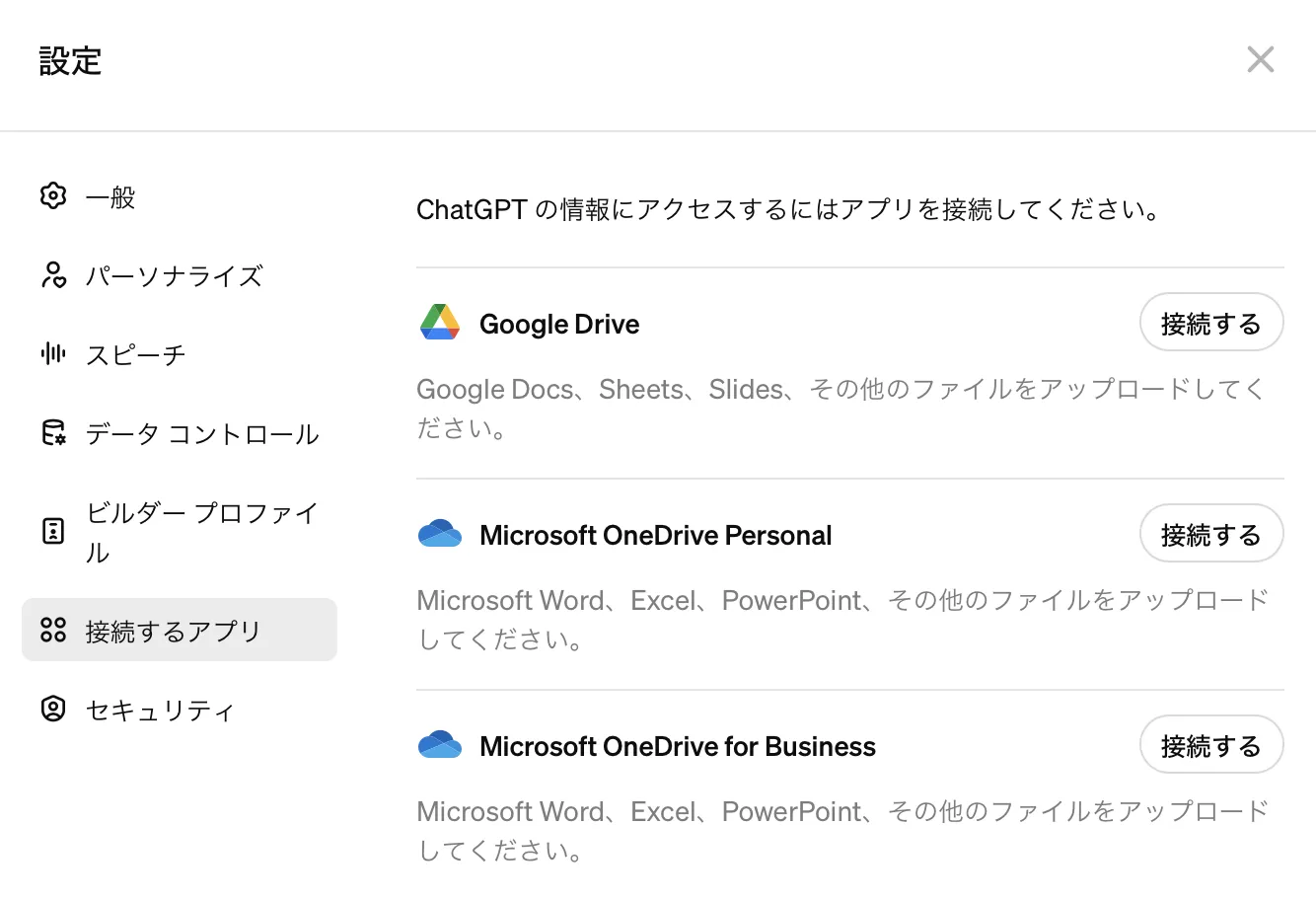

実際の手順

- ChatGPTの会話画面のアイコンをクリックし、「設定」を押します。

- 「接続するアプリ」を選択すると、次の様な画面が表示されます。

ここで、連携したいストレージアプリを選択してください。

接続先の選択

- 「接続する」を選択すると、以下の様な確認画面に遷移するので、続行を選択します。

接続確認

4. チャット画面のクリップマーク(画像矢印)を選択し、連携したアプリが表示されていれば設定完了です。

ファイルアップロードのボタン

リアルタイム翻訳

OpenAI demos real-time language translation with its latest GPT-4o model. pic.twitter.com/pXtHQ9mKGc

— TechCrunch (@TechCrunch) May 13, 2024

画像から作品の詳細を提供

GPT-4o凄いな、速いだけじゃなくて賢い。

— AIセバスちゃん (@SebasAi) May 14, 2024

1枚目 GPT-4

2枚目 GPT-4o

なんで分かるんだよ。まじかよ pic.twitter.com/2mJsujYk9c

ロゴの画像認識(OCR)

GPT-4o、OCR性能もえぐい‥‥この人間でも認識困難なAIカオスマップの内容を永遠に吐き出してくる pic.twitter.com/0DumgrPYFv

— 石川陽太 Yota Ishikawa (@ytiskw) May 13, 2024

データ分析

#GPT4o のデータ分析能力が凄い!

— IT navi (@itnavi2022) May 14, 2024

データを渡しただけで、一瞬で色々分析してくれる。 pic.twitter.com/n7m46F9nNe

手書きの画像から図を作成

スライド作成は人間の仕事ではなくなりそう…

— あやみ|マーケティング (@ayami_marketing) May 14, 2024

GPT-4oで、画像→図表作成→PowerPoint出力ができた!

(手書きが汚すぎるけど、ちゃんと書いたらそれなりにいけそう!) pic.twitter.com/nvnJWefsYh

グラフの作成

GPT-4oのデータビジュアライゼーションの機能が素晴らしい!

— KEITO💻AIディレクター (@keitowebai) May 23, 2024

基本的な使い方

CSVなどのファイルを送って「グラフを作成してください」と言えば良い感じのグラフを作成してくれる。その前に「このデータに最適なグラフを教えて下さい」と言うとこちらからある程度求めていたものを指定出来る。… pic.twitter.com/pdl5VI51IY

GPT-4oのセキュリティについて

GPT-4oは、安全性を重視して設計されています。トレーニングデータのフィルタリングやモデルの行動の調整を通じて、安全性を確保しています。

また、外部の専門家によるリスク評価も行われており、モデルの安全性が高められていることが述べられています。

要約すると以下のように記載されています。

GPT-4oは、訓練データのフィルタリングや事後訓練で安全性を高め、音声出力に対する新しい安全システムを構築しました。評価では、サイバーセキュリティや自律性などのカテゴリーで「中」以上のリスクはありません。

70人以上の外部専門家と協力し、リスクを特定・軽減しました。

現在はテキストと画像の入力、テキスト出力を公開しており、数週間から数ヶ月以内に音声入力とテキスト出力も公開予定です。

急速に進化するAIとともに安全上のリスクと対策も進化していく必要があります。利用する側もリテラシーを持った対応が必要とされるでしょう。

【関連記事】

ChatGPTのセキュリティリスクとは?実際の事例を踏まえて対策を解説

AI導入でお悩みの方へ

まとめ

本記事では、ChatGPT-4o(GPT-4o)の主要機能、料金体系、使い方、そして後継モデルとの関係について解説しました。

GPT-4oは2024年の発表当時、テキスト・画像・音声を統合的に処理するマルチモーダルAIとして画期的なモデルでした。従来のGPT-4 Turboと比較して2倍の速度・半分のコストを実現し、日本語を含む多言語性能の大幅向上やネイティブ画像生成機能の搭載など、AI活用の可能性を大きく広げました。

2026年2月13日をもってChatGPTのUI上からは引退しましたが、その技術はGPT-5.2に発展的に引き継がれています。APIでは引き続きGPT-4oを利用可能であり、既存のワークフローやアプリケーションで活用を続けることもできます。新規開発の場合は、後継のGPT-5.2への移行が推奨されます。