この記事のポイント

Microsoft Fabricは、データの収集・加工・保管・分析・可視化までを一気通貫で担うオールインワンの分析プラットフォーム

OneLakeという統合データレイクを中心に、Data Engineering/Data Warehouse/Real-Time Intelligence/Power BIなどのワークロードが連携して動作

CopilotをはじめとするAI機能により、クエリ作成やレポート作成、データクレンジングなどを自然言語ベースで支援

Fabric固有のセキュリティ・ガバナンス機能とMicrosoft Purview連携により、エンタープライズ向けの統制・コンプライアンスにも対応

AI総合研究所によるMicrosoft Fabric導入支援で、PoCから本番運用・社内展開まで一気通貫でサポート

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

ビジネスにおいてデータ分析の重要性が高まる中、企業が抱える課題は「大量のデータを効率的に分析し、迅速な意思決定につなげること」です。

この課題を解決するために開発されたのが、Microsoftの統合データ分析ツール「Microsoft Fabric」です。

本記事では、Microsoft Fabricの特徴や機能、構成要素、価格体系、セキュリティ・ガバナンス、代表的な導入事例について詳しく解説し、このツールがいかにしてビジネスにおけるデータ分析・AI活用の効率化と高度化を実現するのかを明らかにします。

データ活用に悩む企業にとって、Microsoft Fabricの理解を深め、導入の一助となることを期待しております。

なお、AI総合研究所ではMicrosoft Fabricの導入支援を行っており、ビジネスのデータ活用力強化をサポートしています。

無料相談も承っておりますので、お気軽にお問い合わせください。

➡️【AI総合研究所】お問い合わせページ

※本記事の内容は、2026年1月時点で公開されている情報をもとにしています。料金や機能は今後変更される可能性があるため、最新情報は公式ドキュメントもあわせてご確認ください。

目次

Power BI / Synapse / Data Factoryとの違い・位置づけ

「ワークロード」「OneLake」「Capacity」で理解するFabric

Fabric Capacityとワークスペース/アイテムの関係

Data Factory:データ統合・ETL/ELTパイプライン

Data Engineering:Spark/Notebookによる加工・前処理

Data Warehouse / SQL:DWH・業務指標の土台

Real-Time Intelligence:ログ・イベントのリアルタイム分析

One Copyの考え方とDelta / Parquet形式

Mirroringによる運用DB・外部DBからの継続取り込み

Copilotでできること(クエリ・レポート・パイプライン生成など)

Data Agent / AI Functionsなど周辺AI機能の位置づけ

課金の全体像:Fabric Capacity + OneLake Storage + ライセンス

Fabric Capacity(F SKU)のラインナップと選び方の目安

OneLake Storageの課金イメージ(保存・バックアップ・キャッシュ)

1. ワークスペースとLakehouse / Warehouseを用意する

2. データを取り込む(Get data / Data Factory)

4. Power BIでレポート化し、Teamsなどに共有する

Shared Responsibility Model(責任分界)の整理

ID/アクセス管理とロール設計(Entra ID・RLS/CLS/OLSなど)

ネットワーク制御:Managed VNet / Private Endpoint等の考え方

Microsoft Purviewとの連携でできること(カタログ・リネージ・ポリシー)

Microsoft Fabricに関するよくある質問(FAQ)

Q. Fabricと従来のSynapse / Power BI単体はどう違いますか?

Q. 小規模・スモールスタートでも導入メリットはありますか?

Q. どの程度のデータ量・組織規模から検討するとよいですか?

Q. 既存のDWHやデータレイクとどう共存させればよいですか?

Q. CopilotなしでFabricだけ導入することは可能ですか?

<<<<<<< HEAD

666c08e9c (commit)

Microsoft Fabricとは

Microsoft Fabricは、マイクロソフトが提供する統合データ&AIプラットフォームです。

データの収集・蓄積・加工・分析・可視化までを、一つのSaaS(クラウドサービス)上で完結できるように設計されています。

従来は「ETLはAzure Data Factory」「DWHはSynapse Analytics」「可視化はPower BI」のように、複数サービスを組み合わせて設計する必要がありました。

Fabricでは、これらの役割を**共通のデータレイク「OneLake」と共通の容量(Capacity)**の上でまとめて扱えるため、「どのサービスを選ぶか」よりも「どう活用するか」に集中しやすくなります。

Microsoft Fabric

Microsoft Fabricの概要

ここでは、まずMicrosoft Fabricの全体像をかんたんに整理します。

あとから出てくる詳細な構成要素を理解しやすくするための「ざっくりしたイメージ」として読んでみてください。

Fabricを一言で表すと、次のようなサービスです。

- 組織全体のデータをOneLakeという一つの論理的なデータレイクで管理する。

- データ統合・DWH・データサイエンス・リアルタイム分析・BIなど、主要な分析ワークロードを1つのSaaS体験で提供する。

- その上にCopilot(生成AI)や機械学習機能を重ね、データ活用を支援する。

Azureの細かいインフラ(リソースグループやVM、ストレージアカウントなど)を意識せず、「データ基盤+BI+AI」までをSaaSとしてまとめて使える点が大きな特徴です。

Fabricが解決したい課題

Microsoft Fabricは、従来のデータ基盤でよく見られた次のような課題を意識して設計されています。

- データ統合/DWH/BIが別々のサービス・チームで運用され、構成が複雑になりやすい。

- 分析用途ごとにデータをコピーし、同じデータが何度も複製されて管理コストが増大する。

- リアルタイム分析や生成AIの活用をしようとしても、データ側の整備に時間がかかりすぎる。

Fabricでは、共通のOneLakeとCapacityの上にワークロードを揃えることで、

「どのチームも同じデータを参照しながら、それぞれの役割(ETL・分析・可視化・AI活用)に集中できる」状態を目指しています。

Power BI / Synapse / Data Factoryとの違い・位置づけ

Microsoft Fabricは、既存のサービスを置き換えるものではなく、再編・統合したプラットフォームという位置づけです。

-

Power BI

Fabricの中では、主に可視化・ダッシュボード・レポート共有の役割を担います。

従来のPower BIサービスはFabricと統合されており、Fabricワークスペース上でPower BIアセットを扱えるようになっています。 -

Azure Synapse Analytics

Synapseの機能のうち、「SQL DWH」「Spark」「Data Explorer」など分析寄りの部分は、FabricのData Warehouse / Data Engineering / Real-Time Intelligenceに取り込まれてきています。 -

Azure Data Factory

データ統合やパイプライン機能は、FabricのData Factoryワークロードとして統合されています。Fabric側のData Factoryを使うことで、OneLakeとの連携やFabricワークスペースとの一体運用がしやすくなります。

既存のPower BIやSynapse環境をすぐに廃止する必要はありませんが、

新規のデータ基盤・BIプロジェクトではFabric前提のアーキテクチャを検討するケースが増えています。

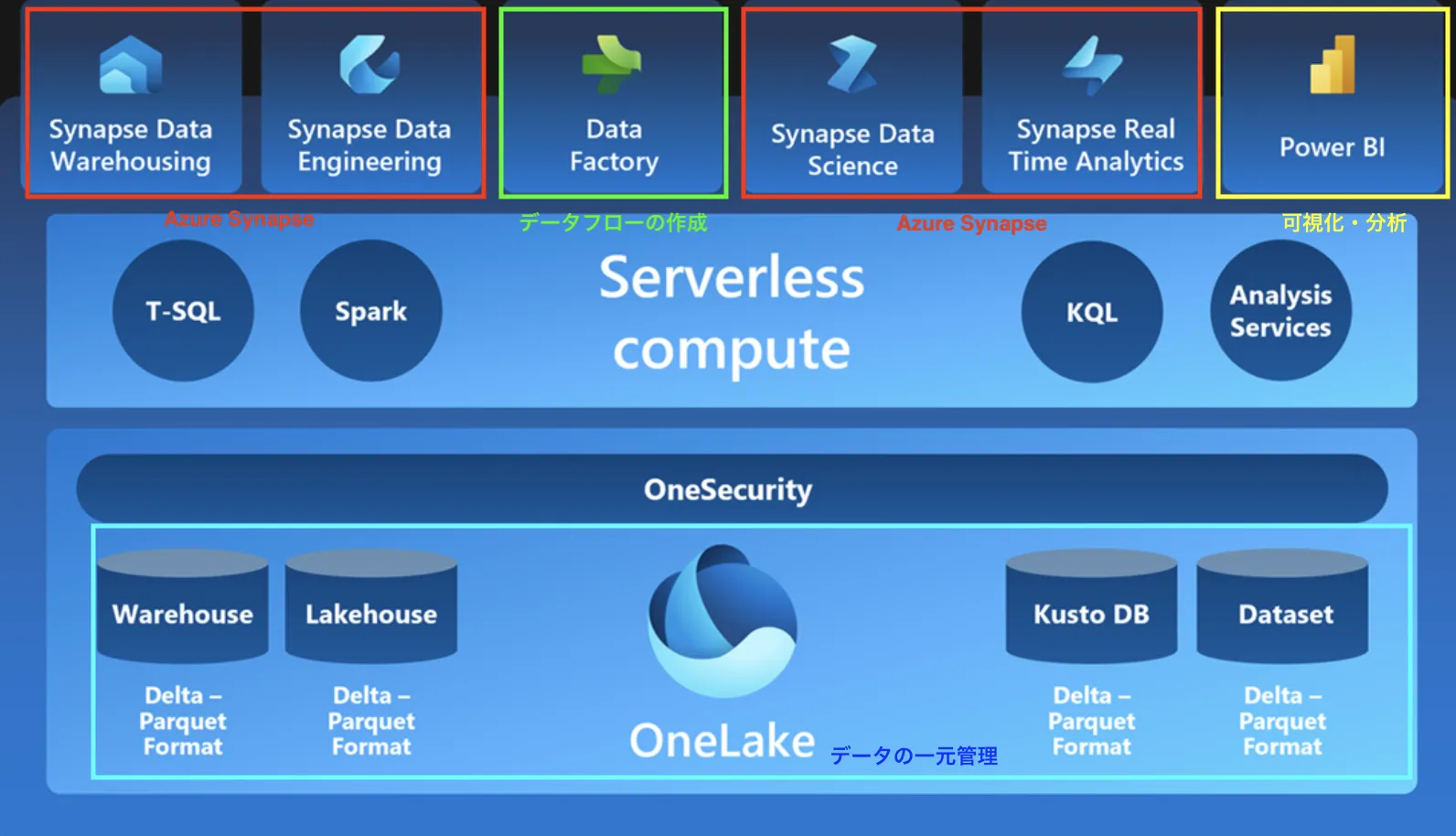

Microsoft Fabricのサービス全体像

ここからは、Microsoft Fabricを構成する要素をもう少し体系立てて整理します。

「どんな部品があって、それぞれがどのフェーズを担当しているのか」を把握するイメージです。

Microsoft Fabricの構成

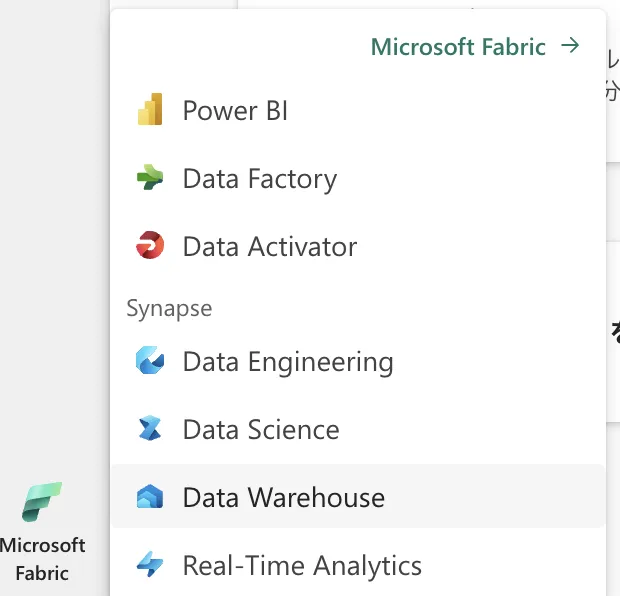

「ワークロード」「OneLake」「Capacity」で理解するFabric

Fabricは、大きく次の3つのキーワードで捉えると整理しやすくなります。

-

ワークロード(エクスペリエンス):

Data Factory / Data Engineering / Data Warehouse / Real-Time Intelligence / Data Science / Power BI / Databases など、「何をするか」に紐づく機能群。 -

OneLake:

すべてのワークロードの下にある共通データレイクです。ファイルやテーブルはOneLake上に置かれ、各ワークロードはそれを共有して利用します。 -

Capacity(キャパシティ):

実行リソースやスループットを表す単位です。F2 / F4 / F8…といったSKUで課金され、ワークスペースをこのCapacityにぶら下げる形で利用します。

これら3つを組み合わせることで、「どのデータを、どのワークロードで、どのくらいの規模で扱うか」を設計していくイメージです。

データライフサイクルで見たFabric

Fabricがカバーするライフサイクルを、典型的なデータ活用プロセスに当てはめてみます。

-

収集(Ingest):

各種SaaSやRDB、ファイルストレージからデータを取り込む(Data Factory / Real-Time Intelligence)。 -

加工・統合(Transform):

Notebook(Spark)やSQLでデータを整形し、共通のスキーマに統合する(Data Engineering / Data Warehouse)。 -

保存・管理(Store):

OneLake上でテーブルやファイルとして保存し、LakehouseやWarehouseに整理する。 -

分析・可視化(Analyze / Visualize):

Power BIでレポート・ダッシュボードを作成し、セルフサービスBIも展開する。 -

AI活用(AI & ML):

Data ScienceやCopilot、AI functionsなどを用いて、機械学習モデルや生成AIを組み合わせた活用を行う。

Fabricは、この一連の流れを**「1つのSaaS体験」+「OneLake」**という枠組みでまとめている点が特徴です。

Microsoft Fabricの構成要素

ここでは、Microsoft Fabricを構成する主要なコンポーネントをもう少し細かく見ていきます。

具体的にどのようなワークロードがあり、OneLakeやCapacityとどう結び付いているのかを整理します。

分析ワークロード(エクスペリエンス)の一覧

Fabricの代表的なワークロードと役割を、あらためて表にまとめます。

どのワークロードが自社のユースケースに関係しそうか、ざっくり当たりを付ける材料として活用してください。

| ワークロード | 主な役割 | 典型的な用途 |

|---|---|---|

| Data Factory | データ統合・パイプライン | SaaS/DB/ファイルからのバッチ・スケジュール取り込み |

| Data Engineering | Lakehouse+Sparkによる加工 | 大量データの前処理・特徴量作成・バッチ集計 |

| Data Warehouse | SQLベースのDWH | 共通KPI・業務指標の集約、レポーティング基盤 |

| Real-Time Intelligence | ストリーミング分析 | センサー/ログなどのリアルタイム集計・異常検知 |

| Data Science | モデル開発・実験 | 機械学習モデルのトレーニングや評価 |

| Power BI | レポート・ダッシュボード | 可視化、セルフサービスBI、配信・共有 |

| Databases | 運用DB(トランザクション) | 業務アプリのOLTP、分析基盤との一体運用 |

これらのワークロードは、すべて同じFabricワークスペース上に共存させることができます。

「DWHは別サブスクリプション、BIは別テナント」といった構成に比べ、可視性と運用負荷を抑えやすい構造です。

組織共通データレイク「OneLake」

OneLakeは、Fabricにおける単一の論理データレイクです。

Azure Data Lake Storage Gen2の上に構築され、テナント全体のデータを一元管理します。

OneLakeの主な特徴は次の通りです。

- テナント全体で1つのデータレイクという考え方で、業務アプリや部門ごとにバラバラにストレージを立てる必要がない。

- データは基本的にDelta / Parquet形式で保存され、LakehouseやWarehouseなど複数のワークロードから共通利用できる。

- Azure上のインフラ用語(リソースグループやストレージアカウント)を意識せずに、SaaSとしてデータレイクを扱える。

Microsoft Fabric利用画面

Fabric Capacityとワークスペース/アイテムの関係

Fabric Capacityは、「どの程度のリソースを常に確保するか」を決める単位です。

AzureポータルからF2 / F4 / F8…といったSKUを購入し、テナントやワークスペースに割り当てる構成になります。

- ワークスペースは、いずれかのCapacity(または試用Capacity)に紐づいて動作します。

- LakehouseやWarehouse、Notebook、レポートなどのアイテムは、このワークスペースの中に作成されます。

- 同じCapacityに紐づくワークスペース同士でリソースを共有するため、設計次第では「本番用」「検証用」などにCapacityを分けるパターンも一般的です。

主要ワークロードごとの役割

ここからは、代表的なワークロードを少し掘り下げて紹介します。

実際のプロジェクトで「どのコンポーネントをどう組み合わせるか」を考える際のヒントとしてご覧ください。

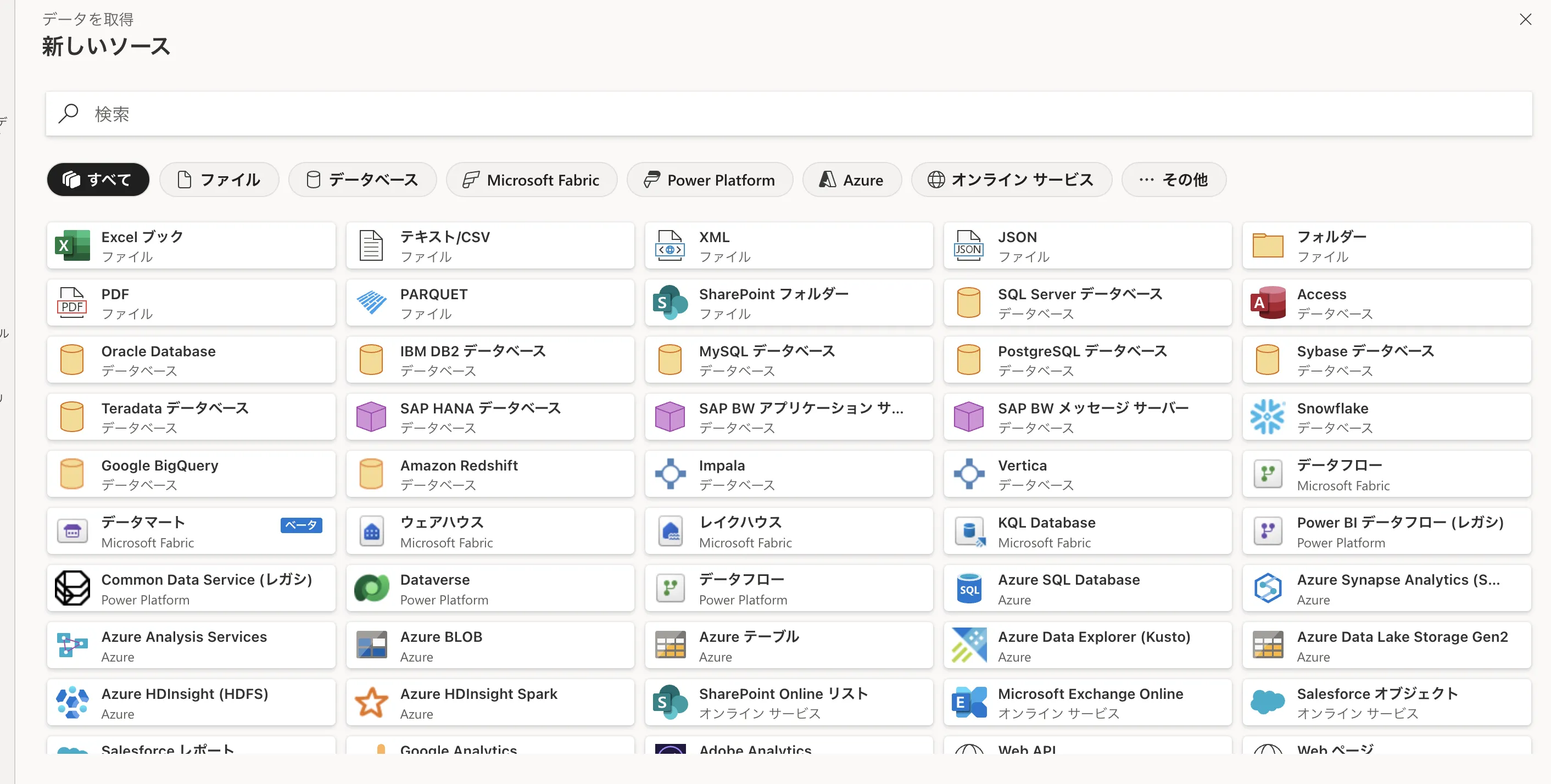

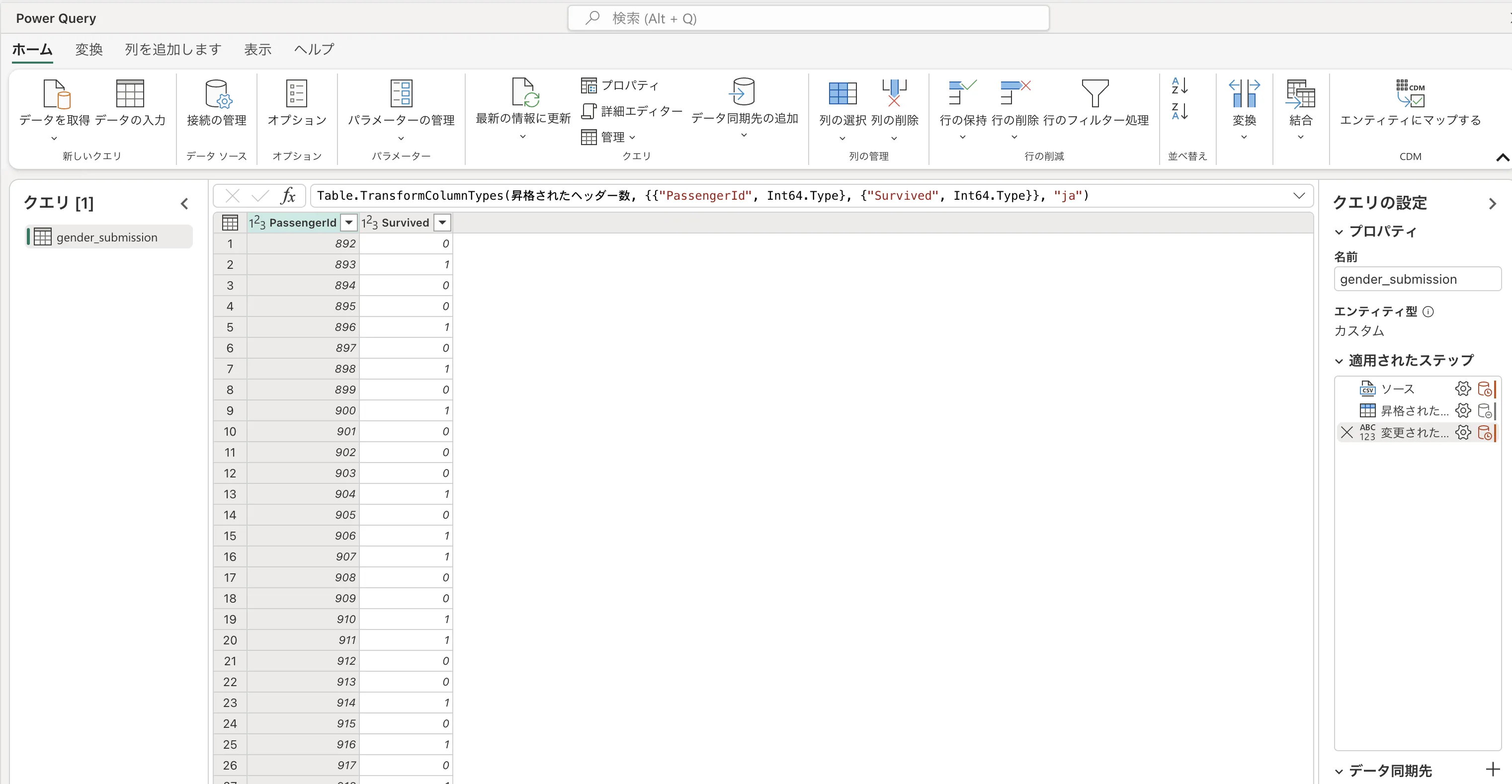

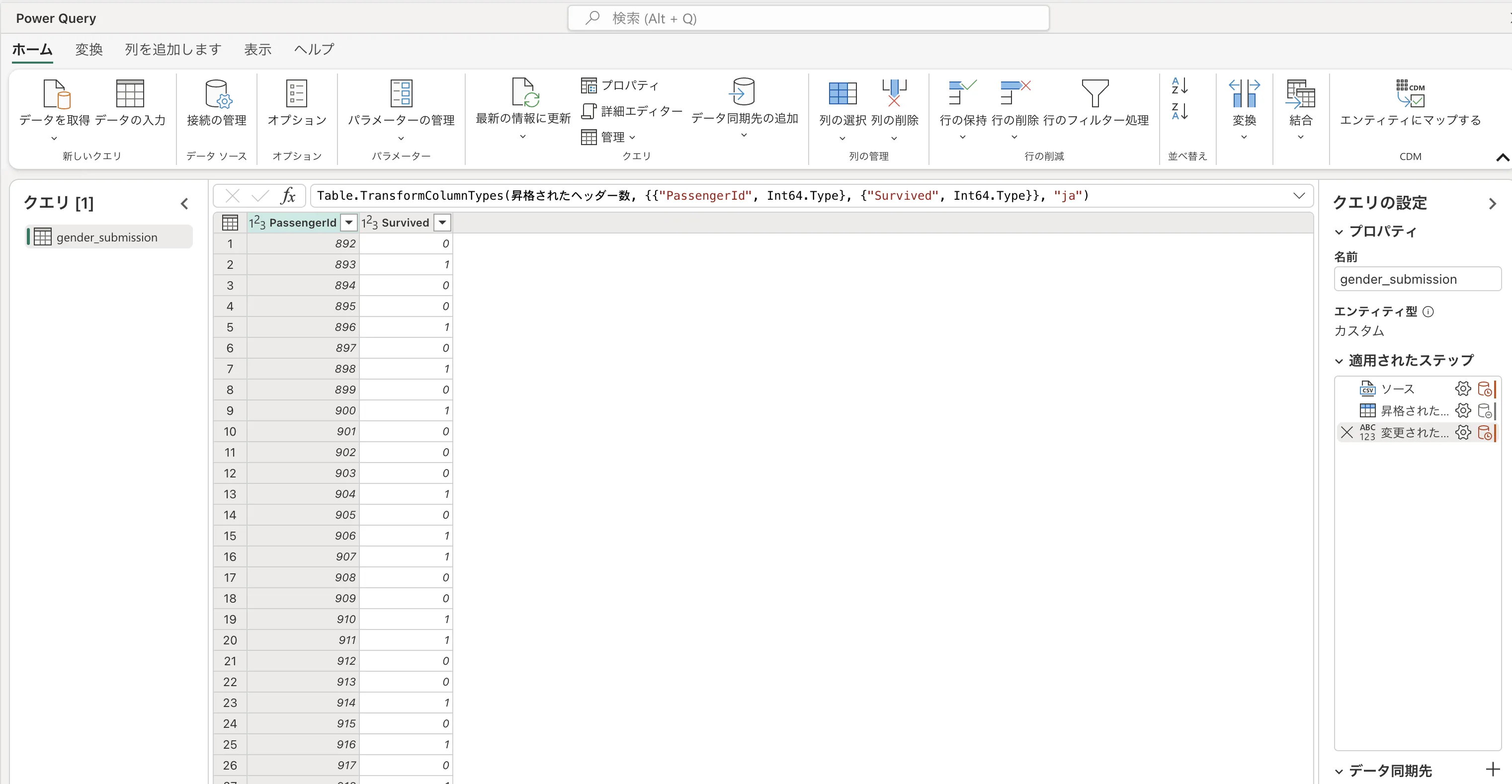

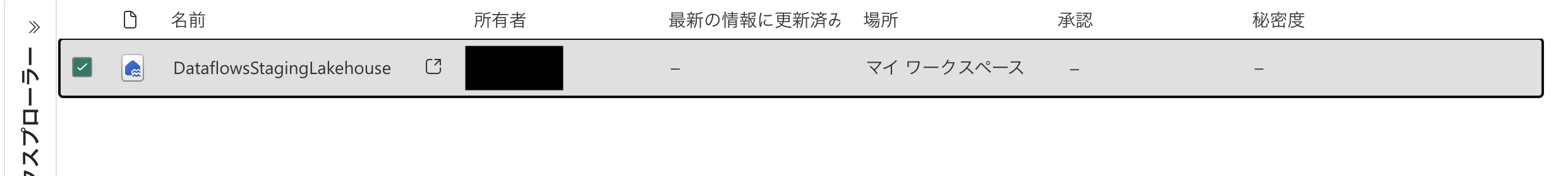

Data Factory:データ統合・ETL/ELTパイプライン

Fabric版のData Factoryは、各種ソースからのデータ取り込みや変換処理を担います。

従来のAzure Data Factoryに近い体験を、FabricのワークスペースやOneLakeと一体化した形で提供しています。

- GUIベースでパイプラインやデータフローを定義できる。

- Azure / SaaS / データベース / ファイルなど、多数のコネクタを利用可能。

- スケジュール実行やエラー通知など、運用に必要な機能も揃っています。

データの接続先一覧

Data FactoryでOneLakeに取り込んだデータは、そのままLakehouseやWarehouse、Power BIから参照できるため、「取り込み」と「利用」が分断されにくい点がメリットです。

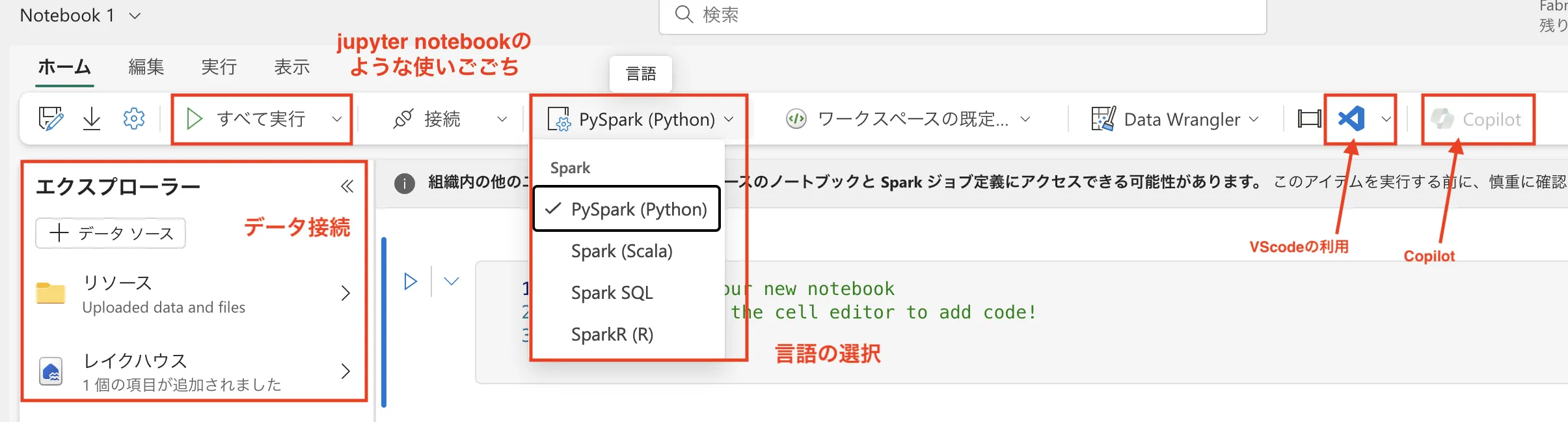

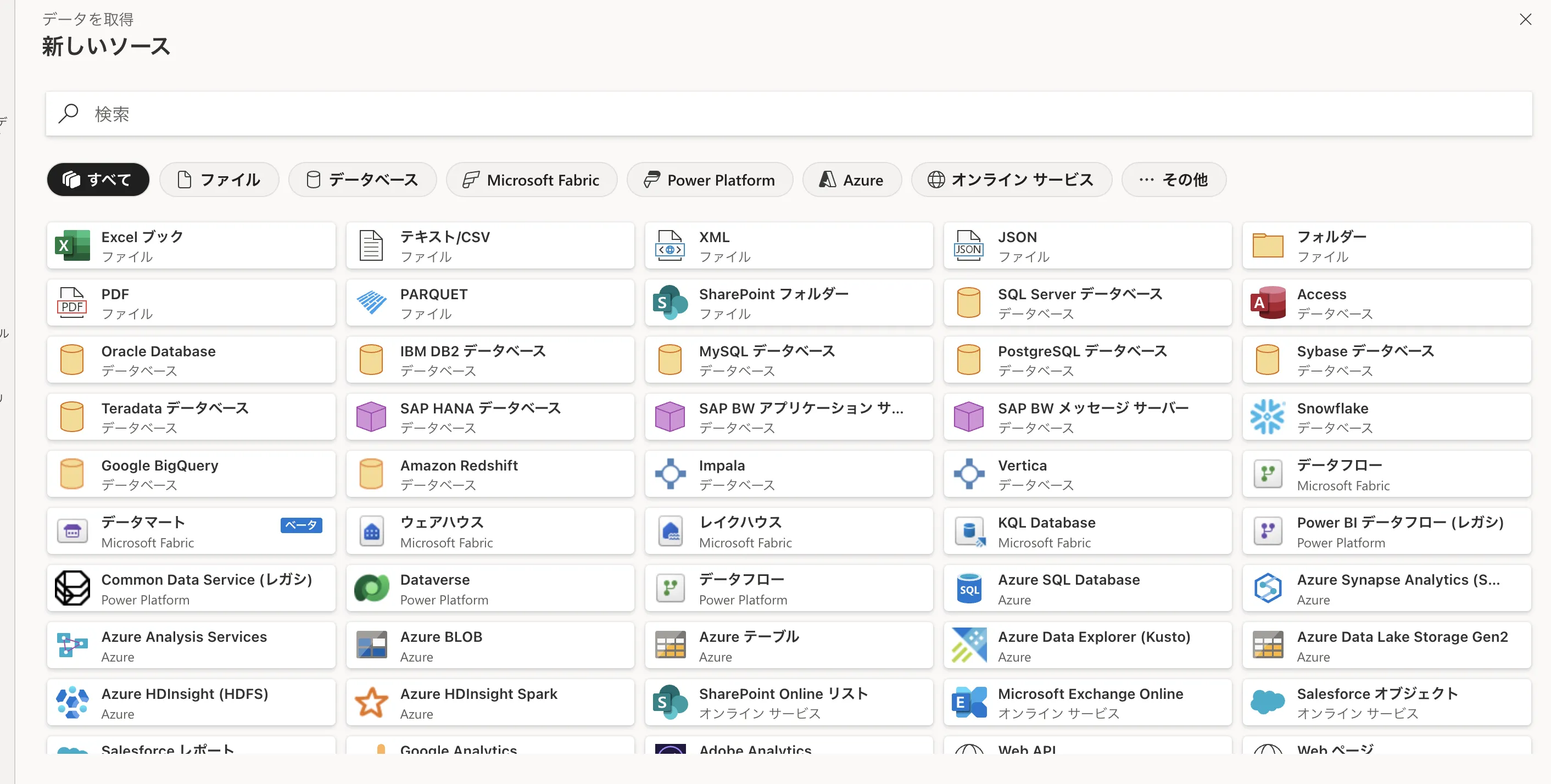

Data Engineering:Spark/Notebookによる加工・前処理

Data Engineeringワークロードでは、LakehouseとSparkベースのNotebookを使ってデータ加工を行います。

データサイエンティストやデータエンジニア向けの環境とイメージすると分かりやすいです。

Jupyter notebookイメージ

- Notebook上でPython / Scala / SQLなどを使い、データの前処理や特徴量作成を実施。

- Deltaテーブルとして保存した結果は、WarehouseやPower BIからも利用可能。

- MLflowなどと組み合わせ、モデル実験のトラッキングにも活用できます。

Data Warehouse / SQL:DWH・業務指標の土台

Data Warehouseワークロードは、エンタープライズ向けのクラウドDWHです。

Lakehouse上のデータと連携しながら、業務で使うKPIやマートの土台を整える役割を担います。

DataWarehouseのクリック

DataWarehouseの画像

- T-SQLベースでテーブルやビューを定義し、Power BIのDirect Lake / DirectQueryで利用できる。

- 従来のSynapse SQLと同様、DWH的なチューニングやガバナンスを意識した設計が可能。

- 既存のSQLスキルを活かしつつ、OneLake上のデータと密に連携できる点が特徴です。

Real-Time Intelligence:ログ・イベントのリアルタイム分析

Real-Time Intelligenceワークロードは、リアルタイムデータの取り込み・分析を行う機能群です。

ストリーミングデータに対するクエリやダッシュボードを、Fabric上で一貫して扱えるようにする狙いがあります。

- イベントハブやKafkaなどからのストリーミングデータ取り込み。

- ストリーミングテーブルを使ったリアルタイム集計・ウィンドウ集計。

- 異常検知やアラートのトリガーを組み合わせたユースケース。

ログ監視やIoTデータの可視化、リアルタイムKPIの表示など、「今起きていること」をすぐに把握したいシナリオで有効です。

Data Science:機械学習開発とMLOps基盤

Data Scienceワークロードでは、NotebookやMLライブラリを使ったモデル開発が可能です。

Fabricの中でデータ探索・特徴量作成・モデル訓練・評価までを一貫して行えるように設計されています。

- Notebookベースでの実験・特徴量エンジニアリング。

- OneLake上のデータを直接読み、結果もOneLakeに書き戻す。

- Azure Machine Learningや他のMLOps基盤と連携する構成も取りやすい。

生成AIだけでなく、従来型の機械学習モデル(需要予測・スコアリングなど)との組み合わせにも向いています。

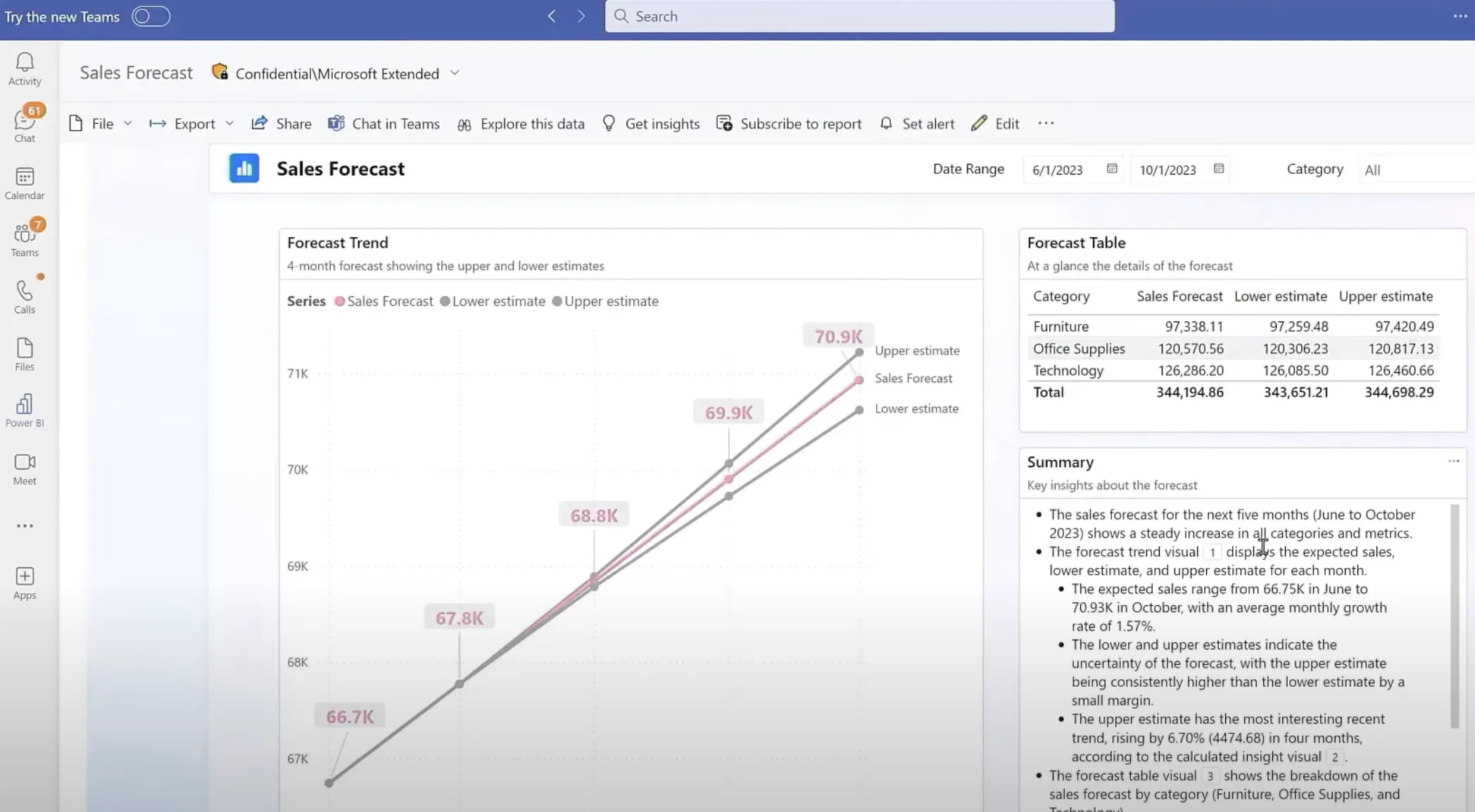

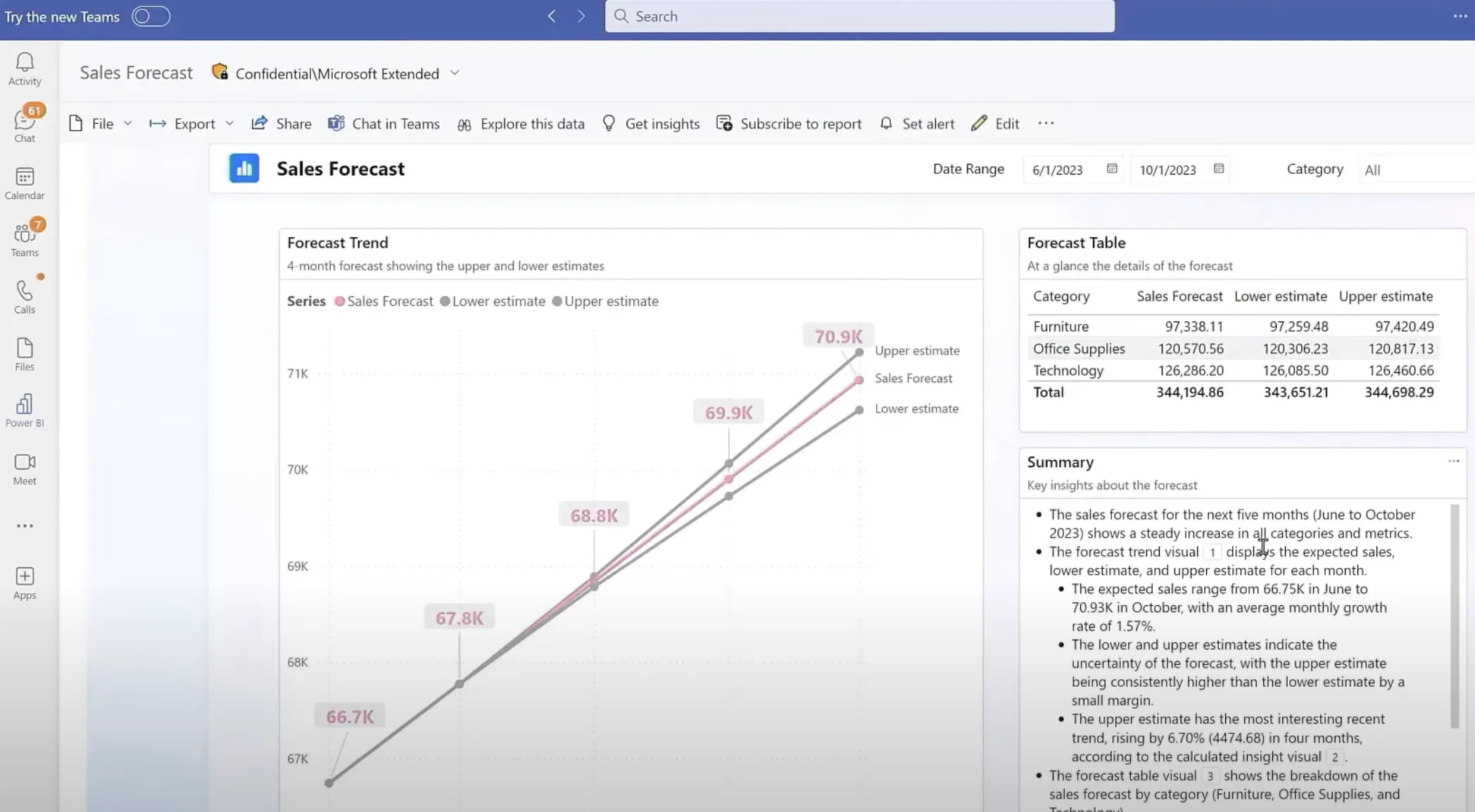

Power BI:可視化・ダッシュボード・共有

Power BIは、Fabricにおいても可視化と共有の中核を担います。

データモデルやレポート、ダッシュボードを作成し、組織内へ配信する役割です。

Teamsへのレポート共有

- LakehouseやWarehouseをデータセットとして接続し、レポートを作成。

- TeamsやPowerPoint、SharePointへの埋め込み・共有。

- Direct Lakeモードにより、大規模データに対しても高パフォーマンスな分析が可能。

既にPower BIを利用している組織にとっては、**「データソースがFabricのOneLakeに変わる」**イメージで移行・統合を検討できます。

OneLakeとデータ設計のポイント

このセクションでは、OneLakeを前提としたデータ設計の考え方を整理します。

「コピーしない」「共通の形式に寄せる」といった設計思想が重要になります。

One Copyの考え方とDelta / Parquet形式

OneLakeの中心にある思想が**「One Copy」**です。

同じデータを用途ごとに何度もコピーせず、単一のコピーをさまざまなワークロードから参照することを目指します。

- 生データも、加工済みデータも、基本的にはDelta / Parquet形式で保存する。

- Lakehouse / Warehouse / Notebook / Power BIが、同じDeltaテーブルをそれぞれの観点から利用する。

- コピーが必要な場合も、「明確な理由」と「ライフサイクル」を決めておく。

これにより、ストレージコストやデータ鮮度の管理コストを抑えやすくなります。

Shortcutsによる外部ストレージ連携

OneLakeのShortcut機能を使うと、外部ストレージ(Azure Data Lake Storage Gen2やAmazon S3など)上のデータを、「コピーせずに」OneLake配下に見せることができます。

- すでにAzure Data LakeやS3でデータレイクを構築している場合でも、Shortcutで参照を貼るだけでFabricから扱える。

- 取り込み前にサンプルを見たり、一部だけをFabric側に持ってくるといった柔軟な構成が可能。

- 完全移行ではなく、共存・ハイブリッド構成を取りやすい点が実務上のメリットです。

Mirroringによる運用DB・外部DBからの継続取り込み

Mirroring機能は、特定の外部データベースのデータを、ほぼリアルタイムにOneLakeへ同期する仕組みです。

- 例として、Azure SQL DatabaseやSQL Server、Snowflakeなどのテーブルをミラーし、そのままFabric側でテーブルとして利用できます。

- 従来の「夜間バッチで丸ごとコピー」から、更新分だけを随時反映していく構成へ移行しやすい。

- リアルタイム分析やダッシュボード更新の頻度を上げたいシナリオに向いています。

データのインポート

データの表示

Direct Lakeとパフォーマンス最適化

Power BIのDirect Lakeモードは、OneLake上のDeltaテーブルに直接アクセスしながら、高速なインタラクティブ分析を可能にする仕組みです。

- 従来のImportやDirectQueryに比べ、大容量データでも応答速度を維持しやすい。

- WarehouseやLakehouse上のテーブル設計と合わせて、パフォーマンスチューニングを行うことで効果を最大化できます。

Direct Lakeを前提にすると、「DWH側のデータ構造」と「レポート側のモデリング」の両方を意識した設計が重要になります。

Copilot / AI機能とFabric

Fabricは、単なるデータ基盤ではなくCopilotやAI機能と一体化されている点も特徴です。

ここでは、代表的なAI体験と、利用時の前提条件を整理します。

によるサポート.webp)

Copilot (AI) によるサポート

Copilotでできること(クエリ・レポート・パイプライン生成など)

Copilot in Microsoft Fabric / Copilot for Power BIでは、次のようなことが可能です。

- 自然言語からSQLやDAXのたたき台を生成する。

- Power BIレポートのビジュアル配置や要約文を提案してもらう。

- Notebook内でのコード補完や、データ探索ステップの提案を受ける。

- Data Factoryのパイプライン定義や、変換ロジックの案を生成してもらう。

あくまで「たたき台」として活用し、最終的なロジックの妥当性は人間側でレビューする前提で使うのが実務的です。

Data Agent / AI Functionsなど周辺AI機能の位置づけ

Fabricでは、Copilotに加えて次のようなAI関連機能も順次提供されています。

- Data Agent:OneLake内外のデータを跨いで検索・要約するエージェント的な機能。

- AI functions(AI関数):SQLやNotebookから直接、要約や分類などの生成AIを呼び出すための関数群。

- Azure OpenAI / Azure AI Searchとの連携:RAG(検索拡張生成)パターンでのアプリケーション開発など。

機械学習、検索、ChatGPT api等も使用可能

Fabricはこれらをデータ基盤のすぐそばに配置することで、「データを動かさずにAIを呼べる」構造を目指しています。

Copilot利用時の前提条件・制約(2026年1月時点)

Copilot in Fabric / Copilot for Power BIの利用には、主に次の前提があります。

- 有償のCapacity(Fabric F2以上 / Power BI Premium P1以上)に紐づくワークスペースが必要。

- 試用(trial)SKU/試用CapacityではCopilotはサポートされない。

- テナントのリージョンやデータ境界、ネットワーク構成(Private Linkなど)によっては利用制限が生じる。

Fabric Copilot Capacity(既存の容量をCopilotの課金先として指定する機能)を使う選択肢もあり、Copilot利用に必要なリソースを分離して管理できます。

Microsoft Fabricの料金体系

ここでは、Fabricのコスト構造を大きく捉えます。

実際にはAzure料金ページや見積もりツールでの確認が必須ですが、「何に対してお金がかかるのか」を押さえておくことが重要です。

課金の全体像:Fabric Capacity + OneLake Storage + ライセンス

Microsoft Fabricのコストは、おおまかに次の3レイヤーで考えます。

-

Fabric Capacity(F SKU)

- 分析ワークロードの実行リソースに対する料金。

- F2 / F4 / F8… といったSKUごとに、月額または時間単価が設定されています。

-

OneLake Storage

- OneLake上に保存したデータ量に応じたストレージ料金(Capacityとは別に発生)。

- Azure Data Lake Storage Gen2とほぼ同様の課金モデルです。

-

ユーザーライセンス(Power BI / Fabric)

- Power BI Pro / Premium Per User、Fabric関連のユーザーライセンスなど。

- レポート作成・共有の要件によって最適な組み合わせが変わります。

ワークスペースの作成

Fabric Capacity(F SKU)のラインナップと選び方の目安

Fabric Capacityは、SKUと規模によってコストと性能が変わります。

詳細な価格は公式サイトに譲り、ここでは選び方の目安だけ整理します。

| SKUイメージ | 主な用途の目安 |

|---|---|

| F2 | 小規模PoCや部門内での検証環境 |

| F4〜F16 | 部門単位の本番環境、中規模システム |

| F32以上 | 全社横断のデータ基盤、大規模DWH・リアルタイム分析 |

- 「まずはPoCで動かす」段階ではF2〜F4から始め、負荷に応じてスケールアップするパターンが多いです。

- 全社展開やリアルタイム分析の比重が大きい場合は、最初からF32以上を想定した設計が検討対象になります。

OneLake Storageの課金イメージ(保存・バックアップ・キャッシュ)

OneLakeのストレージ料金は、基本的に「保存しているデータ量」に比例します。

さらに、リージョンを跨いだレプリケーションやバックアップ、キャッシュなどを組み合わせると、追加のコストが発生します。

- 「何でもコピーして貯める」運用を続けると、長期的にはストレージコストが膨らみがちです。

- One CopyやShortcut、Mirroringの設計を意識して、本当に必要なコピーだけを作ることが重要です。

ライセンス構成の考え方

ユーザーライセンスについては、次のような観点で整理します。

- レポートの閲覧のみが必要なユーザーは、Power BI Pro / PPU / Fabricライセンスのうち、既存環境との兼ね合いで選択。

- レポートの作成・共有を行うユーザーは、Pro以上が前提になることが多い。

- 開発者やデータエンジニアは、FabricワークスペースやNotebookを扱えるライセンスが必要です。

組織規模や既存のPower BI契約状況によって最適解が変わるため、既存契約を棚卸ししたうえでFabric容量と組み合わせるのが現実的です。

無料トライアル(60日)の位置づけと制約

Microsoft Fabricには、一定期間利用できる**無料トライアル(試用Capacity)**が用意されています。

- 小規模なPoCや機能検証には有効ですが、Copilotはサポート対象外などの制限があります。

- 本番利用を前提とする検証では、早い段階で有償Capacityに切り替え、実際の制約に近い環境で検証することをおすすめします。

Microsoft Fabricの基本的な使い方

ここからは、PoCレベルでFabricを試すときの「最小限の流れ」を5ステップで整理します。

実際のUIはアップデートで変わる可能性がありますが、考え方そのものは長く使える部分です。

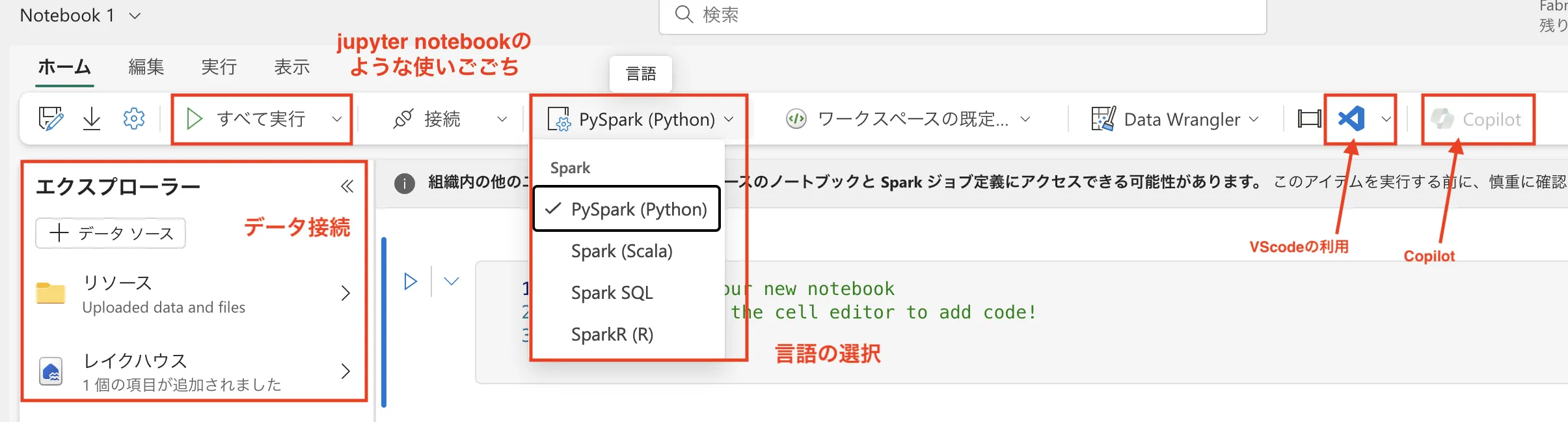

1. ワークスペースとLakehouse / Warehouseを用意する

最初のステップは、Fabricワークスペースとデータ格納先を用意することです。

Microsoft Fabric利用画面

- Fabricポータルから、新しいワークスペースを作成します。

- ワークスペースにCapacity(試用または有償)を割り当てます。

- LakehouseまたはWarehouseを新規作成し、OneLake上のデータ格納先を確保します。

Lakehouseを軸にするか、Warehouseを軸にするかは、チームのスキルセットや既存DWHとの整合性で選ぶとスムーズです。

2. データを取り込む(Get data / Data Factory)

つづいて、ソースシステムからOneLakeにデータを取り込みます。

データの接続先一覧

- 最初はCSVやExcelなどのファイルアップロードから始めても構いません。

- 本格的には、Data Factoryのコネクタを用いてSaaSやRDBからの取り込みパイプラインを構築します。

- MirroringやShortcutを併用することで、「コピーしすぎない」構成も検討可能です。

3. NotebookやSQLで加工・分析する

データを取り込んだら、NotebookやSQLを使って加工・分析を進めます。

Notebookでの利用画面

- Data EngineeringのNotebookで前処理や特徴量作成を行います。

- Data WarehouseのSQLエディタでビューやマートを定義し、Power BIから使いやすい形に整えます。

- この段階からCopilotを活用し、「たたき台としてのコード生成」を試してみると、Fabricならではの体験がしやすくなります。

4. Power BIでレポート化し、Teamsなどに共有する

整形したデータをもとに、Power BIでレポートやダッシュボードを作成します。

Teamsへのレポート共有

- Lakehouse / Warehouseをデータセットとして接続し、基本的なメジャー・ディメンションを定義します。

- グラフやテーブル、カードビジュアルを使って、KPIを可視化します。

- 作成したレポートは、TeamsのタブやPowerPointへの埋め込み、メール配信などで共有できます。

5. 最小限の運用ルール(権限・環境分離・命名)を決める

PoCの段階から、次のような最低限のルールを決めておくと、後からの拡張が楽になります。

- ワークスペースの役割(本番/検証/個人)と命名規則。

- ワークスペース・アイテムの権限設計(閲覧/編集/管理)。

- 環境ごとのデータソースやパイプラインの切り替え方。

Microsoft Fabricの代表的な構成パターン

ここでは、実際のユースケースに近い形で、Fabricの構成パターンを4つ紹介します。

それぞれのパターンは、実際には組み合わせて使われることも多いです。

BIレポーティング基盤としてのFabric

最も分かりやすいパターンが、BIレポーティング基盤としてFabricを利用する構成です。

- OneLake+Data Warehouseを軸に、部門横断のKPIを集約。

- Power BIによるダッシュボード・レポートを、全社で共有。

- 一部の高度な分析はNotebookやCopilotを併用。

既存のPower BI環境を強化する形で、徐々にFabricへ移行していくケースも多いです。

複数SaaS・DBを統合するデータハブとしてのFabric

CRMやMAツール、コアシステムなど、複数SaaS・DBに散らばったデータを統合するハブとしてFabricを使うパターンです。

- Data Factoryで各システムからデータをOneLakeへ取り込み。

- 共通の顧客IDや製品コードなどで統合し、データマートを設計。

- Power BIや外部アプリケーションから、このデータハブを参照。

ShortcutやMirroringを組み合わせることで、既存データレイクとの共存も可能です。

リアルタイム分析・アラート基盤としてのFabric

リアルタイム性が求められるユースケースでは、Real-Time Intelligenceを中心に構成します。

- センサーやログストリームを取り込み、ストリーミングテーブルで集計。

- 閾値や異常パターンを検知して、アラートやワークフローを起動。

- バックグラウンドでは、集計結果をOneLakeに蓄積し、後日分析にも活用。

運用監視やIoT、デジタルマーケティングのリアルタイム指標などに適したパターンです。

検索・生成AI(RAG)と組み合わせた応用パターン

Fabric上のデータと、Azure AI SearchやAzure OpenAIを組み合わせて**RAG(検索拡張生成)**の基盤にするパターンも増えています。

- OneLake上のドキュメントやログを、Azure AI Searchでインデックス化。

- 検索結果とともにLLM(大規模言語モデル)へ渡すことで、根拠付きの回答を生成。

- ダッシュボードやチャットボット、社内ポータルなどに組み込む。

【関連記事】

Azure AI Search(Cognitive Service)の詳細解説はこちら

Fabric側でデータ品質やアクセス制御を整えたうえでRAGに接続することで、「データ基盤+生成AI」の安全性と再現性を高めやすくなります。

Microsoft Fabricのセキュリティとガバナンス

エンタープライズでFabricを導入する際には、セキュリティとガバナンス設計が不可欠です。

ここでは、責任分界・ID管理・データ保護・ネットワーク・ガバナンスの観点で整理します。

Shared Responsibility Model(責任分界)の整理

FabricはSaaSであり、インフラ層のセキュリティ(物理・ホストOS・サービス継続性など)はMicrosoftの責任範囲です。

一方、利用者側には次の責任が残ります。

- ユーザー・グループ管理(Microsoft Entra ID)の設計。

- ワークスペースやアイテムごとのアクセス権限設計。

- データ分類や感度ラベル、DLPポリシーの設定。

- 開発・検証・本番などの環境分離。

Fabric導入にあたっては、既存のMicrosoft 365 / Azureセキュリティポリシーと整合性をとることが重要です。

ID/アクセス管理とロール設計(Entra ID・RLS/CLS/OLSなど)

Fabricでは、Entra ID(旧Azure AD)ベースの認証・認可モデルが採用されています。

- ワークスペース単位で「閲覧者」「メンバー」「管理者」などのロールを割り当てる。

- Power BIのRLS(Row-Level Security)やCLS(Column-Level Security)を使い、データレベルのアクセス制御を行う。

- 組織やテナント跨ぎの共有範囲を明示的に設計する。

特に、個人情報や機微データを扱う場合は、最低限でもRLS+感度ラベルの組み合わせを検討したいところです。

データ保護:暗号化・情報保護ラベル・DLP・監査ログ

Fabricは、暗号化やコンプライアンス対応といった基盤機能を持っていますが、

利用側での設定と運用も同じくらい重要です。

- 機微データに対する**感度ラベル(Sensitivity Label)**の付与。

- Microsoft PurviewのDLPポリシーによるデータ持ち出しの抑制。

- アクセスログや操作ログを監査し、定期的なレビューを行う仕組み。

こうした設定により、「誰がどのデータにアクセスしているのか」を説明できる状態を作ることが大切です。

ネットワーク制御:Managed VNet / Private Endpoint等の考え方

Fabricでは、一部のワークロードでManaged Virtual NetworkやPrivate Endpointを利用できます。

一方で、Copilotや一部クラウドサービス連携との相性も考慮しなければなりません。

- Private Link/閉域ネットワーク構成では、現時点ではCopilotがサポートされないケースがある。

- 逆に、インターネット経由のアクセスを許しすぎると、データ漏えいリスクが高まる。

そのため、「どのワークスペースはManaged VNetで閉じるのか」「どこまでCopilotや外部連携を許容するのか」といったゾーニング設計が重要になります。

Microsoft Purviewとの連携でできること(カタログ・リネージ・ポリシー)

Microsoft Purviewと連携することで、次のようなガバナンス機能をFabricに適用できます。

- データ資産のカタログ化(どこにどんなデータがあるかの可視化)。

- データリネージ(どのソースからどのレポートに至るか)の可視化。

- 感度ラベルとポリシーの一元管理。

複数部門でFabricを利用する場合は、Purviewを使って「企業全体のデータ辞書+ガバナンス基盤」を整備するイメージが現実的です。

Microsoft Fabricに関するよくある質問(FAQ)

最後に、導入検討時によく挙がる質問をQ&A形式で整理します。

詳細は本文の該当セクションや公式ドキュメントも併せてご確認ください。

Q. Fabricと従来のSynapse / Power BI単体はどう違いますか?

A. 大きな違いは、OneLakeとSaaSとしての一体感です。

Synapseや従来のPower BIでは、サービスごとにリソースや設定が分かれていましたが、Fabricでは「ワークスペース+Capacity+OneLake」という共通の枠組みで運用できます。

既存環境をすぐに廃止する必要はありませんが、新規プロジェクトではFabric前提のアーキテクチャを検討するケースが増えています。

Q. 小規模・スモールスタートでも導入メリットはありますか?

A. あります。

特に次のような状況では、F2〜F4クラスのCapacityでのスモールスタートが現実的です。

- これからデータ基盤を整備しようとしている中小規模組織。

- 既存のBI環境を整理しながら、生成AIとの連携も視野に入れたいチーム。

OneLake+Power BIの組み合わせだけでも、既存の「Excel+オンプレDB」構成に比べて、運用の見通しを立てやすくなります。

Q. どの程度のデータ量・組織規模から検討するとよいですか?

A. 明確な閾値があるわけではありませんが、次のような兆候が見えてきたら検討のタイミングです。

- 部門ごとにデータマートが乱立し、「どれが正しい数字か分からない」状態になりつつある。

- 個別システム間のデータ連携に時間がかかり、分析より連携作業の方が負荷になっている。

- 生成AIの活用を検討しているが、そもそもデータの所在や品質が整理されていない。

こうした状況では、「データ基盤+AIプラットフォーム」としてFabricを位置付ける価値が高くなります。

Q. 既存のDWHやデータレイクとどう共存させればよいですか?

A. いきなり完全移行するのではなく、ShortcutやMirroringを使った共存構成から始めるのがおすすめです。

- 既存データレイクの一部をShortcutで参照し、Fabric側で分析・可視化を試す。

- 運用DBはMirroringで一部テーブルから同期し、リアルタイム分析の候補を探る。

徐々にOneLake側に主軸を移していくことで、リスクを抑えながら移行できます。

Q. CopilotなしでFabricだけ導入することは可能ですか?

A. 可能です。

CopilotはあくまでオプションのAI機能であり、Fabricのデータ基盤としての価値はCopilotがなくても成立します。

一方で、Copilotを活用することで、SQLやDAX、Notebookの記述・デバッグを補助できるため、

「まずはCopilot抜きで基盤を整え、あとからCopilotを段階的に解放していく」という段階的な導入パターンも考えられます。

AI総合研究所による導入支援

最後に、AI総合研究所としての支援メニューの位置づけをまとめます。

Fabricは機能が広く、社内だけで検証・運用までを完結させるのは大きな負担になるケースも少なくありません。

PoC支援:まずは小さく試すための支援メニュー

- 既存のデータ環境・Power BI環境のヒアリング。

- PoCに適したスコープ(データソース・KPI・レポート)の整理。

- Fabricワークスペース/Capacity構成の初期設計。

PoCフェーズでは、「何をもって成功とするか」「どの指標を改善したいか」を一緒に定義し、小さく試すところから伴走します。

本番導入・運用設計支援(ガバナンス・コスト設計を含む)

- CapacityとOneLake設計、ワークスペース分割方針の検討。

- ID・権限設計(Entra IDロール、RLS/CLS、環境分離など)。

- コスト管理と監視、運用ルール(命名規則・レビュー体制など)の整備。

PoCで得られた知見を踏まえ、全社展開を見据えたアーキテクチャを一緒に作り込んでいきます。

Fabricと生成AI(Azure OpenAI / Azure AI Search等)の統合支援

- RAG(検索拡張生成)やAIエージェントのユースケース整理。

- OneLake/Azure AI Search/Azure OpenAIを組み合わせたアーキテクチャ設計。

- 既存業務への組み込み方や、ガバナンス・ログ設計の支援。

Fabricを「単なるDWH」ではなく、生成AIやエージェントの土台として活用したい企業向けの支援です。

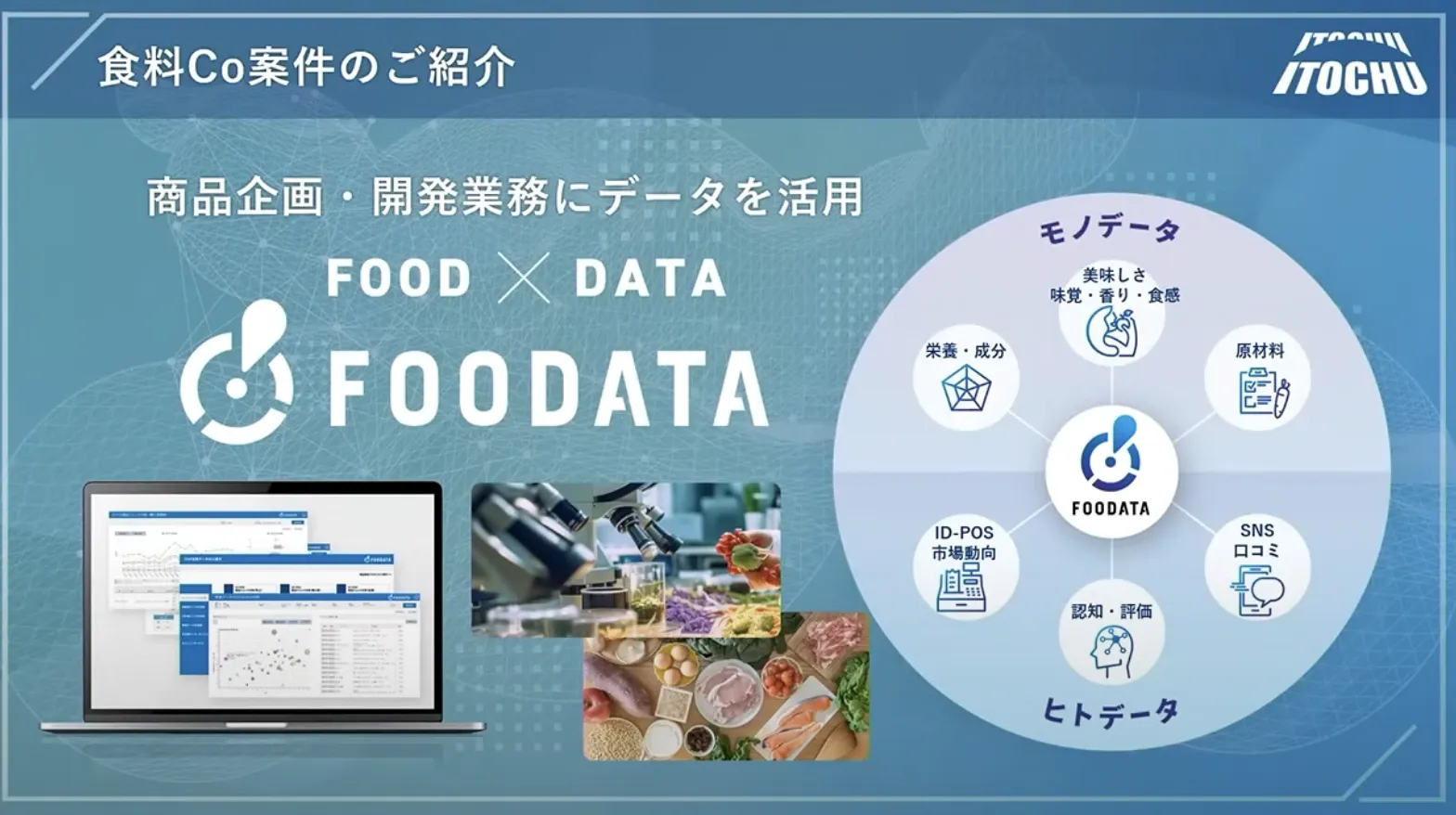

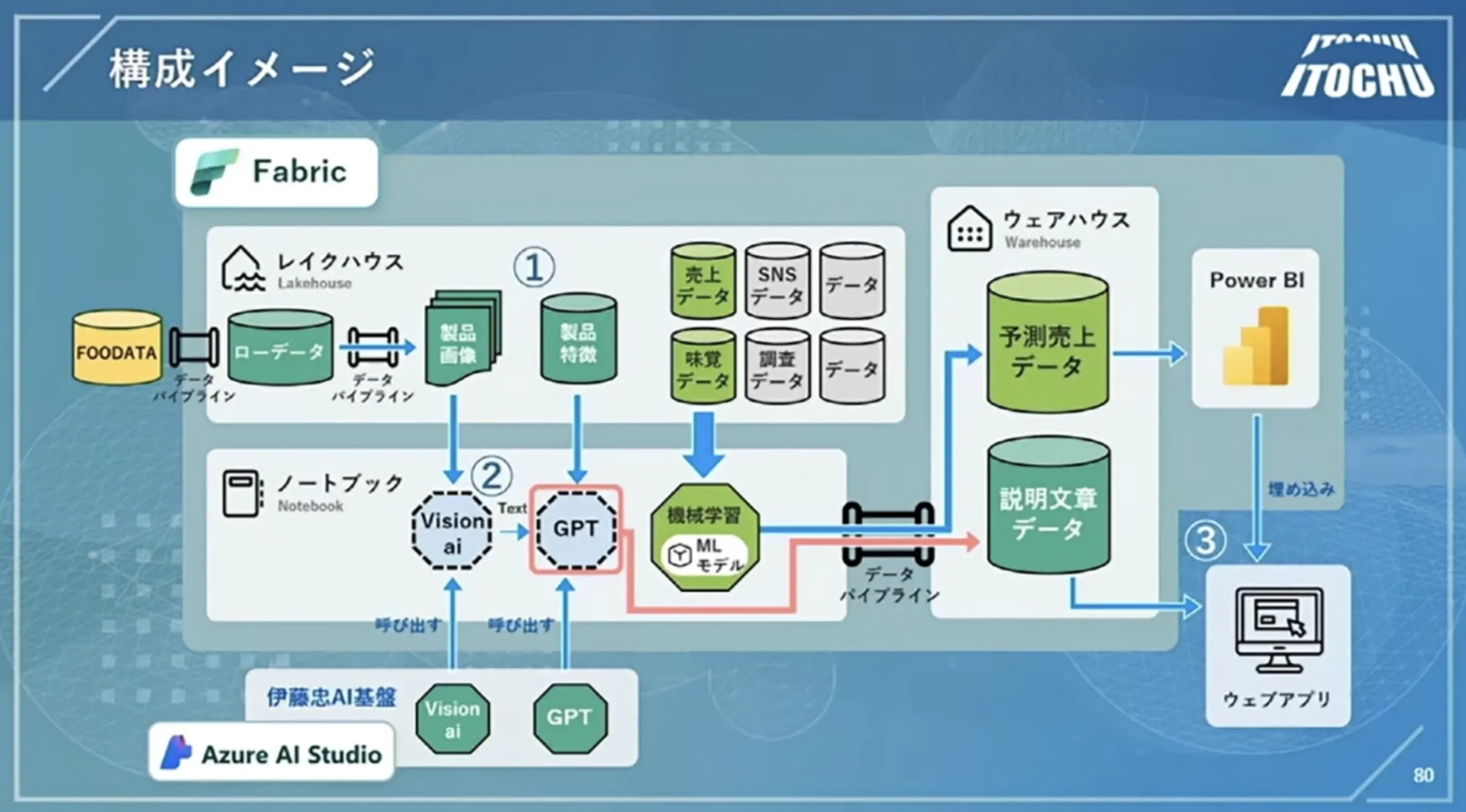

Foodata画像引用:Microsoft Ignite 2023

構築のアーキテクチャ

研修・ワークショップ(データ基盤/Fabricハンズオン)

- 経営層・企画部門向けの「Fabricとは何か」セミナー。

- データエンジニア向けのLakehouse / Warehouseハンズオン。

- Power BI開発者向けのFabric連携トレーニング。

社内にFabricやデータ基盤の知見を広げることで、属人化しない運用体制を作るお手伝いをしています。

まとめ:Microsoft Fabricをどう位置付けるか

本記事では、Microsoft Fabricの概要から構成要素、OneLakeの考え方、CopilotやAI機能、料金・ライセンス、代表的な構成パターン、セキュリティとガバナンスのポイントまでを整理しました。

- Microsoft Fabricは、OneLake+複数ワークロード+Capacityという枠組みで、「データ基盤+BI+AI」をSaaSとして提供するプラットフォームです。

- データ複製を前提にしないOne Copyの設計や、Shortcut / Mirroringを通じた既存環境との共存が大きな特徴です。

- CopilotやAI functionsを組み合わせることで、「データの近くでAIを動かす」構成を取りやすくなります。

- 一方で、セキュリティ・ガバナンス・コスト設計を含めた全体設計が不可欠であり、PoC段階からこれらを意識することが重要です。

まずは小さなPoCから始め、**「どの業務でどれだけ効果が出るのか」**を見極めつつ、段階的に本番活用へと広げていくことが現実的なアプローチです。

AI総合研究所では、Microsoft FabricとAzure AIを組み合わせたデータ基盤+生成AIの設計・導入支援を行っています。

ご興味があれば、ぜひお気軽にお問い合わせください。