この記事のポイント

Data Factoryには、従来の「Azure Data Factory」と、新しい「Data Factory in Microsoft Fabric」の2種類が存在する

Microsoft Fabric版は、データ統合からBIまでを単一環境で実現する次世代のSaaS型エクスペリエンス

Power Queryベースの「Dataflow Gen2」など、Fabric版にはよりモダンで使いやすい新機能が搭載

既存のAzure中心の環境ならADF、新規で分析基盤を構築するならFabricが推奨される

スタンドアロン版ADFも継続的にメンテナンスされており、新規コネクタ追加などのアップデートは続いている

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

Azure Data Factoryは、現在「スタンドアロン版」と、統合分析プラットフォーム「Microsoft Fabric」に内包された次世代版の2種類が存在します。この違いを理解することが、最適なデータ統合基盤を選択する鍵となります。

本記事では、従来のAzure Data Factoryの基本機能に加え、Microsoft Fabricの登場によって生まれた2つのData Factoryの違いを徹底比較します。それぞれのアーキテクチャ、機能、ユースケースを明確にし、自社の状況に合った最適なツールを選ぶための指針を提供します。

これからデータ統合を始める方から、既存のADF環境の今後を検討している方まで、全てのデータ技術者必見の内容です。

Azure Data Factoryとは

Azure Data Factoryイメージ

Azure Data Factory (ADF)は、様々な場所に散在するデータを集約し、ビジネスで活用できる形に加工・変換(ETL/ELT処理)するための、クラウドベースのデータ統合サービスです。ADF自体はデータを保存するデータベースではなく、データの「抽出、変換、読み込み」という一連のプロセスを自動化する「パイプライン」を構築・実行する役割を担います。

オンプレミスのファイルサーバーからクラウド上のデータウェアハウスへデータを転送したり、Web APIから取得したJSONデータを整形してデータベースに格納したりと、データ駆動型のワークフローをコードを書かずに(または最小限のコードで)作成できるのが大きな特徴です。

Azure Data FactoryとMicrosoft Fabric:どちらを選ぶべきか?

現在、Microsoftのデータ統合サービスを検討する上で、従来の「Azure Data Factory(ADF)」と、新しい「Data Factory in Microsoft Fabric」のどちらを選択するかは、最も重要な意思決定の一つです。両者は同じ「Data Factory」の名前を冠していますが、そのアーキテクチャと最適なユースケースは異なります。

2つのData Factoryの違い

まず、両者の立ち位置と特徴の違いを以下の表で確認しましょう。

| 機能項目 | Azure Data Factory (ADF) | Data Factory in Microsoft Fabric |

|---|---|---|

| プラットフォーム | Azureの独立したサービス (PaaS) | 統合分析基盤「Microsoft Fabric」の一部 (SaaS) |

| データ変換 | マッピングデータフロー | Dataflow Gen2 (Power Queryベース) |

| 主要コンポーネント | リンクされたサービス, データセット, パイプライン | 接続, パイプライン |

| 対象ユーザー | データエンジニア、ITプロフェッショナル | データエンジニア、Power BI開発者、市民開発者 |

| 最適なシナリオ | 既存のAzureサービスとの連携、複雑なETL処理 | エンドツーエンドの分析基盤構築、セルフサービスBI |

Azure Data Factoryは、長年の実績がある成熟したサービスであり、Azure Synapse AnalyticsやAzure SQL Databaseなど、既存のAzureサービス群と深く連携する複雑なデータパイプラインを構築する場合に依然として強力です。

一方、Data Factory in Microsoft Fabricは、データ統合からデータエンジニアリング、データサイエンス、そしてPower BIによる可視化まで、すべてのプロセスを「OneLake」という単一のデータレイク上でシームレスに実行できる、次世代のSaaSエクスペリエンスです。特に、これから新しいデータ分析基盤を構築する場合には、第一の選択肢となるでしょう。

こんな方にはこちらがおすすめ

どちらのサービスを選ぶべきか、具体的なシナリオ別に推奨をまとめます。

-

Azure Data Factoryがおすすめな方

- 既にAzure Synapse Analyticsなどを中心としたデータ基盤を運用している。

- オンプレミスのSQL Server Integration Services (SSIS) のパッケージをクラウドへ移行したい。

- ファイルの到着などをトリガーにした、複雑なイベント駆動型のパイプラインが必要。

-

Data Factory in Microsoft Fabricがおすすめな方

- これから新しいデータ分析基盤をゼロから構築したい。

- Power BIを多用しており、データ準備から可視化までをスムーズに行いたい。

- データエンジニアだけでなく、アナリストや市民開発者もデータ準備に参加できるようにしたい。

2025年の最新動向

2025年現在、Microsoftのデータプラットフォーム戦略の軸足は、明らかにMicrosoft Fabricへと移っています。Data Factoryに関する技術革新や新機能の多くは、Fabric版を中心に展開されています。

開発の焦点がFabricへ

Microsoftは、今後のデータ統合機能のロードマップがFabric中心であることを示唆しています。例えば、Apache Airflowとの連携機能は、スタンドアロン版ADFでは既存顧客向けのメンテナンスモードとなり、今後はFabric版での利用が推奨されるなど、機能の移行も始まっています。

スタンドアロン版ADFの現在

開発の焦点がFabricに移ったからといって、スタンドアロン版ADFがすぐに使えなくなるわけではありません。むしろ、既存のAzure環境で安定稼働しているミッションクリティカルなデータ基盤を支えるサービスとして、今後も継続的なメンテナンスとサポートが提供されます。

実際に、Google BigQueryやPostgreSQLといった新しいデータソースへのネイティブコネクタの追加や、新しいAzureリージョンでのサービス提供開始など、機能改善やサービス拡充のアップデートは継続されています。

Azure Data Factoryの主要な概念

ここでは、主にスタンドアロン版のAzure Data Factoryを例に、その動作を理解する上で重要な3つの基本概念を解説します。これらの概念は、Fabric版では一部簡素化されていますが、基本的な考え方は共通しています。

パイプライン

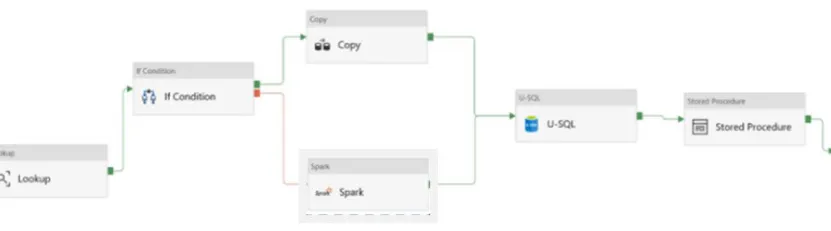

パイプラインの画像

パイプラインは、一連の処理(アクティビティ)をまとめて定義したものです。「データの抽出、変換、ロード」といった一連の作業を自動化するためのワークフローと考えることができます。

パイプラインは、決まった時間に実行(スケジュール実行)したり、特定のイベント(例: ファイルがストレージに置かれた)をきっかけに実行したりできます。

アクティビティ

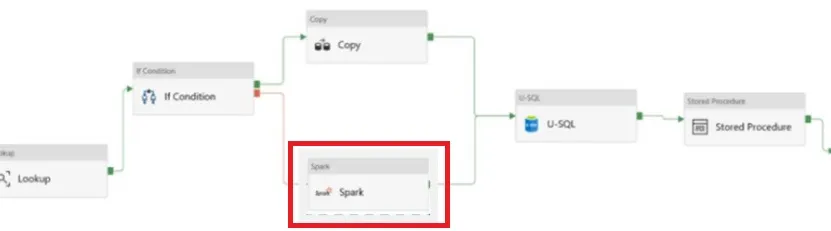

アクティビティの画像

アクティビティは、パイプラインを構成する個々の処理ステップです。代表的なアクティビティには以下のようなものがあります。

- データコピー: あるデータストアから別のデータストアへデータをコピーします。

- データフロー: 後述するマッピングデータフローを実行し、データの変換処理を行います。

- ストアドプロシージャ: データベースのストアドプロシージャを実行します。

これらのアクティビティを線でつなぎ、実行順序や依存関係を定義することで、パイプラインを構築します。

データセット

データセットは、アクティビティが利用するデータの「構造」を定義したものです。これは、操作したいデータがどのデータストアに(例: Azure Blob Storage)、どのような形式で(例: CSVファイル、特定のフォルダパス)存在するかを指し示す、いわば「データの住所録」のような役割を果たします。

注意: Microsoft Fabricでは、このデータセットの概念は「接続」に統合され、よりシンプルな構成になっています。

Azure Data Factoryの料金

このセクションでは、スタンドアロン版のADF V2の価格について解説します。

こちらがAzure Data Factoryの料金に関する情報を表にまとめたものです。

日本リージョンの価格をお示ししています。最新情報はこちらをご覧ください。

| サービスの種類 | 料金モデル | 備考 |

|---|---|---|

| オーケストレーション | ¥151.586/1,000 実行 | アクティビティの実行、トリガーの実行、デバッグ実行を含む |

| データ移動アクティビティ | ¥37.897/DIU時間 | Azure データセンターからデータを送信する際には、ネットワーク帯域幅の追加料金が発生する |

| パイプライン アクティビティ | ¥0.758/時間 ~ ¥151.586/時間 | 検索、メタデータの取得、削除などを含む。統合ランタイム上で実行される |

| 外部パイプライン アクティビティ | ¥0.037897/時間 ~ ¥151.586/時間 | Databricks、ストアドプロシージャ、HDInsight のアクティビティなどを含む。外部アクティビティの完全な一覧については、公式ドキュメントを参照。実行はリンクされたサービス上で行われる |

| Data Flow の実行とデバッグ | 汎用:仮想コア時間あたり ¥45.817 | 大規模なデータ変換を実現するData Factory内のコンポーネント。最小クラスターサイズは 8 仮想コア |

| メモリ最適化:仮想コア時間あたり ¥55.291 | ||

| 予約割引 | 1 年予約:最大 25% 割引、3 年予約:最大 35% 割引 | 汎用とメモリ最適化の両タイプで利用可能 |

Azure Data Factoryの料金は使用するサービスの種類やアクティビティの量、さらには選択する計算リソースによって変動します。オーケストレーションとデータ移動アクティビティは基本的な機能であり、より複雑なデータ変換や大規模データ処理にはData Flowの使用が推奨されます。また、長期的なプロジェクトには予約割引が有効で、コスト削減につながります。

見積もりは、Microsoftが提供しているAzureの料金ツールから算出することも可能です。

Azure Data Factoryの活用事例

ADFは、データ統合と自動化において様々な活用事例を提供します。データの移動から変換、統合までのプロセスをシンプルにし、効率的にすることで、企業がデータを最大限に活用できるよう支援します。

以下に、ADFを活用した具体的なシナリオを紹介します。

データ移行の支援

ADFを使用して、異なるデータストアやシステム間でのデータ移行を簡単かつ迅速に行うことができます。例えば、既存のデータセンターからクラウド環境への移行 を効率的に実施することが可能です。

【関連記事】

➡️Azureによるビッグデータ管理解説記事

Azure Data Lakeへのデータ取得

クライアントのサーバーやオンラインデータソースからデータを収集し、Azure Data Lakeに蓄積 することで、大規模なデータセットの分析と処理が容易になります。

データ統合プロセスの実行

他のSQLサーバーやSales forceなどの異なるソースからのデータを一元的に集め、統合することで、データの一貫性を保ちつつ、複数のデータソースにわたる分析が可能になります。

これにより、サイロ化されたデータを統合し、必要な処理を実施することが可能となり、データ分析の効率を大幅に向上させます。

ERPシステムからのデータ統合

複数のERPシステムからデータを収集し、Azure Synapse Analyticsに統合してロードすることで、高度な分析とレポーティングを実現します。

Azure Data Factoryの導入事例

ログの分析では、オンプレミスのデータストアにある参照データを使用し、クラウドのデータストアにある追加のログデータと統合して活用することがあります。

ADF導入事例参考:Microsoft

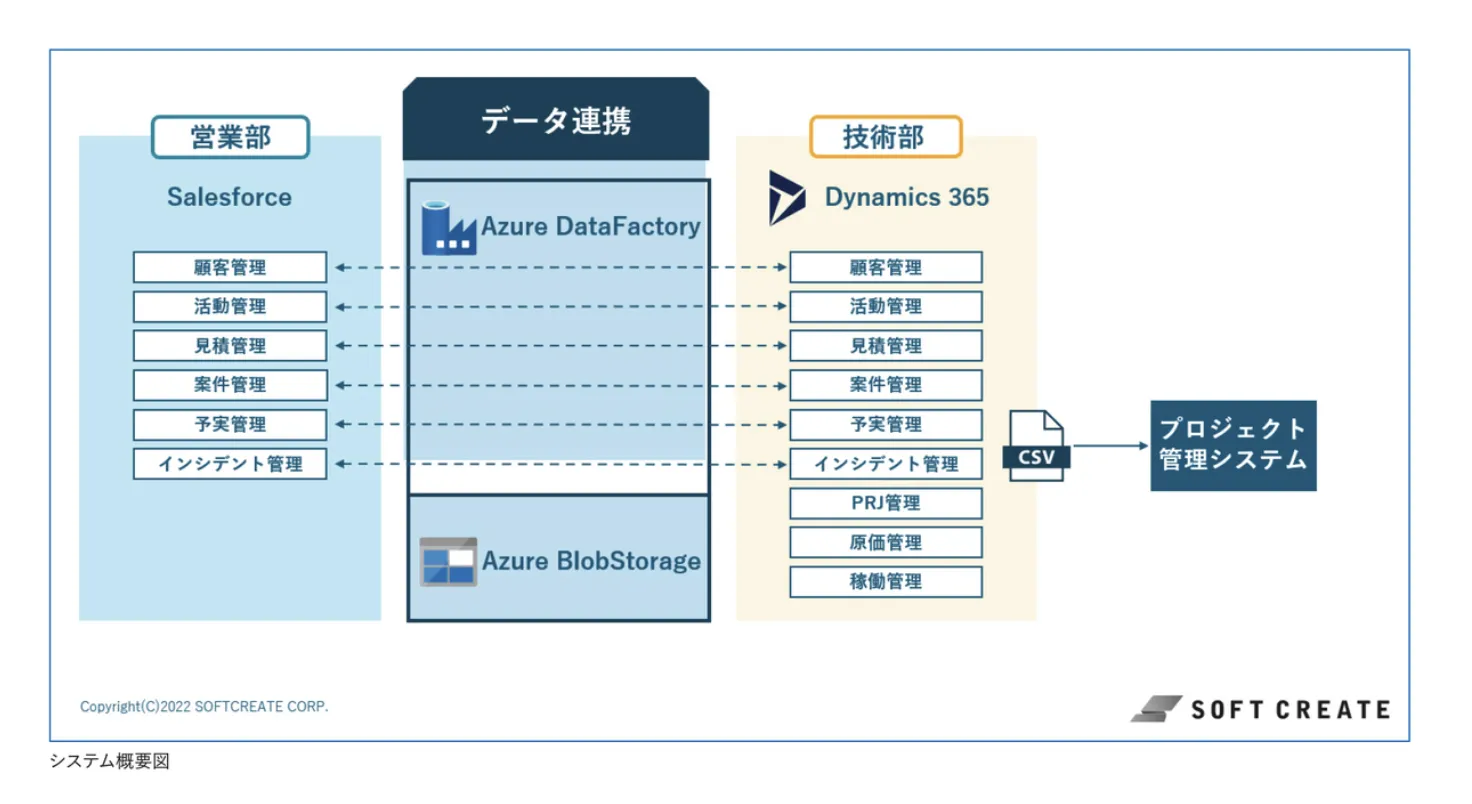

創業から35年以上にわたり、多彩なITサービスを提供してきた企業(ソフトクリエイト社の一例)です。主要な課題の一つは、顧客データを含む社内データをどのように一元管理するかでした。

ADFの活用により、ソフトクリエイトはSalesforceとMicrosoft Dynamics 365の間でデータ連携を実現しました。ADFを選定した理由として、クラウドサービス間の高度な連携能力、豊富なコネクタ数、コーディング不要での簡単なスタート、そしてAzureサービスとの親和性の高さが挙げられます。これにより、ソフトクリエイトは、スモールスタートからトライ&エラーを重ねながら、迅速にデータ連携基盤を構築・リリースすることがでた事例です。

ADFを使用することで、データドリブンのワークフローを作成し、データの移動と変換を自動化することが可能です。これにより、生データを意味のある形式に整理し、より的確な意思決定を支援するデータレイクとデータストアを構築できます。

【関連ページ】

➡️導入事例特集ページ

【無料DL】AI業務自動化ガイド(220P)

Microsoft環境でのAI活用を徹底解説

Microsoft環境でのAI業務自動化・AIエージェント活用の完全ガイドです。Azure OpenAI、AI Agent Hub、n8nを活用した業務効率化の実践方法を詳しく解説します。

まとめ

本記事では、データ統合のための強力なクラウドベースのサービスであるAzure Data Factoryについて詳しく解説しました

Azure Data Factoryは、多様なデータソースからのデータ入力や出力を可能にし、データ駆動型ワークフローの作成とETLプロセスの自動化を実現します。

このサービスを適切に活用することで、企業が持つ貴重なデータリソースを最大限に活かし、ビジネスの意思決定やオペレーションの最適化に役立てることができるでしょう。

Azure Data Factoryの基本的な機能から実際の使用例まで、この記事で得た知識を活かして、自社のデータ統合・データ管理の取り組みを一歩前進させてみてください。