この記事のポイント

ローカルLLMは、クラウドではなくPCや自社サーバーで動作する大規模言語モデル

データの完全なコントロールが可能で、機密情報も安全に扱える

通信遅延なしの高速応答、API利用料不要で長期的なコスト削減も実現

導入には、GPU/CPU、大容量メモリ、実行環境(Ollama等)の構築が鍵

モデル圧縮・量子化技術の進展で、ローカルLLMのエッジデバイスへの展開も加速

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

クラウド上のAIサービスが主流となる中で、「データは手元に置きたい」「外部ネットワークに依存せずAIを使いたい」というニーズが高まっています。

しかし、大規模言語モデル(LLM)を自前で動かすには、高度な知識や多大なコストがかかる、と諦めていませんか?その解決策となるのが「ローカルLLM」です。

本記事では、この「ローカルLLM」について、基礎から応用までをわかりやすく解説します。

ローカルLLMの仕組み、メリット・デメリット、必要なハードウェア、主要なフレームワーク、そして今後の展望まで、幅広く網羅的に説明します。

ローカルLLM とは

ローカル LLMとクラウドLLMの比較

ローカル LLM(Large Language Model)とは、クラウド環境ではなく、PCやオンプレミスサーバーなどのローカル環境で稼働する大規模言語モデルを指します。

インターネット接続を前提とせず、推論(回答生成)を手元で完結できるのが特徴です。これにより、プライバシーの確保や特定用途への最適化といった利点を得ることができます。

一方で、モデルの初回ダウンロードやアップデート、外部データ参照(検索/RAG)を行う場合はネットワークを使います。

「推論はローカルで完結するが、導入・運用ではネットワークを使う場面もある」と捉えると混乱しにくいでしょう。

実行方法としては、

- GPUを活用した高速推論(CUDA対応のNVIDIA GPUなどを使用)

- CPUのみでの軽量推論(GGUF形式を利用した量子化モデルを実行)

などがあり、リソースに応じて柔軟に選択できます。

また、実行用のツールとしては、Ollama、LM Studio、Text Generation Web UIなどが代表的です。

ローカルLLMのメリット

ここでは、ローカル LLMを導入する際の主なメリットを詳しく解説します。

1. プライバシーの確保

ローカルでのLLM運用は、データが外部APIに送信されないため、情報漏洩リスクを大幅に低減できます。

機密情報を扱う企業や研究機関にとっては、社外流出を防ぐうえで非常に重要なポイントです。

2. 応答速度の向上

クラウド経由だとネットワーク遅延が発生しがちですが、ローカル環境なら通信時間がほぼゼロのため、リアルタイム性が求められるアプリケーションでも高速応答が期待できます。

特に、社内ネットワーク・閉域網での利用では、体感差が出やすいです。

3. コスト削減

クラウドのLLMサービスは、API使用料やリクエストごとの課金が積み重なる傾向にあります。

一方、ローカルLLMであれば、初期コスト(GPUやサーバーなどのハードウェア導入費用)はかかるものの、長期的にはランニングコストを抑えやすくなります。

4. カスタマイズの自由度

クラウドベンダーのサービスでは提供されない細かな設定やチューニングが、ローカルなら自由に行えます。

自社の業務データやドメイン特化型のデータセットを用いたファインチューニングや、RAG(検索拡張生成)によって、独自色の強いモデル運用が可能です。

ローカルLLMの課題

一方で導入にはどのような課題があるでしょうか。

- ハードウェアの初期投資

GPUや大容量メモリなどを揃える必要があり、初期コストが高くなる場合がある

- モデルの更新・管理

バージョンアップや脆弱性対応を自社で追随・適用する手間

- 環境構築の難易度

OSやドライバ、CUDA、ライブラリの整合など、導入時の設定に手間がかかる

- ライセンス/利用規約・ガバナンス

モデルごとに配布条件や再配布条件が異なり、社内利用・商用利用・提供形態(API提供等)で注意点が変わる

このように運用や実装をする技術者がいるかどうかは大きな課題となります。

ローカルLLMの実装に必要なハードウェア

ローカル LLM の実装に必要なハードウェア

ローカルでLLMを実行するには、ある程度の計算リソースが求められます。代表的なものを挙げると、以下のとおりです。

-

GPU(グラフィックボード)

- LLMの推論を効率的に行ううえで重要

- 例として、RTX 4090クラスの民生GPUから、ワークステーション/サーバー向けGPUまで選択肢がある

-

CPU(中央処理装置)

- GPUが利用できない場合でも、量子化モデル(GGUF形式など)ならCPUのみで推論を実行可能

- 大規模な推論では高性能CPUを推奨

-

RAM(メモリ)

- モデルサイズに応じて16GB~128GB以上が必要

- GPUメモリだけでなく、システムRAMの容量も重要

モデル規模と必要VRAM/RAMの目安

モデルの必要メモリは「パラメータ数 × 精度(bit)」で大きく変わります。ここでは運用でよく使われる4bit/8bit量子化を前提に、目安を置きます。

| モデル規模(例) | 代表的な用途 | 目安(GPU VRAM) | 備考 |

|---|---|---|---|

| 3〜4B | 端末向け/軽量チャット | 6〜8GB | 量子化で動かしやすい |

| 7〜9B | 汎用チャット/簡易RAG | 10〜16GB | 実務バランスが良い |

| 12〜15B | 推論/要約/コード補助 | 16〜24GB | 精度と負荷の折衷 |

| 27B前後 | 高品質チャット/分析 | 24〜48GB | 量子化でも余裕が欲しい |

| MoE/超大規模 | 本格運用/高負荷 | 48GB〜/複数GPU | 推論サーバー前提になりやすい |

※これはあくまで目安です。コンテキスト長、バッチ、KVキャッシュ、推論エンジン、量子化方式で必要量は大きく変わります。

【関連記事】

➡️生成AI向けPC22選!用途別のおすすめパソコン・選び方を徹底解説

ローカルLLMの選び方(用途別の考え方)

おすすめモデルを見る前に、用途で「何を優先するか」を決めると選定が速くなります。

- まずPoCを回す(導入難易度を下げたい)

量子化モデル+Ollama/LM Studioで始め、社内データ連携は小さくRAGから試す。 - 業務で毎日使う(品質と再現性が必要)

長文対応、関数呼び出し、推論サーバー(vLLM等)を前提に設計し、評価指標(精度/上書き率/処理時間)を置く。 - 機密性が最優先(データを外に出せない)

ネットワーク分離、監査ログ、モデル/依存パッケージの更新手順まで含めて運用設計する。 - 端末で動かしたい(エッジ/オフライン寄り)

3〜4B級の軽量モデルを選び、量子化・推論ランタイム最適化(GGUF等)を重視する。

おすすめのローカルLLM

ローカルLLMの運用においては、オープンモデル(open-weight)を活用するケースが一般的です。以下のようなモデルが近年注目を集めています。

| ベンダー/コミュニティ | 代表モデル | パラメータ規模例 | ライセンス/規約 | 特徴・補足 |

|---|---|---|---|---|

| OpenAI(open-weight) | gpt-oss-20b / gpt-oss-120b | 20B / 120B(MoE) | Apache 2.0 | 推論向けのopen-weightモデル。ローカル/自前環境での活用が進む。 |

| Gemma 3(1B/4B/12B/27B) | 1B〜27B | Gemma Terms of Use | 4B以上は長文(128K)やマルチモーダル入力に対応し、軽量〜高品質まで幅が広い。 | |

| Gemma 3n(2〜4B級) | 2〜4B級 | Gemma Terms of Use | 端末実行を意識した省リソース設計で、エッジ用途の選択肢になりやすい。 | |

| Microsoft | Phi-4-reasoning / Phi-4-mini-instruct | 14〜15B級 / 3.8B | MIT | 小型〜中型の推論・指示追従を狙ったopen-weightモデル群。軽量モデルは端末用途でも扱いやすい。 |

| Mistral AI | Mistral Small 3.1 | 24B | Apache 2.0 | 24B級の実用モデルとして採用例が多い。長文対応や実装周辺が整っている。 |

| Meta | Llama 4(Scout / Maverick) | (モデルにより) | Llama 4 Community License | 高性能で注目度が高い一方、利用形態や規模によって制限があるため要確認。 |

| DeepSeek | DeepSeek-R1-0528 | (モデルにより) | MIT | 推論・コードで評価が高く、派生も多い。ローカル実装の選択肢として定着。 |

| Alibaba(Qwen) | Qwen3-235B-A22B など | 235B(MoE/22B active) | Apache 2.0 | 多言語・コード・推論で採用例が増えている。MoE構成のため設計時は推論条件に注意。 |

| Databricks | DBRX 132B | 132B(MoE) | Databricks Open Model License | MoE系の大規模モデル。配布・提供形態の条件があるため、商用は特に確認が必要。 |

ローカルLLMの実行方法

ローカルLLMの実行は大きく分けて以下の2つのアプローチがあります。

- GPUを活用した高速推論

- CUDA対応のGPUを利用し、高速な推論を実現

- ミドル〜ハイエンドGPUが必要になる場合が多い

- CPUでの軽量推論

- 量子化モデル(GGUFなど)を使ってメモリ占有を削減

- 高速性はGPUほどではないが、環境構築やコスト負担を抑えられる

ローカルでLLMを扱うための主要フレームワーク・ライブラリ

ローカルでLLMを扱うためのツールや推論基盤は複数存在します。

用途(まず触る/本番に載せる/端末で回す)で選ぶと迷いにくいです。

| ツール名 | 操作形態 | 対応モデル例 | 主な用途 | 対応OS |

|---|---|---|---|---|

| Llama.cpp | CLI / C++ | GGUF(量子化) | 軽量・高速。CPU中心で扱いやすい | Windows / macOS / Linux |

| Ollama | CLI + API | 主要open-weight各種 | 簡単実行・モデル管理・API化 | Windows / macOS / Linux |

| LM Studio | GUI + REST API | GGUF、Ollama互換等 | GUI操作+API提供で統合しやすい | Windows / macOS / Linux |

| Hugging Face Transformers | Python API | モデル全般 | 実験・研究・実装の標準ライブラリ | 全OS(Python環境要) |

| vLLM / TGI など | サーバー | 主要open-weight各種 | 本番推論サーバー、並列処理 | Linux中心 |

Llama.cpp

MetaのLlama系を含む各種モデルを、軽量かつ高速に動かすC++ベースのランタイムです。量子化したGGUFモデルを使えばCPUでも実行可能で、組込みやエッジ用途に適しています。

CLIベースのためコマンド操作が必要ですが、低メモリ環境でも動作します。

Ollama

CLIで簡単にモデルの取得と実行ができ、ローカルでAPIとして呼び出す運用に向いています。モデルの切り替えや自動化が容易で、まず触る導線としても定番です。

社内ツールやチャットUIとつなぐ場合は「APIとして扱えるか」を最初に確認するとスムーズです。

LM Studio

ローカルLLMをGUIで操作できるデスクトップアプリです。モデル検索・ロードが簡単で、APIを提供することで他アプリとの統合も可能です。

非エンジニアにも使いやすく、PoCや検証で選ばれやすいツールです。

【関連記事】

▶︎LM Studioとは?機能・ローカルLLMの使い方・最新アップデートを紹介

Hugging Face Transformers

PyTorchやTensorFlow上で動作する標準ライブラリで、モデルの実装・カスタマイズ・ファインチューニングに強力です。

研究から製品開発まで幅広く使われ、エコシステムも充実しています。

vLLM / TGI など(本番推論向け)

同時アクセスが増える場合は、単体PCのツールだけではスループットが出にくくなります。

その場合、vLLMやText Generation Inference(TGI)のような推論サーバーを前提に設計すると、本番運用に寄せやすいです。

Google ColabでLLMを使ってみた(クラウドでの動作確認)

※ここは「ローカル環境」そのものではありませんが、まずモデルの挙動を試すという目的では有効です。

ローカル導入前に「生成の癖」「速度感」「必要メモリ感」を掴む用途として紹介します。

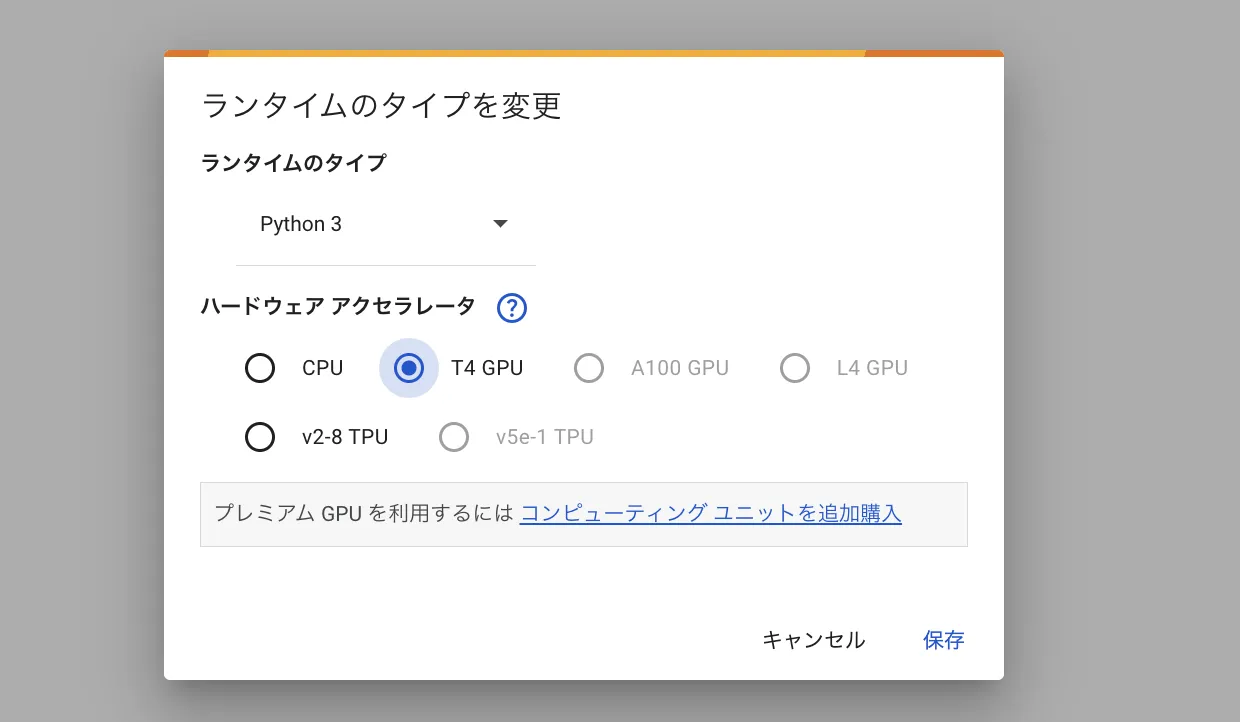

1. Notebookの準備

- Google Colabを開き、新しいノートブックを作成します。

- メニュー上部の「ランタイム」→「ランタイムのタイプを変更」をクリックし、**ハードウェアアクセラレータを「GPU」 に設定します。

ランタイムのタイプを変更

2. ライブラリのインストール

Colabのセルに以下のコマンドを入力し、ライブラリをインストールします。

!pip install transformers accelerate einops

- transformers: Hugging Faceの高機能なモデル実装ライブラリ

- accelerate: GPU割り当てや分散を扱いやすくするライブラリ

- einops: 行列演算のユーティリティ(モデルによっては必要)

3. 小規模モデルのロード・推論

ここでは例として、比較的軽量なオープンモデル「Phi-4-mini-instruct」を使います。

小型モデルでも指示追従や関数呼び出し周りの検証ができ、PoCの入口として扱いやすいです。

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "microsoft/Phi-4-mini-instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

torch_dtype=torch.float16

)

prompt = "ローカルLLMを企業で導入するときの注意点を3つ、短く教えてください。"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

with torch.no_grad():

output = model.generate(

**inputs,

max_new_tokens=150,

do_sample=True,

top_p=0.9,

temperature=0.7,

eos_token_id=tokenizer.eos_token_id

)

print(tokenizer.decode(output[0], skip_special_tokens=True))

4. 実行時の注意点

- セッション切断対策: Colabの無料枠ではセッションがリセットされることがあります。再現できるよう、設定やメモは残しましょう。

- GPUの割り当て: 割り当てられるGPUや利用時間には制限があり、大きいモデルは動かしにくい場合があります。

- 速度・メモリ限界: エラーになった場合は、生成トークン数を下げたり、より小さいモデルに切り替えたりして調整します。

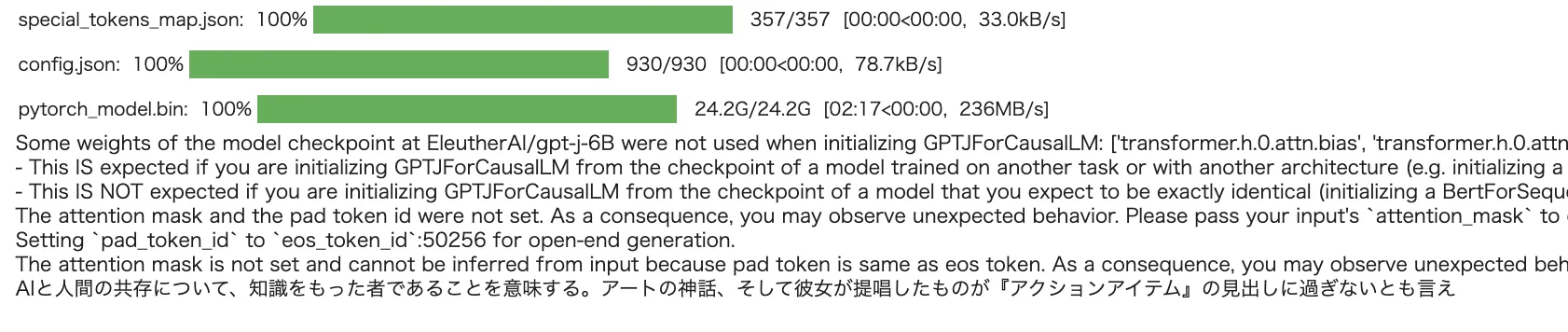

実演結果のイメージ

上記のスクリプトを実行すると、プロンプトに対して続きのテキストが生成されます。

たとえば以下のような応答が得られるかもしれません(あくまでも一例です)。

出力イメージ

ローカルLLM導入で注意すべき点は、(1) データ持ち出しルールと監査ログ、(2) モデル更新と脆弱性対応の運用、(3) ライセンス/利用規約の確認です。...

ローカル LLM の今後の展望

今後、モデル圧縮や量子化技術のさらなる進歩により、より軽量なLLMが登場すると考えられます。これにより、エッジデバイスやモバイル端末への組み込みも一層進むでしょう。

また、推論基盤(推論サーバー、KVキャッシュ最適化、分散推論など)の成熟により、ローカルLLMの本番運用ハードルも下がっていくと見られます。

IoTやエッジデバイスなどに搭載され、ハードウェアでのAI活用が進むことが非常に楽しみです。

【関連記事】

➡️AIの蒸留(蒸留モデル)とは?その仕組みや実装例をわかりやすく解説!

AI導入でお悩みの方へ

まとめ

- ローカル LLMは、データを手元で管理しつつ大規模言語モデルの恩恵を受けられるアプローチ。

- メリットはプライバシーの確保、応答速度向上、コスト削減、カスタマイズ性など。

- 課題としては、初期投資の高さや管理運用の複雑さ、ライセンス/ガバナンス面が挙げられる。

- 今後はモデル圧縮や量子化技術、推論基盤の進化により、より多様な環境への展開が期待される。

企業や研究機関で機密性の高いデータを扱う場合や、大規模な推論リクエストが想定されるプロジェクトでは、ローカル LLM の導入を検討する価値は十分にあるでしょう。クラウドとローカルのメリットを比較検討し、最適な運用スタイルを選びましょう。