この記事のポイント

NVIDIAのGPUがChatGPTなどの高度なAIモデルを支える重要性

ARMとNVIDIAの関係性とソフトバンクの戦略

ARMの売却試みとその後の成功裏のIPO

NVIDIAのGPUによるAI学習・推論の高速化とクラウドAIサービス

ソフトバンクとNVIDIAの今後の関係性の可能性

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

人工知能の発展には技術的な基盤が欠かせません。特に対話型AIモデルであるChatGPTのような高度なモデルを動作させるためには、強力な計算能力が必要とされます。

本記事では、そのようなAI技術の発展を支えるNVIDIAの役割と、SoftBankが所有するARMと連携したNVIDIAの戦略について解説していきます。

また、ARMのNVIDIAへの売却試みやその後のIPOについても、孫正義氏のビジョンとともに紐解いていきます。

NVIDIAのGPUがAIのリアルタイム処理をどのように支えているのか、チップからクラウドまで、AIニーズを満たすためのNVIDIAの動きを詳しくご紹介していきます。

ChatGPTの新料金プラン「ChatGPT Go」については、以下の記事をご覧ください。

ChatGPT Goとは?料金や機能、広告の仕様、Plus版との違いを解説

ChatGPTの概要

ChatGPTの画像

ChatGPTは、OpenAIによって開発された人工知能ベースの対話型モデルです。自然言語処理を用いて、ユーザーからの質問やコメントに対して自然で流暢な回答を生成します。

このシステムは、大量のテキストデータから学習し、文脈に基づいて適切な応答を行う能力を持っています。

ChatGPTは多くの用途に応用されており、顧客サービス、教育、エンターテイメントなど、さまざまな分野で利用されています。

NVIDIAの概要

NVIDIAのロゴ

NVIDIAは、グラフィックス処理ユニット(GPU)の開発で知られる半導体企業です。同社の製品は、大規模言語モデルの運用において中核的な役割を果たしています。

NVIDIAのGPUは並列処理能力に長けており、大量のデータを扱う複雑な言語モデルの学習や推論を高速に実行できます。

OpenAIが開発したChatGPTなどの大規模言語モデルでは、NVIDIAのDGX AIシステムやH100などのGPUが重要な計算基盤として活用されてきました。

さらにMicrosoftとの提携によって、NVIDIAのGPUを活用したクラウド基盤の開発が進められており、AIモデルの実用化が加速しています。医療、金融、エンターテイメントなど、幅広い業界でNVIDIAのAI技術が活用されています。

GPU テクノロジーの貢献

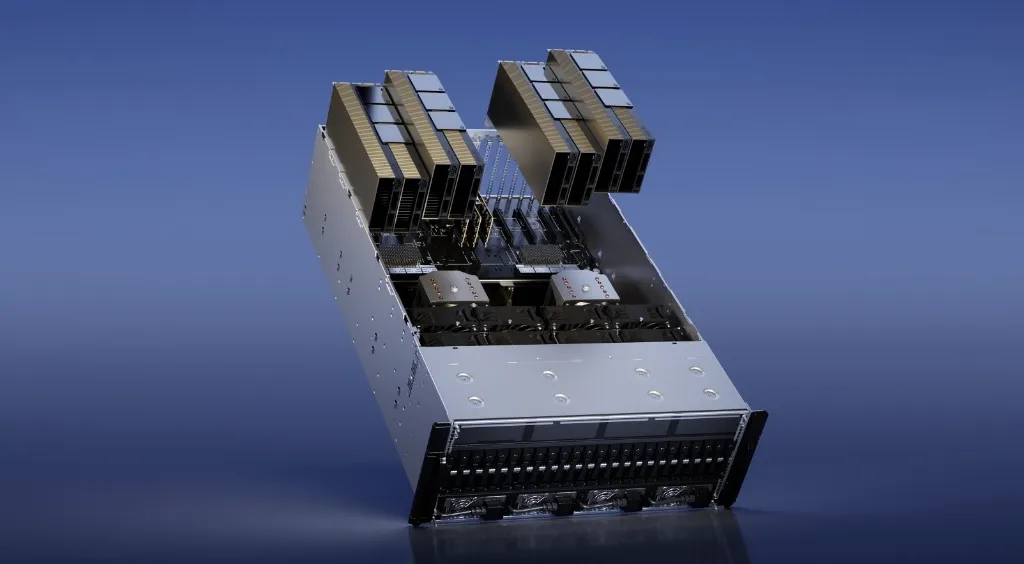

NVIDIA H100 Tensor コア GPUの画像 (出典)NVIDIA)

GPU(グラフィックス処理ユニット)は、複雑な計算処理を行うための高性能なコンピューター機器で、NVIDIAがこの分野で大きな役割を果たしています。

2023年3月には、NVIDIAがAI特化型の最新GPUモデル「H100」を発表しました。

H100はAIモデルの学習と推論に必要な高い計算能力を提供し、従来はCPUが担っていた推論処理もこのGPUで効率的に行えるようになりました。

NVIDIA H100 Tensor Core GPUを使うことで、推論性能が30倍、モデル学習性能が4倍向上しています。

これにより、多くの業界でAIの実用化が進んでいます。

ChatGPTとNVIDIAの関係性

ChatGPTは、NVIDIAのAIプラットフォームを活用した対話型モデルです。

ChatGPTは大量のデータから学習し、それに基づいて回答を生成するAIモデルです。このようなAIモデルが複雑な質問に答えるためには、非常に多くの計算処理能力が必要になります。

NVIDIAは、世界初のAI開発プラットフォーム「NVIDIA DGX AIシステム」をOpenAIに提供し、ChatGPTを含む多くのGPTモデルの開発を後押ししてきました。

さらに、Microsoftと共同で、ChatGPTなどの大規模言語モデルを効率的に処理できるクラウド基盤を開発しています。

こうした最先端技術により、ChatGPTなどのAIモデルの構築や運用が大幅に効率化されています。

NVIDIAのエッジAIとクラウドAI

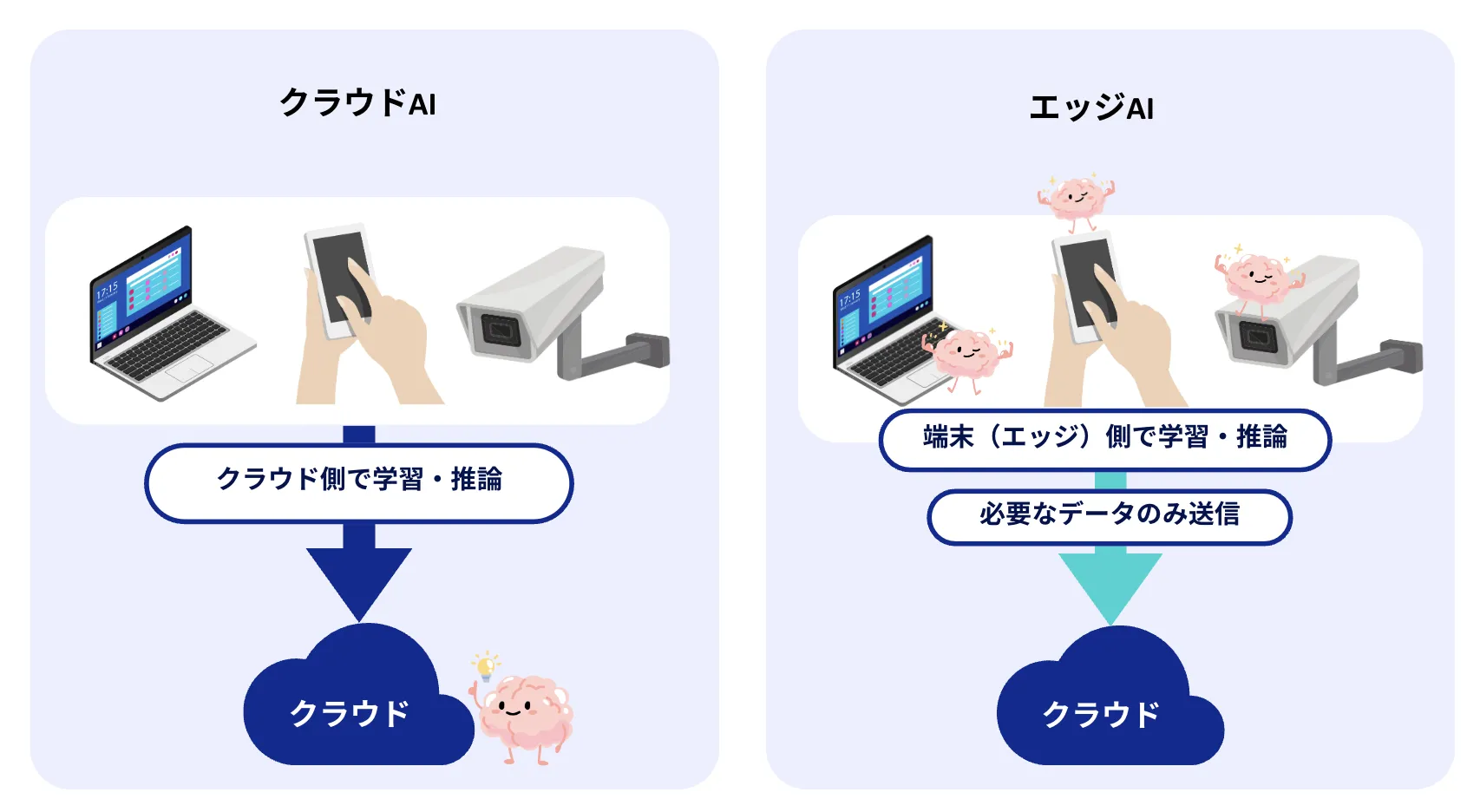

NVIDIAは、エッジAIとクラウドAIをサポートしています。

これらはAIテクノロジーを活用する二つの主要な方法で、処理の場所とデータの扱いに大きな違いがあります。

エッジAIはデータの発生源である端末で直接データ処理を行い、リアルタイム性とプライバシー保護が求められる場面に適しています。

一方、クラウドAIはChatGPT等のデータセンターやクラウドでの処理を行い、大規模なデータセットや複雑なAIモデルの学習に適しています。

エッジAIとクラウドAIの違い

エッジAIとは

エッジAIは端末上でのデータ処理を特徴とし、NVIDIAのJetsonシリーズがこれに対応しています。

この技術は、高速な応答時間、データのプライバシー保護、低通信コストを提供し、インターネットが不安定な環境でも機能します。

【関連記事】

➡️エッジAIとは?その概要や活用事例、クラウドAIとの違いを徹底解説!

クラウドAI

クラウドAIとは、データセンターやクラウド基盤上で人工知能によるデータ処理を行う技術を指します。

この技術は、NVIDIAのTeslaやA100、H100などのGPUを使用して、ChatGPTのようなクラウドデータセンターでの大規模AI処理を可能にします。

高い計算能力、大容量ストレージ、柔軟なリソース拡張性を提供しますが、インターネット依存性と高コストが課題です。

NVIDIAは、AzureやAWSといったクラウドプロバイダーと協力して、クラウドベースのAIサービスを提供しています。

【関連記事】

➡️クラウドAIとは?エッジAIとの違いやメリット、主要サービスを解説

ローカルLLMとNVIDIAの関係性

NVIDIAはハードウェア・ソフトウェアの両面から、ChatGPTに代表される大規模言語モデルの基盤を支え、ローカルとクラウドの両環境において言語AIの発展に貢献しています。

このセクションではローカルLLMとNVIDIAの関係性について詳しく説明して行きます。

ローカルLLMとは

ローカルLLMとは

ローカルLLM(大規模言語モデル)とは、インターネット接続なしで端末上で動作するAIモデルのことです。

このモデルはファイルとして公開されており、ユーザーはそれをダウンロードして自分のコンピューターや端末上で直接、AIモデルの推論を実行することができます。

クラウド上のAPIを利用する代わりにローカルでモデルを実行する主な利点は、以下の通りです。

- インターネット環境に左右されずに動作できること

- 提供元の仕様変更に影響を受けない安定した利用が可能なこと

- 使用期限の制約がなく長期に渡って同じモデルを活用できること

一方で、ローカルLLMには課題も存在します。端末上で直接モデルを動作させる必要があるため、高い計算リソースを要求されるのが大きなデメリットです。

パソコンなどの自前の計算環境を用意しなければならず、その性能が不十分だと制限を受ける可能性があります。また、多数のユーザーにサービスを提供する場合、各ユーザーの端末性能に依存してしまいます。

ローカルLLMとハードウェアの高速化への貢献

NVIDIAは高性能なグラフィックス処理ユニット(GPU)を提供しており、ディープラーニングや機械学習、特に言語モデルの分野で計算速度を大幅に向上させる役割を果たしています。

ローカル環境で大規模言語モデル(LLM)を動作させる際には、TeslaやA100、最新のH100などのNVIDIAのGPUが、モデルの学習と推論を中心的に担います。

ソフトウェアとエコシステムの提供

NVIDIAは、GPUに最適化されたソフトウェアのリポジトリを公開しています。ここからディープラーニングのフレームワークやモデル、各種ライブラリなどを簡単にダウンロードして利用できます。

このリポジトリの提供により、ローカルでLLMを構築・実行するための技術的ハードルが下がります。

Chat with RTX - NVIDIAのローカルチャットボットツール

NVIDIAは「Chat with RTX」という無料のツールを提供しています。

これは、NVIDIA製のグラフィックカード(GeForce RTX 30シリーズ以降)を搭載したWindows PCで動作するチャットボット作成ツールです。

Chat with RTXは、ユーザーのPC内にあるファイルやYouTubeの動画・プレイリストを学習データとして使用し、それらの内容に関連した質問に回答できるパーソナライズされたチャットボットを作成できます。

このツールは、NVIDIAのグラフィックカードの性能を活かして高速に動作し、インターネット接続がなくてもローカルのPC上で動作するため、プライバシーが保護されるのが特徴です。

Chat with RTXは、NVIDIAがハードウェアとソフトウェアの両面から、チャットボットに代表される大規模言語モデル(LLM)の発展を支援している良い例と言えるでしょう。

NVIDIA・ARM・ソフトバンクの関係性

時間軸に沿って整理すると、以下のようにNVIDIA、ARM、およべソフトバンクの関係性を説明できます。

2016年:ソフトバンクによるARMの買參

SoftbankとARMの画像

ソフトバンクグループは、孫正義氏の指揮のもと、約320億ドルでARMを買収しました。この買収を通じて、ARMのビジネスを成長させることを目指し、長期的な投資として位置付けられました。

ARMについて

ARMはイギリスに拠点を置く半導体企業で、AIが活躍する社会の中心となるコンピューティングの各領域で、設計、安全性、管理を支える先進的な技術を提供**しています。

この会社はチップからクラウドに至るまで、幅広い技術的要素に対応しており、産業全体の基盤となる機能を持っています。

(参考)当社によるARM買収の提案に関するお知らせ|2016年7月18日ソフトバンクグループ株式会社

2020年:NVIDIAによるARM買収の試み

NVIDIAはARMを400億ドルで買収しようとしましたが、独占禁止法の問題で規制当局の承認が得られず、最終的にこの計画は中止されました。

この買収計画では、NVIDIAとARMの技術を統合し、AI業界を牽引する一つの大企業を形成することを目指していました。

NVIDIAは英国ケンブリッジにAIリサーチセンターを設立する予定であり、技術革新の拠点としてARMを強化する計画でしたが、これは実現しませんでした。

その後のソフトバンクのARM保持

買収失敗後、ソフトバンクは引き続きARMの最大株主としての立場を保ち、経済的な課題に直面しながらも、ARMの成長とイノベーション創出を後押ししました。売却を模索しながらも、売却は行われませんでした。

ARMの新規株式公開(IPO)

ARMのIPOは大成功を収め、上場初日に株価は25%上昇しました。これにより、ARMは約7200億円を調達し、孫正義氏の戦略的な決断が投資家に安心材料を提供しました。

現状と今後の展望

NVIDIAがARMの買収計画を断念した後も、技術面での協力関係を維持しています。ARMが上場企業として市場に浸透したことで、NVIDIAとの協業がさらに進展する可能性があります。

ソフトバンクはARMの最大株主として、先端技術の開発を通じて業界の革新をリードする役割を担っています。

また、ソフトバンクは外国資本を日本に呼び込めるARMを保持していることは、日本が半導体分野で競争力を保つ上で重要な要素**の一つです。

この流れは、孫正義氏による戦略的なビジョンと長期的な投資が、時に予期せぬ形で大きな成果を生む可能性を示しています。

AI導入でお悩みの方へ

まとめ

NVIDIAの高性能GPUは、ChatGPTの複雑な言語処理を支える計算基盤となっており、リアルタイムでユーザーに高品質な応答を提供することを可能にしています。さらにMicrosoftとの協業を通じて、クラウドベースの計算リソースを柔軟に拡張できるようになり、ChatGPTなどのAIアプリケーションの大規模化とユーザー層の拡大に貢献しています。

このようなハードウェアとソフトウェア、クラウドの連携は、より高速で正確なAIモデルの開発環境を整備しつつあります。NVIDIAの先端技術とクラウドプロバイダーとの協力関係は、AI分野におけるイノベーションの鍵を握っており、ChatGPTに代表される革新的製品の飛躍的な進化を後押ししていくことでしょう。

人工知能の未来を切り拓く上で、NVIDIAとChatGPTの協働は言語AIの領域における最も重要な事例と位置付けられるに違いありません。