この記事のポイント

GitHub Modelsは、40以上の主要AIモデルを検索・比較・評価し、アプリケーションに組み込める開発者向けプラットフォーム

統合モデルカタログにより、OpenAIやMeta、DeepSeekなどのモデルを単一APIキーで切り替えて利用可能

プロンプトを.prompt.yml形式でバージョン管理し、Gitワークフローの中でレビューや共有が行える

比較ビューや評価指標を用いた定量的なABテスト機能により、最適なモデルとプロンプトの組み合わせをデータに基づいて選定可能

無料枠でのプロトタイピングから、監査ログや予算管理を備えたエンタープライズ運用まで、段階的な導入に対応

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

「企業でAI開発を効率化したい」「複数のAIモデルを安全に管理・比較したい」というニーズに応えるため、GitHubは「GitHub Models」を展開しています。これは、AIアイデアの検証から本番運用まで、モデルカタログ、プロンプト管理、定量的評価を統合した開発者向けプラットフォームです。

本記事では、2025年12月時点の情報に基づき、GitHub Modelsの主要機能、料金体系、そしてプロンプトを「コードのように」管理・評価する具体的なワークフローについて解説します。

目次

GitHub Modelsとは?

GitHub Modelsは、GitHub上で複数のAIモデルを検索・比較・評価し、そのままアプリケーションに組み込める開発者向けプラットフォームです。

モデルカタログ、プレイグラウンド(実験環境)、プロンプト管理、評価機能を一体のワークスペースとして提供し、AIアイデアから本番運用までの流れをGitHubワークフローの中で完結させることを目指しています。

GitHub Modelsの位置づけをざっくり整理

ここでは、GitHub Modelsが「どんな課題をどのポジションで解決するプロダクトなのか」を、3つの観点からコンパクトに整理します。

1. エンタープライズAI導入のどこを埋めるプロダクトか

多くの企業では、

- PoCはノートブックや専用ツールで実施

- 本番運用は別チーム・別基盤で構築

という形になりがちで、「PoCでうまくいったプロンプトや設定が、本番で再現できない」というギャップがよく発生します。

GitHub Modelsはこのギャップを埋めるために、

- GitHub Marketplace上でモデルを試す(PoC)

- 「.prompt.yml」 と評価機能で、プロンプトやモデル設定をGitリポジトリに残す

- 同じ資産をGitHub Actionsやアプリケーションコードから呼び出す(本番)

という流れを、GitHub内だけで一貫させるための「モデル利用基盤」として位置づけられています。

GitHub Copilot / GitHub Sparkとの関係

GitHubのAI関連プロダクトの役割分担は、おおまかに次のように整理できます。

-

GitHub Copilot

IDEやGitHub上でコード補完・チャットを提供する「開発者体験向上ツール」。

裏側のリクエストは「Requests in GitHub Copilot」の枠組みで管理されます。

-

GitHub Models

開発者が自分のアプリケーションやワークフローから直接LLMを呼び出すための「モデル利用基盤」。

課金やレート制限はGitHub Models billingとして、Copilotとは別枠で管理されます。

-

GitHub Spark

AIアプリケーションのホスティングやテンプレートを提供する「AIアプリ基盤」で、内部でGitHub Modelsを含む各種モデルプロバイダーを利用するケースがあります。

本記事で扱っているGitHub Modelsは、「Copilotの裏側のモデル」ではなく、「ユーザー自身が直接叩くモデルAPI」という立ち位置と考えると理解しやすくなります。

どんなユースケースに向いているか

GitHub Modelsが特にフィットしやすいのは次のようなユースケースです。

- GitHub Enterpriseを使っていて、LLMをプロダクト内機能として組み込みたい開発チーム

- 複数ベンダー(OpenAI / Microsoft / Meta / DeepSeek / xAI など)のモデルを比較しながら、コストと品質のバランスを取りたいアーキテクト

- プロンプトや評価指標を、Gitリポジトリで共有・再利用できる形で管理したいプラットフォームチームやMLOps担当

一方で、

- まずは「VS Codeやブラウザの開発体験をAIで強化したい」だけならCopilot中心で十分

- 既にAzure AI Foundryや他社のLLM基盤に乗っている場合は、「プロンプト管理と評価だけGitHub Modelsを使い、推論エンドポイントはBYOKで既存基盤に寄せる」といったハイブリッド構成が現実的です。

このように、GitHub Modelsは「LLMそのもの」ではなく、複数モデルの比較・管理・運用を、GitHubワークフローの中で完結させるための土台と考えると、全体像がつかみやすくなります。

GitHub Modelsの主な機能・特徴

ここでは、GitHub Modelsの全体像をつかむために、4つの観点から主な機能をコンパクトに整理します。

具体的な設定方法やワークフローへの組み込み方は、後半の「料金・仕様」「基本の使い方」で詳しく解説します。

1. 統合モデルカタログと管理機能

GitHub Modelsの中核は、複数プロバイダーのモデルを横断して扱える統合モデルカタログです。

GitHub Modelsのモデルカタログは、次のようなモデルを含む、40以上のモデルに対応しています(2025年12月時点)。

| モデルプロバイダー | 代表的なモデル例 |

|---|---|

| OpenAI | GPT-4o / GPT-4.1 / GPT-4o mini / GPT-4.1 mini |

| Meta | Llama 3.1 / Llama 3.2 / Llama 3.3 系 |

| Microsoft | Phi-4 / Phi-4-mini / Phi-4-multimodal / Phi-4-reasoning |

| DeepSeek | DeepSeek-R1 / DeepSeek-R1-0528 / DeepSeek-V3-0324 |

| xAI | Grok-3 / Grok-3 Mini |

主なポイントは次の通りです。

-

単一APIキーで複数モデルを切り替え

プロバイダーごとに異なるエンドポイントや認証方式を意識せず、同じコードパターンでモデルを差し替えられます。

-

モデルごとの仕様・料金を横並びで比較

入力長の上限、無料枠のレート制限、有料時の料金乗数などを、Marketplace上で一覧できます。

-

ベンダーロックインを避けた評価がしやすい

「まず複数ベンダーを一通り試してから、本番採用モデルを決める」というワークフローを取りやすくなります。

2. 高度なプロンプト開発・管理システム

GitHub Modelsは、プロンプトを「コードに近い資産」として扱えるように設計されています。

-

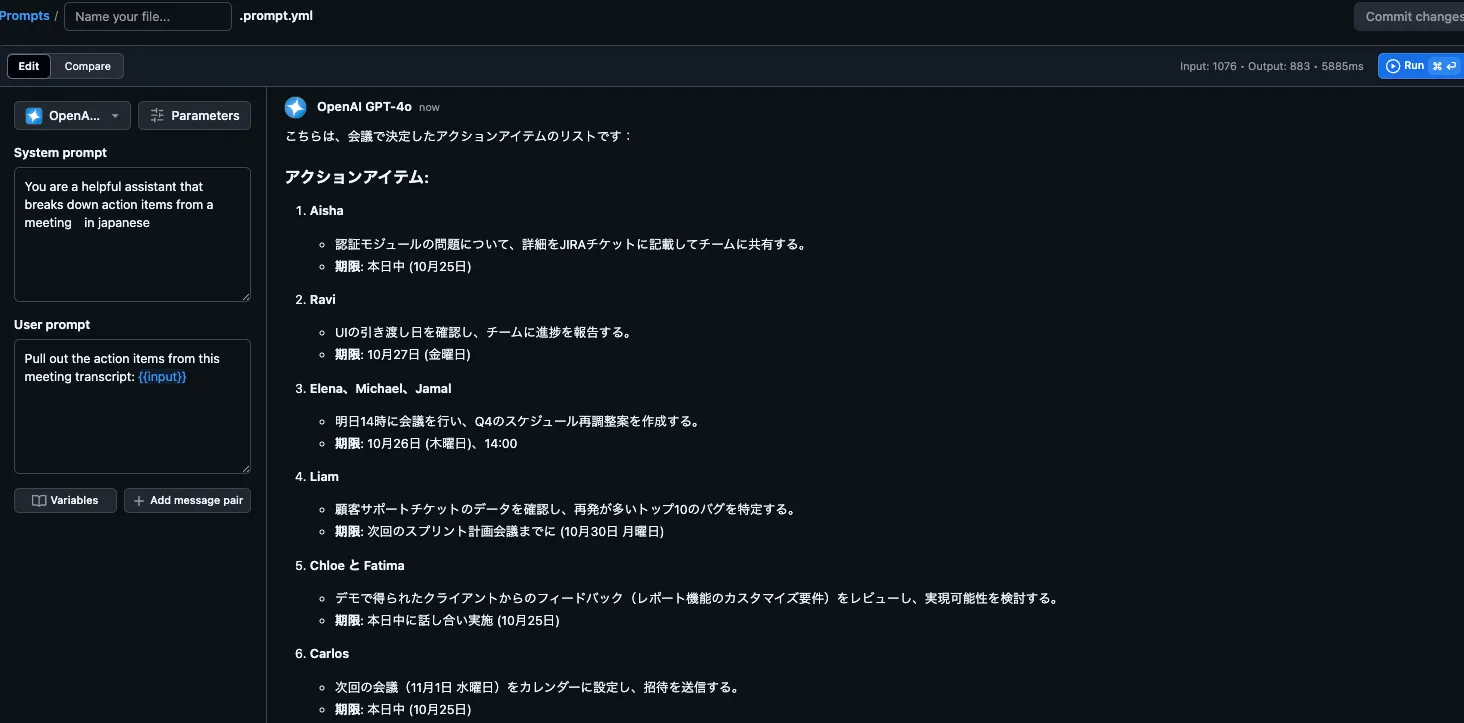

Playgroundでの構造化プロンプト編集

システムメッセージ・ユーザーメッセージ・変数(「{{input}}」 など)をGUI上で組み立て、複数モデルに同じプロンプトを投げて挙動を比較できます。

-

「.prompt.yml」 による保存・共有**

Playgroundで作ったプロンプトを、そのままリポジトリ内の「.prompt.yml」ファイルとして保存できます。

通常のソースコードと同じように、Pull Requestでレビュー・マージが可能です。

-

バージョン管理とレビューの対象になるプロンプト

「いつ・誰が・どんな意図でプロンプトを変更したか」をGitの履歴で追跡でき、属人化しがちなノウハウをチーム資産として残せます。

-

構造化出力・JSONスキーマ対応

JSONスキーマを指定して、後段のプログラムから扱いやすい構造化出力を得ることもできます。

単なるテキスト生成だけでなく、「LLMをAPIの一部として組み込む」使い方をしやすいのが特徴です。

3. 包括的評価・比較システム

GitHub Modelsには、複数モデル・複数プロンプトをまとめて評価できる仕組みが組み込まれています。

- 比較ビューによるモデル・プロンプトのABテスト

1つの評価データセット(例:質問と正解ラベルのCSV)に対して、「Prompts A/B/C × Models X/Y/Z」を一括実行し、出力とスコアをグリッド表示で比較できます。

- similarity / relevance / groundedness などの評価指標

参照ドキュメントとの一致度や、質問に対する適合度、回答の根拠性などを定量的に評価できます。

- カスタム評価プロンプト

社内規定に沿っているか」「必ず○○という注意書きを含んでいるか」など、独自ルールをチェックする評価プロンプトも定義可能です。

これにより、「どのモデル・どのプロンプト設定が、自社のユースケースにとって最適か」を、感覚ではなくスコアベースで比較できるようになります。

4. エンタープライズセキュリティ・ガバナンス

GitHub Modelsは、個人利用だけでなく、エンタープライズ利用を前提としたセキュリティ・ガバナンス機能を備えています。

-

GitHub/Azure内でのデータ処理

プロンプトや出力はGitHubおよびAzureのインフラ内で処理され、モデルプロバイダー側で学習目的に再利用されない設計が明示されています。

-

コンプライアンスフレームワークへの対応

GDPR、SOC 2、ISO 27001などの枠組みを前提に、どのモデルをどの用途で許可するかを検討できるようになっています。

-

監査ログ・クォータ・予算管理

モデル利用の記録やエラーログを監査ログとして確認でき、部門ごとの利用量やコストを可視化しながら、月間の予算上限を設定できます。

このように、GitHub Modelsは「個人の検証用ツール」というより、組織としてAI利用のルールづくり・運用統制まで含めて支援するプラットフォームという位置づけになっています。

GitHub Modelsの仕様・対応モデル

ここでは、GitHub Modelsが「どんな環境で・どのモデルにアクセスできるか」という仕様面を整理します。

利用条件(誰が使えるか)

GitHub Modelsは、個人アカウント、組織、GitHub Enterpriseのいずれからも利用できます。

-

個人・小規模チーム

- GitHub MarketplaceのPlaygroundや、軽いプロトタイプ用途で無料枠を利用可能

- GitHub MarketplaceのPlaygroundや、軽いプロトタイプ用途で無料枠を利用可能

-

組織・Enterprise

- エンタープライズオーナーがGitHub Modelsの利用可否(opt-in)を設定

- そのうえで、各組織オーナーが「利用を許可するモデル」や「利用上限」などを細かく制御

技術仕様とモデル対応

GitHub Modelsの技術仕様を簡潔に整理すると、次のようになります。

| 仕様項目 | GitHub Models | 詳細 |

|---|---|---|

| 対応モデル数 | 40以上(2025年12月時点) | OpenAI、Microsoft、Meta、DeepSeek、xAI、Mistral、AI21 Labs、Cohereなど |

| 代表的モデル | GPT-4o / GPT-4.1 / GPT-4o mini / Phi-4 / Meta Llama 3.1/3.2/3.3 / DeepSeek-R1 / Grok-3 等 | GitHub Marketplaceに一覧 |

| アクセス方法 | 統一API + GitHub CLI (gh models) |

モデルごとの差異は主にパラメータと料金 |

| プロンプト管理 | .prompt.yml |

Gitによるバージョン管理に対応 |

| 評価機能 | 類似性・関連性・根拠性・カスタム評価 | 比較ビューでABテストが可能 |

| インターフェース | Web UI, REST API, CLI, VS Code / AI Toolkit | Copilot Chat拡張機能からの利用も可能 |

| セキュリティ | GitHub/Azure内データ処理、学習への非利用、監査ログ | GDPR / SOC 2 / ISO 27001等の観点で検討可能 |

| カスタムモデル | BYOK(独自APIキー) | Azure OpenAIなど外部契約を接続可能 |

ここで重要なのは、課金とセキュリティが「GitHub Models」単位で整理されているという点です。

GitHub Copilotとは別枠で料金・トークン利用が管理されるため、「Copilotの利用上限」と「自社アプリケーションでのLLM利用上限」を切り分けて設計できます。

拡張機能とツール連携

GitHub Modelsは、ブラウザだけでなく、CLIやIDEからも利用できます。代表的な連携は次の通りです。

-

GitHub CLI拡張機能

github/gh-models を利用すると、ターミナルからモデルに対してプロンプトを送信したり、「.prompt.yml」を指定して推論を実行したりできます。

CIの一部としてエバリュエーションを回したい場合にも有効です。

-

GitHub Copilot Chat向け拡張(GitHub Models extension)

Copilot Extensionsの一種として、Copilot Chat内からGitHub Modelsのモデルにアクセスし、「今リポジトリで使っているプロンプトセット」を直接呼び出すような連携が可能です。

-

Visual Studio Code用 AI Toolkit / GitHub Models統合

AI Toolkit for VS Codeは、Azure AIとGitHub Modelsを統合的に扱う拡張機能です。

VS Code上でモデルを切り替えながらプロンプトを試し、そのままアプリケーションコードに埋め込むといった開発スタイルが取りやすくなります。

これらのツールを組み合わせることで、「ブラウザでプロトタイプ → VS Codeでコードに落とし込み → GitHub Actionsで自動評価 → Copilot Chatから運用状況を確認」といった一貫した開発・運用体験を構築できます。

GitHub Modelsの料金・プラン

ここからは、GitHub Modelsの料金体系と、無料枠・有料利用の違いを整理します。

料金体系について

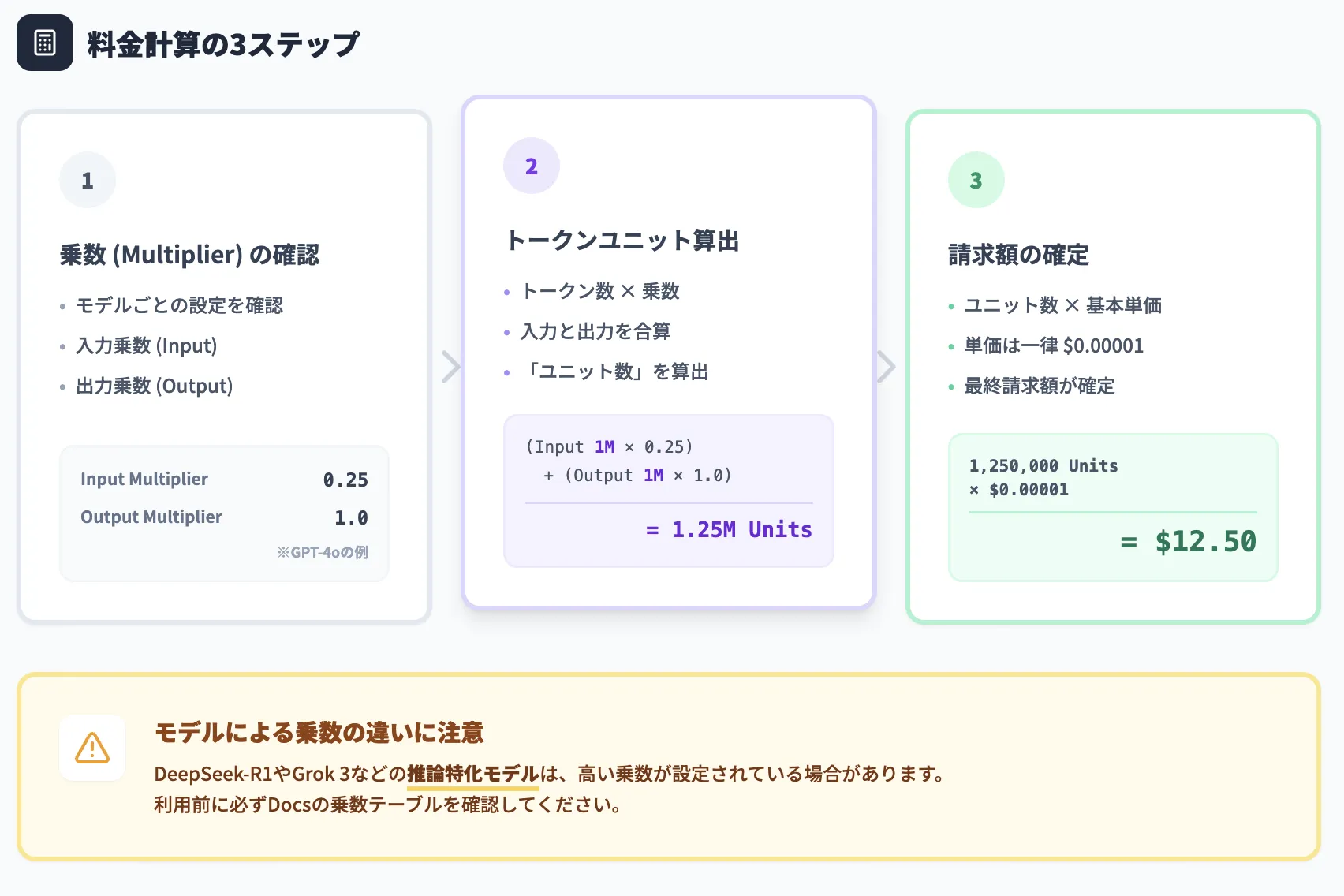

GitHub Modelsの料金は、トークンユニット(token unit)単位の従量課金として定義されています。2025年12月時点では、1トークンユニットあたり $0.00001 USD が基本価格です(ここは全モデル共通)。

料金計算の大まかな流れは次の通りです。

- 各モデルには「入力乗数(input multiplier)」と「出力乗数(output multiplier)」が設定されている

- 実際に使用した入力トークン数・出力トークン数に、各乗数を掛け合わせて「トークンユニット数」を算出

- トークンユニット数 × $0.00001 USD が請求額の目安

例えば、OpenAI GPT-4oで100万トークン入力+100万トークン出力を使った場合、乗数0.25(入力)と1.0(出力)を用いて125万トークンユニットとなり、請求額は約12.50ドルとなる例がDocsに掲載されています。

無料枠と有料利用の違い

GitHub Modelsには、全ユーザーに提供される無料枠と、エンタープライズ/組織がopt-inする有料利用があります。

無料枠(rate-limited free usage)

GitHubアカウントごとに、モデル別のレート制限付きで無料利用が可能です。

- 例:DeepSeek-R1やGrok 3では、1日あたりのリクエスト数や1リクエストあたりのトークン数に上限が設定されている

レート制限はアカウント種別や利用状況によって変動し得るため、最新のRate limitsドキュメントを確認してください

有料利用(paid usage / production-grade limits)

無料枠を超えて継続的に利用したい場合、Enterprise/organization/個人アカウントのいずれでも支払方法を有効化することで、有料利用に移行できます。

Enterprise/organizationでは、オーナーがGitHub Modelsの課金を「オプトイン」すると、所属リポジトリに対して本番環境向けのレート制限(requests per minute / day, tokens per request)が適用されます。

個人アカウントの場合も、支払方法を登録すれば同様に有料利用が可能です(Enterprise Managed Usersを除く)。

BYOK(独自APIキー)利用時の料金

BYOK(Bring Your Own Key)として、Azure OpenAIやその他のLLMプロバイダーのAPIキーをGitHub Modelsに登録することもできます。

この場合、推論トークンに対する課金は基本的に各プロバイダー側(例:Azure)の請求に載る形になり、GitHub Modelsの従量課金とは別枠で管理されます。

GitHub Modelsの使い方

ここでは、初めてGitHub Modelsを触る開発者向けに、「ブラウザ上のプレイグラウンドで試す」「リポジトリと連携して使う」という2つの基本パターンを紹介します。

基本の使い方(プレイグラウンド編)

まずは、ブラウザ上のプレイグラウンドを使って、モデルの挙動やプロンプトの手触りを確認する方法です。

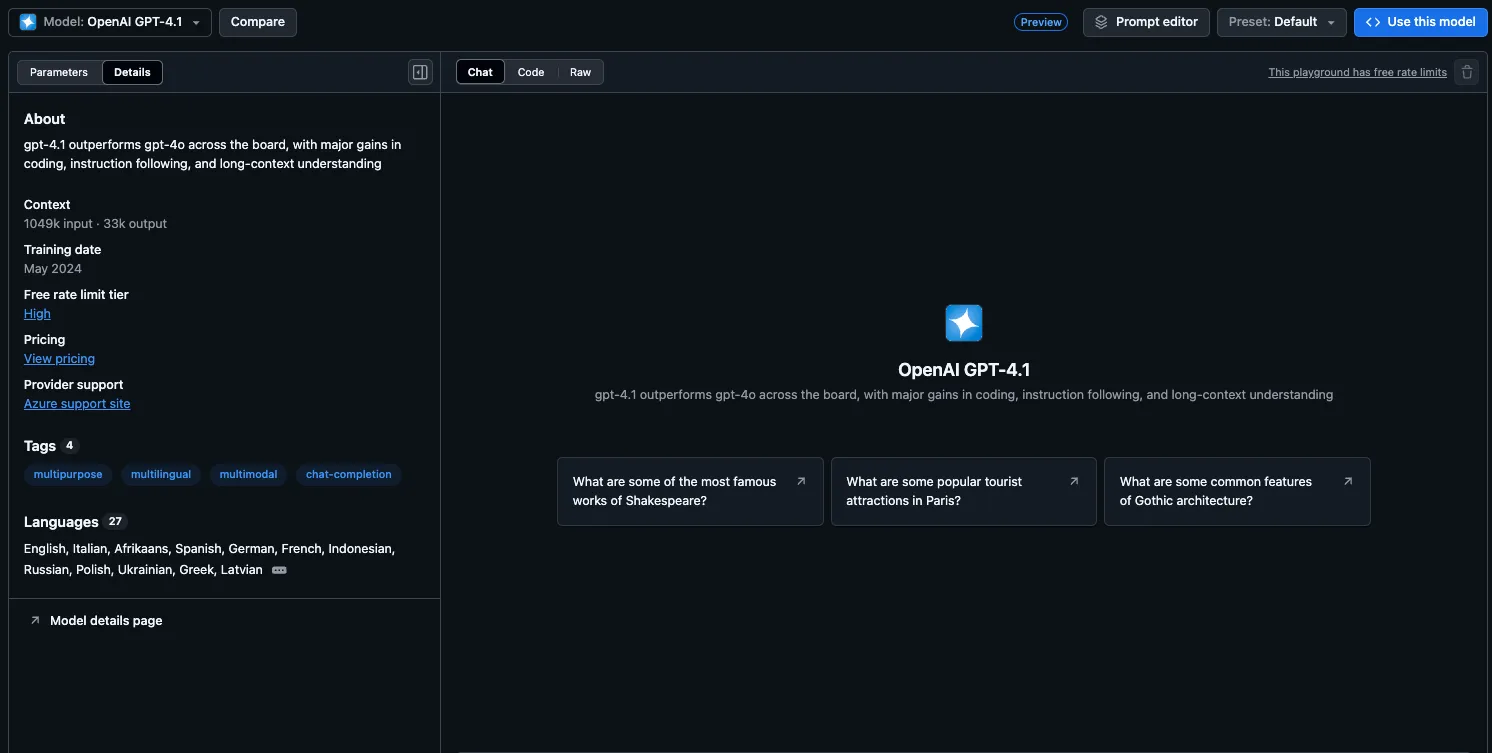

実際のGitHub Modelsの画面

プレイグラウンドは、ブラウザ上でモデルを選び、チャット形式でやり取りしながらプロンプトやパラメータを調整できる環境です。無料枠の範囲で利用できるため、最初の評価に向いています。

- GitHub Marketplace – Models にアクセス

- 上部の「Model: Select a Model」から、使用したいモデルを選択(例:azureml-deepseek/DeepSeek-R1)

- モデルページで [Playground] を開く

- 入力欄にプロンプトを入力し、実行して応答を確認

- 必要に応じて、右側のParametersタブで温度・最大トークン数・system messageなどを調整

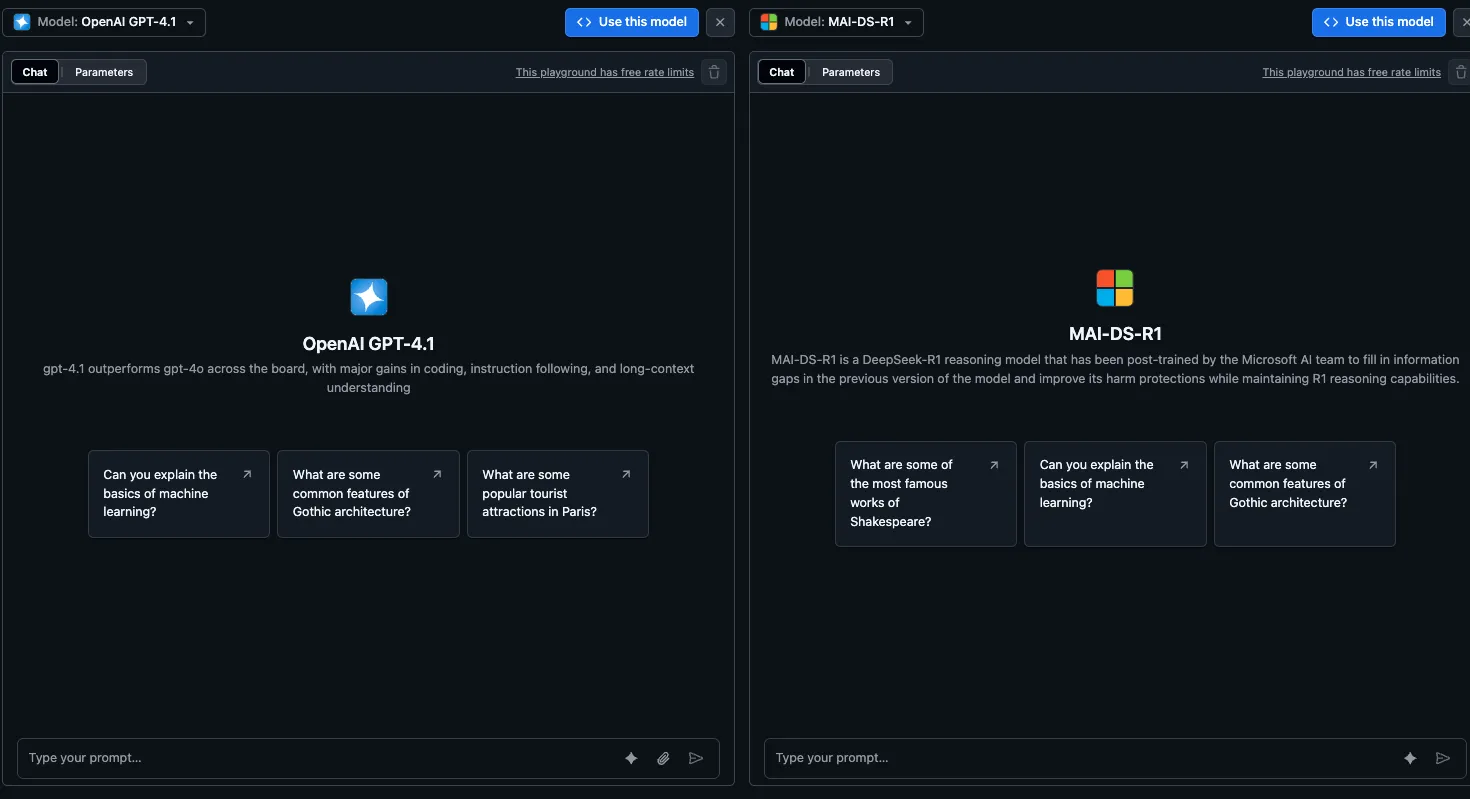

ヒント:複数モデル比較

プレイグラウンドには Compare機能 があり、同じプロンプトを2つのモデルに同時に送信して応答を並べて比較できます。

例として、GPT-4oとDeepSeek-R1に同じ要件定義のドラフトを生成させ、どちらの出力が自社のドキュメントスタイルに近いかを比較する、といった使い方が可能です。

Compare機能

リポジトリと連携して使う方法

プレイグラウンドでプロンプトの手応えを確認したら、次はGitHubリポジトリのワークフローに組み込んでいきます。

このセクションでは、Issue自動要約を例に、リポジトリ連携の流れを簡単に紹介します。

リポジトリ内でのプロンプト作成イメージ

使い方の流れ

まずは、リポジトリ内でプロンプトを作成し、「.prompt.yml」として保存します。

- 対象リポジトリの [Models] タブから新しいプロンプトを作成

- 「{{input}}」 などの変数に、Issue本文やPull Requestの差分といったテストデータを流し込み、出力を確認

- 問題なければ、プロンプトを「.prompt.yml」として保存し、Pull Request経由でレビュー・マージ

- GitHub Actionsや「gh models」CLIから、このプロンプトを参照して自動実行

実用例(Issue自動要約)

以下は、Issue投稿時に要約コメントを自動で追加するための、シンプルな「.prompt.yml」の例です。

messages:

- role: system

content: あなたはGitHubのIssueを要約するアシスタントです。重要なポイントを3〜5個の箇条書きで出力してください。

- role: user

content: このIssueを要約してください:{{input}}

model: azureml-openai/gpt-4o

temperature: 0.2

max_tokens: 512

このプロンプトをGitHub Actionsから呼び出すことで、Issue作成時に自動で要約コメントを投稿するボットを実装できます。

最新のドキュメントでは、actions/ai-inference などの公式アクションと組み合わせる方法も紹介されています。

GitHub Modelsのユースケース

ここからは、GitHub Modelsの機能を活用できる具体的な用途をいくつか紹介します。実際の導入検討時のイメージ作りに役立ててください。

1. エンタープライズAI開発・統合

大規模なソフトウェア開発プロジェクトでは、IssuesやPull Requestの量が多く、情報の把握に時間がかかりがちです。

GitHub ModelsとGitHub Actionsを組み合わせることで、次のような統合が可能です。

-

Issue / Pull Request自動要約

「.prompt.yml」で定義した要約プロンプトをActionsから呼び出し、新規IssueやPR作成時に自動で要約コメントを投稿します。

大規模プロジェクトでも、要点だけを短時間で把握できるようになります。

-

テストレビュー・変更影響分析の下書き生成

DeepSeek-R1やPhi-4-reasoningなどの推論モデルを用いて、「このPRで影響を受ける可能性があるモジュール」や「追加で必要そうなテストケース」をリストアップさせることができます。

最終判断は人間が行いつつ、レビューの入口作業をAIで補助するイメージです。

-

多言語ドキュメント生成・翻訳

Llama 3.2 VisionやPhi-4-multimodal-instructなど、マルチモーダル対応モデルを利用し、図版付きドキュメントの要約や翻訳を行うことで、多言語展開の負担を軽減できます。

2. プロンプトエンジニアリング・最適化

GitHub Modelsの比較ビューと評価機能を使うと、プロンプトのABテストを日常的な開発フローに組み込めます。

-

DeepSeek-R1 vs GPT-4o vs Phi-4-reasoningの比較評価

同じ評価データセットに対して、複数のプロンプト × 複数モデルを一括で実行し、類似性・関連性・根拠性スコアを比較します。

コスト(トークン単価)と性能のバランスを見ながら、用途ごとに最適な組み合わせを選べます。

-

プロンプト改善の履歴管理

「.prompt.yml」の変更をPull Requestとして扱うことで、「どの変更がスコア向上につながったか」を過去のPRと評価結果から振り返ることができます。

組織内で「プロンプト改善のベストプラクティス」を共有する仕組みとして機能します。

3. 組織レベルガバナンス・管理

モデル利用が部門をまたぐ規模になってくると、コストとリスクの管理が重要になります。GitHub Modelsでは、次のようなガバナンス機能を活用できます。

-

モデル使用状況の可視化と制限

管理者は、どのリポジトリ・どのチームが、どのモデルをどの程度利用しているかを把握できます。

必要に応じて、特定モデルの利用を制限したり、使用量クォータを設定したりできます。

-

監査ログによるコンプライアンス対応

モデルの利用履歴・設定変更履歴が監査ログとして残るため、「誰がいつどのようなプロンプトを送信したか」を後から追跡できます。

規制業種や情報保護が厳しい組織では、監査チームがGitHub Modelsの導入可否を判断するうえで重要な材料になります。

-

コスト最適化

高価な推論モデル(DeepSeek-R1やGrok 3など)は、要件定義や重要ドキュメントのレビューといった「付加価値の高いタスク」に限定し、日常的なチャットや補助的な処理はPhi-4-miniなどの軽量モデルに切り替える、といった使い分けが可能です。

GitHub Modelsの乗数テーブルをベースに、どのタスクをどのモデルで処理するのかを設計することで、全体コストを抑えつつ品質を確保できます。

4. カスタムAIアプリケーション開発

最後に、GitHub Modelsを用いたカスタムアプリケーション開発の例をいくつか挙げます。

チャットボット・対話システム

- サポート用チャットボットで、FAQドキュメントを参照しながら応答するプロンプトを「.prompt.yml」に定義

- モデルはDeepSeek-R1やLlama 3.3などから選び、評価機能で応答品質を確認

- 本番環境では、アクセスパターンに応じて有料利用またはBYOKを選択

文書処理・要約・分類

- 契約書や仕様書の要約、リスク抽出などをPhi-4-reasoningやGPT-4.1で実施

- 各種出力を別モデル(軽量モデル)で再評価し、信頼度スコアを付与する二段階構成も取りやすい

データ分析・インサイト生成

- 分析用のSQLクエリやPythonコードの生成を、GPT-4o miniやPhi-4-miniに任せつつ、最終レビューだけ高性能モデルに任せる構成

- 結果をダッシュボードにまとめるまでの流れをGitHub Actions + GitHub Modelsで半自動化

AI導入でお悩みの方へ

まとめ

GitHub Modelsは、AIアイデアのプロトタイプから、エンタープライズレベルの運用までを見据えたモデル利用基盤として設計されています。

40以上のモデルカタログ、プロンプト管理、評価機能、セキュリティ・ガバナンス機能を備え、2025年時点ではDeepSeek-R1やGrok 3、最新のLlamaやPhiシリーズなども含めた幅広いモデルに対応しています。

本記事で見てきたように、GitHub Modelsは単なる「無料でLLMを試せる場」を超え、組織全体でプロンプトや評価指標を共有しながらAI機能を育てていくためのワークスペースとして活用できます。

既存のGitHubワークフローとの統合により、開発者は慣れた環境のままAI機能を組み込み、ガバナンスやコスト管理を損なうことなく運用に乗せることが可能です。

GitHub Modelsの導入を検討される際は、まず無料枠でプレイグラウンドと「.prompt.yml」ベースの開発体験を試し、その上で、

- どのモデルを本番で使うか

- どこまでGitHub Modelsで運用し、どこから専用エンドポイントや他サービスに任せるか

- 組織としてどの程度の予算・ガバナンスを設定するか

といった観点を整理していくと、スムーズな導入につながります。

GitHub Modelsの導入や、エンタープライズ向けAI活用全般についてご相談がある場合は、お気軽にお問い合わせください。