この記事のポイント

Windows AI Foundryは、AIモデルの構築から実行までをローカルで完結できる統合開発基盤。

Foundry LocalやWindows MLにより、NPU/GPU/CPUへの自動最適化と高速推論を実現。

MCP(Model Context Protocol)により、AIエージェントとネイティブアプリが安全に連携可能に。

Visual Studio Code ToolkitやLoRA対応により、ノーコードに近い形で微調整やトレーニングも可能。

Azure AI Foundryとはクラウドとローカルで役割が異なり、両者を補完的に活用することで柔軟なAI開発が可能に。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

WindowsがAI開発の現場になる──Build 2025で発表された「Windows AI Foundry」は、開発者に向けた本格的なAI統合基盤として注目を集めています。

クラウド依存から脱却し、ローカルデバイス上での推論・微調整・実行を支えるこの新しいプラットフォームは、開発の自由度とセキュリティを両立させた設計が特徴です。

本記事では、Windows AI Foundryの構成要素、MCPによるエージェント連携、Azure AI Foundryとの違いまで、開発者視点で詳しく解説します。

AI総合研究所では、GitHub Copilot研修、請求代行、運用の伴走支援を行っています。

お気軽にご相談ください。

目次

Windows AI Foundry:オンデバイス開発・エッジ処理に最適化

Azure AI Foundry:クラウドスケールでのエージェント構築・評価・統治に特化

Windows AI Foundryによる開発エクスペリエンスの革新

Windows AI Foundryとは何か?

Windows AI Foundryは、MicrosoftがBuild 2025で発表した、Windows上でAIアプリケーションやエージェントを構築・最適化・実行・配布するための統合プラットフォームです。

従来のWindows Copilot Runtimeで示されてきた「オンデバイスAI」路線を発展させつつ、ローカル(デバイス)での推論を中心に据えた開発ライフサイクルを支援します。

マイクロソフトは 「AIの未来はクラウド、エッジ、そしてWindows上で構築される」 と明言し、Windows AI Foundryをその要となる存在として位置づけています。

Windows AI Foundryの特徴

このプラットフォームは、以下のような特徴を備えています。

- モデル選定から展開までの一貫した開発体験

推論ランタイム(Windows ML)を中心に、モデル最適化やLoRAによる微調整、App SDK連携までを一元化。

- クラウドとローカルを跨ぐ柔軟な開発スタイル

Azureと連携したクラウドトレーニングや、ローカル推論によるプライバシー重視のアプリ構築が可能。

- NPU/GPU/CPUへの自動最適化と多様なシリコン対応

AMD、Intel、NVIDIA、Qualcommなどとの連携により、次世代チップでも安定稼働。

- セキュリティとエージェント管理を統合する将来設計

モデルコンテキストプロトコル(MCP)やEnclave SDKと連携し、今後のAIエージェントエコシステムを支えるインフラへ。

このWindows AI Foundryによって、MicrosoftはWindowsを単なるOSではなく、AI開発の「現場(Foundry)」にするという明確なメッセージを打ち出しました。

Azure AI Foundryとの違いと補完関係

Windows AI FoundryとAzure AI Foundryは、いずれもMicrosoftが提供するAI開発基盤ですが、目的・ユースケース・実行環境に明確な違いがあります。

両者は対立する存在ではなく、それぞれの強みを活かしながら、ローカルとクラウドをつなぐ“ハイブリッドAI開発戦略”を支える存在です。

| 特性 | Windows AI Foundry | Azure AI Foundry |

|---|---|---|

| 実行環境 | デバイスローカル(Windows) | Azureクラウド |

| 想定用途 | オフライン処理、軽量AI、エッジ推論 | 組織全体のAI運用、複数ツール連携 |

| 主な強み | 高速、プライベート、柔軟な統合性 | ガバナンス、セキュリティ、拡張性 |

| 連携基盤 | MCP、Windows ML、Foundry Local、VS Code Toolkit | Purview、Entra ID、Defender for Cloud |

Windows AI Foundry:オンデバイス開発・エッジ処理に最適化

Windows AI Foundryは、主にWindows上でAIを動作させたい開発者やISV向けに設計されています。

- オープンソースモデルや独自モデルをローカルに迅速に展開

- オフライン環境でもAI機能を提供可能(セキュリティ/プライバシー上の利点)

- Copilot+ PCのNPU/GPUに最適化された推論環境

- モデルの実行・API呼び出し・MCPによるエージェント連携までWindows上で完結

このアプローチは、リアルタイム性・プライバシー・デバイス制御が求められるアプリに適しています。

Azure AI Foundry:クラウドスケールでのエージェント構築・評価・統治に特化

一方、Azure AI Foundryはエンタープライズ向けのクラウド型AIプラットフォームとして、以下のような高度な機能を提供します。

- 複数のツール・LLM・外部APIを統合したエージェント構築フレームワーク

- Prompt Injection対策やセーフティガードを含む安全性強化機能

- 評価スコアリング、タスク逸脱の検知、継続モニタリング

- Microsoft Purview、Entra、Defenderとの統合による企業レベルの統治と可視化

こちらは、大規模な業務システム、社内Copilotの構築、リスク評価の厳しい業界に適しています。

両Foundryは、Microsoftの「どこでもAIを動かせる統合スタック」戦略の両輪として、開発者・管理者・ビジネス部門それぞれのニーズに応える設計となっています。

【関連記事】

Azure AI Foundryとは?できることや使い方、料金を徹底解説!

Windows AI Foundryの主な構成要素と機能

Windows AI Foundryは、開発者がAIモデルの参照・実行・微調整・デプロイまでをローカルで完結できるようにするための、複数のコンポーネントで構成されています。以下に、代表的な構成要素とその役割を紹介します。

Windows AI Foundryの主な構成要素

Foundry Local:ローカルAI開発の中核

Foundry Localは、Azure AI Foundryのモデルを含むAIモデルをオンデバイスで推論するためのソリューションで、CLI/SDK/REST APIを通じてローカル実行を行えます。

なお、Foundry Localはパブリックプレビューとして提供されており、GA前は機能や挙動が変更される可能性があります。

- WinGetからインストール可能(

winget install Microsoft.FoundryLocal) - Foundry Local CLIを通じて、モデルの参照・ダウンロード・テストを実行可能

- ハードウェア(CPU/GPU/NPU)を自動検出し、利用可能なモデルを提示

補足:運用範囲(分散・コンテナ用途ではない)

Foundry Localは、あくまでデバイス上での推論を目的とした仕組みです。公式にも、分散、コンテナ化、マルチマシン運用の本番デプロイを想定しない旨が明記されています。

「ローカルで試す/PCアプリに組み込む」用途に寄せて捉えるのが安全です。

補足:CLIとライセンス確認(企業利用で特に重要)

Foundry LocalはCLIを備えており、利用可能なコマンドは次で確認できます。

foundry --help

また、モデル利用時はライセンス条項の確認が欠かせません。カタログ上のモデルライセンスは、次のようにCLIで表示できます。

foundry model info <model> --license

補足:アップグレード

バージョン更新は、Windowsの場合は次で行えます。

winget upgrade --id Microsoft.FoundryLocal

Windows ML:推論エンジンとしての基盤技術

Windows MLは、Windowsアプリでローカル推論を行うための推論基盤として提供されており、2025年9月に一般提供(GA)になりました。

- 実行プロバイダーを自動判別し、最適なハードウェアで推論を実行

- モデルやドライバのバンドル不要、アプリを軽量に保てる

- AMD・Intel・NVIDIA・Qualcommなどのシリコンベンダーに最適化済み

すぐに使えるAI API群

Copilot+ PCに搭載されたインボックス(組み込み)モデルを活用し、アプリから直接AI機能を呼び出せるAPI群が提供されています。

| タスク分類 | 対応API例 |

|---|---|

| テキスト処理 | Text intelligence(要約、書き換え、分類など)、Custom prompts(用途に応じたプロンプト駆動の処理) |

| ビジョン処理 | Text recognition(OCR)、Image description(画像説明)、Object erase(不要物の消去) |

いずれもローカル推論に最適化されており、デバイス上での安全な実行を実現しています。

LoRA対応による軽量な微調整機能

カスタムデータを使ってモデルを軽量に調整するため、Phi Silicaに対してLoRA(Low-Rank Adaptation)による微調整がサポートされています。

- Azureを使ったトレーニング後、LoRAアダプターをダウンロードしてローカルで即利用可能

- VS Code向けAI ToolkitからGUIベースでトレーニング実行可能

このように、Windows AI Foundryは開発者の技術レベルに応じて使い分け可能な多層的な機能を備えており、AI統合のハードルを大きく下げる設計になっています。

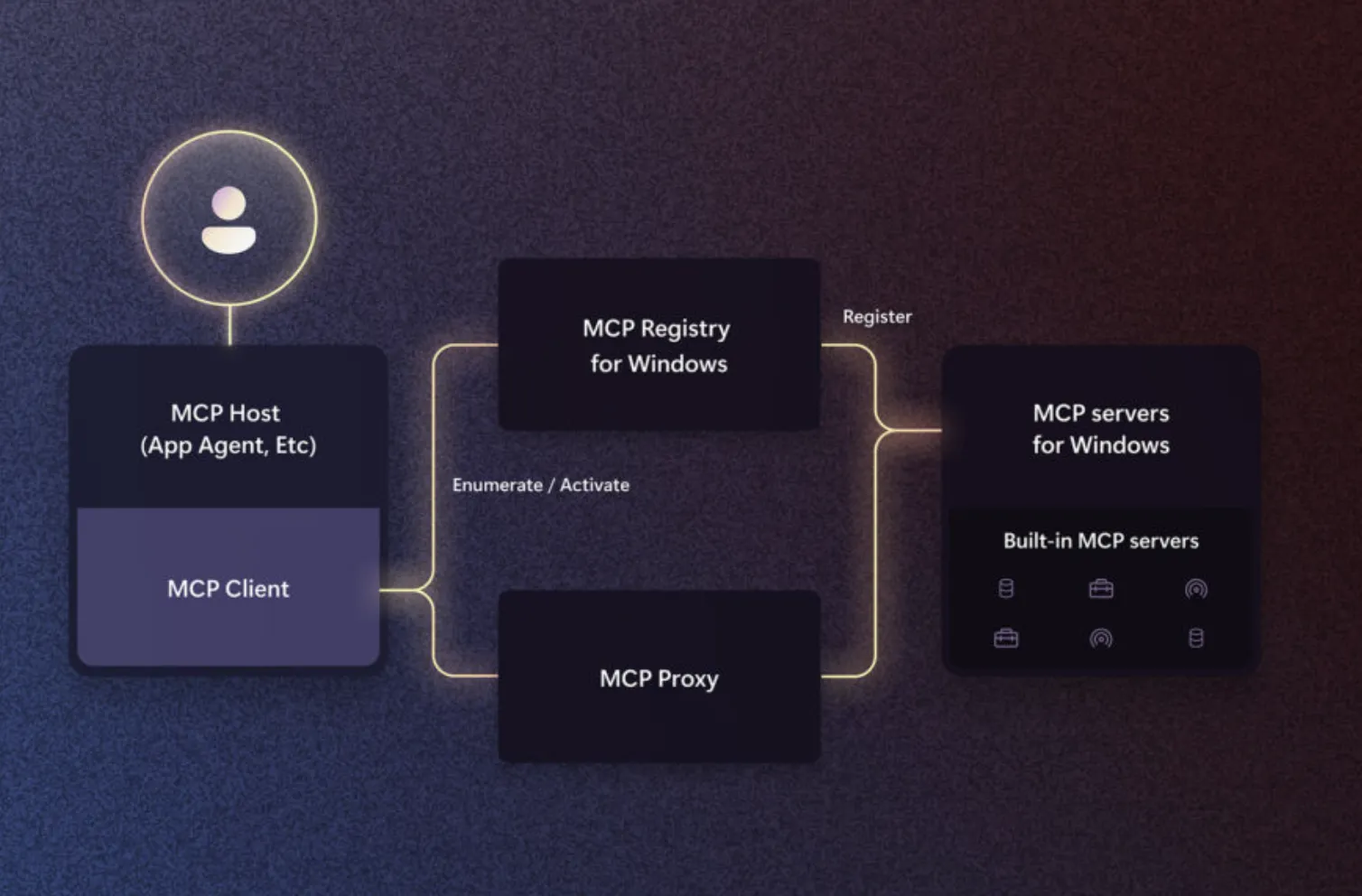

MCPによるエージェント連携の標準化

MCPイメージ

Windows AI Foundryは、アプリケーション開発だけでなく、AIエージェントの実行環境としてのWindowsの強化にも注力しています。その中核をなすのが、今回新たに発表されたモデルコンテキストプロトコル(MCP: Model Context Protocol)です。

| コンポーネント | 役割 |

|---|---|

| MCPレジストリ | Windows上で利用可能なMCPサーバーを一覧・管理する仕組み |

| MCPサーバー | エージェントが接続し、操作する対象(例:ファイルシステム、WSLなど) |

| App Actions | アプリがMCPサーバーとして機能を提供し、他のエージェントから利用可能にするためのAPI群 |

Anthropic(Claude)、Perplexity、OpenAI(ChatGPT)などがMCP対応を進めており、今後、Windows上でAIエージェントとアプリが深く結びついた新しいUXが普及していくと見られます。

Windows AI Foundryによる開発エクスペリエンスの革新

Windows AI Foundryは、AIアプリやエージェントの開発を単なる技術構築から、即試せて、即組み込める“体験中心”の開発プロセスへと進化させています。 特に、初学者からプロフェッショナルまで幅広い層がスムーズに開発できるよう、多数のツールと統合が図られています。

WinGetからの簡易インストールとセットアップ

Foundry Localは、Windows標準のパッケージ管理ツールWinGetを用いて以下のように簡単に導入できます。

winget install Microsoft.FoundryLocal

このコマンドひとつで、デバイスのハードウェア(CPU/GPU/NPU)構成に応じて、自動的に最適な推論環境が整います。導入後は、Foundry Local CLIで使用可能なモデルの参照・ダウンロード・テストが可能です。

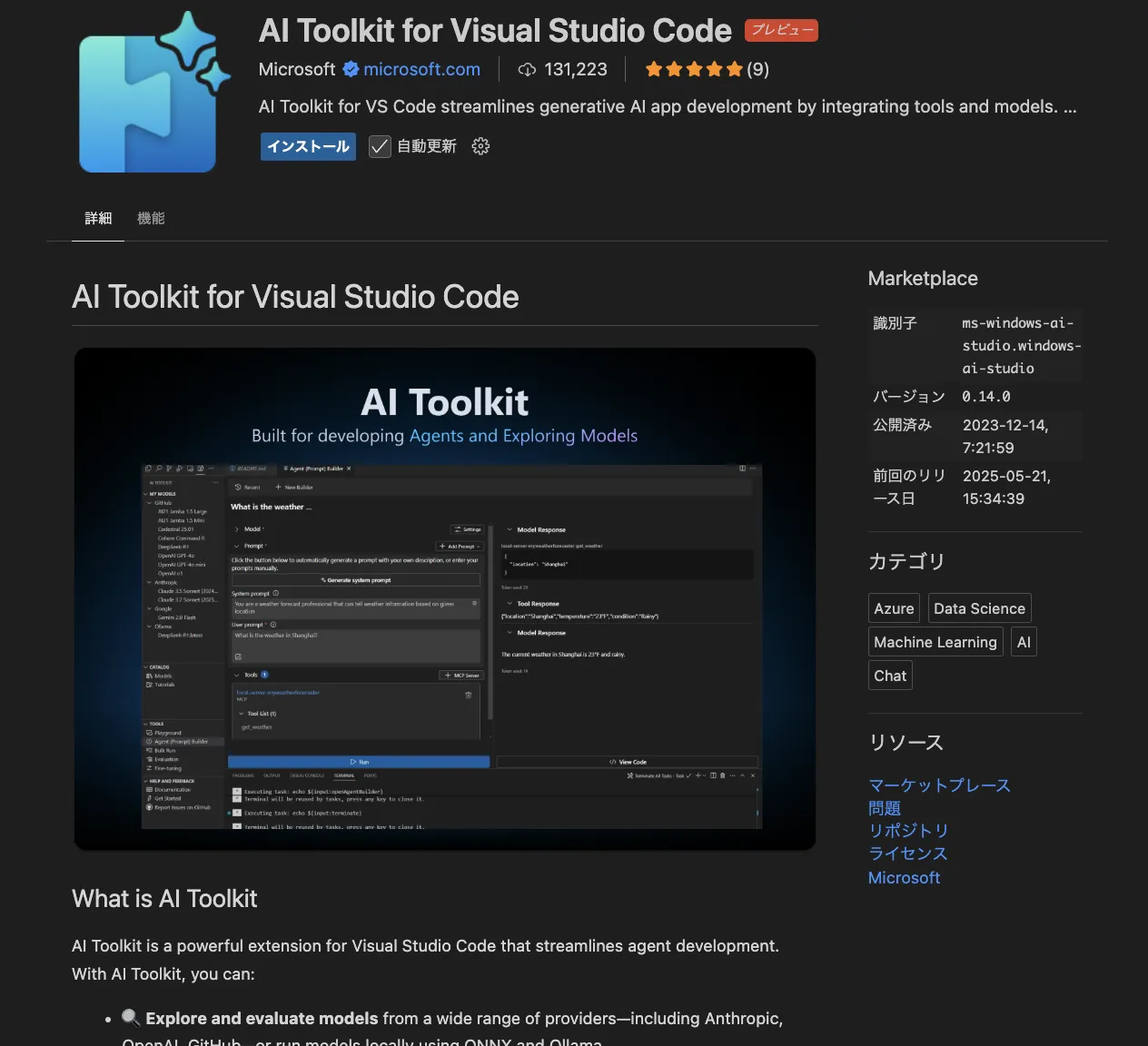

VS Codeとの密接な統合:AI Toolkit

Visual Studio Code向けのAI Toolkitは、モデルのトレーニングから微調整、テスト、デプロイまでをGUIベースで完結できる支援ツールです。

AI Toolkit

- ローカル/クラウドを問わずモデルを一元管理

- Phi Silicaに対するLoRAトレーニングのGUIサポート

- 学習済みLoRAアダプターを即座にダウンロードして検証

加えて、AI Toolkitは継続的に更新されており、2026年1月のアップデートではエージェント開発の体験改善や、Microsoft Foundry(Azure AI Foundry)側との連携強化など、開発の導線が整理されています。

これにより、従来複雑だったファインチューニング工程が、ノーコードに近い手軽さで実行可能となっています。

オープンソースモデルの高速展開

Foundry Localを使うことで、開発者は以下のような動作がすぐに行えます。

- モデルの選択・ダウンロード

- ローカル実行による性能・品質確認

- アプリ組み込み用コードスニペットの生成

試作 → 評価 → 実装 の一連の流れを“数分レベル”で完結させることが可能です。

周辺ツールの強化:PowerToys, Terminal, Edit

生産性向上のために、以下のような周辺開発ツールも強化されています。

| ツール名 | 特徴 |

|---|---|

| PowerToys コマンドパレット | 頻繁な操作・アプリへのクイックアクセスを実現 |

| WinGet Configuration | 環境構築の自動化。構成ファイルの生成と再現が可能 |

| Edit on Windows | CLIで使える軽量テキストエディター。GitHubでOSS化済 |

こうしたツール群が、開発に集中できる環境を整備しています。

このように、Windows AI Foundryは単なるAPIやランタイムではなく、“すぐに作れて、すぐに試せる”体験中心のAI開発環境として設計されていることが特徴です。

Windows MLによるシリコン最適化と開発者支援

Windows AI Foundryの中核をなす技術の一つが、Windows ML(Machine Learning)です。これはWindowsに直接組み込まれたAI推論基盤として提供されており、開発者がデバイスに依存しない高速・高効率な推論環境を手軽に利用できるように設計されています。

ハードウェア自動最適化による推論の信頼性

Windows MLは、アプリやモデルに応じて最適な実行環境(CPU、GPU、NPU)を自動判別し、Microsoftが提供する実行プロバイダーを通じてシリコンレベルで推論性能を最大化します。

- 実行プロバイダーやドライバをアプリにバンドルする必要なし

- クライアントデバイス上で実行環境を自動検出

- 新しいAIチップへの自動適応(将来のNPUにも対応)

これにより、アプリの配布がシンプルになりつつ、常に最新ハードウェアの恩恵を受けることが可能です。

パートナーとの最適化連携

Microsoftは、以下の主要シリコンベンダーと密接な最適化パートナーシップを結んでいます。

- AMD(Ryzen AI対応)

- Intel(Core Ultraシリーズ向け)

- NVIDIA(RTX/NPU統合設計)

- Qualcomm(Snapdragon X Elite向け)

これにより、開発者はパフォーマンスチューニングを意識せずとも最適な実行が保証される環境で、幅広いAIアプリを展開可能です。

アプリ開発企業による採用実績

すでに多数のISV(独立系ソフトウェアベンダー)がWindows MLを採用しています。代表例として以下が挙げられます。

- Adobe:画像処理機能にMLモデルを統合

- Topaz Labs:NPU最適化による高速ノイズ除去処理

- Wondershare / Filmora:ローカルでの動画補正AIを導入

- Bufferzone / McAfee:エンドポイントのセキュリティ評価に活用

こうした実績は、Windows MLがすでに実運用レベルで広く採用されていることの証左です。

ツールと統合で開発効率も向上

- AI Toolkit for VS Code によるワンクリック変換・最適化・量子化

- WinMLTools や ONNXサポート による柔軟なモデル準備

開発者は、モデルを用意した瞬間から「最小の労力で最適な形にして出荷できる」フローを得られます。

Windows MLは、Windows AI Foundryを支えるエンジンとして、AI推論の安定性・柔軟性・スピードの三拍子を支える存在となっています。

ChatGPT活用でお困りの方へ

まとめ|開発者にもたらす未来:WindowsはAIの“現場”になる

Build 2025での発表を通じて、MicrosoftはAI開発の主戦場をクラウドだけでなく、Windows上にも本格的に広げていく意思を明確に示しました。 それを象徴するのが、Windows AI Foundryの登場です。

これまで、AIといえばクラウドでのモデル開発やAPI連携が中心でしたが、今後はローカルでの推論・微調整・展開が日常的に行われる時代が到来します。Windows AI Foundryは、その“日常化”を実現するために設計された、極めて実用的かつ柔軟な開発基盤です。

Microsoftは、「AIを使う場所」から「AIを作る場所」としてのWindows」へと進化させることで、開発者にとって真に生産的で持続可能なAIエコシステムを構築しようとしています。