この記事のポイント

Runway Gen-3 alphaは画質、一貫性、精巧さが向上した最新の動画生成AIモデル

Motion Brush、Director Mode、リップシンク、Image to Videoなどの主要機能を搭載

プロンプト入力で動画を生成、カメラワークや詳細な指示が可能

有料プラン(Standard以上)で利用可能、クレジット制で追加購入も可能

商用利用可能だが、プランによってウォーターマークの有無や利用条件が異なる

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AI技術の進化により、動画生成が簡単にできる時代が到来しました。

プロンプト入力で自由自在に動画を作成し、ビジネスシーンやクリエイティブな活動を支援するRunway Gen-3 alphaは、その最先端を走るツールです。

本記事では、その使い方から料金体系、さらに商用利用における注意点まで、幅広く解説を行います。最新の動画生成AIモデル「Runway Gen-3 alpha」の魅力を、Motion BrushやDirector Modeの改良、プロンプトの活用法など、具体的な機能紹介を交えながらご紹介していきます。

Runwayを利用してどのようにしてクリエイティブな世界を広げていけるか、この機会にチェック、お試ししてみてはいかがでしょうか。

「AIをマーケティングに活用したいけど、具体的な方法がわからない」とお悩みではありませんか?

AI Marketerなら、効率的なコンテンツ制作と多チャネル展開が簡単に実現できます。

⇒AI Marketerの資料を見てみる

Runway Gen-3とは

Runway Gen-3 は、Runway aiが発表した最先端の動画生成AIモデルです。

2世代目にあたるRunway Gen-2に比べて、Gen-3は動画の画質・一貫性・精巧さが大幅にパワーアップしています。

また、Runwayのメイン機能である「Motion Brush」や「Director Mode」にも改良が加えられており、より複雑なシーンの生成やシネマティックな動きなどに対応できるよう設計されています。

こちらはサンプルとして弊社が実際に生成した動画になります。

生成AI特有の破綻が全くなくなった訳ではありませんので、その部分も確認いただけたらと思います。

モーニングルーティーン動画サンプル

例えば、

- 4秒頃の顔の回転に対して顔が見えにくい

- 時計の部分

- その後のブラシを当てる箇所が耳に近い

- パンの横にある植物が浮いている

などが挙げられます。

Runway Gen-3の主な機能

Runway Gen-3の主な機能としては、以下の4つが挙げられます。

- 改良されたMotion Brush

- アートディレクション機能

- リップシンク

- Image to Video(画像から動画を生成)

プロンプトの作成のコツなど詳細を説明していますのでぜひご覧ください。

Motion Brush

Motion Brushとは、画面内の特定の箇所をブラシでこするように塗りつぶすことで、その範囲だけに動き(Motion)をつけることができる機能を指します。

以下の動画はRunway公式が「Gen-2」のMotion Brush機能を紹介する際に公開されたものです。

「Gen-3」ではこのMotion Brushの精度がより高度になった形でリリースされるようです。(記事公開時点ではMotion Brushの機能は実装されていませんのでご注意ください。20204.7.4)

イメージ動画

ディレクター・モード

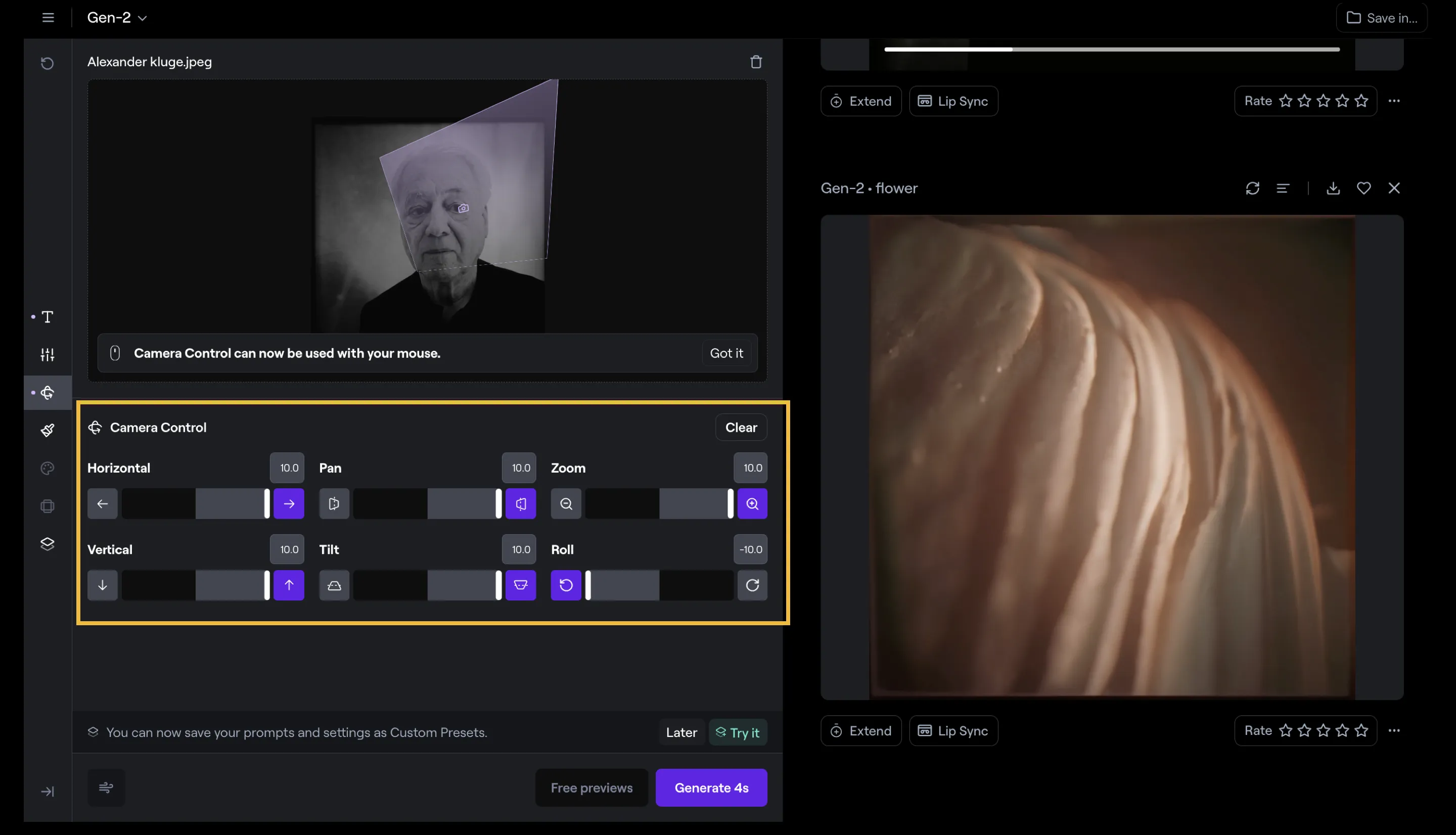

「Gen-2」には「ディレクター・モード」という設定項目がありました。この項目を操作することで、生成された動画にダイナミックなカメラワークを付与することが可能になります。

ディレクター・モードの操作画面

上記画像における黄色い枠に囲った部分が「操作バー」です。これらを組み合わせることで、ビデオ内でのカメラの動き、強度、速度を操作できます。

一般的に、数多ある動画生成AIサービスでは、高画質でリアルな映像を出力してくれるものの、その映像がどのようなカメラワークを行うかは、細かくプロンプトで指定するしかありませんでした。

そのため、意図したカメラワークを行えず、ある種の偶然性に身を任せるような部分がありました。

しかしその一方で、「Runway」では「ディレクター・モード機能」があることで、生成される動画の「見せ方」に大きく介入できるようになります。

この「ディレクター・モード」は現在「Gen-2」のみ対応しており「Gen-3」では対応しておりませんが、今後のアップデートでは、「Gen-2」と比べてよりクオリティの高い「ディレクター・モード」が搭載されることが公式から予告されています。

プロンプトによる細かい制御

「Gen-3」は、現段階では「Text to video」のみ対応しています。これはつまり、文章から動画が生成されるということを指します。

そして、そのプロンプトを理解して、動画へと反映させる力がとても高いことで話題になっています。

Runway公式が公開しているプロンプトガイドラインでは、プロンプトのキーワードや構造など、効果的に動画を生成するためのプロンプトのコツが掲載されています。

| 項目 | 説明 | 例 |

|---|---|---|

| カメラの動き | カメラの動きやアングルについて説明します。 | 低角度静止ショット |

| シーンの概要 | シーンの主要な内容を記述します。 | カメラがオレンジ色の服を着た女性を見上げるように角度をつけ、色鮮やかな植物が生い茂る熱帯雨林に立っています。 |

| 追加の詳細 | シーンの追加情報や特別な要素を記述します。 | 空は曇り、灰色です。 |

サンプルプロンプト

| タイプ | プロンプト例 |

|---|---|

| シームレスなトランジション | 連続したハイパースピードFPV映像: カメラが氷河の峡谷をシームレスに飛び抜け、夢のような雲の風景へと移行します。 |

| カメラの動き | 夜の発光する海: 夜の発光する生物が水中にいる。カメラは発光するクラゲのマクロクローズアップから始まり、その後、様々な発光色で照らされた海全体を星空の下で映し出します。カメラの動き:クラゲのマクロショットから始まり、ゆっくりと引いて上に移動し、発光する海を見せます。 |

| テキストタイトルカード | 動的な動きのあるタイトル画面: シーンはカラフルなペンキで覆われた壁から始まります。突然、黒いペンキが壁に流れ、「Runway」という言葉を形成します。滴るペンキは詳細でテクスチャがあります。中央に配置され、優れたシネマティックライティングが施されています。 |

プロンプトキーワード

キーワードは、特定のスタイルを出力に反映させるために役立ちます。

キーワードがプロンプト全体と一貫していることを確認することで、その効果がより顕著になります。

| シーンの種類 | キーワードの例 |

|---|---|

| クローズアップショット | 肌の質感、詳細なディテール |

| ワイドショット | 環境の詳細、風景の広がり |

| 動的なシーン | ハイパースピード、シームレスなトランジション |

| シネマティック | 劇的な照明、シネマティックライティング |

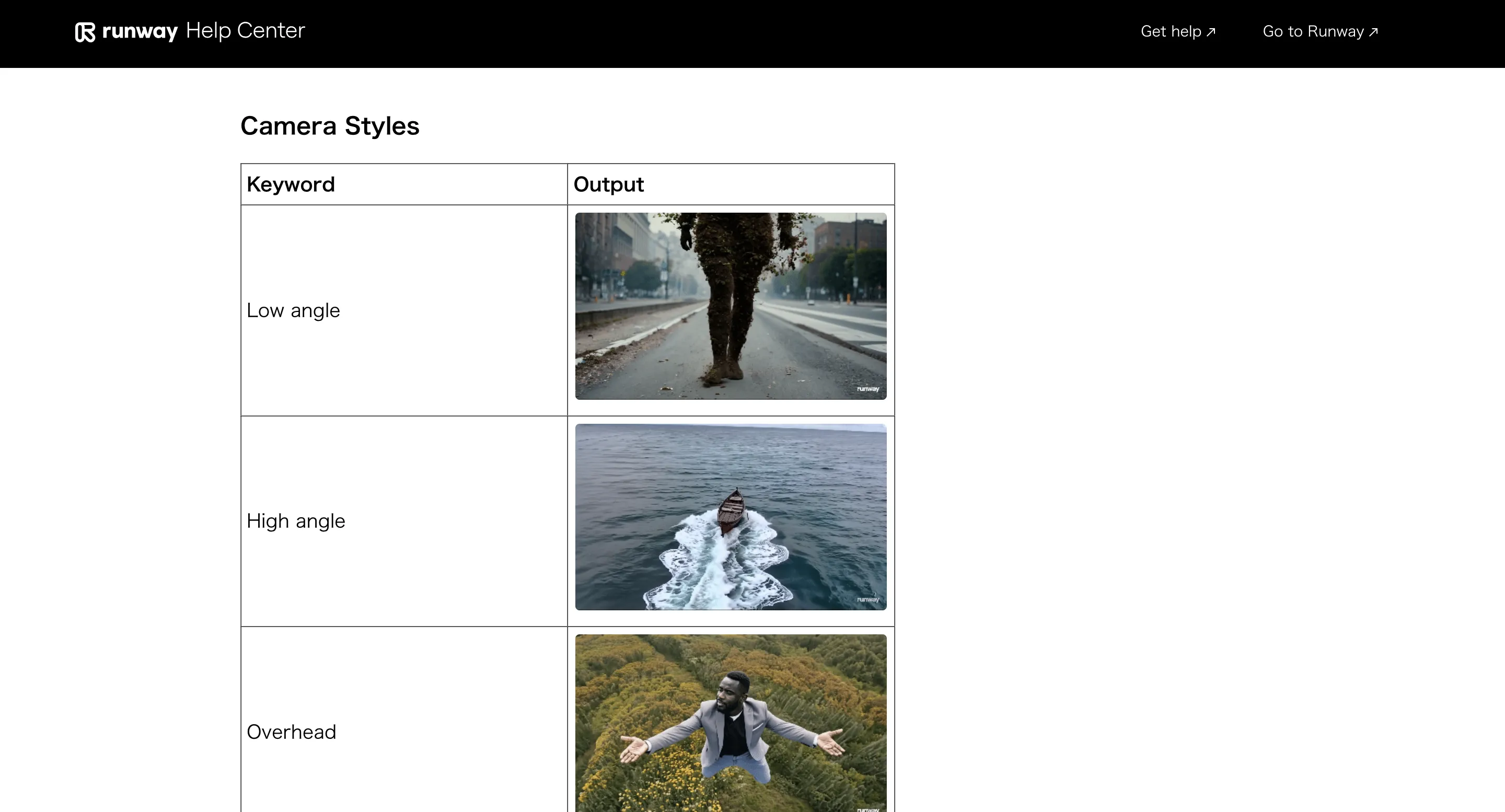

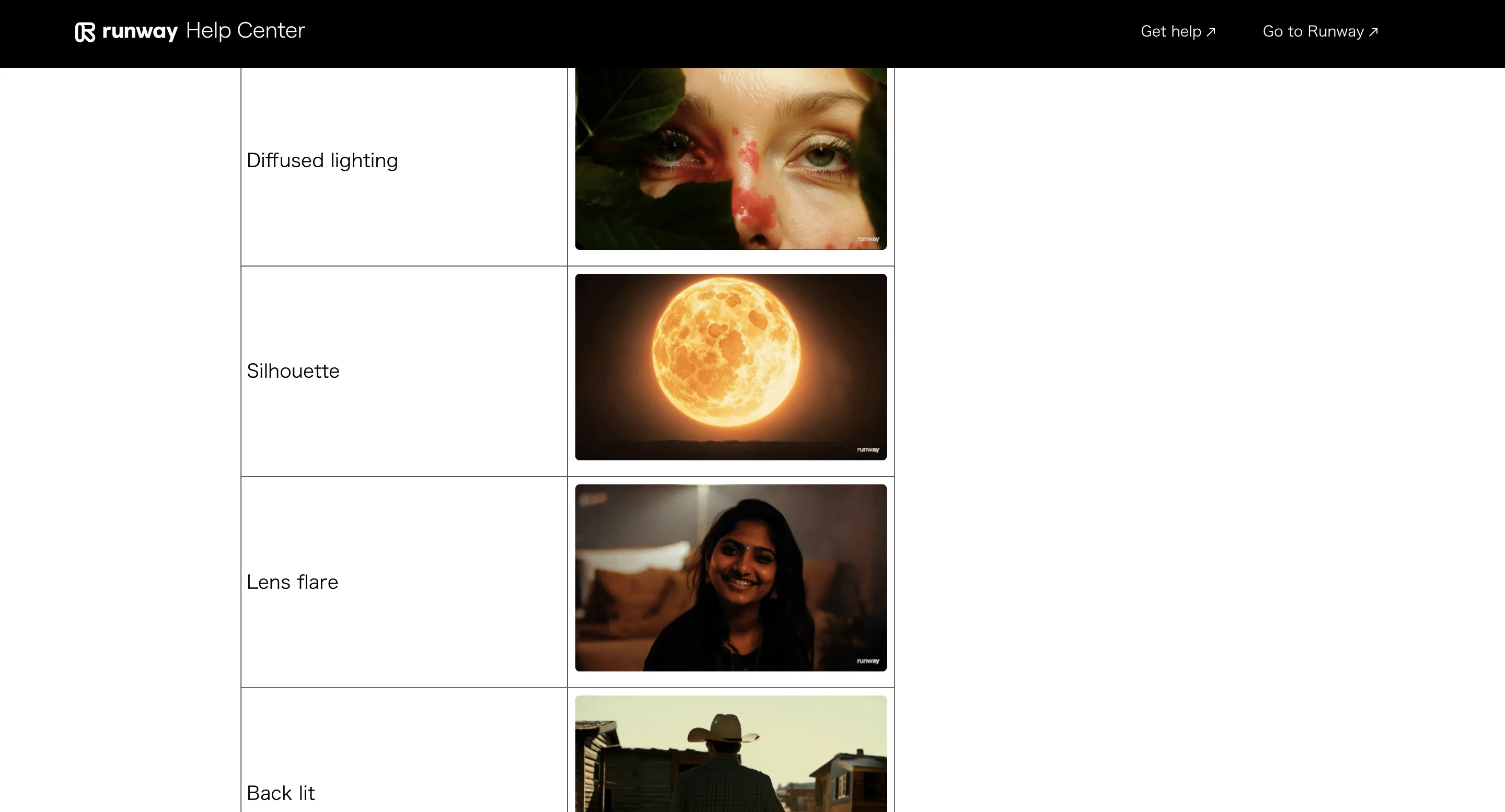

以下の画像は、URLへと飛んだ先のページのスクリーンショットです。

黒い線の枠の中で、「Keyword」に対してどのような「Output」が出力されるかの見本がたくさん載せられています。

プロンプトのキーワード - その⑴

プロンプトのキーワード - その⑵

リップシンク

gen-2に比べて、リップシンクも大幅に進化しています。

そもそもリップシンク(リップ・シンクロナイゼーションの略称)とは、「映像内の口元の動き」と、「流れている音声の言葉」が一致している状態のことを指します。

アップデート以前のGen-2の状態においても、リップシンクのクオリティは高かったと言えます。

しかしながら遠方の人物の口元だけを正確に動かしたり、横顔の状態にある人物の口元を動かすことは難しかったようです。

今回のアップデートでは、そういった障壁もクリアし、より質の高いリップシンクが実現されています。

これによって、動画生成AIだけで映画やMVなどを作成することも、より現実味を増してきていると言えます。

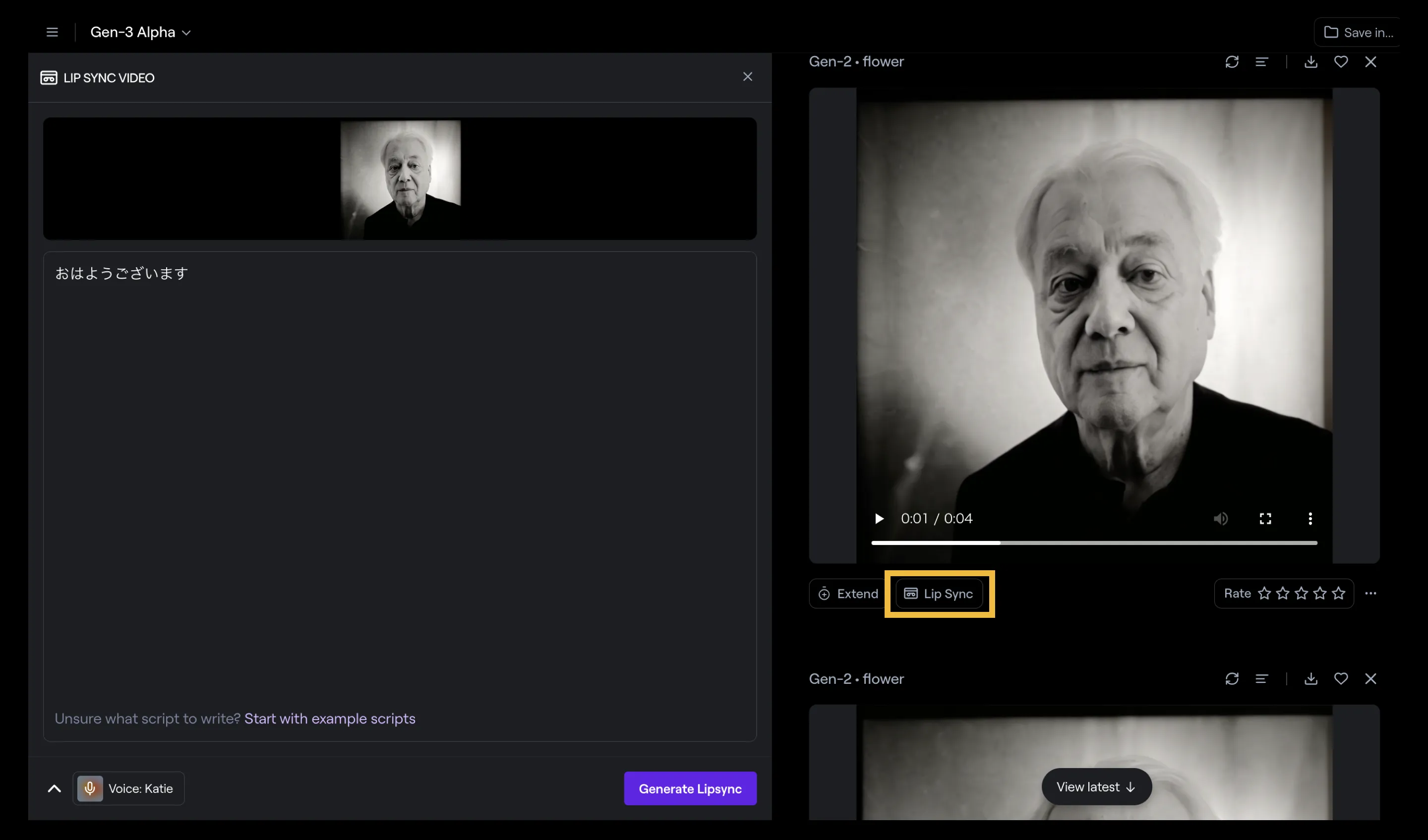

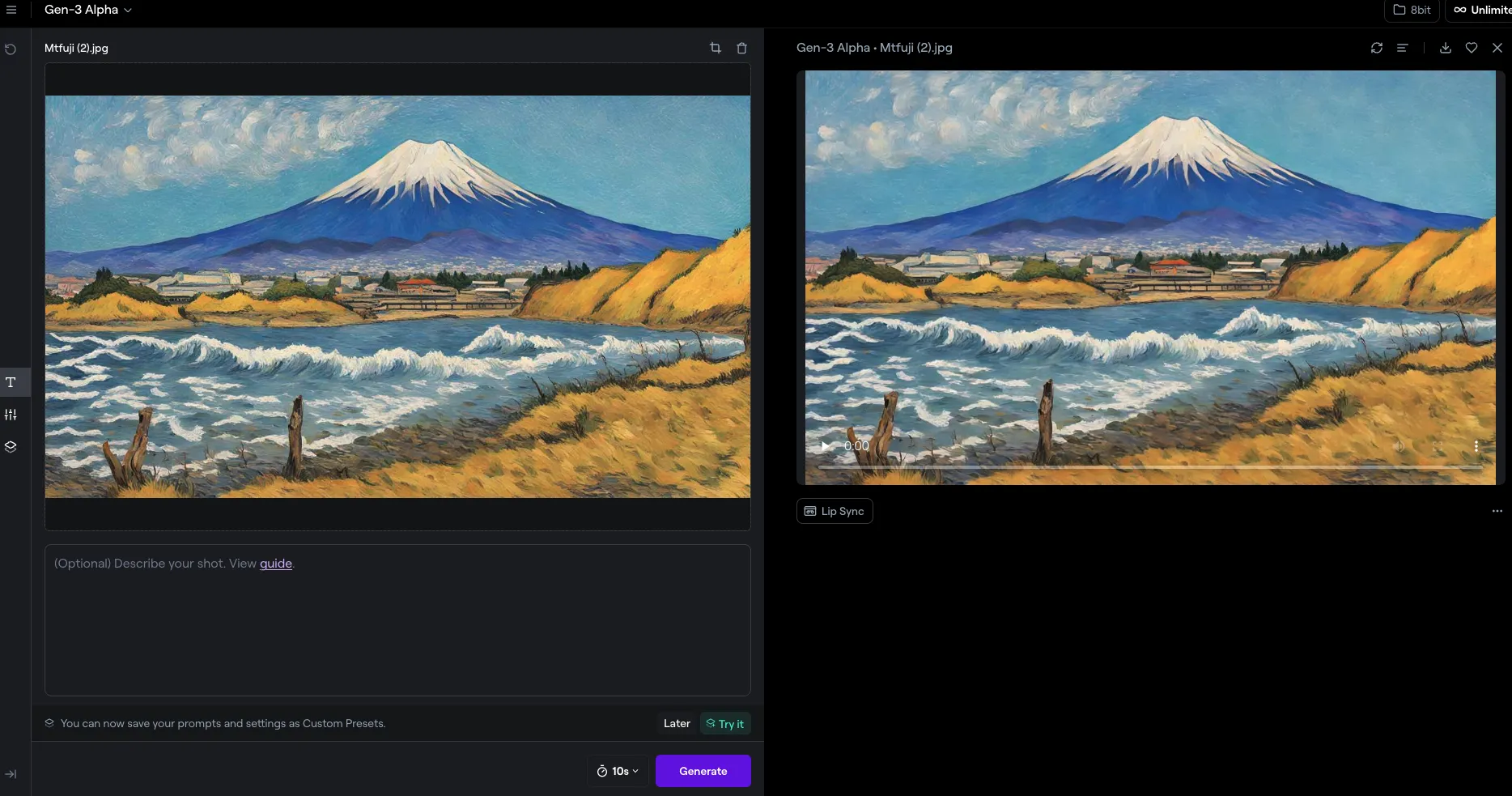

「リップシンク」の機能は、生成した動画の左下にあります。

リップシンクのボタン

「リップシンク」のボタンを選択すると、音の素材をどのようにつくるかの選択をすることができるようになります。

録音するか、テキストで音声を生成するか、音声ファイルを入力するか、の3択で音素材の選択ができます。

素材が用意でき次第、「Generate Lipsync」を選択することで、リップシンク動画が生成されます。

Image to Video

Runway gen3の最新アップデートとして、Gen-3 Alpha Image to Videoが登場しました。この新機能により、静止画から動画を生成することが可能になります。

通常の動画生成(Text to Image)と同様に、テキストプロンプトを追加することで、より詳細な指示を与えることも可能です。

➡️Imgage to videoの使い方

【主な特徴】

- 1280x768ピクセルの固定解像度で動画を生成

- 5秒または10秒の動画長を選択可能(デフォルトは10秒)

- 生成された動画へのリップシンク(口の動きの同期)機能

- 画像アップロード後のオプションテキストプロンプト入力

Today we are releasing Gen-3 Alpha Image to Video. This update allows you to use any image as the first frame of your video generation, either on its own or with a text prompt for additional guidance.

— Runway (@runwayml) July 29, 2024

Image to Video is major update that greatly improves the artistic control and… pic.twitter.com/OieDwMIspz

Runway Gen-2とRunway Gen-3の違い

以下は、Runwayの動画生成AIモデル「Gen-2」と「Gen-3 Alpha」の主な違い一覧です。

| 特徴/機能 | Runway Gen-2 | Runway Gen-3 Alpha |

|---|---|---|

| 動画の長さ | 最大16秒 | 5秒~最大10秒 |

| 生成方法 | テキスト、画像、ビデオクリップから生成 | 現在はtext to videoのみ |

| Motion Brush | 静止画の特定部分を動かす機能 | 改良されたMotion Brush機能 |

| Director Mode | カメラの動きをシミュレートする機能 | 詳細なアートディレクション機能 |

| インフラ | 記載なし | 大規模なマルチモーダルトレーニング用の新しいインフラ |

| 安全対策 | 記載なし | 改良された視覚的モデレーションシステム、C2PA証明標準 |

| カスタマイズ | 記載なし | エンターテインメントやメディア業界向けのカスタムバージョン |

| コントロールモード | Motion Brush、Director Mode | Motion Brush、Advanced Camera Controls、Director Mode |

現時点では、生成可能な動画の最大秒数ではGen-2に軍配が上がるものの、Gen3はより高品質な動画生成、複雑なシーンの変更、アートディレクション機能など、さまざまな改良が加えられています。

Runway Gen-3の使い方

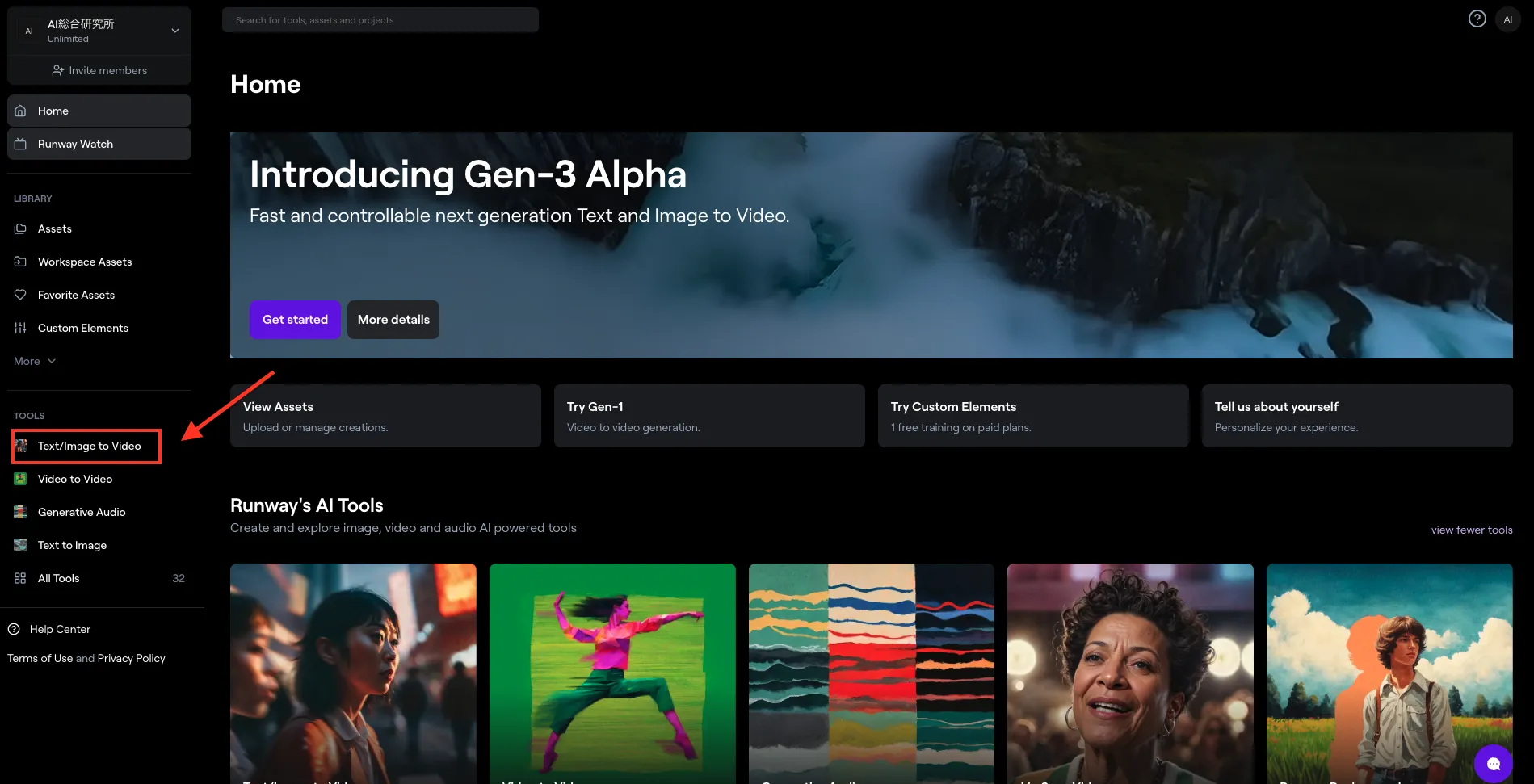

ここからは実際に手を動かしながら「Runway Gen-3」の使い方を確認していきます。

まず、Runwayを使うにはアカウント登録が必要です。下記URLからRunwayのWebページへとアクセスし、ログインしましょう。

Runway公式ページ

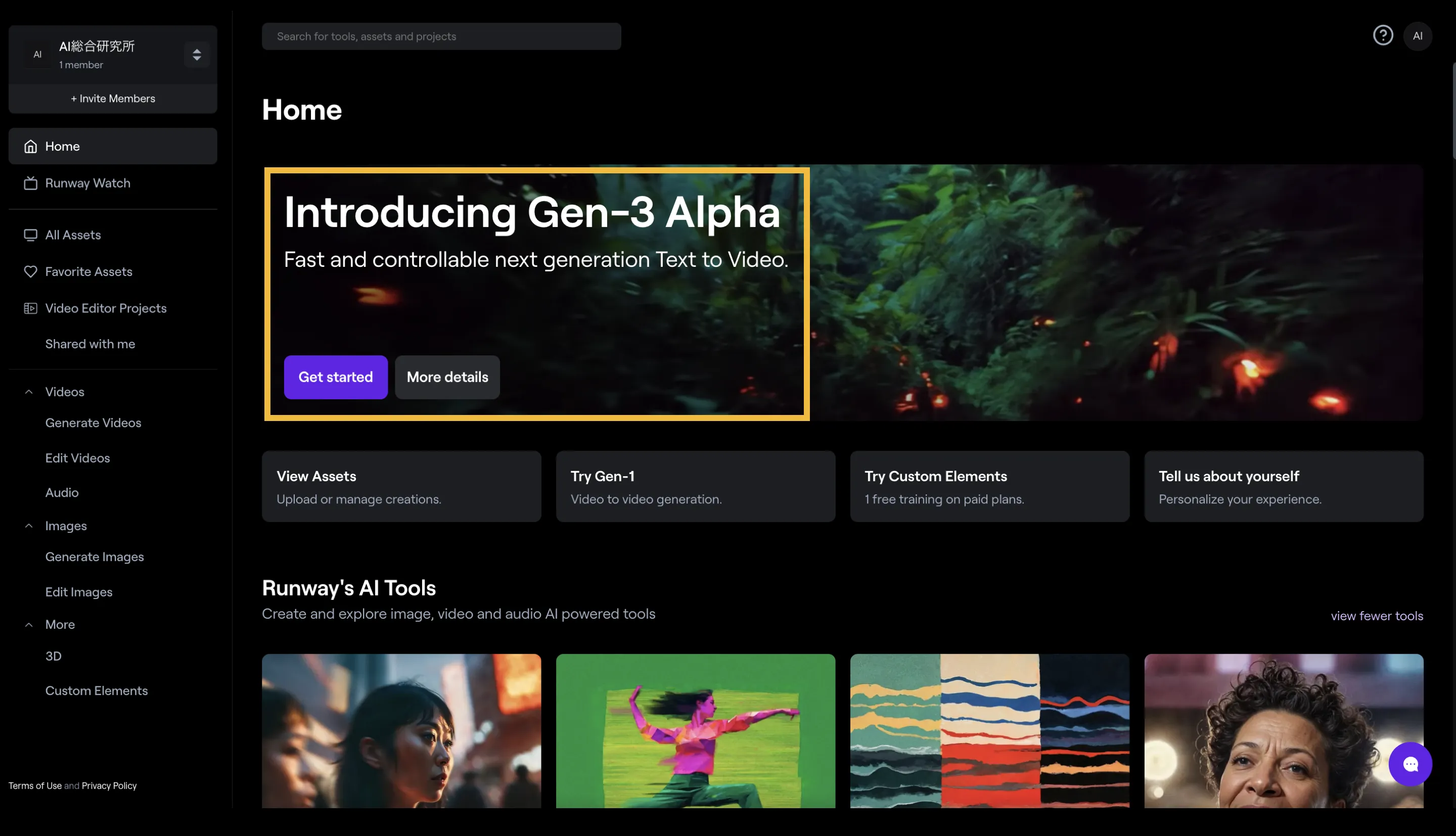

ログインが完了すると、このようなページに案内されます。画面中央にある「Get started」を選択しましょう。

トップページ

「Get started」を選択すれば、動画生成画面へと遷移します。

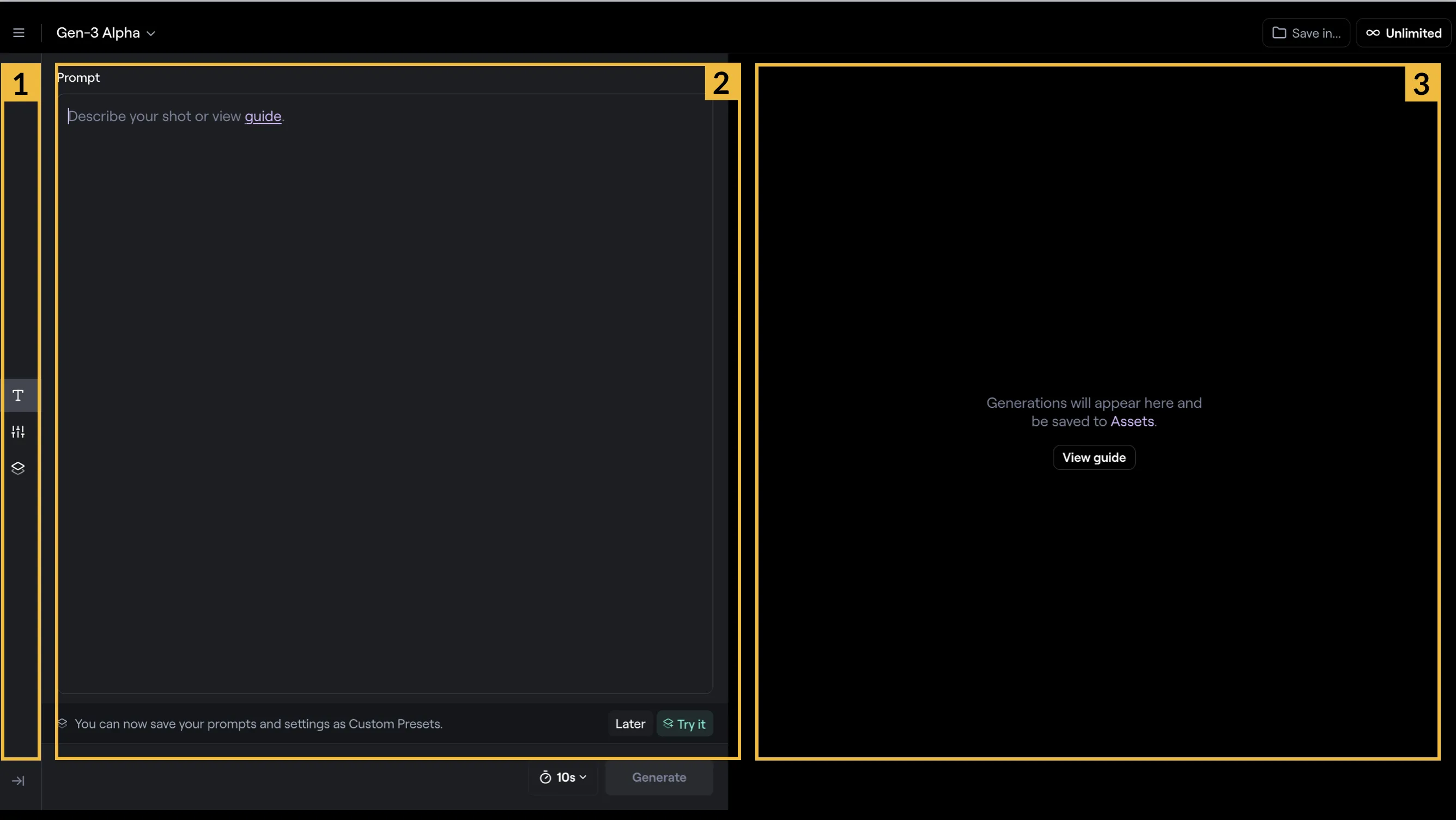

下記画像にあるように、画面の機能は大きく3つの要素で成り立っています。

画面向かって一番左(1)では、「Prompt入力画面」「設定画面」などが選択でき、その選択が画面中央(2)に反映されます。一番右は、生成された動画が表示されるようになっています。

動画生成画面

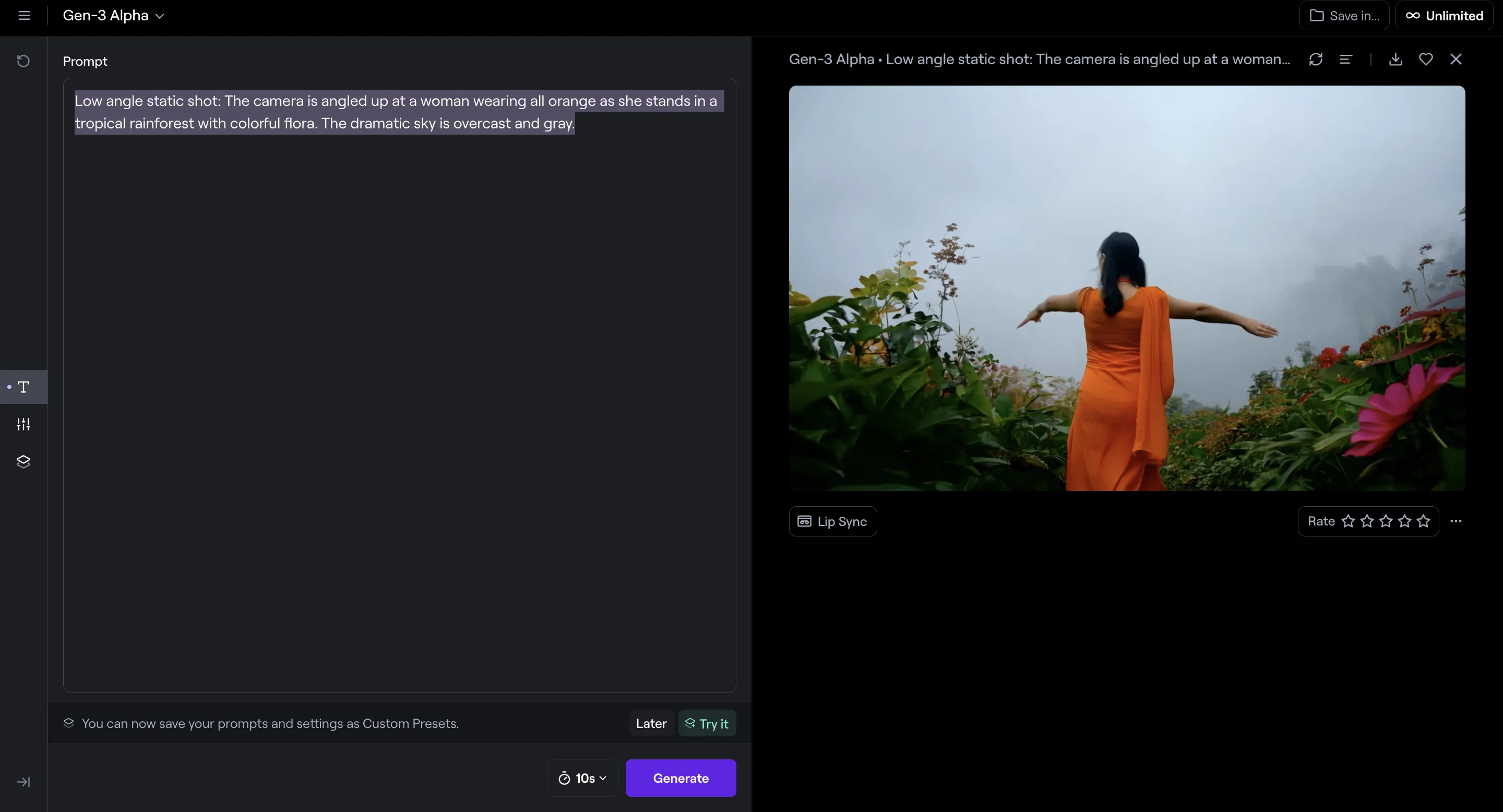

画面中央のプロンプト欄に文章を入力していきましょう。ここでは、以下のプロンプトを入力しました。

Low angle static shot: The camera is angled up at a woman wearing all orange as she stands in a tropical rainforest with colorful flora. The dramatic sky is overcast and gray.

プロンプトの入力

ポイントは、プロンプトの冒頭に「カメラワークについての記述」を置き、その後に「カメラを主語に、どのような光景が写っているのか」を詳しく記載することです。

漠然としたプロンプトでとりあえず生成してみるのであれば話は別ですが、狙った動画を生成するにはある程度のプロンプトの具体性が必要になってきます。

下にあるように「4W1H」を意識すると作りやすいのでおすすめです。

・いつ

・どこで

・誰が

・何を

・どのように

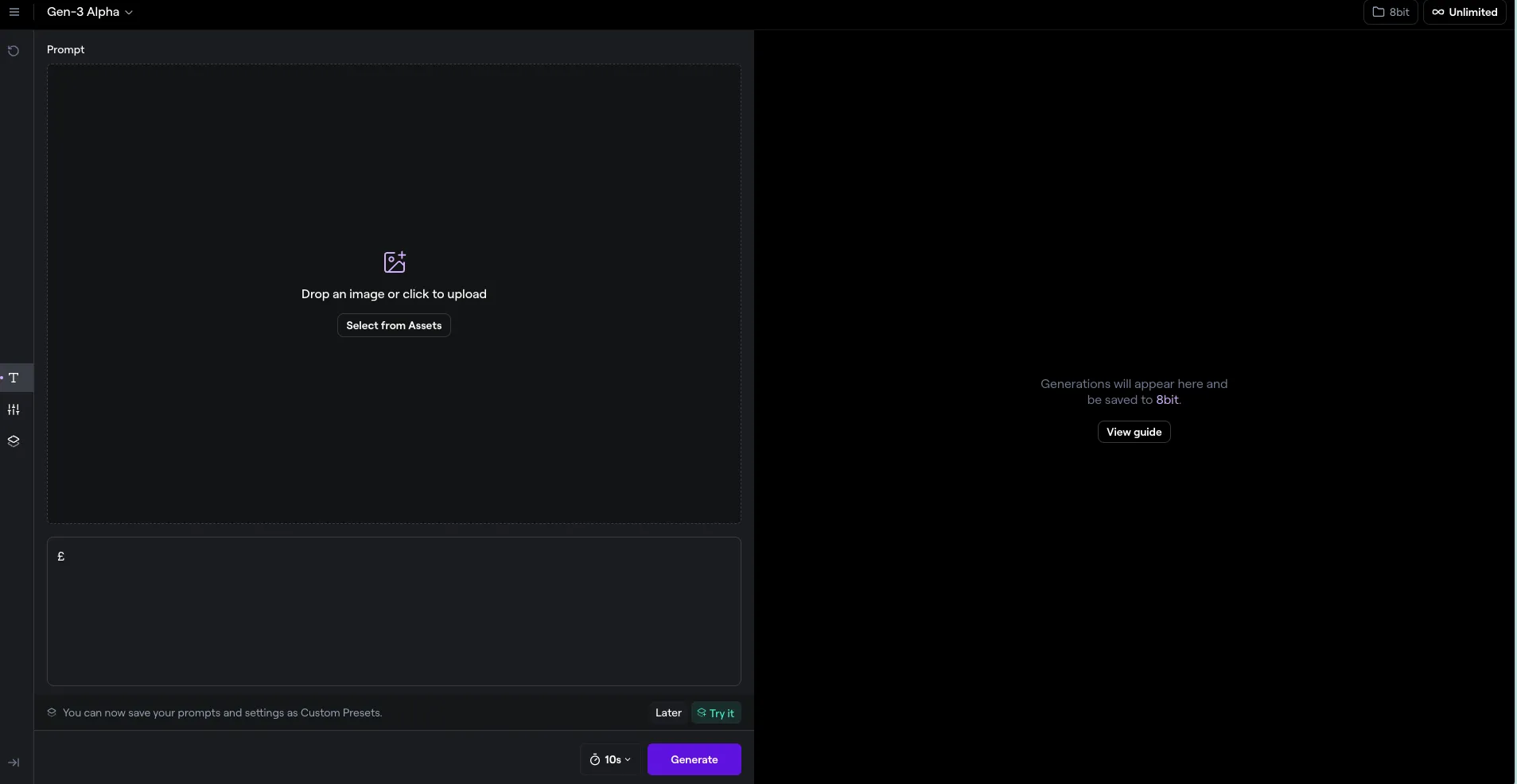

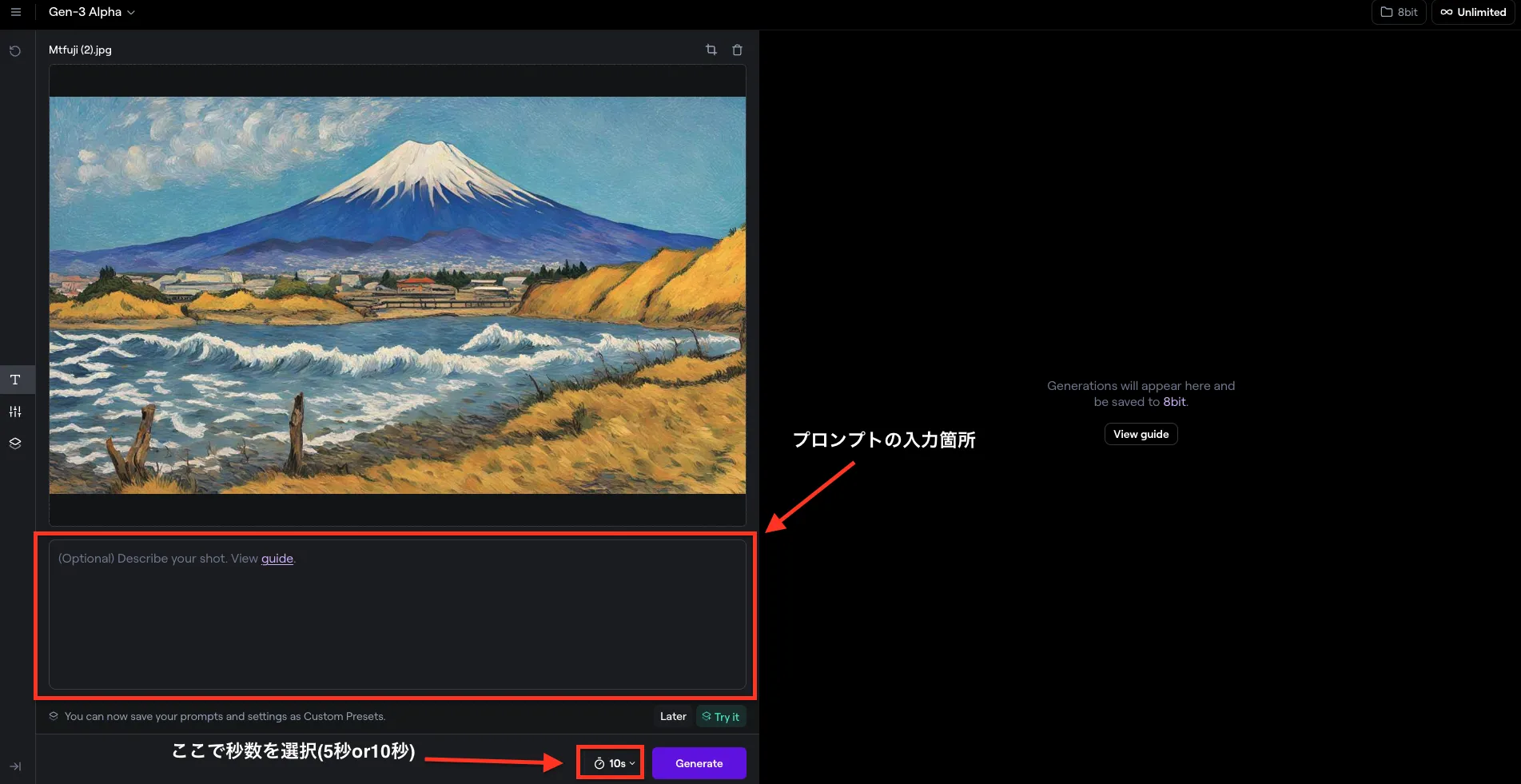

Image to Videoの使い方

トップページ左側のツールバーから、「Text/Image to Video」を選択します。

2.次のような画面が出るので、使用したい画像をアップロード・選択します。

3.画像を選択したら、必要に応じてプロンプトを入力します。

加えて、生成する動画の秒数(5秒もしくは10秒)を選択します。

4.「Generate」ボタンを押すと、画面右側に動画が生成されます。

生成された動画は保存が可能です。

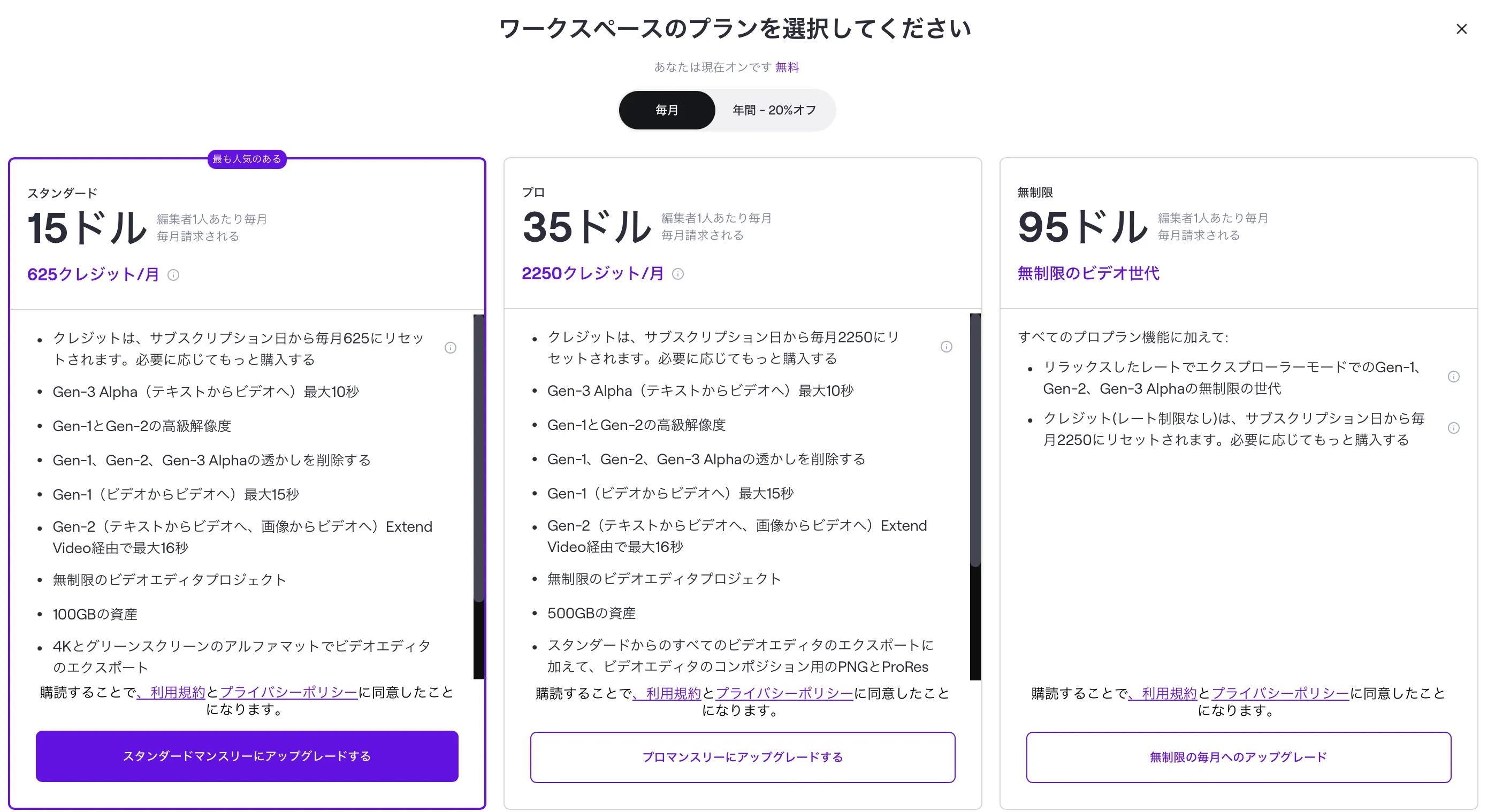

Runway Gen-3の料金

Runway Gen-3を利用するには、有料プランである「Standard」以上のプランに加入する必要があります。

| 各プラン | 料金 | クレジット/1ヶ月 | 特徴 | Gen3 Alphaの利用 |

|---|---|---|---|---|

| Feee | 0ドル | 125クレジット | 部分的なAI Magic Toolsへのアクセス。 クレジット数、エクスポートの解像度、ストレージ容量、 利用可能なプロジェクト数への制限。 |

× |

| Standard | 15ドル | 625クレジット | 解像度の向上、作成したコンテンツに付随するロゴマークの削除、 100GBのアセット容量、無制限のビデオ編集プロジェクトなど |

⚪︎ |

| Pro | 35ドル | 2250クレジット | 500GBのアセット、その他機能多数 | ⚪︎ |

| Unlimited | 95ドル | 無制限 | プロプランの全機能に加えて、無制限のビデオ生成が可能、 その他機能多数 |

⚪︎ |

クレジットの消費量や、機能ごとの費用感については機能ごとのクレジット消費量をご覧ください。

決済方法の一覧

- クレジットカードまたはデビットカード

- Amazon Pay(アマゾンペイ)

- Apple Pay(アップルペイ)

- アリペイ

- Cash App Pay(現金払い)

- WeChatペイ

(参考:Runway)

クレジットの追加購入

「Standardプラン」および「Proプラン」では、「プランごとにあらかじめ付与されるクレジット(先述の料金表参考)」に加えて、1000クレジットあたり$10で追加購入が可能です。(Freeプランは不可)

追加クレジットの購入

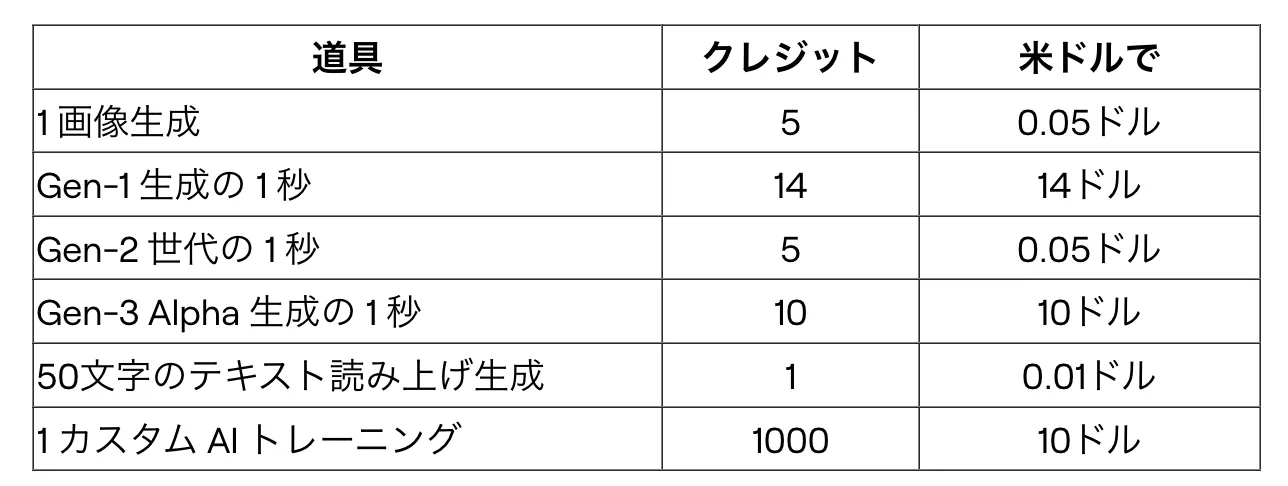

機能ごとのクレジット消費量

それぞれのモデル(Gen-シリーズ)および、機能ごとのクレジット消費は以下の通りです。

実際に筆者がGen-3で動画を生成してみたところ、公式の記載通り10秒の動画で約100クレジットを消費する形でした。

Runway Gen-3の商用利用について

Runway Gen-3の商用利用は無料プランと有料プランで条件が異なり、著作権や責任の所在にも注意が必要です。

商用利用を含むすべての利用は、Runwayの利用規約に従う必要があります。利用規約に違反した場合、アカウントの停止や強制退会の可能性があるため、注意が必要です。

プラン別の利用条件

Runwayの全てのプラン(無料、Standard、Pro、Unlimited)で、生成または編集したコンテンツの商用利用が可能です。

ただし、ウォーターマークの有無に違いがあります。

【無料プラン】

生成されたコンテンツにRunwayのウォーターマークが付与されます。

【有料プラン】

ウォーターマークなしでコンテンツを生成・編集でき、商用利用が可能です。

著作権について

著作権に関しては、「ユーザー側が生成したコンテンツに対して著作権を保持」します。

ただし、Runwayも生成されたコンテンツに対して一定の権利を有します。具体的な権利の範囲は利用規約に定められています。著作権侵害に関する申し立ては、Runwayの著作権エージェントに連絡する必要があります。

【ユーザーの権利】

- 生成したコンテンツの著作権を保持

- 商用利用を含む自由な使用が可能

【Runwayの権利】

- コンテンツの所有権は主張しない

- AIモデルの改善のために、入力(プロンプト)と出力(ユーザーの生成物)を使用する権利あり

- 非独占的で広範な利用ライセンスを保有

エンタープライズプランの場合

組織が「Runway Enterprise Services」を利用する場合は、別途「Enterprise Services Termsが適用されます。

この条件は、通常の利用規約とは内容が異なる可能性があるため、確認が必要です。

Runway Gen-3を商用利用する際は、これらの点を十分に理解し、適切なプランを選択することが重要です。また、著作権や利用規約に関する疑問がある場合は、Runway社に直接問い合わせることをお勧めします。

Runway Gen-3のアップデート情報・最新ニュース【✅随時更新】

Runway Gen-3はテキストや画像からの動画生成、モバイル対応の強化、プロフェッショナル向け機能の拡充など、多岐にわたる機能追加により、AIによる動画制作の可能性を大きく広げています。

Gen-3 Alpha Text to Videoがだれでも利用可能に (2024/7/2)

テキストから高品質な動画を生成できるGen-3 Alpha Text to Video機能が一般公開されました。高忠実度で高速、そして制御可能な動画生成の新時代の幕開けです。

この革新的な機能により、プロフェッショナルからビギナーまで、誰もが直感的に動画制作に取り組めるようになりました。

Gen-3 Alpha Text to Video is now available to everyone.

— Runway (@runwayml) July 1, 2024

A new frontier for high-fidelity, fast and controllable video generation.

Try it now at https://t.co/ekldoIshdw pic.twitter.com/miNbHdK5hX

Runway iOSアプリでGen-3 Alphaが利用可能に (2024/7/17)

Runway iOS アプリでGen-3 Alphaが利用可能になりました。

プロンプト入力から生成過程の視聴まで、ユーザー体験を一新し改善。いつでもどこでも、直感的なインターフェースでAI動画生成が可能になりました。

Gen-3 Alpha is now available on the Runway iOS app. With a redesigned and improved experience for prompting and watching generations.

— Runway (@runwayml) July 16, 2024

Download today: https://t.co/ce7MwTIygA

Gen-3 Alpha Image to Videoをリリース (2024/7/30)

Gen-3 Alpha Image to Video機能がリリースされ、クリエイティブの可能性が大きく広がりました。

任意の画像を動画の最初のフレームとして使用でき、単独での使用はもちろん、テキストプロンプトと組み合わせることで、さらに詳細な制御が可能になりました。

この主要なアップデートにより、生成される動画の芸術性とコンシステンシーが大幅に向上しています。

Today we are releasing Gen-3 Alpha Image to Video. This update allows you to use any image as the first frame of your video generation, either on its own or with a text prompt for additional guidance.

— Runway (@runwayml) July 29, 2024

Image to Video is major update that greatly improves the artistic control and… pic.twitter.com/OieDwMIspz

Gen-3 Alpha Turboが登場 (2024/8/1)

高品質な動画生成の新たな時代を切り開くGen-3 Alpha Turboが開発されました。オリジナルのGen-3 Alphaと同等の品質を保ちながら、生成速度を7倍に向上。

大幅な価格引き下げと無料ユーザーへの提供も開始され、Image to Video機能でもこの高速化が実現しています。ほぼリアルタイムでのインタラクティブな動画生成を可能にし、効率性の新たな基準を確立しました。

We trained a new version of Gen-3 Alpha, Turbo, that can generate videos 7x faster than the original Gen-3 Alpha, while matching its performance on many use cases. We’ll be rolling out Turbo for Image to Video with significantly lower pricing over the coming days while also… pic.twitter.com/4qbmD15pvY

— Runway (@runwayml) July 31, 2024

フレーム指定機能が追加 (2024/8/5)

Gen-3 Alpha Image to Videoの機能が進化し、入力画像を動画の最初または最後のフレームとして使用できるようになりました。この機能は単独での使用も、テキストプロンプトと組み合わせての使用も可能です。

特に最終フレームとしての画像指定により、目的のシーンに向かって自然に展開する動画生成が実現しました。

Gen-3 Alpha Image to Video now supports using an image as either the first or last frame of your video generation. This feature can be used on its own or combined with a text prompt for additional guidance.

— Runway (@runwayml) August 5, 2024

All examples below demonstrate using an image as the last frame.

(1/5) pic.twitter.com/koFBP7iKNf

Runway iOSアプリにInspiration Feedが登場 (2024/8/9)

iOSアプリに新機能「Inspiration Feed」が登場し、全ユーザーが利用可能になりました。

他のユーザーの生成作品とそのプロンプトを閲覧できる機能により、新しいアイデアの発見や既存のアプローチの見直しが容易になりました。さらに、ユーザー自身の作品を投稿することで、コミュニティへの貢献も可能です。

Introducing the Inspiration Feed on the Runway iOS app, available now to all users. Browse generations and their prompts to get new ideas and rethink old ones.

— Runway (@runwayml) August 9, 2024

Submit your own generations: https://t.co/QX7wnuev23 pic.twitter.com/TpWn31hS7K

Gen-3 Alpha Turbo Image to Videoが利用開始 (2024/8/15)

Gen-3 Alpha Turbo Image to Videoの提供が開始され、生成速度は7倍に向上、価格は半額に設定されました。品質を維持しながらこの革新を実現し、無料ユーザーを含むすべてのプランで利用可能になっています。

さらなるモデルの改善、制御メカニズムの向上、リアルタイムでのインタラクション強化も計画されています。

Gen-3 Alpha Turbo Image to Video is now available and can generate 7x faster for half the price of the original Gen-3 Alpha. All while still matching performance across many use cases. Turbo is available for all plans, including trial for free users.

— Runway (@runwayml) August 15, 2024

More improvements to the…

Gen-3 Alpha Turbo 終了フレーム指定に対応(2024/8/20)

Gen-3 Alpha Turboが進化し、入力画像を動画の最後のフレームとして使用できるようになりました。高速生成を維持しながら、目的のシーンに向かって展開する動画制作が可能になっています。

Gen-3 Alpha Turbo now supports using an input image as the last frame of your video.

— Runway (@runwayml) August 19, 2024

Try it now at https://t.co/ekldoIshdw

Gen-3 AlphaのiOSアプリでImage to Videoが利用可能に (2024/8/20)

Gen-3 Alpha の Image to Video機能がiOSアプリでも利用可能になりました。場所を問わず、スマートフォンから直感的な動画生成が実現します。

Image to Video is now available for Gen-3 Alpha on the iOS app.

— Runway (@runwayml) August 20, 2024

Try it today: https://t.co/CUYv6y5SeH

Gen-3 Alpha 生成時間を40秒まで拡張(2024/8/31)

Gen-3 Alpha Extensionsの導入により、全ユーザーが最大40秒までの動画生成が可能になりました。より長尺のストーリー性のある動画制作の可能性が広がっています。

Extend your generations up to 40 seconds with Gen-3 Alpha Extensions.

— Runway (@runwayml) August 30, 2024

Available now to all users at https://t.co/ekldoIsP34 pic.twitter.com/YdyDxHV9vd

Runway APIを公開 (2024/9/16)

Runway APIが公開され、開発者がGen-3 Alpha Turboを自社のアプリケーションや製品に統合できるようになりました。

Omnicomなどの戦略的パートナーがすでに採用しており、APIの利用申請の受付が開始されています。

Today we're announcing the Runway API, allowing developers to easily integrate Gen-3 Alpha Turbo into their apps and products.

— Runway (@runwayml) September 16, 2024

Already in use by trusted strategic partners like @Omnicom, you can now learn more and sign up for the waitlist: https://t.co/hLgy7JuwGW

既存動画をガイドとした生成機能の実装 (2024/9/19)

Gen-3 Alphaに革新的な機能が追加され、既存の動画をガイドとして使用した新しい動画生成が可能になりました。

入力した動画の形状や動きを維持しながら、テキストプロンプトで新しいスタイルに変換できます。クリエイターの意図をより正確に反映した動画制作が実現します。

With Gen-3 Alpha you can now use an existing video as a guide to generate new outputs with text prompts. This new level of control allows you to maintain the shapes and movements of your input video while transforming its style. pic.twitter.com/YiIIGK5xKr

— Runway (@runwayml) September 19, 2024

縦型ビデオがGen-3 Alpha Turboですべてのユーザーが利用可能に (2024/9/21)

Gen-3 Alpha Turboで縦型動画の生成が可能になり、全ユーザーが利用できるようになりました。

SNSやモバイルコンテンツに最適化された動画制作の幅が広がります。

Vertical video generations are now available to all users with Gen-3 Alpha Turbo. pic.twitter.com/h4kk8mqrUO

— Runway (@runwayml) September 20, 2024

Gen-3 Alpha Turboが大幅アップデート (2024/9/28)

Gen-3 Alpha Turboが大幅なアップデートを実施。縦型動画の生成やVideo to Video機能の実装により、より迅速な制作フローが実現しました。

表現力と忠実度の向上に焦点を当てた追加アップデートも予定されています。

Today we're excited to share updates to Gen-3 Alpha Turbo that bring more control and the ability to generate vertical videos.

— Runway (@runwayml) September 27, 2024

Learn more below.

(1/4) pic.twitter.com/EucNJmMc3x

Gen-3 Alpha Turboで開始・終了フレームの同時指定が可能に (2024/10/9)

Gen-3 Alpha Turboで、動画の最初と最後のフレームを同時に指定できるようになりました。

横型・縦型どちらのアスペクト比でも利用可能で、全ユーザーがウェブから使用できます。より緻密なストーリーテリングと制御が実現します。

You can now provide both first and last frame inputs for Gen-3 Alpha Turbo. Available for all users on web in both horizontal and vertical aspect ratios. pic.twitter.com/JsdEqGYf3P

— Runway (@runwayml) October 8, 2024

Act-One機能がリリース (2024/10/23)

Gen-3 Alphaに革新的な新機能「Act-One」が登場。モーションキャプチャやキャラクターリギングを必要とせず、1本の動画だけで豊かな表現力を持つアニメーションを生成できます。

従来の表情アニメーションが必要としていた複雑な多段階のワークフローを一新。スマートフォンで撮影した1本の動画から、様々なキャラクターデザインやスタイルへの展開が可能です。

視線、微細な表情、演技のペース、感情の機微まで、入力された演技の本質を忠実に生成結果に反映。

さらに、多様なカメラアングルやフォーカル長での撮影にも対応し、シネマティックでリアリスティックな表現を実現します。

Act-Oneは段階的にユーザーへの提供を開始。近日中に全ユーザーが利用可能になる予定です。

Introducing, Act-One. A new way to generate expressive character performances inside Gen-3 Alpha using a single driving video and character image. No motion capture or rigging required.

— Runway (@runwayml) October 22, 2024

Learn more about Act-One below.

(1/7) pic.twitter.com/p1Q8lR8K7G

Advanced Camera Control機能が追加 (2024/11/1)

Gen-3 Alpha Turboに Advanced Camera Control機能が追加されました。シーン内での移動方向と強度を自由に選択でき、より意図的なショット作りが可能になります。

【主な撮影テクニック】

・被写体を中心に弧を描くようなパン&横移動

・ロケーションを探索するような横移動とパンの組み合わせ

・様々なカメラワークとスピード変化を組み合わせたループ映像

・劇的なズームイン/アウトによる空間表現

・シーンをゆっくりと横断するトラッキングショット

・新しい文脈やストーリーを明らかにする引きの演出

すべてのテクニックがGen-3 Alpha Turboで即座に利用可能です。

Advanced Camera Control is now available for Gen-3 Alpha Turbo. Choose both the direction and intensity of how you move through your scenes for even more intention in every shot.

— Runway (@runwayml) November 1, 2024

(1/8) pic.twitter.com/jRE6pC9ULn

Expand Video機能をリリース (2024/11/23)

動画のアスペクト比を変更できる新機能「Expand Video」が登場。入力された動画の周囲に新しい領域を生成することで、異なるアスペクト比への変換を実現します。

テキストプロンプトやガイド画像を使用して予期せぬ展開を作り出すことが可能で、複数回の拡張を組み合わせることで、ドラマチックなクラッシュズームやプルアウトリビールなども実現。

静止画のような映像から、シネマティックなカメラワークを生み出すことができます。

この機能はGen-3 Alpha Turboで段階的に展開され、近日中に全ユーザーが利用可能になる予定です。

Introducing, Expand Video.

— Runway (@runwayml) November 22, 2024

This new feature allows you to transform videos into new aspect ratios by generating new areas around your input video. Expand Video has begun gradually rolling out and will soon be available to everyone.

See below for more examples and results.… pic.twitter.com/liF0qF9d0S

Frames: 高度なスタイル制御を可能にする新しい画像生成モデルが登場 (2024/11/25)

革新的な画像生成の基盤モデル「Frames」がリリースされました。このモデルは、スタイリスティックな制御と視覚的な忠実度において大きな前進を遂げています。

Framesを使用することで、クリエイターは非常に具体的な視点と美的特徴を持つ世界を構築することが可能になりました。特に、作成したい世界の外観、質感、雰囲気を精密にデザインできる点が特徴です。

Introducing Frames: An image generation model offering unprecedented stylistic control.

— Runway (@runwayml) November 25, 2024

Frames is our newest foundation model for image generation, marking a big step forward in stylistic control and visual fidelity. With Frames, you can begin to architect worlds that represent… pic.twitter.com/kg8Fz0LEgU

生成AI活用事例を知りたい方へ

画像・動画生成AIの導入事例集

Stable Diffusion、Midjourney、Runway等の最新生成AIツールを活用した企業の導入事例や、実務での活用方法をまとめた資料を無料でダウンロードいただけます。

まとめ

本記事では、最新の動画生成AIモデル「Runway Gen-3 alpha」について、その特徴や機能、使用方法を実際に試しながら紹介しました。

Gen-3は画質や一貫性が大幅に向上し、改良されたMotion Brushや詳細なアートディレクション機能を備えています。

動画生成AIは急速に進化しており、今後はクリエイティブな活動やビジネスでの活用がさらに広がると予想されます。

Runway Gen-3を通じて、AIによる動画生成の最前線を体験していただければ幸いです。