この記事のポイント

NVIDIA Jetsonは、エッジデバイス上で高度なAI処理を実行するために設計された組み込みコンピューティングボードのシリーズ

CPU, GPU(CUDAコア/Tensorコア), メモリ等を統合したSOMと、包括的なJetPack SDKで開発を支援

リアルタイム処理、プライバシー保護、オフライン動作、高度な自律性を実現し、エッジAI・ロボティクス分野で注目

Nano, Xavier, 最新のOrinファミリーなど、性能と用途に応じた多様なモデルラインナップを提供

自律移動ロボット、スマートシティ、製造業、ヘルスケアなど、多岐にわたる分野で活用されている

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

「AIをロボットやドローンに組み込みたいけど、普通のPCでは大きすぎる…」「現場でリアルタイムにAI処理を行いたいけど、クラウドとの通信が不安…」

そんなエッジAI開発の課題を解決するのが、NVIDIAの「Jetson」シリーズです。しかし、その種類や性能、開発環境について、どこから手をつければ良いか迷う方も多いのではないでしょうか。

本記事では、この強力なエッジAIプラットフォーム「NVIDIA Jetson」について、その基本から最新情報までを徹底的に解説します。

Jetsonのハードウェア構成、AI処理性能を支える技術、開発を加速するソフトウェアエコシステム、そして自律移動ロボットからスマートシティまで、幅広い活用事例を詳しくご紹介します。

目次

Jetsonが注目される理由:エッジAI・ロボティクスとの密接な関係

NVIDIA Jetsonシリーズ:モデル別ラインナップと進化

他の組み込みプラットフォームとの違い (例: Raspberry Pi + AIアクセラレータなど)

NVIDIA Jetsonとは?

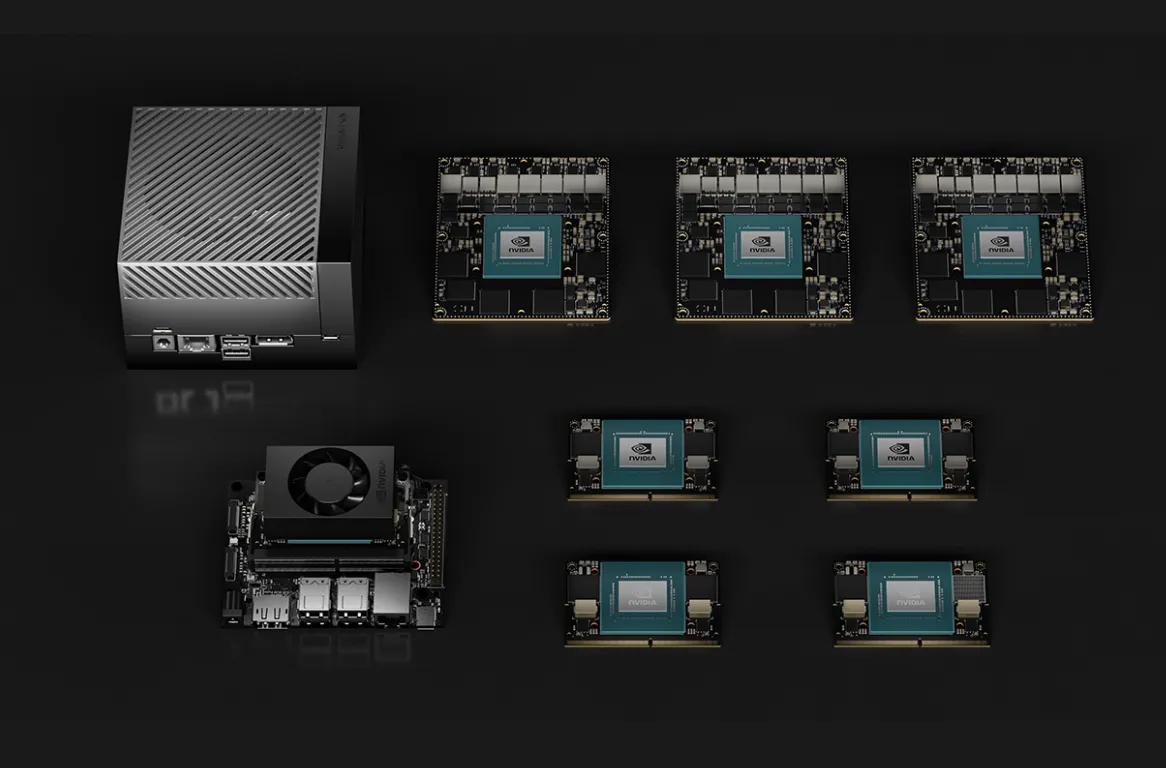

NVIDIA Jetsonは、NVIDIA社が提供する組み込みコンピューティングボードのシリーズです。ロボット、ドローン、インテリジェントカメラ、ポータブル医療機器など、様々なエッジデバイス上で高度なAI処理を実行するために設計されており、データセンターで学習させたAIモデルを、現場に近い場所でリアルタイムに活用することを可能にします。

Jetsonは単なるハードウェアではなく、AI開発を加速するための包括的なソフトウェアスタックと共に提供される点が大きな特徴です。

NVIDIA Jetsonのイメージ (参考:NVIDIA)

Jetsonの全体像:基本構成からAI性能、開発効率まで

このセクションでは、NVIDIA Jetsonのハードウェア構成から、そのAI処理能力、そして開発を効率化するソフトウェア技術まで、Jetsonの主要な特徴をまとめて解説します。

Jetsonがどのようにして強力なAI処理能力を実現し、開発者の生産性向上に貢献するのか、具体的な技術やツールと共に見ていきましょう。

ハードウェアの基本構成

NVIDIA Jetsonの物理的な側面と、その設計がもたらす利点について説明します。

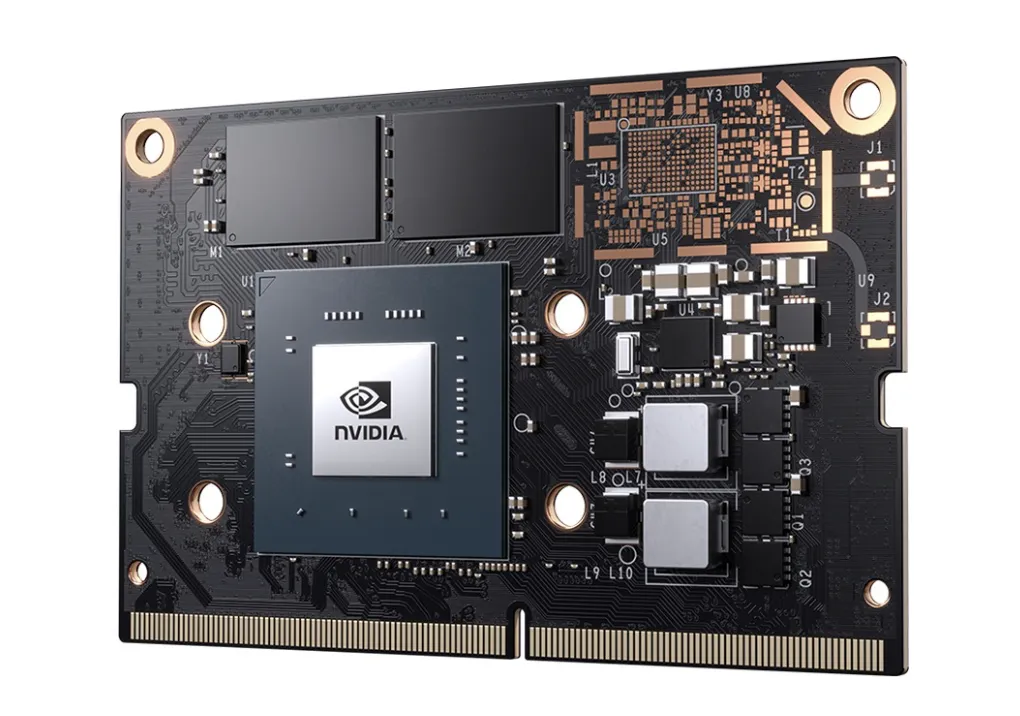

SOM (System-on-Module)

Jetsonデバイスの多くは、CPU、GPU、メモリ、ストレージ、電源管理IC(PMIC)などが一つの小さなモジュールに統合された「System-on-Module(SOM)」として提供されます。

これにより、開発者はキャリアボードを設計するだけで、Jetsonモジュールを最終製品に容易に組み込むことができます。

このモジュール設計は、製品開発の柔軟性と市場投入までの時間短縮に貢献します。

NVIDIA GPUアーキテクチャの継承

Jetsonに搭載されるGPUは、NVIDIAのデータセンター向けGPUやPC向けGeForceシリーズと同じ、先進的なGPUアーキテクチャ(例: Maxwell, Pascal, Volta, Ampere)をベースにしています。

これにより、エッジデバイスにおいてもCUDA®コアや、世代によってはTensorコアといった専用計算ユニットによる強力な並列処理能力とAI演算性能を利用できます。

特にTensorコアは、AIの推論処理を大幅に高速化する上で重要な役割を果たします。

【関連記事】

▶︎Tensorコアとは?CUDAコアとの違いや各世代の特徴を比較解説!

電力効率

Jetsonモジュールは、高い処理性能を発揮しながらも、消費電力を低く抑えるように設計されています。例えば、Jetson Orin Nanoシリーズは7Wから15Wの範囲で動作し、Jetson Orin NXシリーズは10Wから25Wの範囲で動作します。

この優れた電力効率により、バッテリー駆動のポータブルデバイスや、熱設計に制約のある小型製品への組み込みに適しています。

多様なインターフェース

Jetsonモジュールを搭載した開発キットやキャリアボードは、様々なセンサーや周辺機器と接続するための豊富なインターフェースを備えています。

- カメラインターフェース: MIPI CSI-2コネクタを複数備え、高解像度カメラを接続可能。

- ディスプレイ出力: HDMIやDisplayPort。

- 高速ストレージ: M.2 Key Mスロット (NVMe SSD用)。

- ネットワーク: ギガビットイーサネット。

- USB: USB 3.2 Gen2などの高速USBポート。

- 汎用I/O: GPIO、I2C、SPI、UARTなど。

これらのインターフェースにより、ロボットの目となるカメラ、モーター制御、センサーデータの収集など、多岐にわたるアプリケーションに対応できます。

AI処理性能とそれを支える技術

NVIDIA Jetsonが持つAI処理能力の具体的な指標と、その性能を引き出すコア技術について解説します。

AIベンチマーク

NVIDIA Jetsonプラットフォームは、画像分類(ResNet-50など)、物体検出(SSD、YOLOなど)、セグメンテーション、自然言語処理(BERTなど)といった標準的なAIモデルにおいて高い推論パフォーマンスを発揮します。具体的なフレームレート(FPS)はモデルや設定、Jetsonの機種によって異なりますが、Jetson AGX Orinのようなハイエンドモデルでは、複数の高解像度ビデオストリームをリアルタイムで処理する能力があります。

NVIDIAはMLPerfなどの業界標準ベンチマークにも積極的に参加し、Jetsonプラットフォームの優れたAI性能を実証しています。

Tensorコアの活用

Voltaアーキテクチャ(Jetson Xavierシリーズ)以降のJetsonモジュールには、AI計算、特にディープラーニングで多用される行列演算を高速化するための専用計算ユニット「Tensorコア」が搭載されています。

Tensorコアは、FP16(半精度浮動小数点数)やINT8(8ビット整数)といった低精度での演算を得意とし、混合精度コンピューティングにより、精度を維持しつつ処理速度を大幅に向上させます。

Jetson Orinシリーズに搭載されているAmpereアーキテクチャの第3世代Tensorコアは、さらに効率が向上し、構造的スパース性(Structured Sparsity)をサポートすることで、対応するニューラルネットワークの演算スループットをさらに高めることができます。

NVIDIAソフトウェアによる推論最適化 (TensorRT)

学習済みのニューラルネットワークモデルをJetsonプラットフォーム上で最高のパフォーマンスで実行するためには、最適化が不可欠です。

NVIDIA TensorRT™ は、高性能ディープラーニング推論オプティマイザおよびランタイムであり、この役割を担います。

TensorRTは、モデルのグラフ最適化、レイヤー融合、精度キャリブレーション、カーネルの自動選択などを行い、特定のJetsonデバイスのGPUアーキテクチャに合わせて推論エンジンを最適化します。

これにより、多くの場合、TensorFlowやPyTorchなどのフレームワークで直接推論を実行するよりも大幅なレイテンシ削減とスループット向上が期待できます。

【関連記事】

▶︎TensorRTとは?対応GPUや導入方法、使い方をわかりやすく解説!

開発を支援するソフトウェアエコシステム

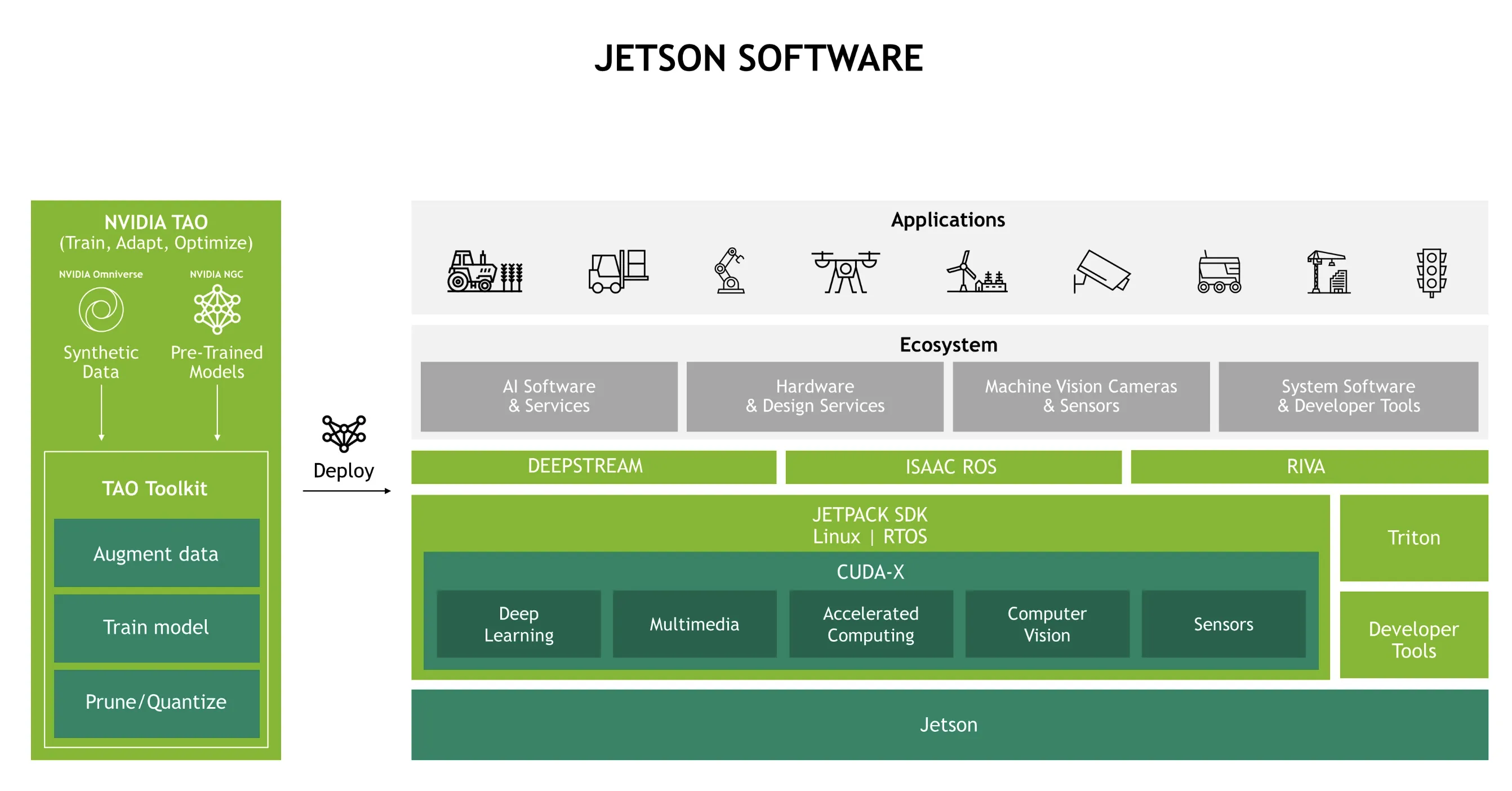

NVIDIA Jetsonの能力を最大限に引き出し、効率的なAIアプリケーション開発を実現するためには、多層的で包括的なソフトウェアエコシステムが不可欠です。

その全体像は下図に示すように、オペレーティングシステムレベルから、AIモデル開発、推論実行、アプリケーション特化型SDK、そして開発ツール群まで、広範なコンポーネントで構成されています。

NVIDIA Jetson ソフトウェアエコシステムの全体像 (参考:NVIDIA)

この広範なエコシステムが、Jetsonプラットフォーム上でのエンドツーエンドのAIソリューション開発を強力にサポートします。

NVIDIA JetPack SDK (概要)

NVIDIA JetPack™ SDKは、Jetsonプラットフォーム向けの最も包括的なソフトウェア開発キットです。これには、Linuxオペレーティングシステム(Jetson Linux)、CUDA-Xアクセラレーテッドライブラリ(CUDA、cuDNN、TensorRTなど)、API、開発者ツール、サンプルコードなどが含まれており、AIアプリケーションの開発をエンドツーエンドでサポートします。

JetPack SDKを利用することで、開発者はJetsonのハードウェア性能を最大限に引き出し、開発効率を高めることができます。JetPack 6.2のような最新バージョンでは、パフォーマンスの向上や新たな機能が追加されています。

NVIDIA TAO Toolkit (Train, Adapt, and Optimize)

NVIDIA TAO Toolkitは、AIモデルの開発とファインチューニングを簡素化し、高速化するためのローコードAI/MLツールキットです。開発者は、NVIDIA NGC™カタログから高品質な事前学習済みモデルを選択し、自身のカスタムデータセットを使って特定のタスクに適応(ファインチューニング)させることができます。

TAO Toolkitは、モデルのプルーニング(枝刈り)や量子化といった最適化機能も提供し、Jetsonデバイスでのデプロイに適した軽量かつ高性能なモデルを効率的に作成することを支援します。

コーディングの専門知識が少なくても、高度なAIモデルを構築できる点が魅力です。

Jetsonが注目される理由:エッジAI・ロボティクスとの密接な関係

NVIDIA JetsonがエッジAIやロボティクスの分野で特に注目を集めている理由について、その具体的な利点と共に解説します。

リアルタイム処理の実現

自動運転車、自律型ドローン、工場の検査ロボットなど、多くのエッジAIアプリケーションでは、瞬時の判断と応答が不可欠です。Jetsonは、強力なオンボードGPUにより、収集したセンサーデータをクラウドに送信することなく、デバイス上で直接AIモデルを実行し、リアルタイムに結果を出力します。

これにより、通信遅延の影響を受けない、信頼性の高いリアルタイムシステムを構築できます。

プライバシーとセキュリティの向上

医療データや個人の行動データなど、機密性の高い情報を扱う場合、データを外部のクラウドに送信することなくローカルで処理できるエッジコンピューティングは、プライバシー保護の観点から非常に重要です。Jetsonは、データをデバイス内部で完結して処理することで、情報漏洩のリスクを低減します。

また、Jetsonプラットフォームには、セキュアブートやハードウェア暗号化アクセラレーションといったセキュリティ機能も備わっています。

ネットワーク帯域幅の削減とオフライン動作

高解像度のカメラ映像など、大量のデータを常にクラウドに送信するには、広帯域なネットワーク接続が必要となり、通信コストも増大します。Jetsonを用いてエッジでデータを処理し、必要な情報だけをクラウドに送ることで、ネットワーク帯域幅の消費を大幅に削減できます。

また、ネットワーク接続が不安定な環境や、完全にオフラインの環境でもAI機能を利用できるため、活用の幅が広がります。

高度な自律性の実現

ロボットが周囲の環境を正確に認識し、状況に応じて自律的に判断し行動するためには、高度なAI処理能力が不可欠です。Jetsonは、複数のセンサーからの情報を統合し(センサーフュージョン)、複雑なAIモデルを実行することで、ロボットや自律マシンに人間のような認識・判断能力を与えます。

NVIDIA Isaac SDKのような専用ソフトウェアと組み合わせることで、より洗練された自律システムの開発が加速されます。

NVIDIA Jetsonシリーズ:モデル別ラインナップと進化

NVIDIA Jetsonは、初代のJetson TK1から始まり、TX1, TX2を経て、Nano、Xavier、そして最新のOrinファミリーへと進化を遂げてきました。ここでは主要な現行モデルを中心に、そのスペックと特徴を紹介します。

各モデルファミリーの進化

Nanoシリーズ

- Jetson Nano:

Maxwellアーキテクチャ搭載。5W/10WのTDPモードで動作し、教育・ホビー・小規模エッジAI向け。

(参考:NVIDIA)

TXシリーズ

- Jetson TX1: Maxwellアーキテクチャ初代エッジAIボード。現行流通は少ないが一部産業用途に現役。

- Jetson TX2: Pascalアーキテクチャ搭載。7.5W/15Wモード。産業組込み・商用ロボットで根強い流通。

(参考:NVIDIA)

Xavierシリーズ

- Jetson Xavier NX: Voltaアーキテクチャ+Tensorコア。10W/20Wモードで最大21 INT8 TOPS。小型商用ロボットやAIカメラ向け。

(参考:NVIDIA)

Jetson AGX Xavier:

Voltaアーキテクチャ。最大32 INT8 TOPS。30W/32Wモード。産業機器や重装ロボティクス向け。

(参考:NVIDIA)

Orinシリーズ

-

Jetson Orin Nano:

Ampereアーキテクチャのエントリーモデル。20~40 INT8 TOPS、7W/10W/15W対応。従来Nanoの上位互換。

(参考:NVIDIA)

-

Jetson Orin NX:

Ampereアーキテクチャ+第3世代Tensorコア。70~100 INT8 TOPS。10W/15W/20W/40W。多用途なAIエッジ実装に対応。

(参考:NVIDIA)

- Jetson AGX Orin:

Orinシリーズ最上位。200~275 INT8 TOPS(32GB/64GBモデル)。TDPは15W~60W。大規模産業AI・自律ロボティクス用途。

(参考:NVIDIA)

- Jetson AGX Orin:

各モデルファミリーの概要

- (参考:NVIDIA)*

Nanoシリーズ

Jetson Nano:

Maxwellアーキテクチャを搭載。5W/10WのTDPモードで動作し、教育やホビー用途に最適。

Jetson Orin Nano:

Ampere世代を採用し、従来のJetson Nanoと比較してAI性能が大幅に向上(最大約40 TOPS)。最小7Wから利用可能。

Xavierシリーズ

Jetson Xavier NX:

VoltaアーキテクチャとTensorコアを搭載し、10W/20Wモードで最大21 INT8 TOPSのAI性能を実現。クレジットカードサイズで商用ロボットに適した性能を提供。

Orinシリーズ

Jetson Orin Nano / Orin NX:

最新のAmpere GPUアーキテクチャとArm Cortex-A78AE CPUコアを採用し、Tensorコア第3世代を搭載。

Orin Nanoは20~40 INT8 TOPS、Orin NXは70~100 INT8 TOPSを提供し、10W~40Wモードで動作可能。

- Jetson AGX Orin:

Ampere世代の最上位シリーズ。AGX Orin 32GBは200 INT8 TOPS、AGX Orin 64GBは275 INT8 TOPSを実現。TDPモードは15Wから最大60Wまでサポートし、最先端ロボティクスや産業用途で高い処理能力を発揮。

ハードウェア構成

以下の表は、各JetsonモデルのCPUコア構成、GPUアーキテクチャ、およびCUDAコア・Tensorコアの搭載数を比較したものです。

- アーキテクチャ名:各Jetsonモデルが採用しているNVIDIAのGPU世代やCPUコア種別を示します。

- CUDAコア:画像処理や並列演算に用いる汎用計算ユニット、Tensorコアはディープラーニング推論を高速化する専用演算ユニットです。

- CPUコア:モデルごとに数・クロック・アーキテクチャが異なり、組み込みAI用途に応じた選択が可能です。

| モデル名 | アーキテクチャ | GPU (CUDAコア / Tensorコア) | CPUコア |

|---|---|---|---|

| Jetson Nano | Maxwell | 128 / 0 | Quad-core ARM A57 @ 1.43GHz |

| Jetson TX2 | Pascal | 256 / 0 | Dual-core Denver2 + Quad-core ARM A57 |

| Jetson Xavier NX | Volta | 384 / 48 | 6-core NVIDIA Carmel ARMv8.2 @ 1.4GHz |

| Jetson AGX Xavier | Volta | 512 / 64 | 8-core NVIDIA Carmel ARMv8.2 @ 2.26GHz |

| Jetson Orin Nano 4GB | Ampere | 512 / 16 | 6-core Arm Cortex-A78AE v8.2 @ 1.5GHz |

| Jetson Orin Nano 8GB | Ampere | 1024 / 32 | 6-core Arm Cortex-A78AE v8.2 @ 1.5GHz |

| Jetson Orin NX 8GB | Ampere | 1024 / 32 | 8-core Arm Cortex-A78AE v8.2 @ 1.5GHz |

| Jetson Orin NX 16GB | Ampere | 1024 / 32 | 8-core Arm Cortex-A78AE v8.2 @ 2.0GHz |

| Jetson AGX Orin 32GB | Ampere | 1792 / 56 | 12-core Arm Cortex-A78AE v8.2 @ 2.2GHz |

| Jetson AGX Orin 64GB | Ampere | 2048 / 64 | 12-core Arm Cortex-A78AE v8.2 @ 2.2GHz |

Jetson NanoやTX2は入門~産業組込み用途に広く使われており、Xavier・OrinシリーズになるとCUDA/Tensorコア数・CPUコア数ともに増強され、高度なAI推論や並列処理が求められる自律ロボットやAIカメラなどの実用現場で利用されています。

メモリ・AI性能・消費電力

各Jetsonモデルのメモリ容量、AI推論性能(INT8 TOPS値)、および対応する動作電力(TDPモード)の比較です。

- メモリ:モデルごとに容量や帯域幅が異なり、大規模AI処理や高解像度画像のストリーミングに影響します。

- AI性能(INT8 TOPS):8ビット整数演算による理論上の最大AI推論スループットを示します。

- 消費電力(TDPモード):用途やデバイス設計に応じて設定可能な電力範囲です。

| モデル名 | メモリ | AI性能 (INT8 TOPS) | 消費電力 (TDPモード) |

|---|---|---|---|

| Jetson Nano | 4GB LPDDR4 (25.6GB/s) | 0.472 (FP16) | 5W / 10W |

| Jetson TX2 | 8GB LPDDR4 (59.7GB/s) | 1.33 (FP16) | 7.5W / 15W |

| Jetson Xavier NX | 8GB LPDDR4x (59.7GB/s) | 21 | 10W / 15W / 20W |

| Jetson AGX Xavier | 16GB LPDDR4x (137GB/s) | 32 | 30W / 32W |

| Jetson Orin Nano 4GB | 4GB LPDDR5 (34GB/s) | 20 | 7W / 10W |

| Jetson Orin Nano 8GB | 8GB LPDDR5 (68GB/s) | 40 | 7W / 15W |

| Jetson Orin NX 8GB | 8GB LPDDR5 (68GB/s) | 70 | 10W / 15W / 20W / 40W |

| Jetson Orin NX 16GB | 16GB LPDDR5 (102.4GB/s) | 100 | 10W / 15W / 25W / 40W |

| Jetson AGX Orin 32GB | 32GB LPDDR5 (204.8GB/s) | 200 | 15W – 60W |

| Jetson AGX Orin 64GB | 64GB LPDDR5 (204.8GB/s) | 275 | 15W – 60W |

NanoやTX2は低消費電力・低価格帯ながら産業導入も多く、Xavier NX/AGX Xavierはより高いAI性能と多メモリで本格的なAI推論を必要とする現場向き。OrinシリーズはAI性能が飛躍的に強化され、消費電力設定の幅も広く、大規模なAIワークロードやリアルタイム推論が求められる産業・ロボティクス用途に対応できます。

他の組み込みプラットフォームとの違い (例: Raspberry Pi + AIアクセラレータなど)

市場には様々な組み込みプラットフォームが存在しますが、NVIDIA Jetsonがそれらとどのように異なり、どのような強みを持つのかを解説します。

統合されたAI処理能力

Raspberry Piのような汎用シングルボードコンピュータにUSB接続のAIアクセラレータを追加する構成と比較して、NVIDIA JetsonはNVIDIA GPUがSoCに緊密に統合されている点が大きな違いです。

これにより、データ転送のボトルネックが少なく、より高いAI処理性能と効率を実現できます。

Jetsonに搭載されているGPUは、AI処理に特化したTensorコア(Voltaアーキテクチャ以降のモデル)を含むことが多く、専用設計ならではのパフォーマンスを発揮します。

ソフトウェアエコシステム

NVIDIA Jetsonの最大の強みの一つは、成熟し、広範囲にわたるソフトウェアエコシステムです。

JetPack SDKには、AI推論を最適化するTensorRT、コンピュータビジョンライブラリのOpenCV、マルチメディア処理ライブラリなどが標準で含まれています。

さらに、ロボティクス開発を加速するNVIDIA Isaac™プラットフォームや、インテリジェントビデオ解析(IVA)アプリケーション構築のためのDeepStream SDKなど、用途特化型の高度なSDKも利用可能です。

スケーラビリティ

NVIDIA Jetsonファミリーは、エントリーレベルのJetson Nanoから、最新かつ最も強力なJetson AGX Orin™シリーズまで、幅広い性能と価格帯のラインナップを提供しています。

これにより、開発者は初期のプロトタイピングから量産製品まで、要求されるAI性能やコストに応じて最適なモジュールを選択し、ソフトウェア資産を再利用しながらシームレスにスケールアップ/ダウンすることが可能です。

産業用途への対応

Jetsonモジュールの中には、より過酷な環境での動作を想定した産業グレードの製品や、長期供給が保証されたモデルも存在します。

これは、信頼性や製品ライフサイクル管理が重要となる産業機器や組み込みシステムへの導入において大きなメリットとなります。

NVIDIA Jetsonの使い方:開発フローとソフトウェアスタック

NVIDIA Jetsonを使ってAIアプリケーションを開発するための一般的なフローと、それを支える主要なソフトウェアコンポーネントについて解説します。

開発の始め方

Jetsonでの開発を始めるには、まずNVIDIA Jetson開発者キット(Developer Kit)を入手します。開発キットにはJetsonモジュールと、必要なインターフェースを備えたリファレンスキャリアボード、電源アダプタなどが含まれています。

次に、NVIDIA SDK Managerを使用して、最新のNVIDIA JetPack SDKを開発キットにインストール(フラッシュ)します。SDK ManagerはホストPC(通常はUbuntu Linuxマシン)上で動作し、JetsonデバイスへのOSイメージの書き込みや各種ソフトウェアパッケージのインストールをガイドしてくれます。

NVIDIA JetPack SDK

前述の通り、JetPack SDKはJetson開発の基盤となるソフトウェアスイートです。主なコンポーネントは以下の通りです。

- Jetson Linux (L4T): UbuntuベースのLinuxオペレーティングシステムで、Linuxカーネル、ブートローダー、NVIDIAドライバ、ファームウェアなどが含まれます。

- CUDA Toolkit: NVIDIA GPU向けの並列コンピューティングプラットフォームおよびプログラミングモデル。Jetson上でGPUアクセラレーションを利用したアプリケーションを開発するために不可欠です。

- cuDNN: ディープニューラルネットワーク向けのGPUアクセラレーテッドライブラリ。畳み込み、プーリングなどの標準ルーチンを高速化します。

- TensorRT: 高性能ディープラーニング推論オプティマイザおよびランタイム。

- Vision Programming Interface (VPI): コンピュータビジョンや画像処理アルゴリズムをGPUやPVA(Programmable Vision Accelerator)などのハードウェアアクセラレータ上で実行するためのライブラリです。

- OpenCV: オープンソースのコンピュータビジョンライブラリ。Jetson向けに最適化されています。

- マルチメディアAPI: ビデオのエンコード/デコード、カメラ制御などのためのライブラリ群。

- 開発者ツール: パフォーマンス解析ツール(Nsight Systems、Nsight Graphics)、デバッガなど。

最新のJetPack 6では、Linuxカーネルのアップストリームサポートや、Jetson AIスタックの独立アップデートなど、柔軟性が向上しています。

コンテナ技術の活用

Jetsonプラットフォームでは、Dockerコンテナを利用したアプリケーションの開発とデプロイが推奨されています。NVIDIA Container Runtimeを使用することで、GPUリソースにアクセス可能なコンテナをJetson上で実行できます。

コンテナ化により、開発環境と実行環境の分離、依存関係の管理、アプリケーションのポータビリティと再現性が向上します。NVIDIA NGCカタログからは、最適化済みのAIモデルやフレームワークを含む多数のコンテナイメージが提供されています。

AIモデルのデプロイ

TensorFlow、PyTorch、MXNetなどの主要なディープラーニングフレームワークで学習したモデルは、ONNX (Open Neural Network Exchange) 形式を経由するなどしてTensorRTに取り込み、Jetsonデバイス向けに最適化された推論エンジンとしてデプロイできます。

TAO Toolkitで作成したモデルも、TensorRTによる最適化を経てデプロイされます。

アプリケーション開発用SDK

Jetsonプラットフォームの能力を最大限に活用し、特定のアプリケーション開発を加速するために、NVIDIAは以下のような専用SDKを提供しています。

NVIDIA DeepStream SDK:

ストリーミングビデオやオーディオからAIで洞察を得るための、スケーラブルなインテリジェントビデオアナリティクス (IVA) アプリケーション構築用SDKです。

複数のビデオ/センサー入力を処理し、物体検出、追跡、分類などのAIタスクを効率的に実行するパイプラインを構築できます。GStreamerフレームワークをベースにしており、C/C++やPythonで開発可能です。

NVIDIA Isaac Sim™ / Isaac ROS:

ロボットのシミュレーション、ナビゲーション、操作のためのAIアルゴリズム開発を支援するプラットフォームです。

-

Isaac Sim

NVIDIA Omniverse™上に構築されたロボティクスシミュレーションアプリケーションで、物理的に正確な仮想環境でロボットのテストや学習を行えます。

-

Isaac ROS

Jetson上でハードウェアアクセラレーションを活用したROS 2パッケージ群を提供し、ロボットの認識(Visual SLAM、深度推定など)やナビゲーション機能を強化します。

NVIDIA Jetsonの主な活用事例

NVIDIA Jetsonの強力なエッジAI処理能力は、既に様々な分野で革新的な製品やソリューションを生み出しています。

自律移動ロボット (AMR)・ドローン

工場や倉庫内を自律的に移動して物品を搬送するAMR、広範囲を監視する警備ドローン、農薬散布や生育状況を監視する農業用ドローンなど、Jetsonはこれらのロボットやドローンが周囲の環境を3Dで認識し、障害物を回避しながら目的地へ移動するための「頭脳」として機能します。

スマートシティ・インフラ

都市における交通流の解析と信号機の最適化、交差点での危険挙動の検知、公共施設やイベント会場での不審者・放置物の監視、橋梁や送電線といったインフラ設備のドローンによる自動点検など、Jetsonは都市機能の効率化と安全性の向上に貢献しています。

製造業・ファクトリーオートメーション

製造ラインにおける製品の外観検査(AOI:Automated Optical Inspection)の精度向上、製造装置の異常を予兆して通知する予知保全、ロボットアームによる複雑な組み立て作業やピッキング作業の自動化など、Jetsonはスマートファクトリーの実現を支援します。

小売・サービス

カメラ映像から顧客の属性や動線を分析して店舗レイアウトを最適化する、棚の欠品を自動的に検知する、レジなし決済を実現するスマートカート、AIを活用した対話型デジタルサイネージなど、Jetsonは小売業における顧客体験の向上と業務効率化に活用されています。

ヘルスケア・医療

持ち運び可能な超音波診断装置や内視鏡システムにAI画像解析機能を組み込み、医師の診断を支援する、手術支援ロボットの精度を高める、リハビリテーションをサポートするロボットなど、Jetsonは医療現場におけるイノベーションを促進しています。

農業 (スマートアグリ)

ドローンや地上ロボットに搭載されたJetsonが、カメラやセンサーからの情報に基づいて農作物の生育状況を詳細に把握し、病害虫を早期に発見したり、必要な場所にだけピンポイントで農薬や肥料を散布したりする精密農業を実現します。

教育・研究

Jetson開発者キットは、その手頃な価格と高い性能から、大学や研究機関におけるAI・ロボティクス分野の人材育成や、新しいアルゴリズム、革新的なアプリケーションの研究開発プラットフォームとして広く採用されています。

エッジでの生成AI

最新のJetson Orinシリーズは、その高いAI処理能力により、小規模な大規模言語モデル(LLM)や画像生成モデルといった生成AIタスクをエッジデバイス上で実行する可能性を拓いています。

これにより、ネットワーク接続に依存しないインタラクティブなAI体験や、プライバシーに配慮したローカルでのコンテンツ生成などが期待されます。

Jetson Orin Nano Super Developer Kitは、このようなエッジでの生成AI開発をターゲットとしています。

AI導入でお悩みの方へ

まとめ

NVIDIA Jetsonは、コンパクトなフォームファクタに強力なAI処理能力と包括的なソフトウェアエコシステムを凝縮した、エッジAIおよびロボティクス開発における最先端プラットフォームです。エントリーレベルのJetson NanoからハイパフォーマンスなJetson AGX Orinまで、幅広いラインナップにより、開発者は多様なニーズに応じたソリューションを構築できます。

JetPack SDK、TensorRT、TAO ToolkitといったNVIDIAのソフトウェアスタックは、Jetsonのハードウェア性能を最大限に引き出し、AIアプリケーションの開発からデプロイまでを加速します。DeepStream SDKやIsaacプラットフォームのような専用SDKを活用することで、インテリジェントビデオ解析や自律ロボットといった高度なシステムの開発も効率的に進められます。

製造、小売、農業、医療、スマートシティなど、あらゆる産業でAIの活用が進む中、NVIDIA Jetsonはその中核技術として、よりインテリジェントで自律的な未来を実現するための重要な役割を担い続けるでしょう。エッジAIの世界に足を踏み入れようとする開発者にとって、NVIDIA Jetsonは強力な選択肢となるはずです。