この記事のポイント

Chatbot UIで「ローカルUI + クラウドAPI」「完全ローカルLLM」の2パターンを整理

Chatbot UIの導入手順(ローカル起動)と、環境変数・運用上の注意点を解説

会話履歴の管理、検索、テンプレートなど、業務で効く基本機能を紹介

料金はChatbot UIではなく、主に利用するモデル/APIで決まる点を分かりやすく整理

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

「ChatGPTをローカル環境で使いたい」「社内データを外に出さずに生成AIを試したい」と考えても、いきなりモデル運用や環境構築までやり切るのは大変です。

そこで本記事では、ChatGPT風の操作感をローカルで実現できるオープンソースのUIである「Chatbot UI」を軸に、現実的な導入パターンを整理します。

具体的には、クラウドのAPIを使って高品質な回答を得る方法と、OllamaやLM Studioなどを使ってローカルLLMを動かす方法の両方を扱います。費用の考え方や注意点も含めて、企業利用の判断に必要なポイントをまとめました。

ChatGPTの新料金プラン「ChatGPT Go」については、以下の記事をご覧ください。

ChatGPT Goとは?料金や機能、広告の仕様、Plus版との違いを解説

✅最新モデル「GPT-5.4」については、以下の記事をご覧ください。

GPT-5.4(ChatGPT5.4)とは?使い方や料金、GPT-5.2との違いを徹底解説

ChatGPTをローカル環境で利用する方法

ローカル環境とは?基本的な理解

ローカル環境とは、インターネット上のクラウドサーバーではなく、自分のパソコンや自社サーバー内でソフトウェアを動かす環境のことです。

生成AIで「ローカル」と言うと、次の2つが混同されやすいので、最初に切り分けておきます。

- ローカルで動くのがUIだけ

ブラウザやデスクトップの画面は手元で動くものの、回答を作る処理はクラウドAPIに投げる方式です。Chatbot UIはこの使い方が代表例です。

- 推論まで完全にローカル

モデル自体をローカルに置き、オフラインでも動かす方式です。OllamaやLM StudioなどでローカルLLMを動かします。

前者は導入が容易でモデル品質も高くしやすい一方、入力データは外部に送信されます。後者はデータを外部に出さずに済む一方、モデル選定やマシンスペック、運用設計の難易度が上がります。

ChatGPTの完全ローカル利用を検討するときの注意点

ChatGPTはクラウド上のサービスなので、一般的に「ChatGPTそのものをオフラインで動かす」という意味では使えません。

一方で、2026年時点では、OpenAIのオープンウェイトモデルをローカル環境で動かす選択肢も登場しています。たとえば、LM StudioでOpenAIのオープンウェイトモデルを実行する手順が公式に紹介されています。

ここで重要なのは、「ChatGPTをローカルにしたい」という目的を次のように言い換えることです。

- ローカルでChatGPT風の操作感がほしいのか

- 入力データを外部に出したくないのか

- 品質を優先したいのか、コストを優先したいのか

この整理ができると、導入パターンの選定が一気に楽になります。

本記事で紹介する2つのアプローチ

本記事では、次の2パターンを比較しながら解説します。

- Chatbot UI + クラウドAPI

ローカルでUIを動かし、OpenAIなどのAPIで高品質な回答を得る方法です。API利用時のデータ取り扱いは必ず公式ポリシーを確認してください。

- Chatbot UI + ローカルLLM

OllamaなどでローカルLLMを動かし、ChatGPT風のUIで使う方法です。完全オフライン運用を目指す場合の選択肢になります。

ChatbotUIとは

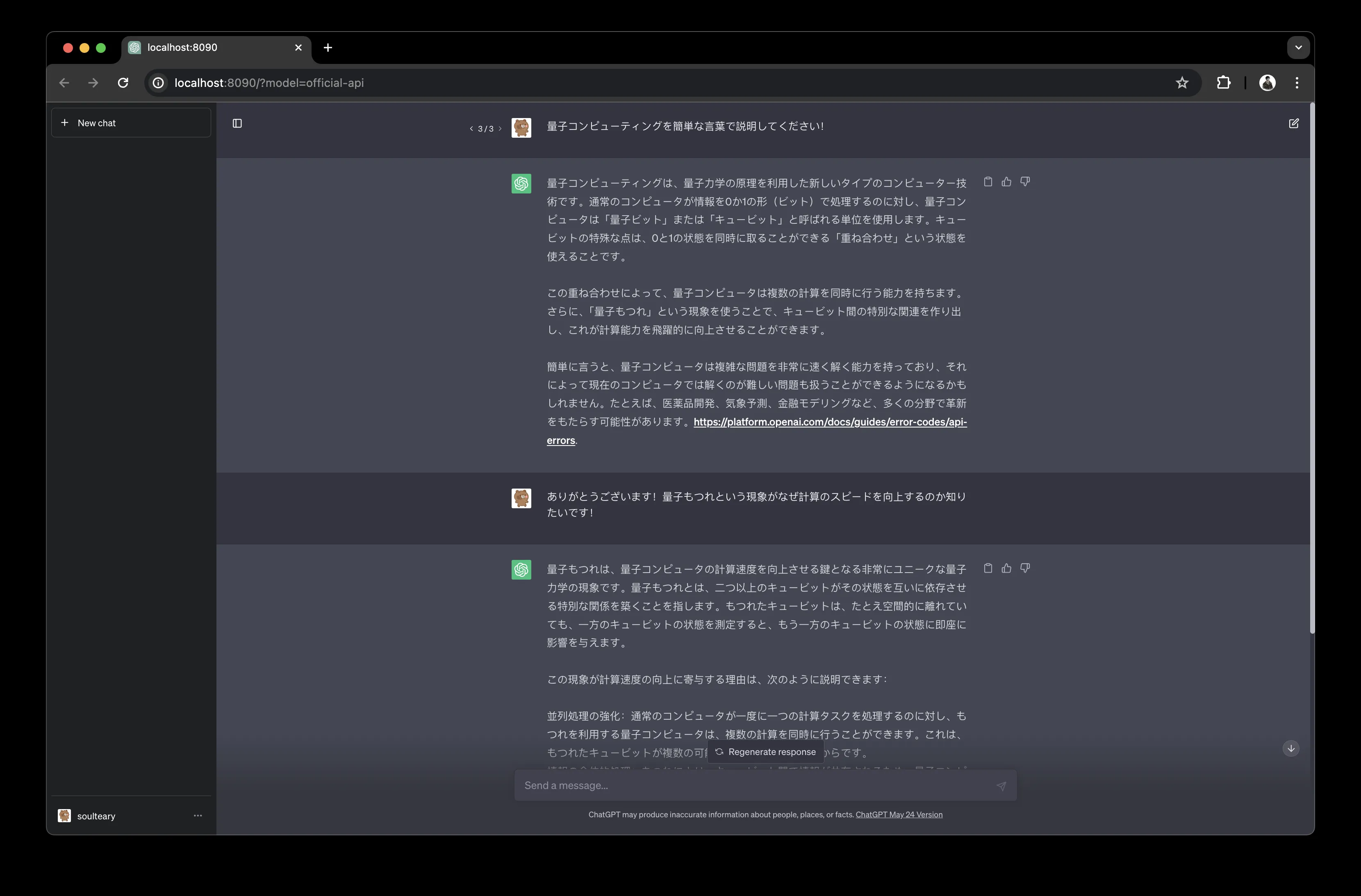

Chatbot UIは、ChatGPTに近い操作感を目指したオープンソースのチャットUIです。

企業利用でよくある「UIは使いやすいが、社内ポリシー上そのままChatGPTのWeb版は使いづらい」といった状況で、運用の落としどころを作りやすいのが特徴です。

Chatbot UI overhaul drops next week.

— Mckay Wrigley (@mckaywrigley) December 22, 2023

It’s honestly really, really good.

Powerful & polished.

And as always, 100% open-source. pic.twitter.com/enLG83iTNe

Chatbot UIでできることと特徴

Chatbot UIでできることを、業務で効く観点に絞って整理します。

- 会話の管理

会話履歴の整理や検索など、チーム・業務での再利用を意識した導線を作れます。

- プロンプトの再利用

よく使う指示をテンプレート化し、属人化を減らしやすくなります。

- モデルの切り替え

利用するモデルを切り替え、品質・コスト・機密性のバランスを取りやすくなります。

Chatbot UIが向くケース・向かないケース

導入前に、向き不向きを確認しましょう。

- 向くケース

既存のチャットUIだけでは運用しづらく、履歴管理やテンプレートで業務化したい場合に向きます。

- 向かないケース

クリックだけで完結するSaaSを求める場合や、管理者が環境・認証・データ保護を設計できない場合は、別の選択肢が合うことがあります。

Chatbot UIのメリットと注意点

最後に、導入判断に直結するポイントをまとめます。

- メリット

ローカルでUIを運用しつつ、クラウドAPIやローカルLLMを切り替えて使えるため、運用の自由度が高い点です。

- 注意点

クラウドAPIを使う場合、入力データは外部に送信されます。OpenAI APIのデータ取り扱いは公式ポリシーを必ず確認し、社内規程に合わせたルール(入力禁止情報、ログ保管、権限管理など)を整備してください。

社内要件でAzure OpenAIの利用を検討している場合は、以下の記事も参考になります。

【関連記事】

Azure OpenAI ServicesとChatGPT APIの違いを徹底比較!

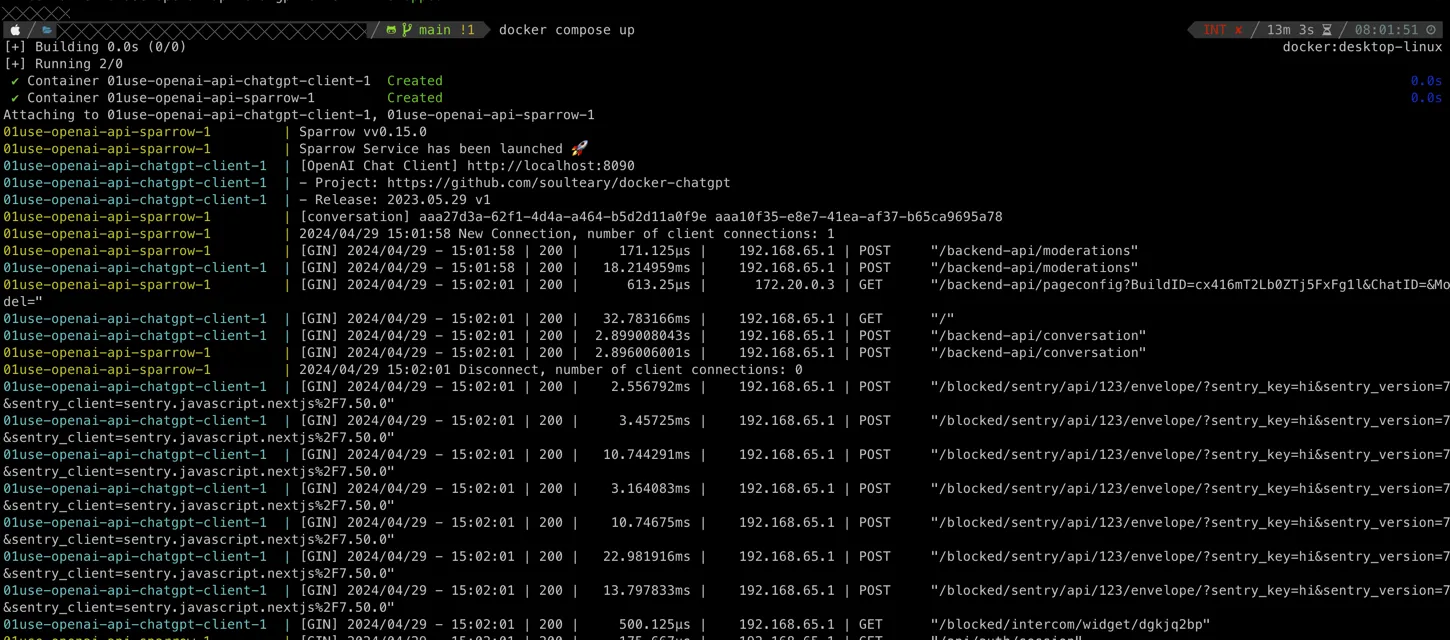

ChatBOT UIの導入方法

ここでは、公式手順をベースに「ローカルでChatbot UIを起動する」流れを紹介します。環境差分が出やすいので、最終的には公式リポジトリも参照してください。

事前準備

導入前に、次の準備を済ませておくとスムーズです。

- Docker Desktopの準備

Supabaseのローカル起動でDockerを使うため、Docker Desktopをインストールします。

- Node.jsの準備

互換性のあるNode.jsを用意します。

- OpenAI APIキーの準備(クラウドAPIを使う場合)

APIキーの発行手順は以下の記事も参考にしてください。

【関連記事】

ChatGPT(OpenAI)のAPIキー発行・取得手順を解説!支払い方法も

具体的な導入手順

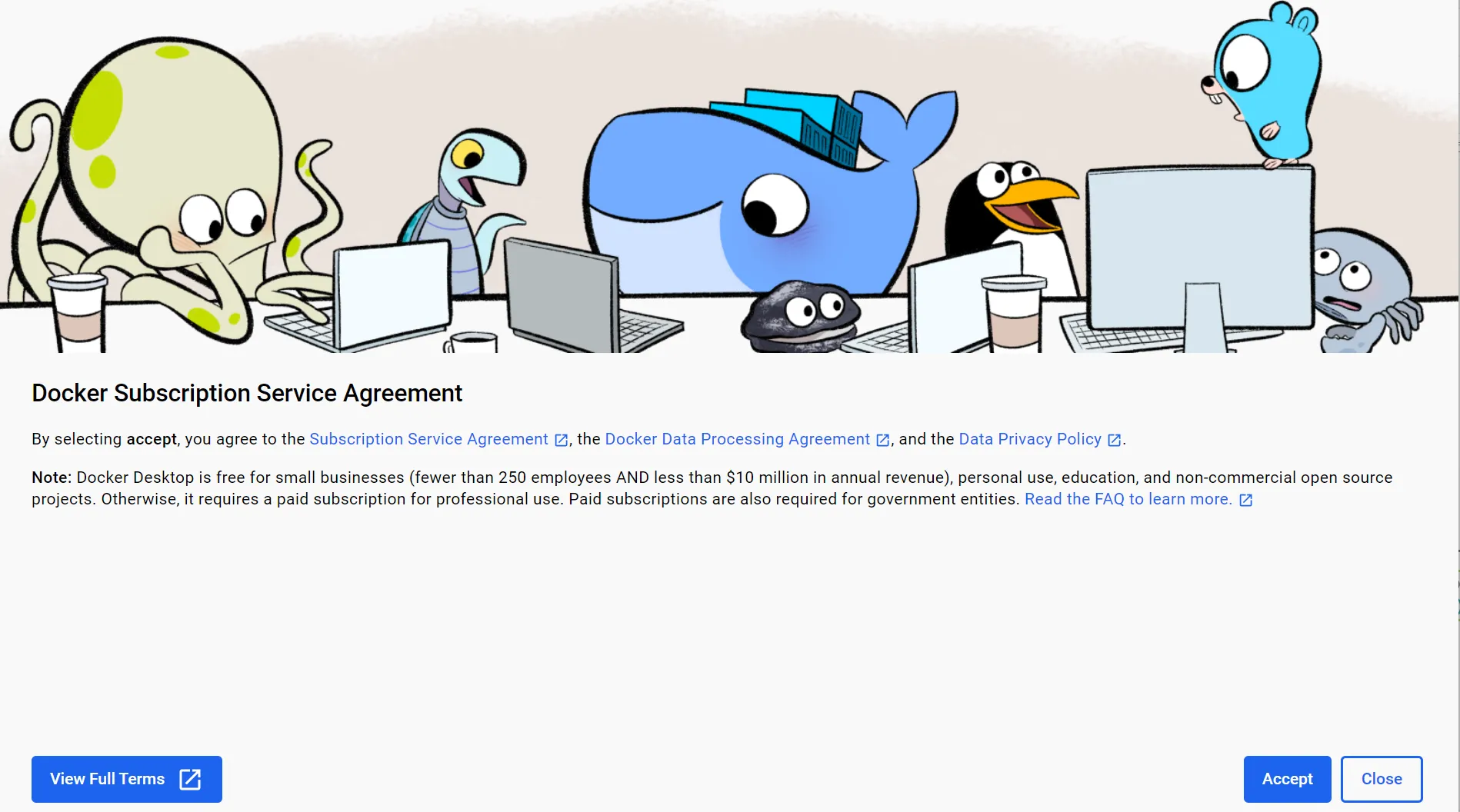

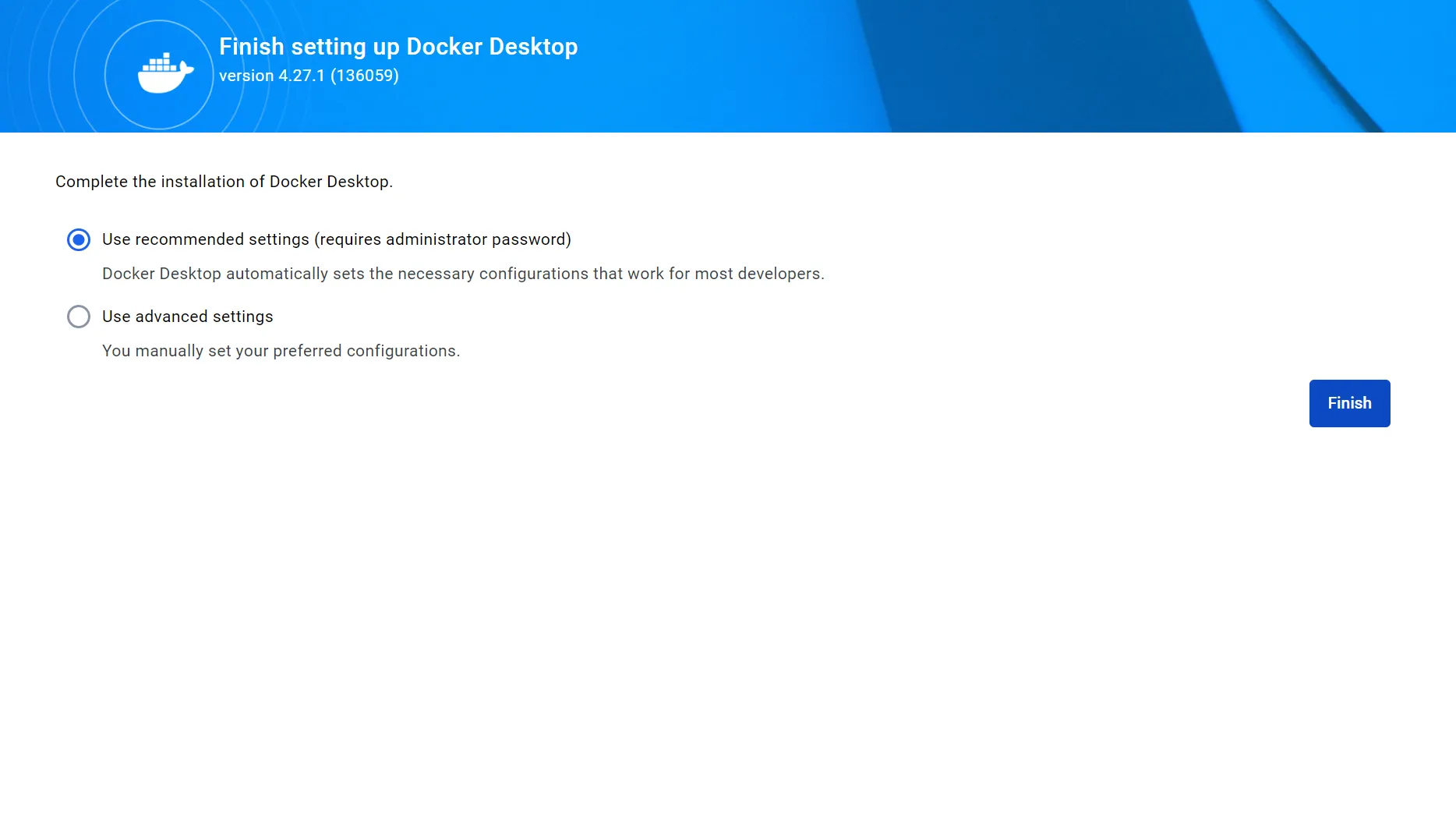

- Docker Desktopをインストールします。

導入手順1

導入手順2

導入手順3

- リポジトリを取得して依存関係をインストールします。

git clone https://github.com/mckaywrigley/chatbot-ui.git

cd chatbot-ui

npm install

- Supabaseをインストールして起動します。

macOSの場合は、Supabaseのインストール手段としてHomebrewがよく使われます。

brew install supabase/tap/supabase

supabase start

- Chatbot UIを起動します。

npm run chat

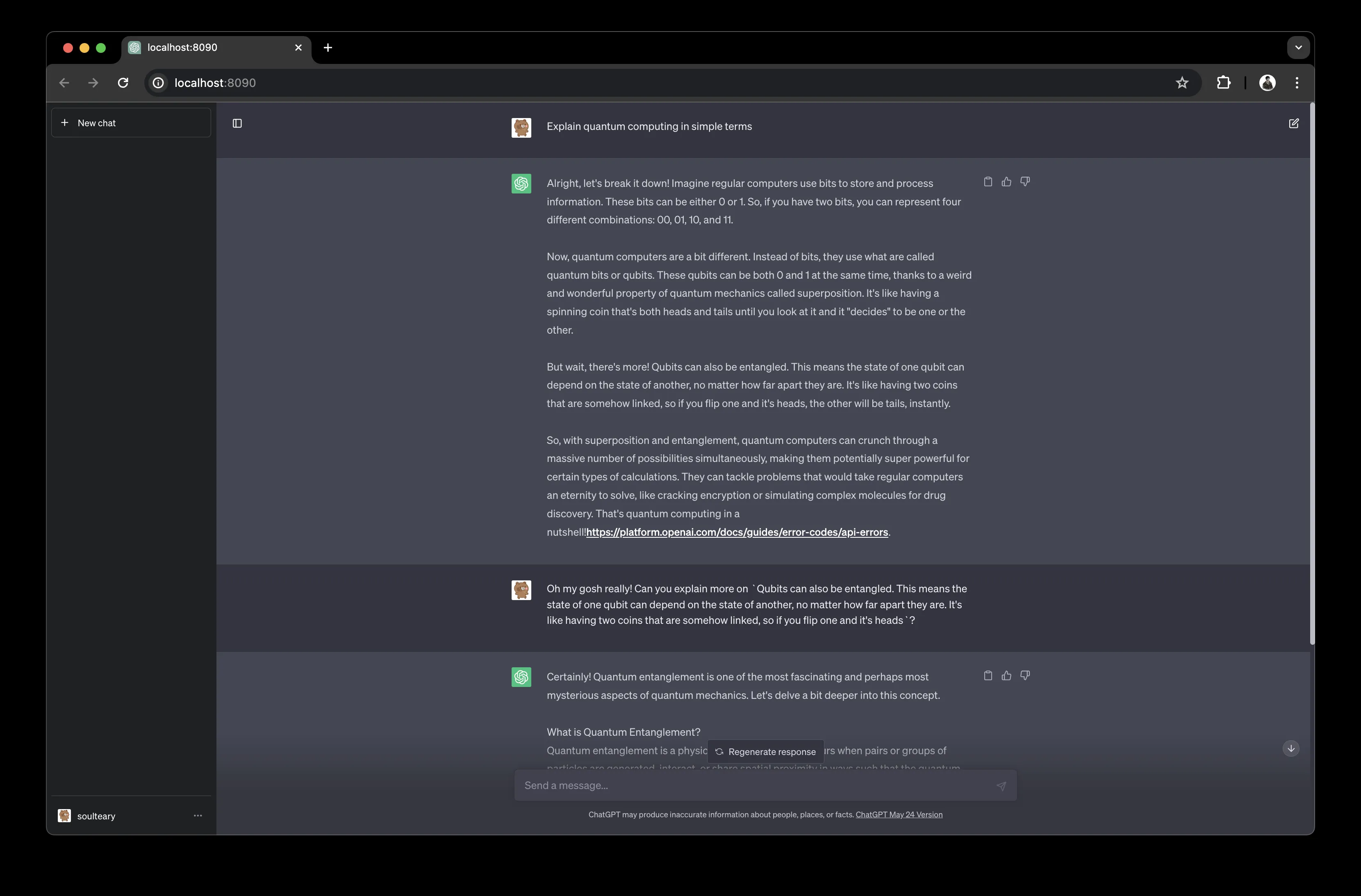

起動できると、ブラウザでローカルのChatbot UIにアクセスできるようになります。

エラー例

ChatBOT UIの使い方と基本操作

導入できたら、まずは業務で効く基本操作から押さえます。ここを押さえるだけでも「使い捨てのチャット」から「ナレッジとして蓄積できるチャット」に近づきます。

プロジェクトとしての使い方と運用の考え方

Chatbot UIは、単にチャットするだけでなく、会話履歴やテンプレートを使って業務に落とし込むのがポイントです。

たとえば、次のように用途ごとに運用ルールを決めておくと、チーム利用でも混乱しにくくなります。

- 入力してよい情報・ダメな情報を決める

個人情報や契約情報など、外部送信できない情報を明確にします。

- テンプレートを用意する

議事録要約、社内FAQ、文章校正など、よくあるタスクはテンプレート化します。

会話履歴のインポート/エクスポート

会話履歴をエクスポートできると、バックアップや環境移行がしやすくなります。

プロンプトのテンプレートを保存する

よく使う指示をテンプレートとして保存しておくと、毎回の入力が短くなり、品質も安定します。

具体的には、次のようなテンプレートが作りやすいです。

- 議事録を要点・ToDo・決定事項に分けて要約する

- 社内ルールに沿って文章を校正する

- 仕様書の観点漏れをチェックする

過去の会話履歴の検索と分類

会話履歴をキーワードで検索したり、用途別に整理したりできると、過去の知見を再利用しやすくなります。

特に、同じ種類の質問が繰り返されるチームでは、テンプレートと履歴検索の組み合わせが効いてきます。

Chatbot UIで使う完全ローカルLLMの活用

クラウドAPIを使わず、完全にローカルで推論したい場合は、ローカルLLMを使う構成を検討します。

この方式は「入力データを外部に送れない」など要件が強い場合に有力ですが、モデル更新や運用も含めて自社側で設計する必要があります。

ローカルLLMとは?

ローカルLLMとは、モデルをローカルに置き、手元のマシン上で推論を実行する方式です。インターネット接続が不要になり、入力データを外部に送信しない運用がしやすくなります。

ローカルLLMの全体像や導入パターンは、以下の記事も参考になります。

【関連記事】

ローカルLLMとは?メリットやおすすめモデル、導入方法を解説

ローカルLLMの実行環境

代表的な実行環境として、OllamaとLM Studioがあります。

- Ollama

ローカルLLMをコマンド中心で扱える環境です。Chatbot UI側は、OllamaのURLを指定して連携できます。

- LM Studio

ローカルLLMをGUI中心で扱える環境です。ローカルでモデルを動かす際の入門として選びやすい選択肢です。

【関連記事】

LM Studioとは?主要機能や使い方、商用利用について徹底解説

ローカルLLMとChatbot UIの連携

Chatbot UIでOllamaを使う場合は、環境変数としてOllamaのURLを設定します。デフォルトのURLは次の通りです。

NEXT_PUBLIC_OLLAMA_URL=http://localhost:11434

社内ネットワークで別ホストにOllamaを立てる場合は、このURLを社内アドレスに変更します。

ローカルLLMのメリットとデメリット

最後に、完全ローカル運用の判断材料をまとめます。

- メリット

入力データを外部に送信しない設計にしやすく、ネットワーク分離環境でも運用しやすい点です。

- デメリット

モデルサイズや設定で必要なマシンスペックが大きく変わります。また、モデル更新・脆弱性対応・ログ保管などを含めた運用設計が必要になります。

Chatbot UIの料金とOpenAI API利用料金の考え方

Chatbot UI自体はオープンソースなので、基本的に「UIの利用料」は発生しません。

料金が発生するかどうか、どこにコストが乗るかは「クラウドAPIで推論するか」「ローカルLLMで推論するか」で大きく変わります。

料金体系の構成要素

Chatbot UIを業務で使うときは、次の3層で分けて考えると見積もりが崩れにくくなります。

- 推論コスト(モデル側)

クラウドAPIなら従量課金が中心です。ローカルLLMならモデル利用料は不要でも、ハードウェアや運用のコストが別で発生します。

- 運用コスト(環境・保守)

バージョンアップ対応、脆弱性対応、バックアップ、監査ログなど、チーム利用ほど無視しにくくなります。

- 組織コスト(ルール整備)

入力禁止情報、権限管理、持ち出し制限などを定義しないと、コスト以前に使えなくなるケースがあります。

価格例と見積りの作り方

クラウドAPIを使う場合、見積りは「利用量」を先に作るのが現実的です。たとえば、次のように利用シーンから逆算します。

- 想定ユーザー数(部署単位か、全社か)

- 1人あたりの1日あたりの利用回数(質問回数)

- 1回あたりの入力量(資料貼り付けの有無、長文かどうか)

- 1回あたりの出力量(要約なのか、文章生成なのか)

- 長文入力が発生する用途の割合(会議録要約、規程チェックなど)

この利用量が決まると、あとは「モデルごとの単価」に当てはめれば月額の目安が出ます。単価は必ず公式の料金表で確認してください。

ローカルLLMの場合は、API従量課金の代わりに「マシンの購入費や償却」「電力」「運用工数」が主な見積り対象になります。特に、複数人利用や長期運用では、運用工数がボトルネックになりやすい点に注意が必要です。

価格注記

- APIの料金やモデルの提供状況は変わる可能性があるため、本記事では特定の金額を断定しません。必ず公式情報を参照してください。

- 見積りは「平均」だけで作ると外れやすいです。長文入力が集中する用途(RAGの検証、規程レビューなど)がある場合は、別枠で利用量を見積もると現実に近づきます。

読み解き:コストを下げる現実的な打ち手

Chatbot UIでコストを下げるには、モデルを変える前に「使い方」を整える方が効くことが多いです。

- 用途を2〜3類型に分ける

文章校正・要約・アイデア出しなど、用途で期待値を揃えると、必要以上に高価なモデルを使い続けずに済みます。

- テンプレートで入力を短くする

指示が長くなりがちな業務ほど、テンプレート化で入力を圧縮できます。

- 長文貼り付けのルールを作る

長文入力はコストに直結しやすいため、貼り付ける範囲や要約の手順を決めておくとブレが減ります。

モデル選びの考え方を押さえたい場合は、以下の記事も参考になります。

【関連記事】

ChatGPTのモデルとは?OpenAIの最新モデル一覧と特徴をわかりやすく解説【2025年最新版】

AI導入でお悩みの方へ

まとめ:Chatbot UIでローカル運用する要点

本記事では、Chatbot UIを軸に、ローカル環境での生成AI活用を現実的に進めるための考え方と導入手順を整理しました。

記事のポイント

- まずは目的の言い換えから始める

「ChatGPTをローカルにしたい」を、UIだけローカルにするのか、推論までローカルにするのかに分解すると選びやすくなります。

- クラウドAPIは品質と引き換えに外部送信が発生する

ポリシー確認と社内ルール整備が前提になります。

- 完全ローカルは運用設計が必要

ネットワーク分離や機密性の要件が強い場合に有力ですが、モデル更新や運用が課題になります。

どちらを選ぶべきか?

- Chatbot UI + クラウドAPIが向くケース

導入スピードと回答品質を重視し、社内規程の範囲で外部送信が許容できる場合です。

- Chatbot UI + ローカルLLMが向くケース

入力データを外部に出せない要件が強く、運用を自社で設計できる場合です。

最終的に

迷ったら、まずは小さく試して、運用上の課題(入力ルール、コスト、ログ、権限)を洗い出すのがおすすめです。そこから、必要に応じてローカルLLMへ寄せるか、クラウドAPIを使い続けるかを判断すると失敗しにくくなります。