この記事のポイント

AIハルシネーションとは、LLMがもっともらしいが事実に反する情報や根拠のない内容を生成してしまう現象であり、Intrinsic / Extrinsic などの分類で整理できる。

LLMの確率的生成、学習データの量・質・偏り、デコード戦略やプロンプト設計など、モデルの仕組みと運用の双方がハルシネーション発生の要因となる。

医療・法務・金融・検索・社内FAQなど、個人利用から企業利用までさまざまな文脈で誤情報・コンプライアンス違反・ブランド毀損といったリスクが生じうる。

RAG・グラウンディング・ガードレール・ハルシネーション検知モデル・モデル選択/パラメータ調整などを組み合わせることで、技術的にハルシネーションを抑制しやすくなる。

AI利用ガイドラインやHITL、ログ管理・社内教育を通じて、「どこまでAIに任せるか」を明確にしつつ、ハルシネーションを前提にリスクを管理しながら価値を引き出すことが重要である。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

ChatGPTや画像生成AIなどの生成AIは、業務や生活のいたるところに入り込みつつあります。

一方で、「もっともらしいのに事実と違う内容」を自信たっぷりに語ってしまう ハルシネーション の問題も無視できません。

本記事では、AIハルシネーションの定義や Intrinsic / Extrinsic といった分類、なぜ起こるのかという仕組み上の理由から、個人・企業・社会にどのようなリスクをもたらすのかまでを整理します。

さらに、RAG・グラウンディング・ガードレール・ハルシネーション検知モデル・ヒューマンインザループ(HITL)といった技術/運用の両面の対策を紹介し、「ハルシネーション前提」で生成AIの価値を最大化するための考え方を解説します。

目次

ハルシネーションの種類:Intrinsic / Extrinsic

なぜAIはハルシネーションを起こすのか【仕組みから原因を理解】

AIハルシネーション対策と「前提にした使い方」の基本スタンス

【ビジネス利用】「任せてよい業務」と「任せてはいけない業務」

ハルシネーション対策の技術アプローチ【RAG・グラウンディング・ガードレール】

ハルシネーション検知モデルと評価指標(hallucination rate など)

【ユースケース別】ハルシネーションを抑制する生成AI設計パターン

コーディング支援(Copilot系)におけるハルシネーション

AIのハルシネーションとは?

AIのハルシネーションとは、大規模言語モデル(LLM)や生成AIが、もっともらしく見えるが事実に反する情報や根拠のない内容を生成してしまう現象を指します。

ここでいう生成AIには、次のようなシステムが含まれます。

- テキスト生成系(ChatGPTなどのチャットボット)

- コード生成系(GitHub Copilot など)

- 画像・動画生成系(Sora などのマルチモーダルモデル)

例えば、ChatGPTに「存在しない論文」を聞いたときに、それらしいタイトル・著者名・ジャーナル名まででっち上げてしまうことがあります。このような、「自信満々に語っているが、現実には存在しない情報」が典型的なハルシネーションです。

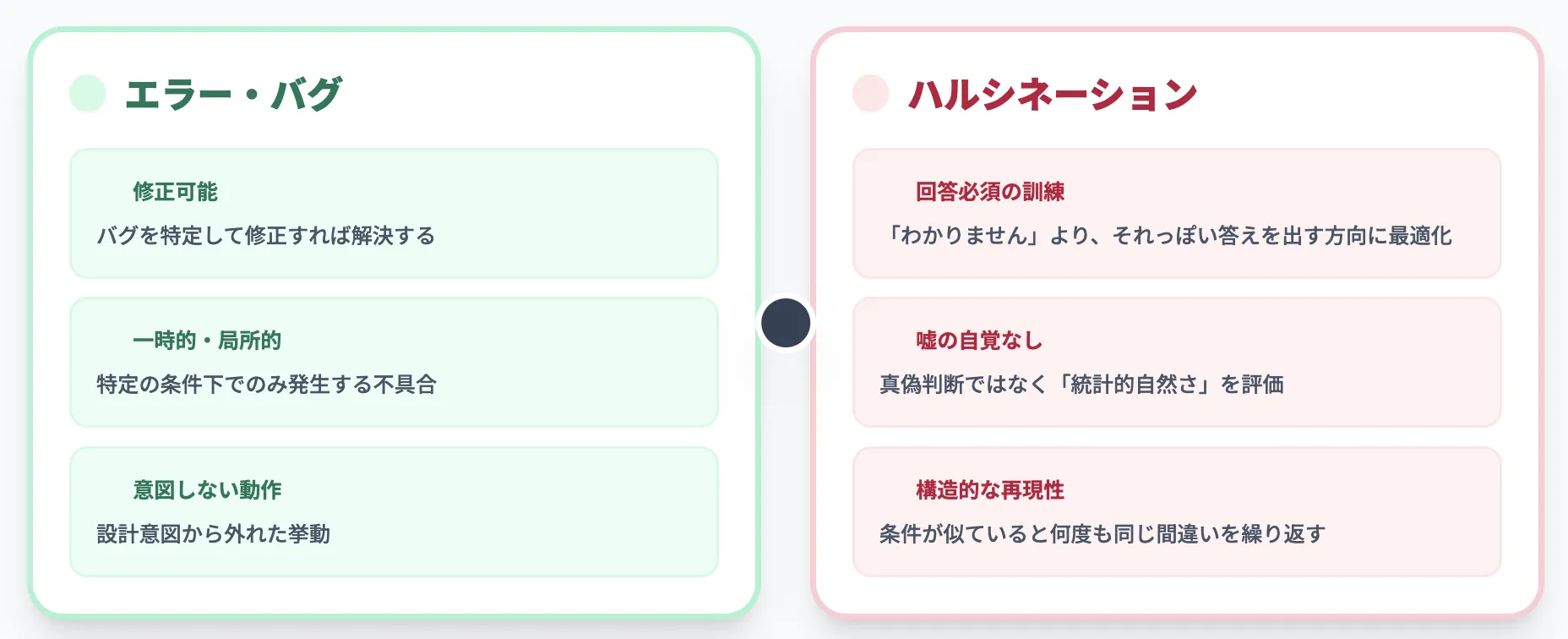

ハルシネーションと単純な「エラー」「バグ」の違い

ハルシネーションは、単なる「バグ」や「一時的なエラー」とは性質が異なります。ポイントは次のとおりです。

-

多くの汎用LLMは、何かしらの回答を返すように訓練されている

LLMは「次に出てきそうな単語の確率」を学習しており、「わかりません」と沈黙するよりも、「それっぽい答え」を出す方向に最適化されているケースが一般的です。

(一方で、最近は「わからない」と答えやすくする研究・調整も進んでいます)

-

内部的には“嘘をついている”自覚がない

モデルは事実かどうかを判断しているのではなく、「文として自然かどうか」「学習データ的に最もありそうか」を評価しているだけです。

-

再度聞いても同じ間違いを繰り返すことがある

バグであれば修正すれば収まりますが、ハルシネーションは学習や推論の仕組みに根ざした「構造的な挙動」のため、プロンプトや条件が似ていると何度も再現されます。

このように、ハルシネーションは**“壊れている”のではなく、“そういうふるまいをするように設計されている”側面が強い**点が重要です。

ハルシネーションの種類:Intrinsic / Extrinsic

近年の研究では、ハルシネーションをいくつかの観点から分類する試みが進んでいます。その代表的なものが、「Intrinsic(内的)」と「Extrinsic(外的)」の分類です。

-

Intrinsic ハルシネーション

- 入力や手元の情報とは整合しているつもりでも、推論や要約の過程で論理的に誤ってしまうタイプ

- 例:元の文章に「売上は前年同期比で5%増」とあるのに、「10%増」と誤った要約を生成する

-

Extrinsic ハルシネーション

- 入力や参照情報にまったく存在しない事実を作り出すタイプ

- 例:社内ナレッジに存在しない製品名・部署名・法律名などを自信満々に回答する

さらに、次のような軸で分類することもあります。

- 入力と矛盾するか(conflicting)/無関係か(irrelevant)

- 数値・日付・固有名詞の誤りか/因果関係・論理構造の誤りか

こうした分類は、ハルシネーションを「ただの変な回答」ではなく、原因別に対策を考えるためのフレームワークとして利用されます。

なぜAIはハルシネーションを起こすのか【仕組みから原因を理解】

次に、なぜ生成AIがハルシネーションを起こしてしまうのか、その「仕組み上の原因」を整理します。

ここを理解しておくと、「完全にゼロにはできないが、どこまで抑えられるか」を現実的に判断しやすくなります。

LLMの仕組みと「確率的生成」からくる限界

大規模言語モデル(LLM (Large Language Model))は、インターネット上の大量のテキストやコードを学習し、次に出てくる単語(トークン)の確率分布を学習しています。

ざっくり言うと、モデルは次のように動作します。

- 入力文をトークンに分解して数値ベクトルに変換する

- トランスフォーマーと呼ばれるニューラルネットワークで処理する

- 「次のトークン」の確率分布を出力する

- 確率の高いトークンを少しランダムに選んで文章を伸ばしていく

ここで重要なのは、モデルは「これは事実か?」ではなく「この文脈では何という言葉が出てきそうか?」を学習している点です。

そのため、以下のような状況でハルシネーションが起こりやすくなります。

- 学習したことがない話題を聞かれたとき

- あいまいな質問で、複数の解釈がありうるとき

- 「自信がないときは黙る」のではなく、「とりあえずそれっぽい答えを出す」設計になっているとき

人間で言えば、「知らないけど、なんとなくこんな感じかな」とそれっぽいことを言ってしまうイメージに近いです。

学習データの量・質・偏りが与える影響

LLMを含む自然言語処理(NLP: Natural Language Processing)モデルのふるまいは、ほぼすべてが「どのようなデータで学習されたか」に依存します。データに問題があれば、ハルシネーションのリスクも必然的に高まります。

代表的な要因として、次のようなものがあります。

-

データが不足している領域

マイナーな分野・最新のトレンド・ニッチな専門領域は、学習データが少なくなりがちです。

この場合、モデルは「似ている別の話題」を当てはめてしまい、現実とは違う情報を生成しやすくなります。

-

ノイズや誤情報を多く含むデータ

インターネット上には、正確な情報だけでなく誤情報や噂話も大量にあります。

それらも学習しているため、「本物っぽい誤情報」を再生産してしまうことがあります。

-

データの偏り(バイアス)

特定の国・文化・業界・思想に偏ったデータを多く学習すると、それ以外の文脈では不自然な結論や偏った内容をアウトプットしてしまいます。

モデルアーキテクチャ・デコード戦略とハルシネーション

同じ学習データを使っていても、**どのようにトークンを選ぶか(デコード戦略)**によってハルシネーションの出やすさは変わります。

代表的なパラメータとして、次のようなものがあります。

-

温度 (temperature)

0 に近づけると「最も確率が高いトークン」を選びやすくなり、保守的で安定した出力になります。

高くするとランダム性が増し、創造性が高まる一方で、事実から逸れるリスクも上がります。

-

top-k / top-p サンプリング

候補に含めるトークンの範囲をどこまで広げるかを決める指標です。

範囲を広げるほど、多様な表現が出やすくなりますが、誤った方向に飛ぶ可能性も高まります。

こうしたデコード設定はハルシネーションの「出やすさ」に影響しうる一方で、温度を下げるなどのパラメータ調整だけで完全に防げるわけではなく、設定を変えても誤った出力が残るケースも多いことが報告されています。

また、モデルのサイズやアーキテクチャ(層の深さ・注意機構の設計など)によっても、「筋の通った嘘」をつく能力が高くなることが知られています。

モデルが大きくなるほど文脈整合性は高まりやすい一方で、誤りが出たときも文章として非常に自然になり、結果として人間がハルシネーションを見抜きにくくなる、というトレードオフがあります。

プロンプト設計・コンテキスト設計が原因になるケース

ハルシネーションは、モデル側の問題だけでなく、「人間側の使い方」に起因することも多くあります。

例えば、次のようなケースです。

- 質問があいまいで、前提条件が不足している

- 長大なコンテキストをそのまま投げ、どこを見て答えればよいか明示していない

- 「絶対に〇〇だと断定して」など、過度な自信を要求する指示を出している

こうした場合、モデルは「何をゴールとすべきか」が分からず、曖昧な前提のまま、もっともらしい物語を構築してしまいます。

業務で使う場合は、少なくとも次のような観点でプロンプトを見直すとハルシネーションを減らしやすくなります。

- 質問のスコープ(対象期間・対象システム・対象ユーザーなど)を明示する

- 必要な前提条件や制約条件を書き下す

- 「わからない場合はわからないと答える」と明示する

マルチモーダル(画像・動画)におけるハルシネーション

近年は、テキストだけでなく画像・動画・音声を扱うマルチモーダルモデルも一般的になりました。このときのハルシネーションは、映像や画像の内容と食い違うテキスト説明や、物理的にありえない動きの動画として現れます。

代表例として、OpenAIの動画生成モデル Sora が挙げられます。

一見するとリアルな映像でも、

- 物体が突然消える・増える

- 手足の関節があり得ない方向に曲がる

- 重力や水の動きが現実と合わない

といった「映像的ハルシネーション」が含まれることがあります。

テキストのハルシネーションと同様に、「ぱっと見の自然さ」と「物理法則や世界知識との整合性」は別問題である点に注意が必要です。

ハルシネーションがもたらすリスクと社会的インパクト

ハルシネーションは「ちょっと間違った回答」程度に見えることもありますが、文脈次第では重大なトラブルにつながります。

ここでは、個人・企業・社会それぞれの観点からリスクを整理します。

個人利用で起こりうる誤情報・判断ミス

個人利用のシナリオでも、ハルシネーションが直接的な不利益をもたらす場面は少なくありません。

- 健康・医療相談

- 症状から推測される病名を「それっぽく」答えてしまう

- 実在しない薬の名前や、誤った服用方法を提示してしまう

<br?

-

投資・資産運用

- 架空の銘柄や間違った財務指標を提示してしまう

- 過去のチャートや業績を誤った形で「要約」してしまう

-

法律・行政手続き

- 存在しない判例や条文を引用してしまう

- すでに改正された古い規定を最新のように説明してしまう

こうした誤情報は、「AIが言っていたから」とそのまま実行してしまうと、健康被害・金銭的損失・法的トラブルにつながるおそれがあります。

企業利用での法的リスク・ブランド毀損

企業で生成AIを活用する場合、ハルシネーションはより広範なリスクになります。

代表的なものを整理すると、次のとおりです。

-

名誉毀損・プライバシー侵害

- 実在の人物に関する誤った噂や犯罪歴を生成してしまう

- 個人情報と誤って結び付けた内容を回答してしまう

-

著作権侵害

- 学習データに含まれる特定の表現をほぼそのまま出力してしまう

- 他社のマニュアル・規約文を、あたかも自社のもののように提示してしまう

-

コンプライアンス違反・レピュテーションリスク

- 規制に抵触するようなアドバイスを自動で行ってしまう

- 差別的・攻撃的な表現を含んだ回答を生成してしまう

これらは、単に「回答が間違っていた」で済まないケースも多く、訴訟・行政指導・炎上といった形で企業の信頼を大きく損ねるリスクがあります。

生成AIのリスク全般については、こちらの記事も参考になります。

ChatGPTの問題点とは?その危険性や社会に与える影響を解説

実際に報じられたハルシネーション事例(国内外)

ハルシネーションは、すでにニュースや論文で多数の事例が報告されています。ここでは代表的なパターンを、簡単に表で整理します。

| 区分 | 業種・文脈 | 発生した問題の例 | 影響 |

|---|---|---|---|

| 法律 | 裁判所への提出書類 | 実在しない判例を引用した書面を弁護士が提出 | 信頼失墜、制裁対象となる可能性 |

| 検索 | 検索エンジンのAI回答 | 健康情報や生活の知恵について、誤ったアドバイスを提示 | 誤解・健康被害のリスク |

| 金融 | 投資アドバイザリ | 銘柄情報や財務指標を誤って要約 | 投資判断の誤り・損失リスク |

| 企業内 | 社内FAQボット | 社内規程に存在しないルールを「公式」のように回答 | 社内混乱・誤った業務運用 |

こうした事例から分かるのは、「AIがハルシネーションを起こすこと」自体よりも、「人間がそれをどの程度検証せずに信じてしまうか」がリスクの大きさを決めているという点です。

AIハルシネーション対策と「前提にした使い方」の基本スタンス

ハルシネーションはゼロにはできません。重要なのは、「どうすればハルシネーションが起こらないか」だけでなく、「ハルシネーションが起こる前提で、どこまでAIに任せるか」を設計することです。

【個人利用】まず押さえるべき基本ルール

個人で生成AIを使う場合、次のようなシンプルなルールを意識すると、ハルシネーションによるリスクを大きく減らせます。

-

重要な判断をAIだけに任せない

健康・お金・法的トラブルなど、人生への影響が大きい分野では、必ず人間の専門家の意見を確認します。

-

複数の情報源でクロスチェックする

AIの回答をきっかけに、公式サイトや公的機関の情報で裏を取る習慣をつけます。

-

「それっぽさ」と「本当らしさ」を分けて考える

日本語として流暢であっても、その内容が事実に基づいているとは限りません。「読みやすさ」と「正しさ」を混同しないようにします。

【ビジネス利用】「任せてよい業務」と「任せてはいけない業務」

企業でAIを導入する際は、業務ごとに「どこまでAIに任せるか」の線引きを明確にする必要があります。簡易なマトリクスで考えると分かりやすくなります。

-

影響度が低く、やり直しが容易な業務

- 例:ブレスト用アイデア出し、社内向けドラフト文書、資料のたたき台

→ AIに大きく任せても良い領域です。

- 例:ブレスト用アイデア出し、社内向けドラフト文書、資料のたたき台

-

影響度が高いが、必ず人間レビューを通す業務

- 例:社外向け重要資料、契約書の草案、役員向けレポート

→ AIはあくまで補助であり、最終判断は人間が行うべき領域です。

- 例:社外向け重要資料、契約書の草案、役員向けレポート

-

そもそもAIに任せるべきではない業務

- 例:最終的な投資判断、医療や法的アドバイスの「確定判断」、機密情報を含むクリティカルな意思決定

→ 資料整理や情報探索まではAIを使いつつ、決定そのものは別レイヤーで行う設計が安全です。

- 例:最終的な投資判断、医療や法的アドバイスの「確定判断」、機密情報を含むクリティカルな意思決定

こうした線引きは、社内のAI利用ガイドラインやポリシーに明文化しておくことが望まれます(後述)。

ヒューマン・イン・ザ・ループ(HITL)の設計

HITL (Human In The Loop) とは、「人間をAIのプロセスに組み込んで、最終判断やレビューを行う設計」のことです。

ハルシネーション対策としては、次のような観点が重要です。

-

どのタイミングで人間が介入するか

- 入力時(プロンプト設計・データの準備)

- 中間生成物のレビュー

- 最終アウトプットの承認

-

何をチェックするか

- 事実関係(数字・固有名詞・日付など)

- ロジック・因果関係

- トーン・表現(差別・誹謗中傷・極端な表現など)

-

どの条件でレビューを省略しても良いか

- 社内限定・低リスク・テンプレート化された用途など、「自動利用を許可する領域」を明確にしておく

HITLは単なる「人間によるダブルチェック」ではなく、業務フローとして組み込まれたプロセスとして設計することがポイントです。

ハルシネーション対策の技術アプローチ【RAG・グラウンディング・ガードレール】

ここからは、技術的にハルシネーションを抑える代表的なアプローチを整理します。キーワードとしてよく登場するのが「RAG」「グラウンディング」「ガードレール」「ハルシネーション検知モデル」です。

RAG

RAG (Retrieval-Augmented Generation) は、LLMが回答を生成する前に、検索エンジンやベクトルデータベースから関連ドキュメントを取得し、その内容を参照しながら回答を生成する手法です。

- 通常のLLM:パラメータ内部にある「記憶」だけで回答する

- RAG構成:外部のナレッジベースやWeb検索結果を見てから回答する

RAGのメリットは、次のような点です。

- モデルが学習していない最新情報や社内専用情報を扱える

- 回答の根拠となるドキュメントを一緒に提示しやすい

- 「パラメータを書き換えなくても」知識を差し替えられる

一方で、近年の研究では、「++RAGだから安全というわけではない**」ことも明らかになっています。たとえば、取得したドキュメントが間違っていたり、モデルがうまく根拠を参照できなかったりすると、RAG構成でもハルシネーションが発生します。

さらに、関連文書がコンテキストに渡されていても、モデル側がそれを無視してパラメトリックな「思い込み」を優先し、根拠と矛盾する回答を返してしまう、といったパターンも報告されています。

【関連記事】

LLMや生成AIのRAGとは?その概要や活用例をわかりやすく解説

グラウンディング

グラウンディング (grounding) は、AIが生成する回答を、特定のデータソース(検索結果、企業データ、公式文書など)に「根拠づける」考え方です。

RAGと似た概念ですが、より広く次のような設計を含みます。

- 検索エンジンや社内検索との連携

- データベースやAPIからのリアルタイム取得

- 「この回答はこの文書のこの部分に基づく」といった根拠の提示

ポイントは、ユーザーが「なぜその回答になったのか」を追跡できるようにすることです。

これにより、ユーザー側で事実確認・再検証がしやすくなり、ハルシネーションが混入していても早期に検知できます。

ガードレール・ポリシーエンジン・コンテンツフィルタ

ガードレール (guardrails) は、LLMの入出力に対してルールや制約を適用し、危険な内容やポリシー違反の出力をブロック・修正する仕組みです。

ガードレールは、大きく次の2箇所に挿入できます。

-

入力側ガードレール

- 明らかに違法・危険・不適切なリクエストを検知してブロックする

- 機密情報の入力を防ぐ(例:個人情報・顧客データなど)

-

出力側ガードレール

- 有害表現・差別的表現・センシティブな内容をフィルタリングする

- 禁止トピックやブランドポリシーに反する回答をブロックする

ガードレール向けの専用ツールやAPIも増えており、LLM本体+ガードレール+RAG/グラウンディングの組み合わせで安全性を高めるのが、2025年時点の主流パターンです。

ハルシネーション検知モデルと評価指標(hallucination rate など)

近年は、ハルシネーションを自動的に検知・評価する専用モデルも登場しています。

代表例として、要約タスクに対するハルシネーション率を測る評価モデルや、各LLMの「事実忠実性」をランキングするリーダーボードなどが公開されています。

代表的な指標には、次のようなものがあります。

- Hallucination Rate(ハルシネーション率)

- 出力トークンのうち、根拠となる文書に存在しない内容の割合

- 出力トークンのうち、根拠となる文書に存在しない内容の割合

- Faithfulness / Factuality スコア

- 原文や根拠文書に対して、どれだけ忠実・正確かを評価する指標

- 原文や根拠文書に対して、どれだけ忠実・正確かを評価する指標

- Consistency / Contradiction スコア

- 入力情報と矛盾していないかを測る指標

これらの指標を使うことで、

- モデル同士の比較(どのモデルがハルシネーションしにくいか)

- 自社プロンプト・RAG構成の改善前後の効果測定

が可能になります。

モデル選択・パラメータ(温度など)による抑制

最後に、より実務的な観点として、モデル選択とパラメータ設定もハルシネーション対策に直結します。

-

モデル選択

- 「創造性重視モデル」よりも「正確性重視モデル」を選ぶ

- 推論専用モデルや、事実重視にチューニングされたモデルを使う

-

パラメータ調整

- 温度 (temperature)を低めに設定し、ランダム性を抑える

- top-p / top-k の値を調整し、「飛びすぎた候補」が選ばれにくいようにする

ただし、パラメータを絞り過ぎると、**「ハルシネーションは減ったが、回答が硬くて使いづらい」**といったトレードオフが生じます。

実務では、「重要度の高い業務フローでは保守的な設定」「アイデア出し用途では少し創造性を上げる」など、ユースケースごとに設定を変えるのが現実的です。

組織で取り組むべきAI利用ガイドラインと運用設計

技術的な対策に加え、組織としてのルールや運用設計もハルシネーション対策の重要な柱になります。ここでは、企業がまず検討すべきポイントを整理します。

AI利用ポリシー・ガイドラインに盛り込むべき項目

企業向けのAI利用ポリシーでは、最低限次のような観点を明文化しておくとよいでしょう。

-

利用目的・適用範囲

- どの業務で生成AIを使ってよいか/使ってはいけないか

- テスト利用・PoCと本番運用でルールを分けるかどうか

-

機密情報・個人情報の取り扱い

- 外部サービスに入力してよい情報/してはならない情報

- 社内専用のクローズド環境を使う必要がある業務

-

レビュー・承認プロセス

- どの種類のアウトプットは、必ず人間の承認が必要か

- レビュー観点(事実・ロジック・トーンなど)

-

責任の所在

- 最終的な責任はAIではなく人間(組織)が負うことを明示

- トラブル発生時のエスカレーションフロー

社内教育・トレーニングのポイント

ガイドラインを作るだけでは不十分で、現場メンバーが「どのようにハルシネーションを見抜き、扱うか」を理解しているかが重要です。

教育では、次のような内容をカバーすると効果的です。

- ハルシネーションの具体例(自社のデモを含める)

- 「信じてはいけない使い方」のパターン

- 事実確認の方法(公式サイト・社内ナレッジなど)

- 社内での相談先・エスカレーション先

単なる座学だけでなく、実際にAIにわざと誤回答をさせ、それを見抜く演習を行うと、ハルシネーションの感覚値が掴みやすくなります。

ログ・監査・モニタリングによる継続的なリスク管理

本格的にAIを業務に組み込む場合、ログ管理・監査・モニタリングも重要な要素になります。

- どのユーザーが、いつ、どのプロンプトで利用したか

- どのような回答が返ってきたか

- 後から問題が発覚した場合に、どのセッションが原因だったか

これらを追跡できるようにしておくことで、インシデント対応・再発防止策の検討・モデルやプロンプトの改善が進めやすくなります。

エンタープライズ向けのAIプラットフォーム構築全般については、次の記事で整理しています。

【ユースケース別】ハルシネーションを抑制する生成AI設計パターン

ここからは、具体的なユースケースごとに「現実的な落としどころ」を確認していきます。

自社の利用シーンに近いパターンをイメージしながら読むと整理しやすくなります。

FAQチャットボット/社内ヘルプデスク

社内・社外向けのFAQボットは、RAGやグラウンディングを組み合わせやすい代表的なユースケースです。

- 社内規程・マニュアル・ナレッジベースを検索対象にする

- 回答と一緒に、参照した文書のタイトルやURLを提示する

- RAGでヒットしない場合は、「わからない」と明示させる

このときの注意点は、次のとおりです。

- ナレッジベース自体の更新を怠ると、「古いがもっともらしい回答」が返ってくる

- 社内用語や略語に対応するための前処理(エイリアス設定)が必要

- 権限管理を誤ると、閲覧権限のない情報を回答してしまうリスクがある

これらをあらかじめ設計に組み込んでおくことで、「いつ・どの情報を根拠に答えているか」が追跡しやすいFAQボットになり、ハルシネーションが起きても早期に検知・修正しやすくなります。

文書要約・議事録生成

会議議事録や長文レポートの要約は、AIとの相性が良い一方で、「原文にない内容を勝手に付け足す」ハルシネーションが問題になりがちです。

対策としては、次のような設計が有効です。

-

必ず原文(音声書き起こし・資料)を添付して要約させる

- 「このテキストの内容だけに基づいて要約して」と明示する

- 「このテキストの内容だけに基づいて要約して」と明示する

-

要約の種類を指定する

- 決定事項・TODO・懸念点など、観点別に要約させる

- 「推測や補完は行わない」とプロンプトに含める

-

要約結果を人間がすばやくレビューしやすいようにする

- 箇条書き・セクション構造を統一しておく

要約タスクでは、「AIに任せるのは情報の圧縮まで」「意味づけや最終判断は人間が行う」という役割分担を徹底することで、ハルシネーションのリスクを抑えつつ、大量のテキスト処理を効率化できます。

コーディング支援(Copilot系)におけるハルシネーション

コード生成系ツールでは、次のようなハルシネーションが起こり得ます。

- 存在しないAPIや関数名を提案する

- セキュリティ上好ましくない実装を提示する

- 仕様や要件と食い違うコードを生成する

ここでの原則はシンプルで、「生成されたコードは必ずテストを書く/既存のテストを通す」「レビューを省略しない」という点に尽きます。

- ユニットテスト・統合テストを自動生成させ、そのテストもレビューする

- 既存コードベースの規約やアーキテクチャを、可能な限りプロンプトやエージェント設定に反映する

こうした前提をチームで共有しておけば、Copilot系ツールは「コードを書く作業を大幅に自動化するアシスタント」として活躍しつつ、品質保証やセキュリティの責任は開発チーム側にしっかり残す設計にできます。

企画書・マーケティング文書の草案作成

企画書やマーケティングコピーの草案では、事実とクリエイティブな表現が混ざり合います。このときは、次のように役割を分けると安全です。

-

事実ベースの部分(数値・実績・機能)

- 社内データや公式資料をもとに人間が確認

- AIには「テキスト整形」や「読みやすい構成提案」を任せる

-

ストーリー・メッセージ部分

- アイデア出しやトーン調整をAIに任せる

- 誇張表現や誤解を招く表現がないかを人間がチェックする

こうすることで、「クリエイティブはAI」「ファクトは人間」という分業がしやすくなります。

これからのハルシネーション研究とモデル動向【2026年に向けた展望】

最後に、研究コミュニティとモデル開発の両面から、ハルシネーションをめぐる最新動向と今後の方向性を簡単に整理します。

研究コミュニティでの最新サーベイ・ベンチマーク動向

2023〜2025年にかけて、ハルシネーションに関するサーベイ論文やベンチマークが相次いで公開されています。これらは主に次のようなテーマを扱っています。

- ハルシネーションの分類(Intrinsic / Extrinsic、入力と矛盾するかどうか など)

- 評価ベンチマーク・データセット(要約・QA・コードなどタスク別)

- 緩和手法(RAG、自己検証、編集ベースの修正など)

併せて、評価用のベンチマーク・指標も多数提案されています。代表例としては以下のようなものがあります。

- HaluEval:QA や対話など複数タスクにまたがる大規模ハルシネーション評価データセット。:contentReference[oaicite:4]{index=4}

- DiaHalu:対話レベルでの factuality / faithfulness の両方を評価するベンチマーク。:contentReference[oaicite:5]{index=5}

- FaithJudge / Faithfulness in RAG ベンチマーク:RAG 構成における「根拠への忠実度」を測るためのリーダーボードと評価フレームワーク。:contentReference[oaicite:6]{index=6}

さらに、factuality に特化したサーベイとして、LLM の事実性評価・ハルシネーション検出手法をまとめた “Survey on Factuality in Large Language Models” なども提案されており、ハルシネーション問題を「事実性(factuality)」の観点から捉え直す流れも強まっています。

こうしたサーベイやベンチマークの整備により、各社・各モデル間の比較がやりやすくなり、「どのモデルが、どのタスクで、どれくらいハルシネーションしやすいか」を定量的に議論できる土台が整いつつあります。

検知モデル・ガードレール技術の発展

ハルシネーション検知モデルやガードレール技術も、2025年時点で大きく進化しています。

- 専用の検知モデルによる自動スコアリング

- RAG構成と組み合わせた「根拠ベースの検証」

- ベンダー各社によるガードレール機能の標準搭載

今後は、「LLM本体+検知モデル+ガードレール+RAG/グラウンディング」をパッケージとして扱うプラットフォーム**が増えていくと考えられます。

モデル側の改善(推論モデル・自己検証・不確実性の表現)

モデル本体の側でも、次のような方向での改善が進んでいます。

-

自己検証・自己反省(self-check/self-reflection)

- 一度生成した回答を、別のプロセスで検証・言い換え・修正する

- 一度生成した回答を、別のプロセスで検証・言い換え・修正する

-

不確実性の表現

- 「わからないときにわからないと言う」ためのしきい値や評価関数の設計

- 回答と一緒に「自信度」や「前提条件」を提示する試み

-

タスク特化モデルとの役割分担

- 一般的なLLMの上に、特定ドメイン向けの検証モジュールを重ねる構成

AI導入でお悩みの方へ

まとめ:ハルシネーションと付き合いながらAIの価値を引き出す

生成AIは、便利さと引き換えに「もっともらしい誤情報を生む」という性質を本質的に抱えています。ハルシネーションはバグではなく、LLMの仕組みや学習データ、人間側の使い方が重なって生じる挙動だ、という前提を持って付き合う必要があります。

本記事のポイントをコンパクトに整理すると、次のようになります。

- 本質:生成AIがもっともらしいが事実と異なる内容を生成してしまう「仕様的な性質」

- 要因:確率的生成、学習データの量・質・偏り、モデル設計、デコード戦略、プロンプト設計

- リスク:個人の誤判断から、企業の法的リスク・コンプライアンス違反・ブランド毀損まで広く波及しうること

- 技術的対策:RAG、グラウンディング、ガードレール、ハルシネーション検知モデル、モデル/パラメータ選択の組み合わせ

- 運用面の鍵:AI利用ガイドライン、HITL、ログ管理・社内教育によるガバナンス設計

ハルシネーションを前提にしつつ、「AIに任せる部分」と「人間が責任を持つ部分」の境界を設計できれば、リスクをコントロールしながら生成AIのメリットだけを最大限に引き出していくことができます。