この記事のポイント

ChatGPTには学習データや入力情報の漏洩、サイバー攻撃によるデータ窃取などのリスクがある

実際に、バグによるユーザー情報の閲覧や、ダークウェブでのアカウント情報流出などの事例が発生

リスク対策として、機密情報の入力回避、オプトアウト設定、組織内ガイドラインの制定が有効

OpenAIは情報保護に努めているが、ユーザー自身も適切な対策を講じる必要がある

法人向けプラン(Enterprise, Teams)の利用で、より高度なセキュリティ機能を活用可能

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AI技術の進化に伴い、ChatGPTをはじめとする言語モデルの利用が急速に拡大しています。

しかし、その便利さの裏で情報漏洩のリスクが高まっていることをご存知でしょうか。

ユーザーが入力した機密情報がどのように処理され、保存されるのか。そして、それらの情報が意図せず流出してしまう可能性について理解することは、安全なChatGPTの利用において非常に重要です。

この記事では、ChatGPTの情報漏洩リスクに焦点を当て、その原因や具体的なリスクの種類、そして対策方法について詳しく解説します。

OpenAIの情報保護方針や、実際に発生した漏洩事例についても触れながら、ユーザーと運営側それぞれに求められる安全対策を提示します。

ChatGPTを安心して利用するためにぜひ最後までお読みいただき、日々の業務やタスクに役立ててください。

ChatGPTの新料金プラン「ChatGPT Go」については、以下の記事をご覧ください。

ChatGPT Goとは?料金や機能、広告の仕様、Plus版との違いを解説

ChatGPTの情報漏洩リスクとは

ChatGPTの使用には、いくつかの情報漏洩リスクが伴います。

- 学習データに含まれる機密情報が、応答に反映されてしまう可能性

- ユーザーが入力した機密情報が、システム内で保存され、漏洩するリスクが

- ChatGPTのデータベースがサイバー攻撃を受け、ユーザー情報や会話履歴が窃取される可能性

これらのリスクは、ChatGPTの設計と運用の仕組みに起因しています。

ChatGPTを提供するOpenAI社は、ユーザーのプライバシーとデータの保護に努めていますが、同時に、サービス改善のためにユーザーデータを利用する可能性があることも明記しています。

そのため、ChatGPTのユーザーは自身の責任において情報漏洩のリスクを理解し、適切な対策を講じる必要があります。特に、機密情報や個人情報を扱う場合には、細心の注意が求められます。

ChatGPTの情報漏洩事例

ここでは、ChatGPTの利用に伴って発生した情報漏洩事例を紹介します。

これらの事例は、ChatGPTのセキュリティ上の課題と、適切な利用方法の重要性を示唆しています。

### ChatGPTのバグによる情報漏洩事例

2023年3月20日、ChatGPTを提供するOpenAIは、オープンソースライブラリのバグにより、一部のユーザーが、他のアクティブユーザーのチャット履歴のタイトルを閲覧できる状態になったことを公表しました。

また、同時期にアクティブだったユーザー間で、新しく作成された会話の最初のメッセージが他のユーザーのチャット履歴に表示される可能性もありました。

さらに、OpenAIは、同じバグにより、ChatGPT Plusの1.2%のユーザーの支払い関連情報が意図せず他のユーザーに閲覧された可能性があることも発見しました。

この情報には、ユーザーの姓名、メールアドレス、支払い先住所、クレジットカードの種類と下4桁、有効期限が含まれていました。

参考:OpenAI

ダークウェブにおける10万件以上のChatGPTアカウント情報流出

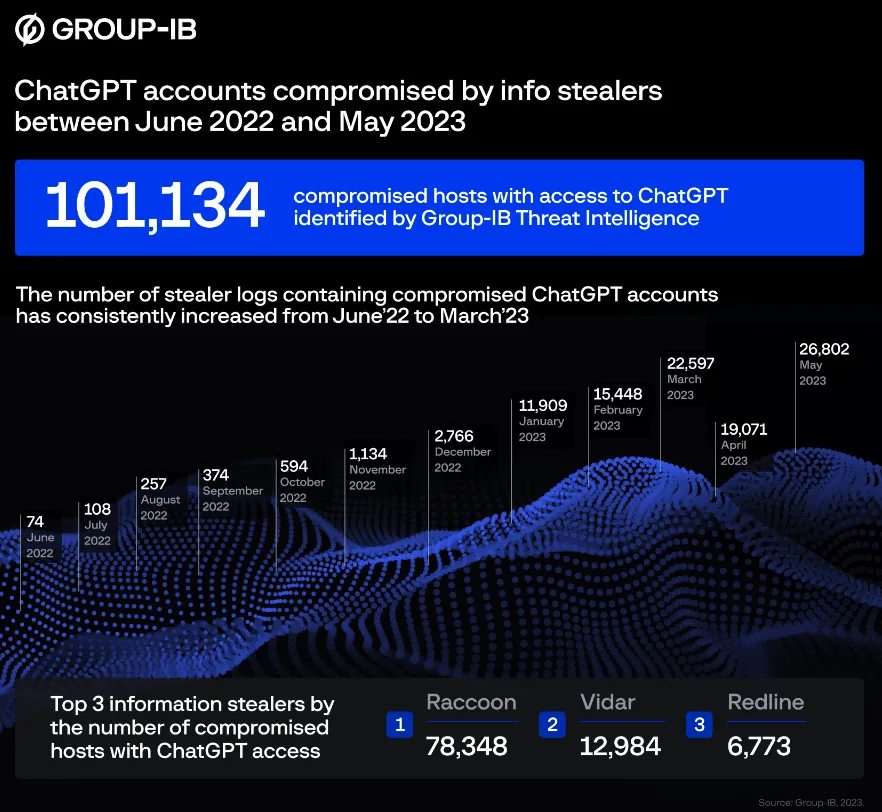

サイバーセキュリティ企業のGroup-IBは、ダークウェブ上で取引されている情報窃取マルウェアのログから、10万件以上の流出したChatGPTアカウント情報を発見しました。

これらの情報は、主にRaccoonというマルウェアによって収集されたものでした。

地域別では、アジア太平洋地域が過去1年間で最も多くのChatGPTアカウント情報が流出していた地域であることが判明しました。

流出したアカウント情報には、機密情報や企業の知的財産が含まれている可能性があり、これらの情報が悪用された場合、企業や個人に大きな被害をもたらす可能性があります。

Group-IBが発表した、「ChatGPTの情報漏洩レポート」 (参考:Group-IB

Samsung、社内情報漏洩を受けChatGPTの利用禁止

2023年5月、SamsungはChatGPTやその他のチャットボットの社員による利用を禁止しました。この決定は、「エンジニアがうっかりChatGPTに機密の社内ソースコードをアップロードしてしまったこと」がきっかけでした。

Samsungは、ChatGPTなどのAIチャットボットに共有されたデータが、OpenAIやMicrosoft、Googleなどのサービス運営会社のサーバーに保存され、簡単にアクセスして削除できないことを懸念しています。

また、ChatGPTに共有された機密データが他のユーザーに提供される可能性もあると考えています。

これらの事例は、ChatGPTをはじめとするAIチャットボットの利用に伴う情報漏洩のリスクを浮き彫りにしています。企業や個人は、これらのツールを利用する際には、機密情報の取り扱いに十分注意し、適切なセキュリティ対策を講じる必要があります。

参考:Samsung Bans ChatGPT Among Employees After Sensitive Code Leak(Forbes)

ChatGPTの情報漏洩リスクへの対策

ChatGPTを安全に利用するには、以下のような対策が重要です。

- 機密情報やプライバシーに関する情報を入力しない

- オプトアウト申請をする*

- 社内・組織内でガイドラインを制定する

- 法人向けプラン(ChatGPT Enterprise,ChatGPT Teams)の利用

機密情報やプライバシーに関する情報を入力しない

情報漏洩のリスクを最小限に抑えるための最も確実な方法は、機密情報やプライバシーに関する情報をChatGPTに入力しないことです。ChatGPTは利便性が高いツールですが、入力する情報の取り扱いには十分な注意が必要です。

企業や組織においては、ChatGPTの利用に関するガイドラインを策定し、従業員に対して機密情報の入力を禁止するなどの措置を講じることが推奨されます。また、個人利用においても、住所や電話番号、クレジットカード情報などの個人情報をChatGPTに入力することは避けるべきです。

ユーザーは、ChatGPTに入力する情報の性質を見極め、機密性の高い情報については、別の手段で伝達することを検討する必要があります。

例えば、企業の財務情報や顧客データ、個人の医療情報などは、ChatGPTではなく、セキュリティの高い専用のシステムで扱うべきでしょう。

【関連記事】

➡️ChatGPTに自社データを学習させる方法!セキュリティ面や活用例も解説

オプトアウト・履歴オフ設定を行う

OpenAI社は、ユーザーの入力内容を、ChatGPTのモデル改善のために使用する場合があると述べています。これを避けるためには、オプトアウト申請を行うことが有効です。

オプトアウトとは、自己に関する情報の利用や提供に対して、同意しない意思を示すことを指します。

OpenAI社の場合、オプトアウト申請を行うことで、ユーザーがChatGPTに入力したデータがモデルの学習に使用されないようにリクエストできます。

オプトアウトの手順

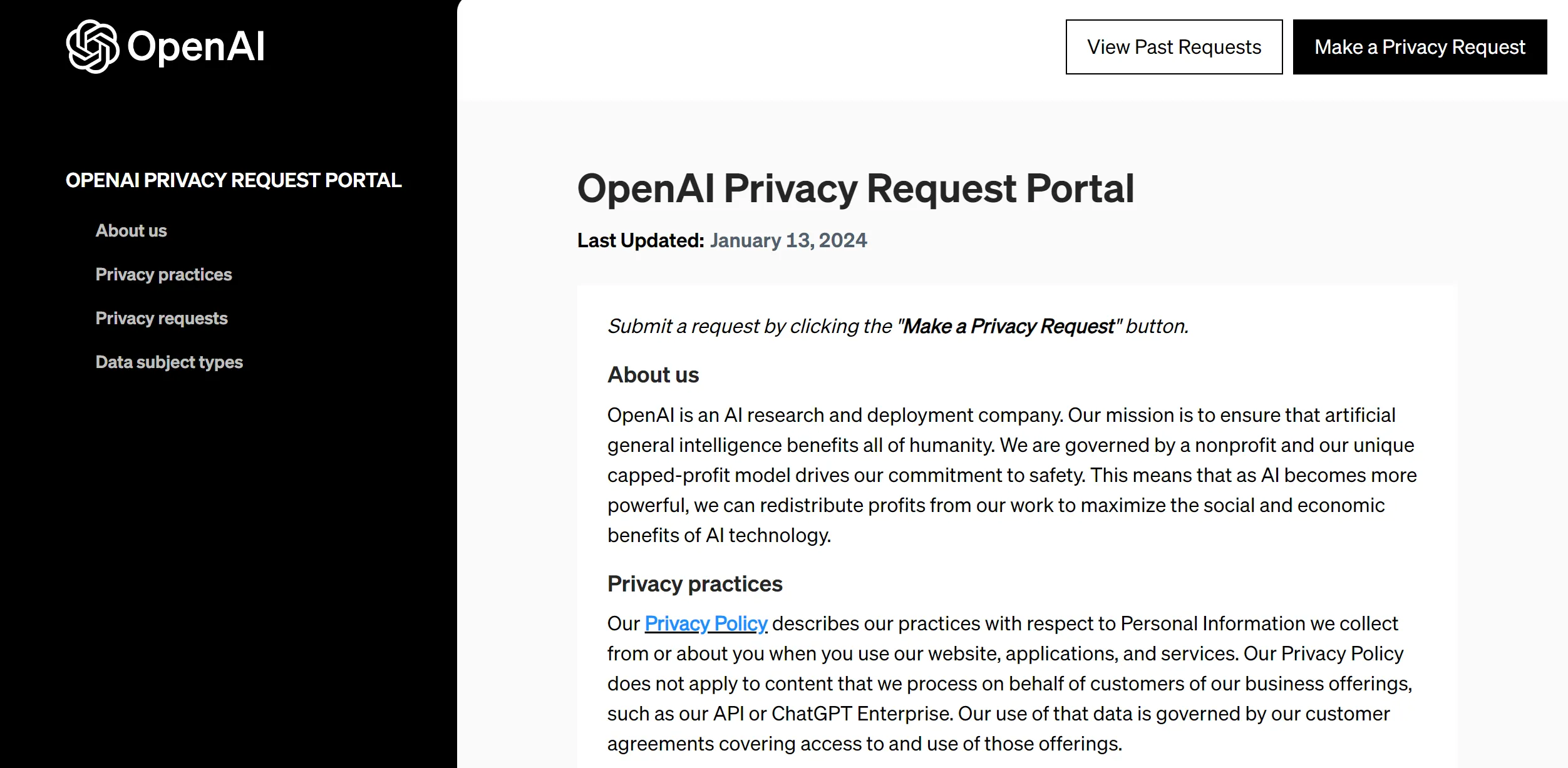

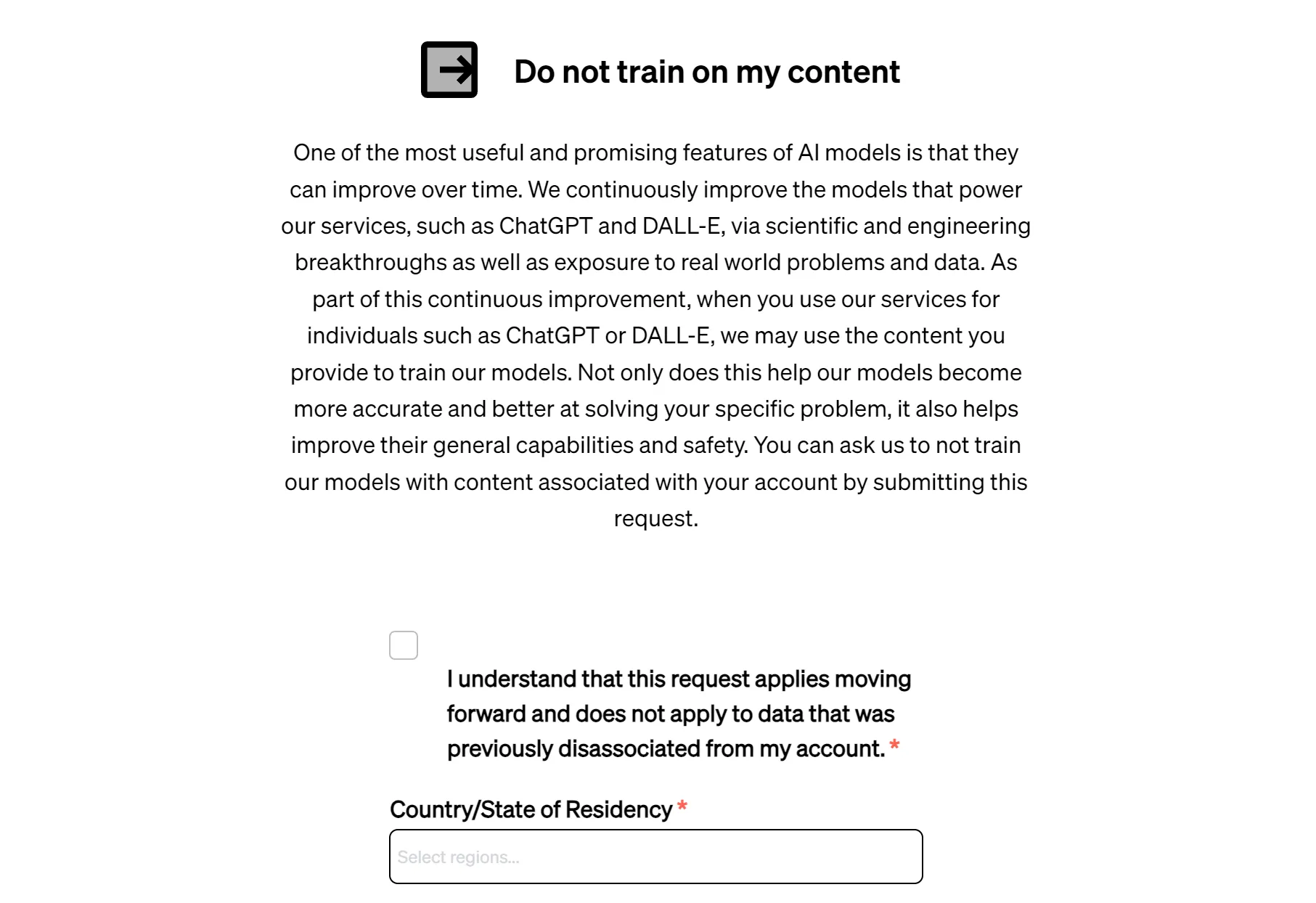

1.OpenAIの申請フォームにアクセスします。

➡申請フォーム:OpenAI Privacy Request Portal

2. ページ右上の、「Make a Privacy Request」をクリックすると、次の様な画面が出るので「I have an OpenAI account」を選択します。

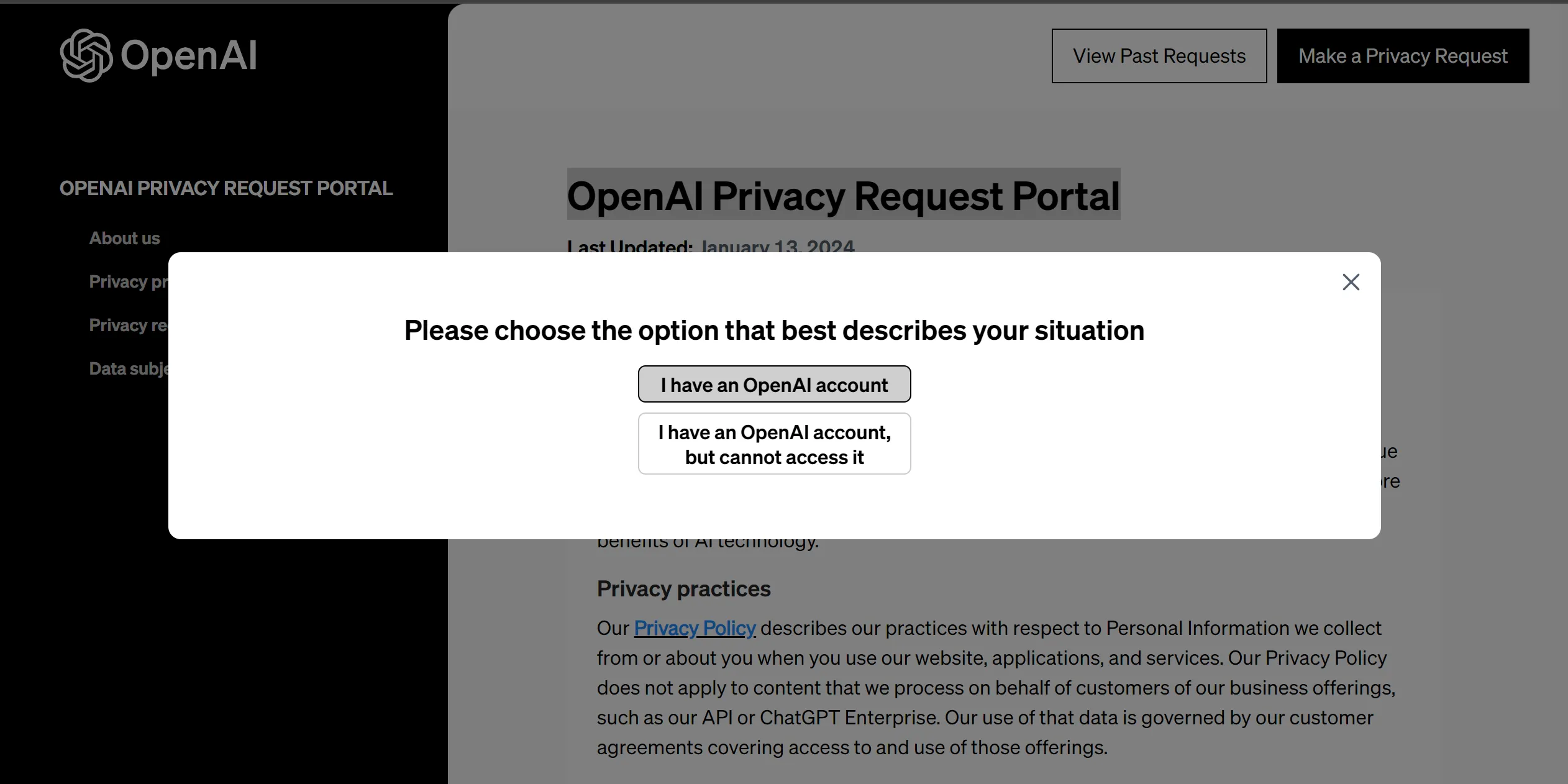

3. 画像右側の、「Do not train on my content」を選択します。

するとメールアドレスの入力を求められるので、オプトアウトアウト申請を行いたいアカウントのメールアドレスを入力します。

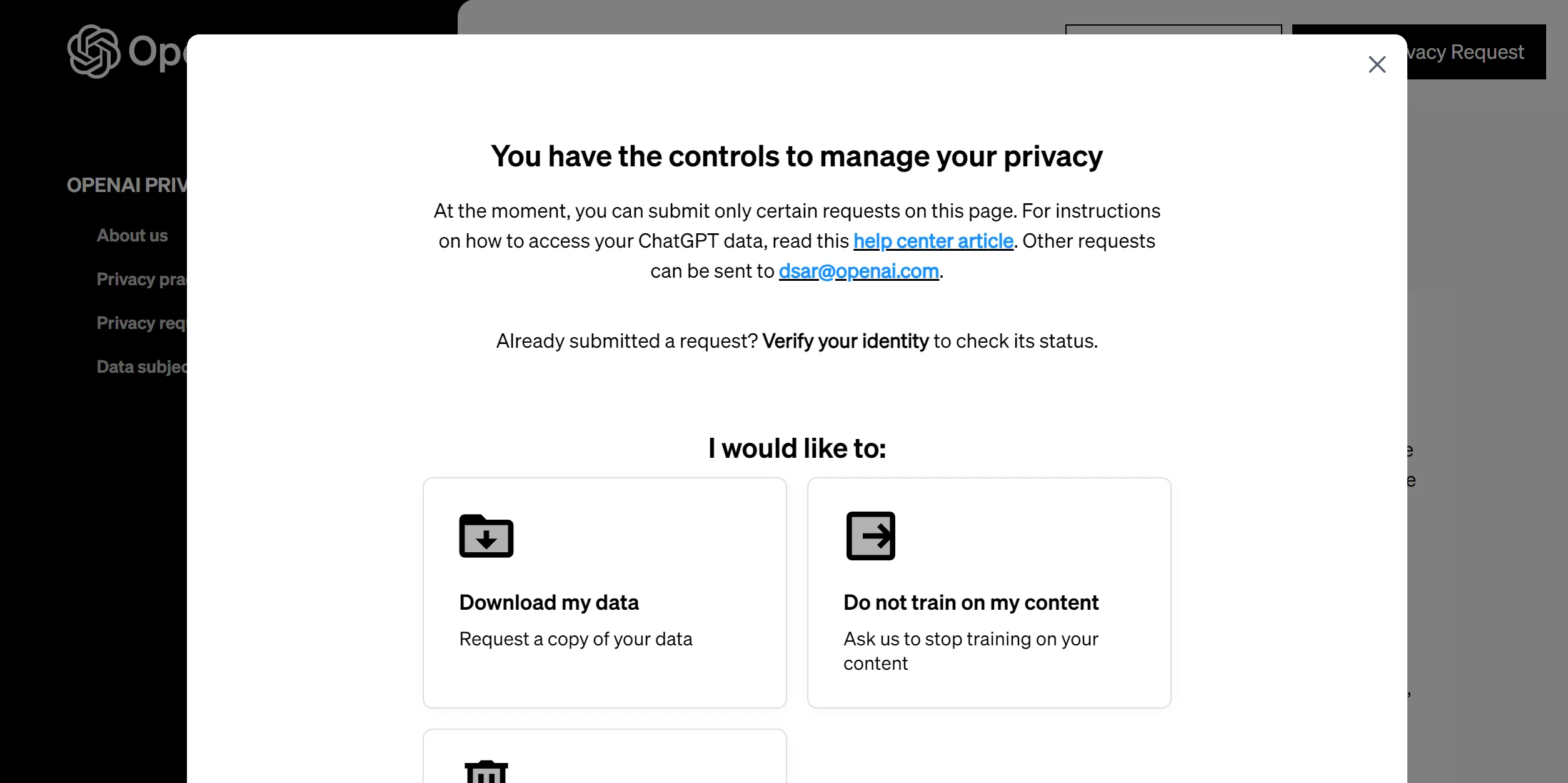

4. 入力したメールアドレス宛にOpenAIからメールが届くので、「Log in」ボタンを押します。

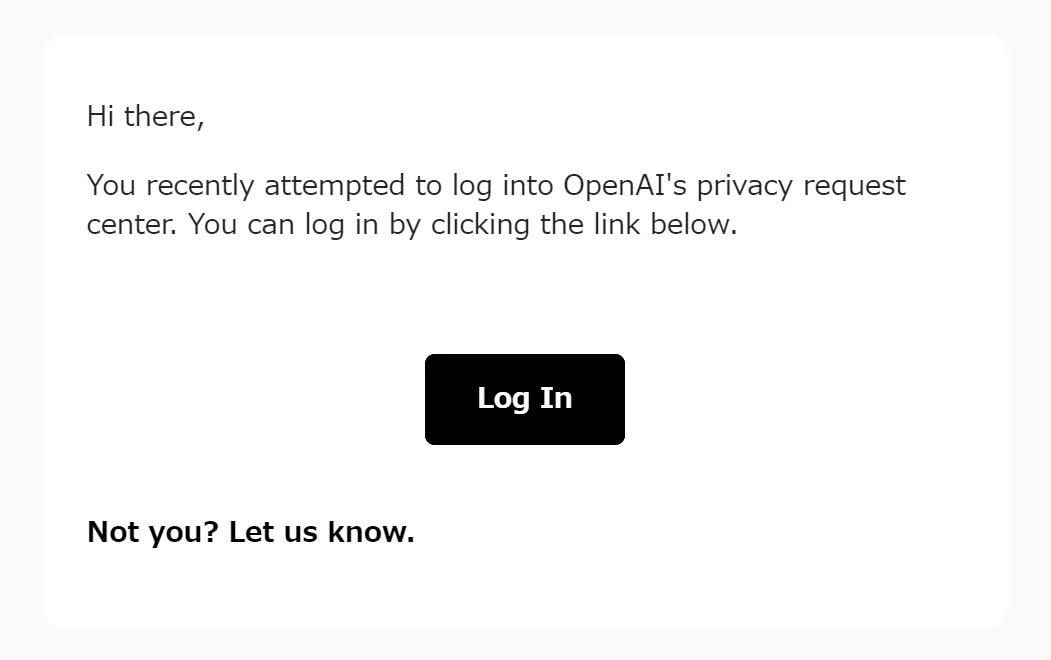

5. 次の様な画面に遷移し、規約への同意(画像のチェックボックス)と、居住国の選択を求められるので「Japan」を選択し、「Confirm Request」をクリックします。

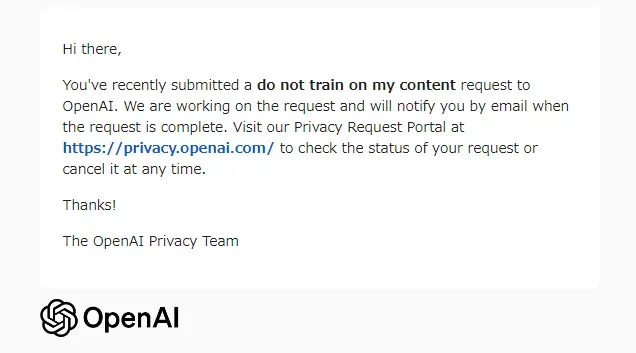

6. 入力したメールアドレス宛に、「Your do not train on my content request」というメールが届いているか確認します。これは「申請を受け付けた」というメールで、まだ申請は完了していません。

- オプトアウト申請の処理が完了すると、「You Do not train on my conten rewuest is complete」というメールが届きます。

これでオプトアウト設定は完了です!

この手順を踏めば、OpenAI社にクエリが残らなくなります。

オプトアウト申請についてより詳しく知りたい方は、こちらの記事もご覧ください。

➡ChatGPTのオプトアウトとは?入力データを学習させない為の設定方法

社内・組織内におけるガイドラインの制定

多くの企業や組織では、ChatGPTの利用に関するガイドラインを制定し、情報漏洩のリスクに対処しています。

ガイドラインでは、以下のような事項を定めることが一般的です。

- 機密情報の入力禁止

- 利用目的の明確化

- 利用状況のモニタリング

これらのガイドラインを設けることで、従業員によるChatGPTの適切な利用を促し、情報漏洩のリスクを最小限に抑えることができます。

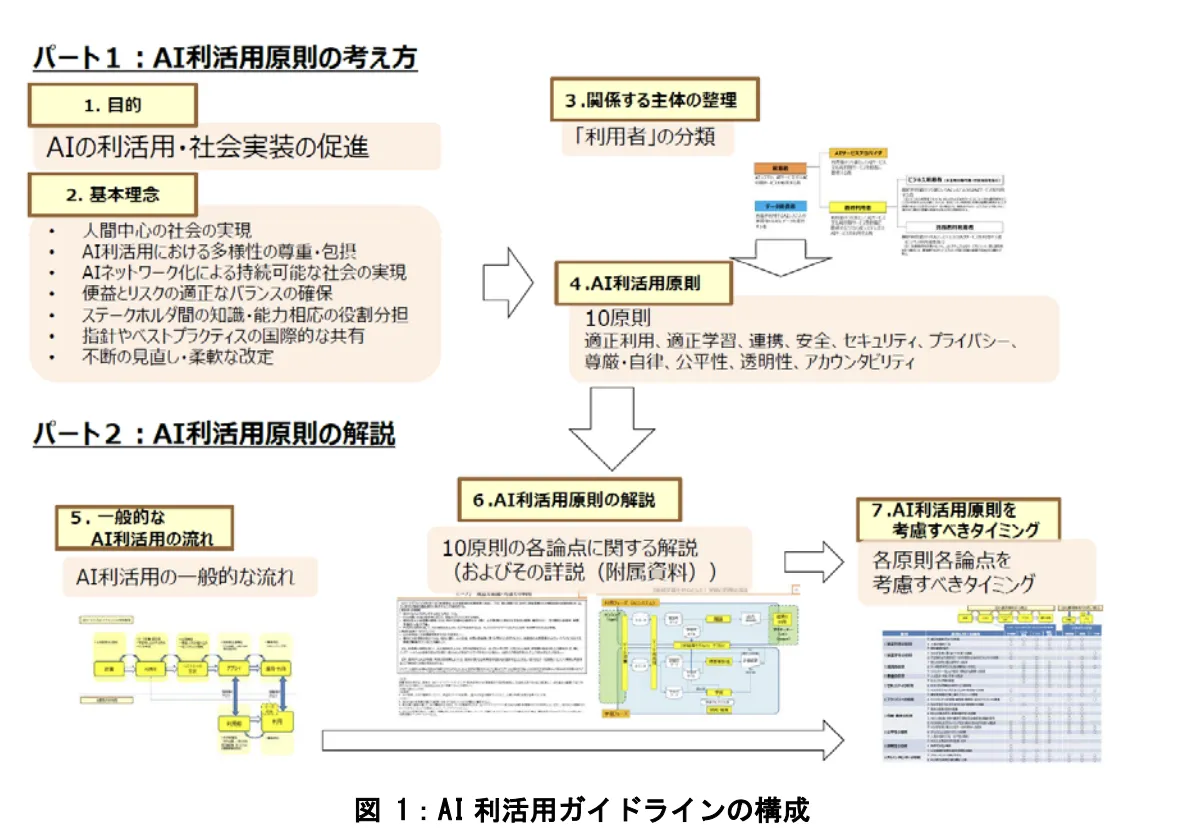

また、総務省が公表している「AI利活用ガイドライン」も参考になります。このガイドラインでは、AIシステムの開発や利用における留意点が網羅的に示されています。

主な内容は以下の通りです。

- AIシステムの適切な利用

- プライバシーの保護

- セキュリティ対策

- 透明性の確保

- 公平性の確保

AI利活用ガイドライン(参考:総務省)

企業や組織がChatGPTの利用に関するガイドラインを制定する際には、総務省のガイドラインも参考にしながら、自社の業務特性に合わせてカスタマイズすることが重要です。

法人向けプラン(ChatGPT Enterprise,Teams)の利用

OpenAI社は、法人向けのChatGPTプランとして「ChatGPT Enterprise」と「ChatGPT Teams」を提供しています。これらのプランでは、ユーザーが入力した情報がOpenAI社の学習に使用されることはありません。

ChatGPT Enterpriseは、「大企業や公的機関向け」のプランで、専用のAPIエンドポイント、強化されたセキュリティ機能、優先的なサポートが提供されます。

一方、ChatGPT Teamsは、「中小企業や小規模チーム向け」のプランで、コラボレーション機能や、管理者による利用状況のモニタリング機能が特徴です。

これらの法人向けプランを利用することで、機密情報の保護と、組織内でのChatGPTの適切な利用を促進できます。ただし、追加の費用が発生するため、費用対効果を検討する必要があります。

【関連記事】

➡️ChatGPT Enterpriseの料金を解説!Teamプランとの違いについても紹介

ChatGPTの情報漏洩リスクに対するOpenAIの方針

ChatGPTを提供するOpenAI社は、プライバシーポリシーにおいて、ユーザー情報の取り扱いについて以下のように述べています。

モデル改善のためのデータ使用

OpenAIは、ChatGPTを含むサービスの改善を目的として、ユーザーが提供したコンテンツを使用する場合があります。ただし、個人情報を含むコンテンツは、使用前に非識別化処理を行うことで、プライバシー侵害のリスクを軽減するよう努めています。

参考:OpenAI 利用規約

第三者とのデータ共有

OpenAIは、サービスの提供や法的要件の遵守に必要な範囲で、特定の状況下において第三者とユーザーの個人情報を共有する場合があります。

ただし、これはOpenAIのプライバシーポリシーのガイドラインに従って行われます。

不正アクセスへの対策

OpenAIは、不正アクセスなどのセキュリティリスクを認識しており、データを保護するための措置を講じています。

これには、データの暗号化、GDPRやCCPAなどの法規制への準拠、サードパーティによるセキュリティ監査、脆弱性の発見に対する報奨金プログラムなどが含まれます。

このように、OpenAI社は情報漏洩のリスクに対して一定の対策を講じているものの、プライバシー設定やセキュリティ対策の回避については責任を負わないとも明記しています。

したがって、ユーザー自身も情報漏洩のリスクを理解し、適切な対策を講じる必要があります。

セキュアなAI活用をお考えの企業様へ

AI Agent Hubで安全に業務を自動化

金融機関レベルのセキュリティで、情報漏洩リスクを抑えながらAI活用を実現。顧客Azureテナント内でデータ保持し、安心してAIを導入できます。

まとめ

この記事では、ChatGPTの利用に伴う情報漏洩のリスクとその対策について解説しました。ChatGPTは利便性が高い一方で、情報漏洩のリスクが存在します。

このリスクに対しては、ユーザー自身による機密情報の入力回避、オプトアウト申請、法人向けプランの利用など、適切な対策が推奨されます。企業や組織では、ガイドラインの策定と定期的なモニタリングが重要です。

ChatGPTを安全に活用するには、ユーザー、サービス提供者、社会全体で情報漏洩のリスクを理解し、適切な対策を講じる必要があります。そうすることで、AIチャットボットの利便性を享受しつつ、プライバシーとセキュリティを確保できるでしょう。