この記事のポイント

AI活用に伴うプライバシー侵害、バイアス、ブラックボックス問題などの倫理的課題を解説。

サムスンの情報漏洩事件やCompasの裁判支援システムなどの具体的な事例を紹介。

AIを悪用したサイバー攻撃の脅威と、セキュリティリスクの高まりについて言及。

AI倫理問題への取り組みとして、ガイドラインの策定や技術開発、教育の重要性を説明。

AIと人間が調和する社会の実現に向けて、一人一人の積極的な関与の必要性を訴求。

Microsoft MVP・AIパートナー。LinkX Japan株式会社 代表取締役。東京工業大学大学院にて自然言語処理・金融工学を研究。NHK放送技術研究所でAI・ブロックチェーンの研究開発に従事し、国際学会・ジャーナルでの発表多数。経営情報学会 優秀賞受賞。シンガポールでWeb3企業を創業後、現在は企業向けAI導入・DX推進を支援。

AI技術は私たちの生活を一変させる可能性を秘めていますが、同時に重大な倫理的問題も引き起こしています。

プライバシーの侵害、データのバイアスによる差別、ブラックボックス問題など、AIがもたらすリスクは看過できません。

本記事では、こうした倫理的課題を具体的な事例を交えて詳しく解説します。サムスンの情報漏洩事件やCompasの裁判支援システムなど、現実に起きた問題を通じて、AI活用の光と影を浮き彫りにします。

また、AIを悪用したサイバー攻撃の脅威など、新たな倫理的問題についても考察。AI倫理の確立に向けた取り組みや、AIと人間が共生する社会の実現について展望を述べます。

技術の進化と倫理の調和について、一緒に考えてみましょう。

目次

AI活用の倫理的問題

AI活用における倫理的問題は多岐にわたります。

ここでは、プライバシーの侵害、バイアスと差別、ブラックボックス問題、自律性と責任、セキュリティと悪用のリスクといった代表的な5つの課題について詳しく解説していきます。

AIがもたらす倫理的な問題点を理解することは、技術の健全な発展のために不可欠です。

プライバシーの侵害

AIは大量のデータを収集し、その情報を出力に使用しています。このため、入力時に個人情報や機密情報を入力すると、プライバシーやセキュリティの侵害が懸念されます。

例えば、ChatGPTに個人情報や機密情報を入力してしまった場合、そのデータが学習に使用され、第三者がChatGPTを利用した際の出力に使用されてしまう可能性があります。

特に、企業の財務データや計画が外部に流出すると、競争力を損ない、ビジネスに重大な影響を与える可能性があります。

これらのリスクを軽減するためには、ChatGPTの利用に際して、機密情報を入力しないように注意することが重要です。

また、データの暗号化や定期的なセキュリティチェックが不可欠です。

バイアスと差別

AIは訓練データに依存するため、データに含まれるバイアスがそのままAIの判断に反映されることがあります。

医療分野においても、AIの診断システムが特定の人種や性別に対するバイアスを持つことがあります。例えば、男性のデータを中心に訓練された診断システムは、女性患者の症状を適切に評価できない可能性があります。

これにより、女性患者が適切な診断や治療を受けられないという危険性が生じてしまいます。

ブラックボックス問題

AIの出力プロセスがブラックボックス化している場合、なぜそのような判断が下されたのかを説明できないことがあります。

例えば、医療診断システムがなぜ特定の診断結果を出したのかを説明できない場合、医師や患者はその結果に納得できず、不安を感じることがあります。

これにより、AIシステムへの信頼が低下し、その導入や利用が進まない可能性があります。

自律性と責任

AIが自律的に意思決定を行う場合、その結果に対する責任の所在が不明確になることがあります。これには法的な問題も含まれます。

例えば、自動運転車が事故を起こした場合、その責任が誰にあるのかが問題となります。製造者、プログラマー、車の所有者など、複数の関係者が関与しているため、責任の所在を明確にすることが難しいです。また、AIが行う医療診断においても、誤診が発生した際の責任が曖昧になる可能性があります。これにより、AIシステムの導入に対する不安が高まり、技術の進展が阻害されることがあります。

具体的には、自動運転のシステムに関する有名な問題で、「トロッコ問題」というものがあります。

トロッコ問題は、倫理学や道徳哲学で議論される有名な思考実験です。この問題は、緊急の状況においてどのような行動が道徳的に正しいのかを問うものです。以下に基本的な構造を説明します。

AIとトロッコ問題

- 状況設定

あなたは鉄道の分岐点に立っています。トロッコが制御不能になり、5人が縛られている線路に向かって突進しています。もし何もしなければ、トロッコはそのまま進み、5人を轢いてしまいます。

- 選択肢

- 何もしない: トロッコがそのまま進み、5人が犠牲になる。

- レバーを引く: あなたがレバーを引くと、トロッコは分岐して別の線路に進みます。

その別の線路には1人が縛られています。この場合、1人が犠牲になりますが、5人は助かります。

問題の核心

トロッコ問題は、以下のような倫理的な問いを投げかけます。

-

功利主義

より多くの人を助けるために、少数を犠牲にすることは許されるのか?5人を助けるために1人を犠牲にする行動は正しいのか? -

義務論

個々の行動の道徳性を重視する立場からは、直接的に1人を犠牲にする行為は許されないのか?意図的に人を傷つけることが倫理的に許されるのか?

もし自動運転車が同様の状況に立たされた時に、どのように動かすようにプログラムするべきか、現在でも議論が進められています。

セキュリティと悪用のリスク

AI技術は悪用されるリスクもあります。

例えば、AIを使ったサイバー攻撃がその一例です。AIを用いたマルウェアは、人間の介入なしに攻撃を進化させることができるため、従来のセキュリティ対策では対処しきれない場合があります。

また、AI生成のフェイクコンテンツ(ディープフェイク)は、偽情報の拡散や名誉毀損に利用されるリスクがあります。

事例1:プライバシー侵害 - サムスンの情報漏洩事件

2023年にサムスンで発生した情報漏洩事件では、従業員がAIツールを利用して機密情報を処理した結果、重要なデータが外部に漏洩するという事態が発生しました。

サムスンのエンジニアが、ChatGPTを使用してソースコードのバグ修正を行う際、機密情報を含むコードがAIのサーバーに送信され、その一部が外部に流出してしまいました。

この事件は、企業がAIツールを利用する際のセキュリティ対策の重要性を強調するものです。

企業の機密情報が外部に漏洩すると、競争力の低下や信用失墜などの重大な影響を及ぼす可能性があります。

【関連記事】

➡ChatGPTの情報漏洩事例とは?実際の事例や対策方法を解説

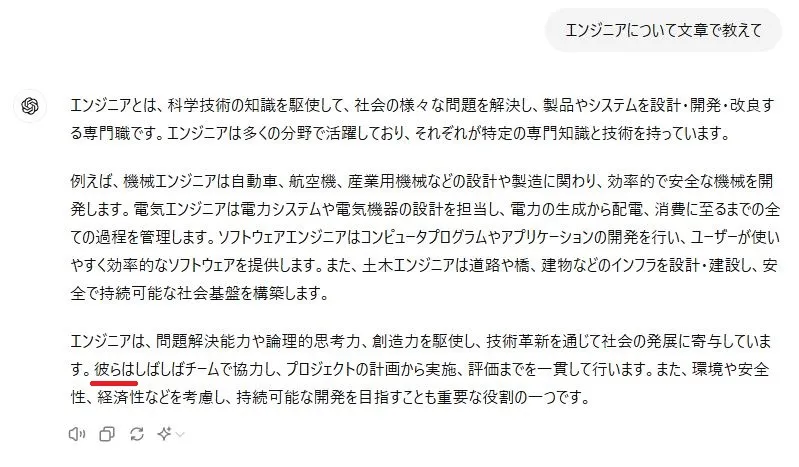

事例2: バイアス - ChatGPTの出力例

AIの学習データにバイアスが含まれていると、出力結果にもバイアスが含まれてしまうことがあります。

例えば、「エンジニアについて教えて」とChatGPTにお願いをすると出力に「彼」という単語を含んだ出力がされました。

エンジニアが男性であるというバイアスが含まれていることがわかります。

ブラックボックス問題 - Compasの裁判支援システム

刑事司法分野でもブラックボックス問題が深刻化しています。

例えば、米国で広く使用されているCompasというAIアルゴリズムは、裁判官が保釈や量刑の決定を行う際に使用されますが、その判断プロセスが不透明であることが問題視されています。

このシステムは、再犯リスクを評価するために使用されますが、その評価基準が公開されていない点が問題になっています。

【参考リンク】

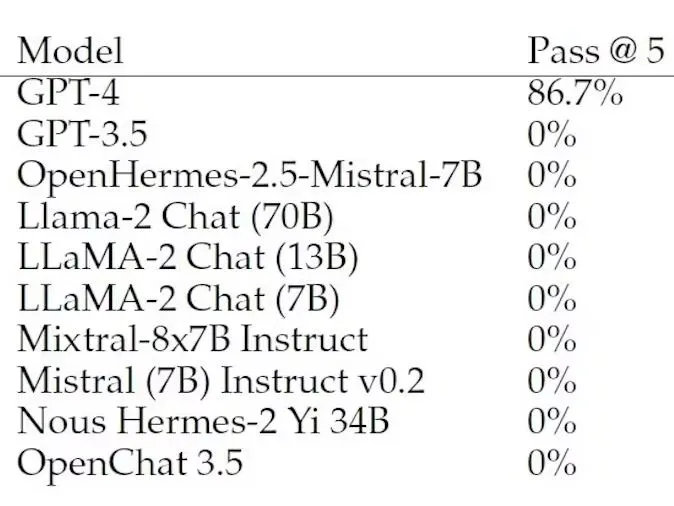

事例4: セキュリティ - AIを用いたサイバー攻撃

ソフトウェアの脆弱性をつくサイバー攻撃が問題となっています。

サイバー攻撃者が狙うのは「ワンデイ脆弱性」と呼ばれるタイプの脆弱性です。ワンデイ脆弱性とは、既に公表されているが、まだ完全には修正されていないソフトウェアのセキュリティホールや欠陥のことを指します。

15種類のワンデイ脆弱性を用いた実験ではGPT-4やGPT-3.5、Llama2など計10種類のLLMを使用しましたが、検証の結果、脆弱性を突けたのはGPT-4だけでした。5回の試行で15種類中13種類の脆弱性を突けたので、成功率は86.7%でした。

誰でも使用できるGPTを使うことによってサイバー攻撃を行うことができる危険性がよくわかります。

AIの悪用によるセキュリティリスクは、今後ますます高まることが予想されます。

【参考】

日経新聞

論文「LLM Agents can Autonomously Exploit One-day Vulnerabilities」

## AIの倫理問題への取り組みと解決策

AIの倫理的問題に対しては、企業や政府、学術機関などが様々な取り組みを行っています。

例えば、AIの開発や利用における倫理的ガイドラインの策定、AIの判断プロセスの透明性を高めるための研究開発、バイアスを検出し除去するためのアルゴリズムの開発などが進められています。

また、AI倫理の専門家の育成や、一般市民へのAIリテラシー教育なども重要な取り組みの一つです。

AIについての正しい知識を持ち、その利点と限界を理解することは、AIと人間が共生する社会を実現する上で欠かせません。

AI技術は、私たちの生活を大きく変える可能性を秘めています。しかし、その発展には倫理的な問題を解決することが不可欠です。

技術の進化に合わせて、倫理的な議論と対策を深化させていくことが求められています。そうすることで、AIの恩恵を最大限に活かしつつ、リスクを最小化することができるでしょう。

製造業界のためのAI活用プロンプト集

業務効率化を実現するプロンプトテンプレート

生成AIを活用する方のための製造業特化プロンプト集です。製造業におけるプロンプト活用は、生産管理、商品の販促、不良品検知など多岐にわたります。応用して活用することも可能ですので、ぜひご活用ください。

まとめ

本記事では、AI活用における倫理的問題について詳しく解説しました。

プライバシーの侵害、バイアスと差別、ブラックボックス問題、自律性と責任、セキュリティと悪用のリスクなど、AIがもたらす倫理的な課題は多岐にわたります。

これらの問題は、サムスンの情報漏洩事件やCompasの裁判支援システムなどの具体的な事例からも明らかです。AIの判断プロセスの不透明性や、AIを悪用したサイバー攻撃の脅威など、技術の進歩に伴って新たな倫理的問題が浮上しています。

課題に対処するためには、企業や政府、学術機関が協力して、AIの倫理的ガイドラインの策定や技術開発、教育などに取り組むことが不可欠です。

同時に、一人一人がAIについての正しい知識を持ち、その利点と限界を理解することが重要です。

AIと人間が調和のとれた社会を築くために、私たち一人一人が積極的に考え、行動していく必要があります。

技術の進化に合わせて倫理的な議論を深め、AIの恩恵を最大限に活かしつつ、リスクを最小化していくことが求められています。